Как скрапить Pollen.com: Руководство по извлечению локальных данных об аллергии

Узнайте, как скрапить Pollen.com для получения локальных прогнозов аллергии, уровней пыльцы и основных аллергенов. Получайте ежедневные данные о здоровье для...

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- Блокировка IP

- Блокирует известные IP дата-центров и отмеченные адреса. Требует резидентных или мобильных прокси для эффективного обхода.

- AngularJS Rendering

О Pollen.com

Узнайте, что предлагает Pollen.com и какие ценные данные можно извлечь.

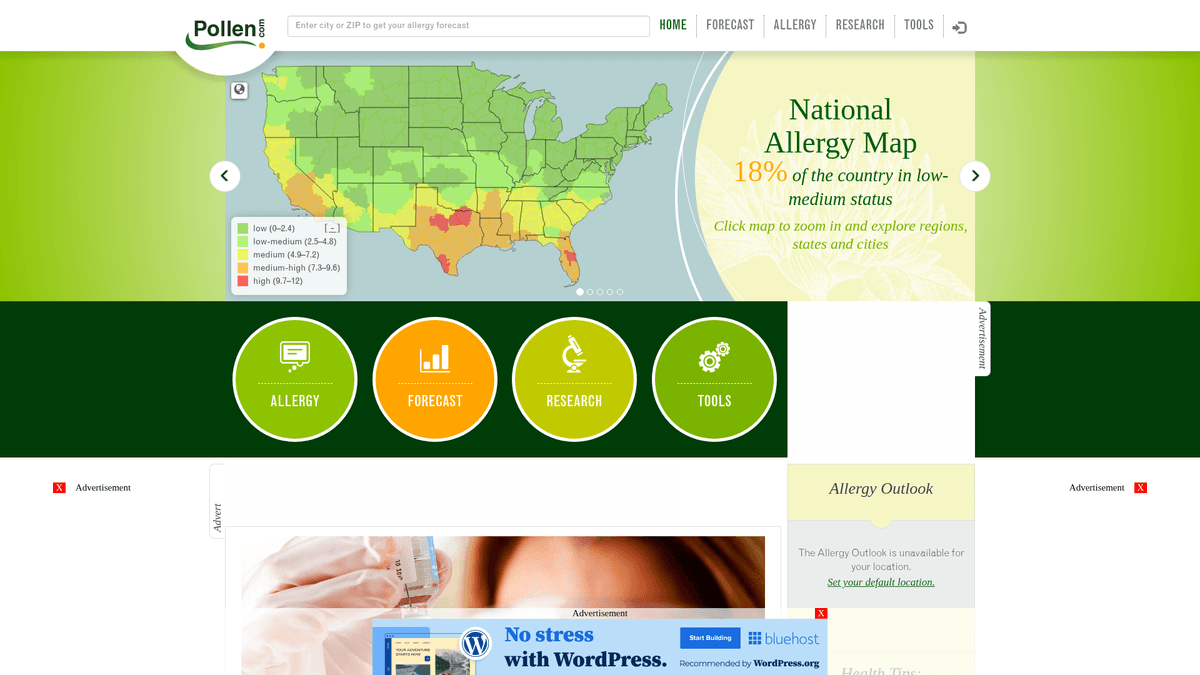

Комплексные данные об аллергии в США

Pollen.com — это ведущий портал о здоровье и окружающей среде, предоставляющий локализованную информацию об аллергии и прогнозы на всей территории США. Платформа, принадлежащая и управляемая IQVIA — известной аналитической компанией в сфере здравоохранения, предоставляет точные показатели концентрации пыльцы и типы аллергенов на основе ZIP-кодов. Она является критически важным ресурсом для людей с сезонными респираторными заболеваниями и медицинских специалистов, отслеживающих экологические тренды.

Ценные данные для общественного здравоохранения

Сайт содержит структурированные данные, включая индекс пыльцы от 0 до 12, категории основных аллергенов (деревья, сорняки, травы) и подробные 5-дневные прогнозы. Для разработчиков и исследователей эти данные дают представление о региональных экологических триггерах и исторических паттернах аллергии, которые сложно собрать с обычных метеорологических сайтов.

Полезность для бизнеса и исследований

Скрапинг Pollen.com полезен для создания приложений для мониторинга здоровья, оптимизации фармацевтических цепочек поставок лекарств от аллергии и проведения академических исследований влияния изменения климата на циклы опыления. Автоматизируя извлечение этих данных, организации могут приносить реальную пользу аллергикам по всей стране.

Зачем Парсить Pollen.com?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из Pollen.com.

Создание персонализированных систем оповещения для медицинских приложений

Прогнозирование трендов спроса на локальные лекарства от аллергии

Проведение экологических исследований региональных сезонов опыления

Агрегация гиперлокальных данных о здоровье для новостных и погодных порталов

Анализ исторических паттернов аллергии для городского планирования здравоохранения

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге Pollen.com.

Рендеринг динамического контента с помощью AngularJS требует автоматизации браузера

Основные данные прогноза загружаются через асинхронные внутренние API-вызовы, защищенные сессией

Строгие ограничения (rate limiting) на повторяющиеся запросы по ZIP-кодам могут привести к временным банам IP

Защита от ботов Cloudflare часто выдает проверки (challenges) для User-Agent, не являющихся браузерами

Скрапинг Pollen.com с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из Pollen.com. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по Pollen.com, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг Pollen.com без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из Pollen.com. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по Pollen.com, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Автоматический рендеринг JavaScript обрабатывает сложные графики AngularJS без дополнительного кода

- Встроенная ротация прокси успешно обходит защиту Cloudflare и лимиты запросов по IP

- Запланированные запуски позволяют полностью автоматизировать ежедневный сбор данных по тысячам ZIP-кодов

- Интерфейс без кода (no-code) упрощает настройку извлечения данных для конкретных географических регионов

No-Code Парсеры для Pollen.com

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Pollen.com без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для Pollen.com

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Pollen.com без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

# Примечание: Это извлекает только статические метаданные новостей.

# Для данных прогноза требуется рендеринг JavaScript или прямой доступ к API.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Извлечение базовых заголовков новостей из боковой панели

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'Последние новости об аллергии: {news}')

except Exception as e:

print(f'Произошла ошибка: {e}')Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить Pollen.com с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

# Примечание: Это извлекает только статические метаданные новостей.

# Для данных прогноза требуется рендеринг JavaScript или прямой доступ к API.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Извлечение базовых заголовков новостей из боковой панели

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'Последние новости об аллергии: {news}')

except Exception as e:

print(f'Произошла ошибка: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

browser = playwright.chromium.launch(headless=True)

page = browser.new_page()

# Переход к прогнозу для конкретного ZIP-кода

page.goto('https://www.pollen.com/forecast/current/pollen/20001')

# Ожидание, пока AngularJS отрендерит индекс пыльцы

page.wait_for_selector('.forecast-level')

data = {

'pollen_index': page.inner_text('.forecast-level'),

'status': page.inner_text('.forecast-level-desc'),

'allergens': [el.inner_text() for el in page.query_selector_all('.top-allergen-item span')]

}

print(f'Данные для 20001: {data}')

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class PollenSpider(scrapy.Spider):

name = 'pollen_spider'

# URL для конкретного ZIP-кода

start_urls = ['https://www.pollen.com/forecast/current/pollen/20001']

def parse(self, response):

# Для динамического контента используйте Scrapy-Playwright или аналоги

# Этот стандартный метод обрабатывает статические элементы, такие как заголовки

yield {

'url': response.url,

'page_title': response.css('title::text').get(),

'news_headlines': response.css('article h2 a::text').getall()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Установка User-Agent для имитации реального браузера

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64)');

await page.goto('https://www.pollen.com/forecast/current/pollen/20001');

// Ожидание появления динамического уровня прогноза

await page.waitForSelector('.forecast-level');

const data = await page.evaluate(() => ({

pollenIndex: document.querySelector('.forecast-level')?.innerText,

description: document.querySelector('.forecast-level-desc')?.innerText,

location: document.querySelector('h1')?.innerText

}));

console.log(data);

await browser.close();

})();Что Можно Делать С Данными Pollen.com

Изучите практические применения и инсайты из данных Pollen.com.

Персонализированные оповещения об аллергии

Мобильные приложения для здоровья могут предоставлять пользователям уведомления в реальном времени, когда уровень пыльцы в их районе достигает высоких значений.

Как реализовать:

- 1Скрапинг ежедневных прогнозов для ZIP-кодов, указанных пользователем

- 2Определение моментов, когда индекс пыльцы превышает «высокий» порог (7.3+)

- 3Отправка автоматических push-уведомлений или SMS-оповещений пользователю

Используйте Automatio для извлечения данных из Pollen.com и создания этих приложений без написания кода.

Что Можно Делать С Данными Pollen.com

- Персонализированные оповещения об аллергии

Мобильные приложения для здоровья могут предоставлять пользователям уведомления в реальном времени, когда уровень пыльцы в их районе достигает высоких значений.

- Скрапинг ежедневных прогнозов для ZIP-кодов, указанных пользователем

- Определение моментов, когда индекс пыльцы превышает «высокий» порог (7.3+)

- Отправка автоматических push-уведомлений или SMS-оповещений пользователю

- Прогнозирование спроса на лекарства

Фармацевтические ритейлеры могут оптимизировать уровень запасов, сопоставляя локальные всплески пыльцы с прогнозируемым спросом на антигистаминные препараты.

- Извлечение данных 5-дневного прогноза по крупным мегаполисам

- Выявление предстоящих периодов высокой активности аллергенов

- Координация распределения запасов в местные аптеки до начала пика

- Экологический рейтинг недвижимости

Сайты по поиску недвижимости могут добавить «рейтинг аллергии», чтобы помочь чувствительным покупателям оценить качество воздуха в районе.

- Сбор исторических данных о пыльце для конкретных районов города

- Расчет среднегодового показателя интенсивности пыльцы

- Отображение рейтинга как дополнительной характеристики на странице объекта недвижимости

- Исследование изменения климата

Экологи могут отслеживать продолжительность и интенсивность сезонов опыления во времени для изучения климатических воздействий.

- Ежедневный скрапинг видов пыльцы и индексов в течение весеннего и осеннего сезонов

- Сравнение дат начала и окончания опыления со средними историческими значениями

- Анализ данных для выявления тенденций к удлинению или усилению сезонов аллергии

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу Pollen.com

Экспертные советы для успешного извлечения данных из Pollen.com.

Ориентируйтесь на внутренние API-эндопоинты, найденные в сетевом трафике, для прямого доступа к данным в формате JSON.

Используйте резидентные прокси для ротации IP-адресов, чтобы избежать срабатывания защиты от ботов Cloudflare.

Выполняйте скрапинг ежедневно рано утром (около 7 утра по восточному времени), чтобы получать самые свежие обновления прогнозов.

Убедитесь, что ваш скрапер исполняет JavaScript, так как Pollen.com использует AngularJS для заполнения данных об индексах.

Установите случайную задержку (sleep) от 3 до 10 секунд между запросами для разных ZIP-кодов.

Регулярно отслеживайте структуру сайта, так как названия классов AngularJS могут меняться при обновлении ресурса.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape American Museum of Natural History (AMNH)

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Poll-Maker: A Comprehensive Web Scraping Guide

Часто задаваемые вопросы о Pollen.com

Найдите ответы на частые вопросы о Pollen.com