Как парсить SeekaHost: Полное руководство по веб-скрейпингу

Узнайте, как парсить тарифные планы, цены и данные доменов SeekaHost. Извлекайте характеристики хостинга и контент блога для конкурентного анализа рынка.

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- User-Agent Blocking

- robots.txt

О SeekaHost

Узнайте, что предлагает SeekaHost и какие ценные данные можно извлечь.

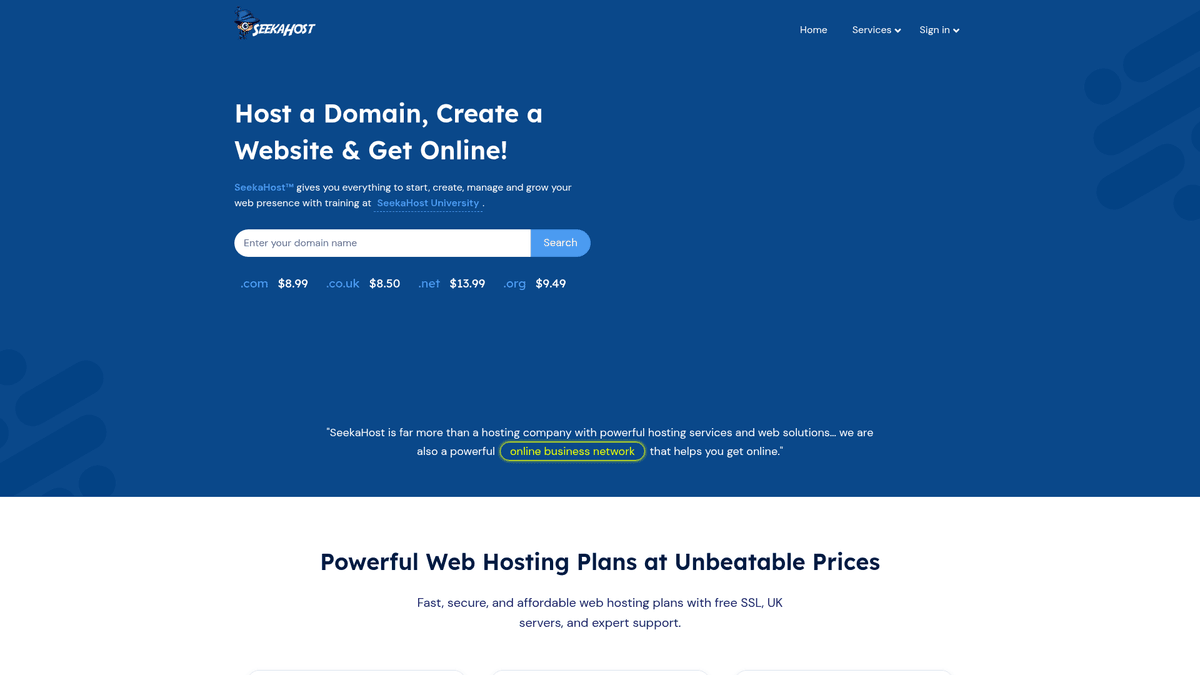

SeekaHost — это известный глобальный провайдер веб-хостинга и регистратор доменов со штаб-квартирой в Лондоне, Великобритания. Он предлагает широкий спектр услуг, включая персональный, бизнес-, VPS- и WordPress хостинг. Компания получила значительную популярность в SEO-сообществе благодаря специализированному хостингу для частных сетей блогов (PBN) и SEO-ориентированным IP-решениям.

Сайт содержит структурированную информацию о различных уровнях хостинга, конкретные технические характеристики, такие как объем хранилища и пропускная способность, а также цены в реальном времени для сотен доменных TLD. Также на сайте есть обширный блог и SeekaHost University, которые предоставляют множество технических руководств и знаний по цифровому маркетингу.

Скрейпинг SeekaHost особенно ценен для конкурентного анализа в индустрии хостинга. Извлекая данные с этого сайта, компании могут отслеживать колебания цен, сравнивать наборы функций с конкурентами и агрегировать высококачественный технический контент для исследовательских или информационных целей.

Зачем Парсить SeekaHost?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из SeekaHost.

Мониторинг цен конкурентов на тарифные планы хостинга

Исследование рынка специализированных SEO-хостингов

Агрегация технического контента из блога SeekaHost

Отслеживание тенденций ценообразования TLD для сотен расширений

Генерация лидов для услуг веб-разработки и SEO

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге SeekaHost.

Обход защиты Cloudflare и браузерных проверок

Обработка динамического контента и таблиц цен, отрисованных через JavaScript

Навигация при строгих ограничениях robots.txt для AI-краулеров

Управление частыми обновлениями UI, которые меняют CSS-селекторы

Скрапинг SeekaHost с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из SeekaHost. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по SeekaHost, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг SeekaHost без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из SeekaHost. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по SeekaHost, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Автоматический обход защиты Cloudflare

- Обработка рендеринга JavaScript без дополнительных настроек

- Запуск по расписанию для автоматического отслеживания цен в реальном времени

- Прямая интеграция с Google Sheets для хранения данных

No-Code Парсеры для SeekaHost

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить SeekaHost без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для SeekaHost

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить SeekaHost без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://www.seekahost.com/personal-web-hosting/'

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

plans = soup.find_all('div', class_='pricing-table')

for plan in plans:

name = plan.find('h3').get_text(strip=True)

price = plan.find('span', class_='price').get_text(strip=True)

print(f'Plan: {name}, Price: {price}')

except Exception as e:

print(f'Error: {e}')Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить SeekaHost с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://www.seekahost.com/personal-web-hosting/'

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

plans = soup.find_all('div', class_='pricing-table')

for plan in plans:

name = plan.find('h3').get_text(strip=True)

price = plan.find('span', class_='price').get_text(strip=True)

print(f'Plan: {name}, Price: {price}')

except Exception as e:

print(f'Error: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_seekahost():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.seekahost.com/blog/', wait_until='networkidle')

titles = page.locator('h4 a').all_text_contents()

for title in titles:

print(f'Post Title: {title.strip()}')

browser.close()

if __name__ == '__main__':

scrape_seekahost()Python + Scrapy

import scrapy

class SeekaHostSpider(scrapy.Spider):

name = 'seekahost_spider'

start_urls = ['https://www.seekahost.com/blog/']

def parse(self, response):

for post in response.css('div.blog-item'):

yield {

'title': post.css('h4 a::text').get().strip(),

'author': post.css('span.author a::text').get(),

'date': post.css('span.date::text').get(),

}

next_page = response.css('a.next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36');

await page.goto('https://www.seekahost.com/domain-pricing/', { waitUntil: 'networkidle2' });

const pricingData = await page.evaluate(() => {

const rows = Array.from(document.querySelectorAll('table tr'));

return rows.slice(1).map(row => ({

tld: row.cells[0]?.innerText.trim(),

price: row.cells[1]?.innerText.trim()

}));

});

console.log(pricingData);

await browser.close();

})();Что Можно Делать С Данными SeekaHost

Изучите практические применения и инсайты из данных SeekaHost.

Сервис сравнения хостингов

Создание инструмента для сравнения самых дешевых планов SeekaHost с предложениями других крупных провайдеров.

Как реализовать:

- 1Ежедневно парсить характеристики и цены планов SeekaHost.

- 2Собирать аналогичные данные у конкурентов, таких как Bluehost.

- 3Нормализовать поля данных, такие как объем диска и статус SSL.

- 4Обновлять дашборд с матрицей сравнения.

Используйте Automatio для извлечения данных из SeekaHost и создания этих приложений без написания кода.

Что Можно Делать С Данными SeekaHost

- Сервис сравнения хостингов

Создание инструмента для сравнения самых дешевых планов SeekaHost с предложениями других крупных провайдеров.

- Ежедневно парсить характеристики и цены планов SeekaHost.

- Собирать аналогичные данные у конкурентов, таких как Bluehost.

- Нормализовать поля данных, такие как объем диска и статус SSL.

- Обновлять дашборд с матрицей сравнения.

- Аналитика рынка SEO

Анализ тенденций в ценообразовании и доступности специализированного PBN-хостинга.

- Извлечение цен на пакеты IP-хостинга классов A, B и C.

- Отслеживание изменений в доступности специфических технических услуг.

- Сопоставление изменений цен с общими сдвигами в SEO-индустрии.

- Подготовка квартального отчета по рынку для SEO-профессионалов.

- Автоматизированный куратор контента

Агрегация технических туториалов и руководств по управлению серверами для нишевого сообщества разработчиков.

- Мониторинг блога SeekaHost на предмет новых статей.

- Скрейпинг заголовка, полного текста и категории новых постов.

- Саммаризация контента с помощью инструментов AI.

- Публикация резюме в курируемой рассылке или ленте Twitter.

- Оповещения для реселлеров доменов

Мониторинг цен на TLD для уведомления реселлеров о снижении стоимости регистрации доменов.

- Парсинг страницы цен на домены каждые 24 часа.

- Сравнение текущих цен с исторической базой данных.

- Настройка алертов, если цена на целевой TLD опускается ниже определенного уровня.

- Уведомление реселлеров через автоматические оповещения в Slack или по электронной почте.

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу SeekaHost

Экспертные советы для успешного извлечения данных из SeekaHost.

Используйте резидентные прокси, чтобы обойти черные списки IP-адресов, специфичные для хостинг-провайдеров.

Внедрите плагины для маскировки браузера (browser-stealth), чтобы скрыть сигнатуры headless-браузеров от Cloudflare.

Выполняйте парсинг в часы минимальной нагрузки (полночь по GMT), чтобы минимизировать риски rate limiting.

Блог использует стандартную пагинацию WordPress; для эффективности используйте шаблон URL /page/X/.

Следите за файлом robots.txt, так как SeekaHost часто обновляет разрешения для краулеров.

Сосредоточьтесь на таблице цен на домены для получения оперативных обновлений стоимости.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Часто задаваемые вопросы о SeekaHost

Найдите ответы на частые вопросы о SeekaHost