Как парсить We Work Remotely: Полное руководство

Узнайте, как парсить объявления о работе с We Work Remotely. Извлекайте названия вакансий, компании, зарплаты и другие данные для анализа рынка или создания...

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- Блокировка IP

- Блокирует известные IP дата-центров и отмеченные адреса. Требует резидентных или мобильных прокси для эффективного обхода.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

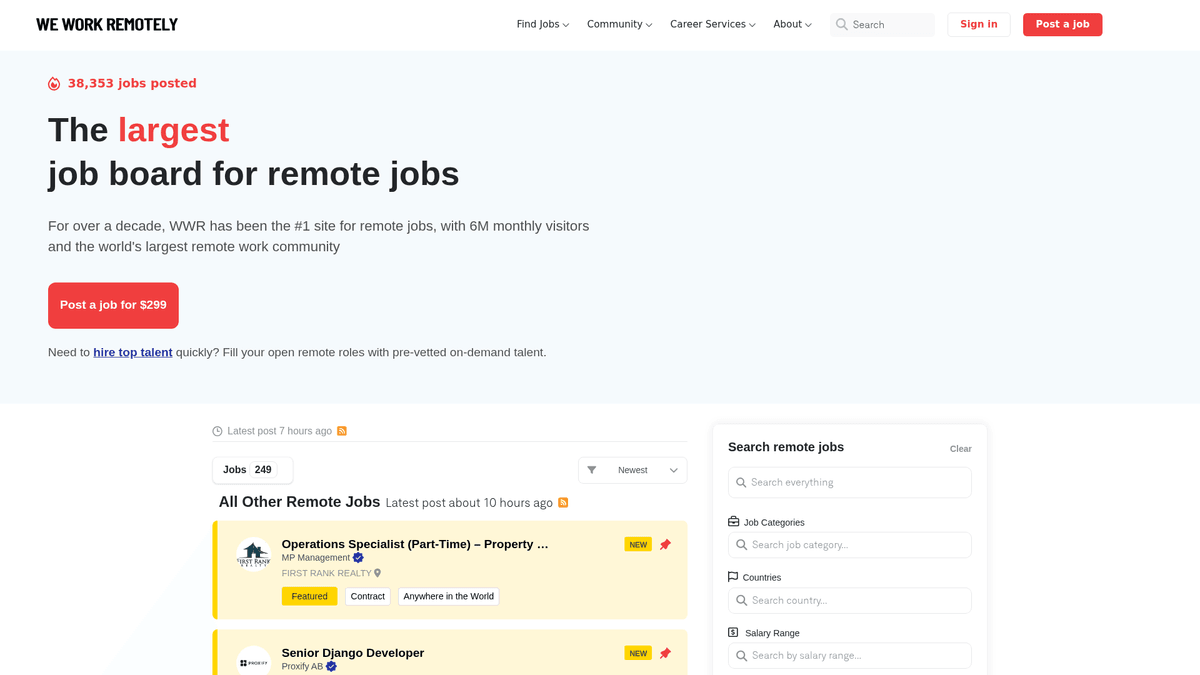

О We Work Remotely

Узнайте, что предлагает We Work Remotely и какие ценные данные можно извлечь.

Хаб для талантов на удаленке со всего мира

We Work Remotely (WWR) — это самое авторитетное сообщество удаленной работы в мире, насчитывающее более 6 миллионов посетителей в месяц. Оно служит основным местом назначения для компаний, отходящих от традиционных office-based models, предлагая широкий спектр объявлений в области разработки ПО, дизайна, маркетинга и клиентской поддержки.

Высококачественные структурированные данные

Платформа известна своими высокоструктурированными данными. Каждое объявление обычно содержит конкретные региональные требования, диапазоны зарплат и подробные профили компаний. Такая структура делает сайт идеальной целью для веб-скрапинга, так как данные последовательны и их легко классифицировать для вторичного использования.

Стратегическая ценность для специалистов по данным

Для рекрутеров и исследователей рынка WWR — это настоящая золотая жила. Парсинг этого сайта позволяет в реальном времени отслеживать тенденции найма, проводить бенчмаркинг зарплат в различных технических секторах и генерировать лиды для B2B-услуг, ориентированных на компании, работающие в формате remote-first. Это дает прозрачное представление о глобальном рынке удаленного труда.

Зачем Парсить We Work Remotely?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из We Work Remotely.

Создание нишевого агрегатора или портала удаленной работы

Проведение конкурентного анализа зарплат в разных отраслях

Поиск компаний, активно нанимающих сотрудников на удаленку

Мониторинг глобального спроса на конкретные технические навыки

Генерация лидов для поставщиков HR-технологий и корпоративных льгот

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге We Work Remotely.

Срабатывание защиты от ботов Cloudflare

Обработка несоответствий в тегах местоположения

Парсинг различных форматов зарплат внутри описаний

Управление IP rate limits при массовом обходе страниц с деталями вакансий

Скрапинг We Work Remotely с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из We Work Remotely. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по We Work Remotely, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг We Work Remotely без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из We Work Remotely. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по We Work Remotely, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Настройка парсинга без кода через визуальный интерфейс

- Автоматическая обработка мер защиты от ботов и прокси

- Запуск по расписанию для обновления доски вакансий в реальном времени

- Прямой экспорт в JSON, CSV или Google Sheets

- Облачное выполнение без использования локальных ресурсов

No-Code Парсеры для We Work Remotely

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить We Work Remotely без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для We Work Remotely

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить We Work Remotely без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Отправка запроса с кастомными заголовками

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Поиск списка вакансий

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Вакансия: {title} | Компания: {company}')

except Exception as e:

print(f'Ошибка: {e}')Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить We Work Remotely с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Отправка запроса с кастомными заголовками

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Поиск списка вакансий

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Вакансия: {title} | Компания: {company}')

except Exception as e:

print(f'Ошибка: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def run():

async with async_playwright() as p:

# Запуск headless-браузера

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

await page.goto('https://weworkremotely.com/')

# Ожидание загрузки основного контейнера

await page.wait_for_selector('.jobs-container')

jobs = await page.query_selector_all('li.feature')

for job in jobs:

title = await job.query_selector('.title')

if title:

print(await title.inner_text())

await browser.close()

asyncio.run(run())Python + Scrapy

import scrapy

class WwrSpider(scrapy.Spider):

name = 'wwr_spider'

start_urls = ['https://weworkremotely.com/']

def parse(self, response):

# Итерация по элементам списка вакансий

for job in response.css('li.feature'):

yield {

'title': job.css('span.title::text').get(),

'company': job.css('span.company::text').get(),

'url': response.urljoin(job.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://weworkremotely.com/');

// Извлечение данных с помощью evaluate

const jobs = await page.evaluate(() => {

return Array.from(document.querySelectorAll('li.feature')).map(li => ({

title: li.querySelector('.title')?.innerText.trim(),

company: li.querySelector('.company')?.innerText.trim()

}));

});

console.log(jobs);

await browser.close();

})();Что Можно Делать С Данными We Work Remotely

Изучите практические применения и инсайты из данных We Work Remotely.

Агрегатор удаленных вакансий

Создайте специализированную платформу для поиска работы в узких технических нишах, таких как Rust или AI.

Как реализовать:

- 1Ежедневно парсить WWR на предмет новых объявлений

- 2Фильтровать по конкретным ключевым словам и категориям

- 3Хранить данные в базе данных с возможностью поиска

- 4Автоматизировать публикации в социальных сетях для новых вакансий

Используйте Automatio для извлечения данных из We Work Remotely и создания этих приложений без написания кода.

Что Можно Делать С Данными We Work Remotely

- Агрегатор удаленных вакансий

Создайте специализированную платформу для поиска работы в узких технических нишах, таких как Rust или AI.

- Ежедневно парсить WWR на предмет новых объявлений

- Фильтровать по конкретным ключевым словам и категориям

- Хранить данные в базе данных с возможностью поиска

- Автоматизировать публикации в социальных сетях для новых вакансий

- Анализ трендов зарплат

Анализируйте данные об удаленных зарплатах для определения глобальных стандартов компенсации по ролям.

- Извлекать поля зарплаты из описаний вакансий

- Нормализовать данные в единую валюту

- Сегментировать по должностям и уровню опыта

- Генерировать ежеквартальные отчеты по рынку

- Лидогенерация для HR Tech

Выявляйте компании, активно нанимающие удаленные команды, для продажи ПО для HR, расчета зарплат и управления льготами.

- Мониторить список «Топ-100 удаленных компаний»

- Отслеживать частоту новых объявлений о работе

- Выявлять лиц, принимающих решения в нанимающих компаниях

- Проводить аутрич с персонализированными B2B-решениями

- Исторические тренды найма

Анализируйте долгосрочные данные, чтобы понять, как спрос на удаленную работу меняется в зависимости от сезона или экономической ситуации.

- Архивировать объявления за 12+ месяцев

- Рассчитывать темпы роста по категориям

- Визуализировать тренды с помощью инструментов BI

- Прогнозировать будущий спрос на навыки

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу We Work Remotely

Экспертные советы для успешного извлечения данных из We Work Remotely.

Используйте эндпоинт /remote-jobs.rss для получения чистого, машиночитаемого XML-фида, который позволяет обойти сложный парсинг HTML.

Используйте ротацию резидентных прокси, чтобы избежать защитных экранов Cloudflare и перманентных банов по IP при высокочастотном сканировании.

Внедряйте рандомизированные задержки между запросами, чтобы имитировать поведение реального пользователя и избежать ограничения частоты запросов.

Нормализуйте данные о местоположении, такие как 'Anywhere', в 'Global' или 'Remote' для более согласованной фильтрации в базе данных.

Установите User-Agent на строку современного браузера, чтобы ваш парсер не пометили как простой скрипт-скрепер.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape Freelancer.com: A Complete Technical Guide

How to Scrape Upwork: A Comprehensive Technical Guide

How to Scrape Arc.dev: The Complete Guide to Remote Job Data

How to Scrape Toptal | Toptal Web Scraper Guide

How to Scrape Guru.com: A Comprehensive Web Scraping Guide

How to Scrape Fiverr | Fiverr Web Scraper Guide

How to Scrape Indeed: 2025 Guide for Job Market Data

How to Scrape Charter Global | IT Services & Job Board Scraper

Часто задаваемые вопросы о We Work Remotely

Найдите ответы на частые вопросы о We Work Remotely