Как парсить WebElements: руководство по сбору данных периодической таблицы

Извлекайте точные данные о химических элементах из WebElements. Собирайте сведения об атомной массе, физических свойствах и истории открытий для исследований и...

О WebElements

Узнайте, что предлагает WebElements и какие ценные данные можно извлечь.

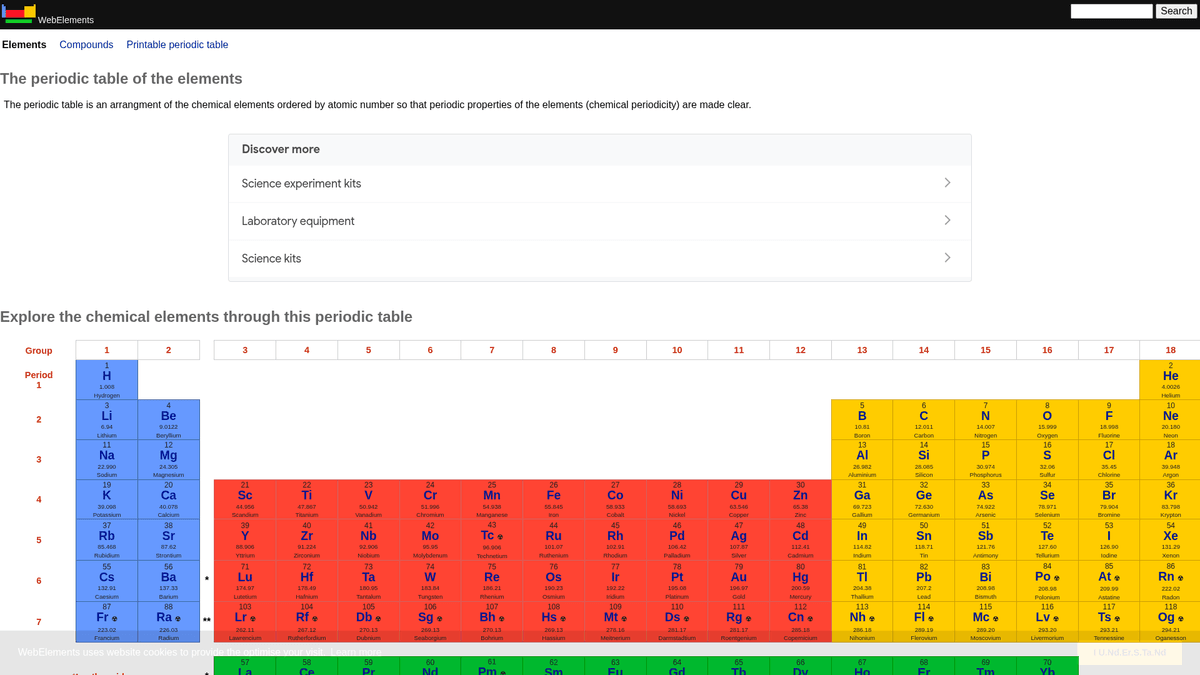

WebElements — это ведущая онлайн-версия периодической таблицы, поддерживаемая Марком Винтером в Шеффилдском университете. Запущенный в 1993 году, он стал первой периодической таблицей во Всемирной паутине и с тех пор превратился в авторитетный ресурс для студентов, ученых и профессиональных химиков. Сайт предлагает глубокие структурированные данные о каждом известном химическом элементе: от стандартных атомных масс до сложных электронных конфигураций.

Ценность парсинга WebElements заключается в получении высококачественных, рецензируемых научных данных. Для разработчиков, создающих образовательные инструменты, исследователей, проводящих анализ тенденций периодической таблицы, или материаловедов, обучающих machine learning models, WebElements является надежным и технически богатым источником истины, который трудно собрать вручную.

Зачем Парсить WebElements?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из WebElements.

Сбор высококачественных научных данных для разработки образовательных инструментов.

Агрегация свойств элементов для исследований в области материаловедения и обучения machine learning models.

Автоматическое наполнение систем инвентаризации лабораторий химическими спецификациями.

Исторический анализ открытий элементов и научного прогресса.

Создание комплексных наборов данных о химических свойствах для академических публикаций.

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге WebElements.

Данные распределены по нескольким подстраницам для каждого элемента (например, /history, /compounds).

Устаревшие макеты HTML на основе таблиц требуют точной логики селекторов.

Путаница в названии домена с классом 'WebElement' в Selenium при поиске поддержки.

Скрапинг WebElements с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из WebElements. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по WebElements, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг WebElements без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из WebElements. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по WebElements, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Навигация без написания кода по иерархическим структурам элементов.

- Автоматическая обработка извлечения сложных научных таблиц.

- Облачное выполнение позволяет извлекать полные наборы данных без простоя локального оборудования.

- Простой экспорт в CSV/JSON для прямого использования в инструментах научного анализа.

- Плановый мониторинг позволяет обнаруживать обновления подтвержденных данных об элементах.

No-Code Парсеры для WebElements

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить WebElements без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для WebElements

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить WebElements без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

import time

# Целевой URL для конкретного элемента (например, золото)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Извлечение названия элемента из тега H1

name = soup.find('h1').get_text().strip()

# Извлечение атомного номера с использованием логики меток таблиц

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Элемент: {name}, Атомный номер: {atomic_number}')

except Exception as e:

print(f'Произошла ошибка: {e}')

# Соблюдение рекомендаций robots.txt

time.sleep(1)

scrape_element(url)Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить WebElements с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# Целевой URL для конкретного элемента (например, золото)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Извлечение названия элемента из тега H1

name = soup.find('h1').get_text().strip()

# Извлечение атомного номера с использованием логики меток таблиц

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Элемент: {name}, Атомный номер: {atomic_number}')

except Exception as e:

print(f'Произошла ошибка: {e}')

# Соблюдение рекомендаций robots.txt

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Элементы связаны гиперссылками из главной периодической таблицы

page.goto('https://www.webelements.com/iron/')

# Ожидаем появления таблицы свойств

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Переходим по каждой ссылке на элемент в периодической таблице

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Извлеченные данные:', data);

await browser.close();

})();Что Можно Делать С Данными WebElements

Изучите практические применения и инсайты из данных WebElements.

Обучение AI для материаловедения

Обучение machine learning models для предсказания свойств новых сплавов на основе характеристик элементов.

Как реализовать:

- 1Извлеките физические свойства всех металлических элементов.

- 2Очистите и нормализуйте такие значения, как плотность и температура плавления.

- 3Передайте данные в регрессионные или прогнозные материаловедческие models.

- 4Сверьте прогнозы с существующими экспериментальными данными о сплавах.

Используйте Automatio для извлечения данных из WebElements и создания этих приложений без написания кода.

Что Можно Делать С Данными WebElements

- Обучение AI для материаловедения

Обучение machine learning models для предсказания свойств новых сплавов на основе характеристик элементов.

- Извлеките физические свойства всех металлических элементов.

- Очистите и нормализуйте такие значения, как плотность и температура плавления.

- Передайте данные в регрессионные или прогнозные материаловедческие models.

- Сверьте прогнозы с существующими экспериментальными данными о сплавах.

- Контент для образовательных приложений

Наполнение интерактивных периодических таблиц для студентов-химиков проверенными научными данными.

- Соберите атомные номера, символы и описания элементов.

- Извлеките исторический контекст и детали открытия.

- Организуйте данные по периодическим группам и блокам.

- Интегрируйте данные в пользовательский интерфейс с визуализацией кристаллических структур.

- Анализ химических закономерностей

Визуализация периодических тенденций, таких как энергия ионизации или атомный радиус, по периодам и группам.

- Соберите данные о свойствах каждого элемента в числовом порядке.

- Классифицируйте элементы по соответствующим группам.

- Используйте библиотеки графиков для визуализации тенденций.

- Выявите и проанализируйте аномальные точки данных в конкретных блоках.

- Управление лабораторными запасами

Автоматическое заполнение систем управления химическими веществами данными о физической безопасности и плотности.

- Сопоставьте внутренний инвентарный список с записями WebElements.

- Соберите данные о плотности, опасностях при хранении и температуре плавления.

- Обновите централизованную лабораторную базу данных через API.

- Настройте автоматическую генерацию предупреждений о безопасности для опасных элементов.

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу WebElements

Экспертные советы для успешного извлечения данных из WebElements.

Соблюдайте Crawl-delay

1, указанный в файле robots.txt сайта.

Используйте Атомный номер в качестве primary key для обеспечения целостности базы данных.

Выполняйте парсинг подстраниц «history» и «compounds» для получения полного набора данных по каждому элементу.

Сосредоточьтесь на селекторах, ориентированных на таблицы, так как структура сайта традиционна и стабильна.

Сверяйте данные со стандартами IUPAC, если они используются для критически важных исследований.

Сохраняйте числовые значения, такие как плотность или температура плавления, в формате float для удобства последующего анализа.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Часто задаваемые вопросы о WebElements

Найдите ответы на частые вопросы о WebElements