Si të bëjmë Scraping në WebElements: Guida për të Dhënat e Tabelës Periodike

Nxirrni të dhëna precize të elementeve kimike nga WebElements. Bëni scraping për peshat atomike, vetitë fizike dhe historinë e zbulimeve për kërkime dhe...

Rreth WebElements

Zbuloni çfarë ofron WebElements dhe cilat të dhëna të vlefshme mund të nxirren.

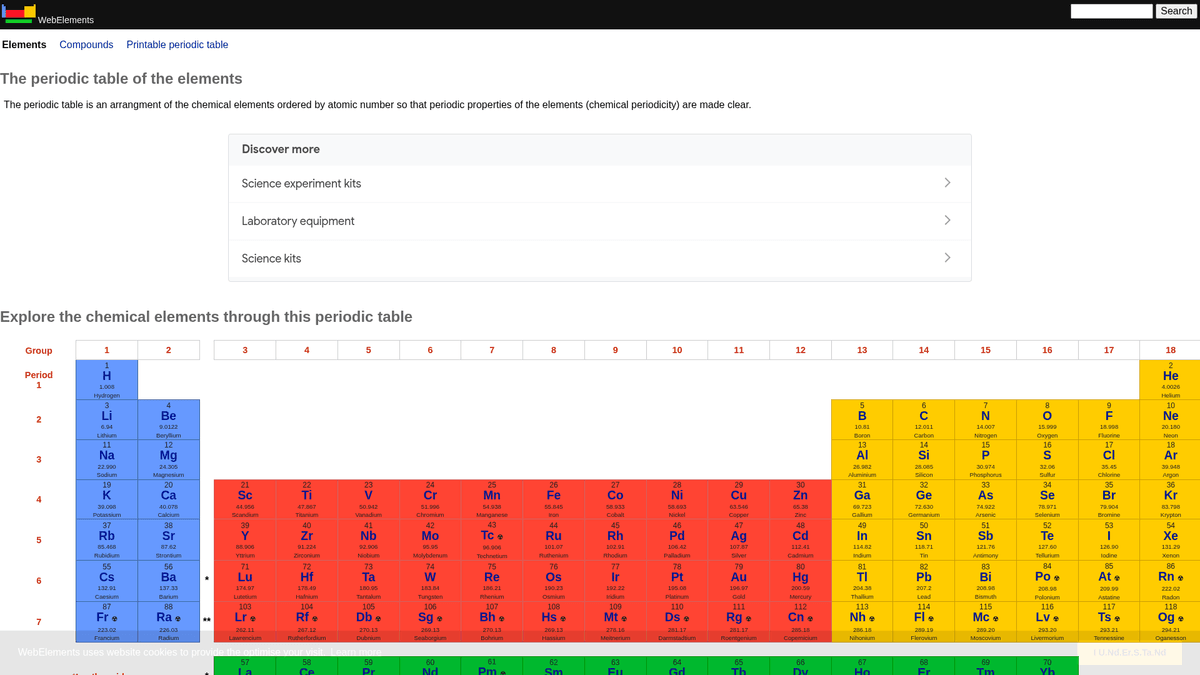

WebElements është një tabelë periodike online kryesore e mirëmbajtur nga Mark Winter në Universitetin e Sheffield. E lançuar në vitin 1993, ajo ishte tabela e parë periodike në World Wide Web dhe që atëherë është bërë një burim me autoritet të lartë për studentët, akademikët dhe kimistët profesionistë. Faqja ofron të dhëna të thella dhe të strukturuara për çdo element kimik të njohur, nga peshat atomike standarde deri te konfigurimet komplekse elektronike.

Vlera e scraping-ut të WebElements qëndron në të dhënat e tij shkencore të cilësisë së lartë, të rishikuara nga kolegët. Për zhvilluesit që ndërtojnë mjete edukative, studiuesit që kryejnë analiza trendesh në tabelën periodike, ose shkencëtarët e materialeve që trajnojnë machine learning models, WebElements ofron një burim të besueshëm dhe teknikisht të pasur që është i vështirë të agregohet manualisht.

Pse Të Bëni Scraping WebElements?

Zbuloni vlerën e biznesit dhe rastet e përdorimit për nxjerrjen e të dhënave nga WebElements.

Mbledhja e të dhënave shkencore të cilësisë së lartë për zhvillimin e mjeteve edukative.

Agregimi i vetive të elementeve për kërkime në shkencën e materialeve dhe machine learning models.

Popullimi automatik i sistemeve të inventarit të laboratorit me specifika kimike.

Analiza historike e zbulimeve të elementeve dhe përparimit shkencor.

Krijimi i datasets gjithëpërfshirës të vetive kimike për publikime akademike.

Sfidat e Scraping

Sfidat teknike që mund të hasni gjatë scraping të WebElements.

Të dhënat janë të shpërndara në disa sub-faqe për çdo element (p.sh., /history, /compounds).

Layout-et e vjetra HTML të bazuara në tabela kërkojnë logjikë precize përzgjedhjeje.

Konfuzioni i emrit të domenit me klasën 'WebElement' të Selenium gjatë kërkimit për mbështetje.

Nxirr të dhëna nga WebElements me AI

Pa nevojë për kod. Nxirrni të dhëna në minuta me automatizimin e bazuar në AI.

Si funksionon

Përshkruani çfarë ju nevojitet

Tregojini AI-së çfarë të dhënash dëshironi të nxirrni nga WebElements. Thjesht shkruajeni në gjuhë natyrale — pa nevojë për kod apo selektorë.

AI nxjerr të dhënat

Inteligjenca jonë artificiale lundron WebElements, përpunon përmbajtjen dinamike dhe nxjerr saktësisht atë që kërkuat.

Merrni të dhënat tuaja

Merrni të dhëna të pastra dhe të strukturuara gati për eksport si CSV, JSON ose për t'i dërguar drejtpërdrejt te aplikacionet tuaja.

Pse të përdorni AI për nxjerrjen e të dhënave

AI e bën të lehtë nxjerrjen e të dhënave nga WebElements pa shkruar kod. Platforma jonë e bazuar në inteligjencë artificiale kupton çfarë të dhënash dëshironi — thjesht përshkruajini në gjuhë natyrale dhe AI i nxjerr automatikisht.

How to scrape with AI:

- Përshkruani çfarë ju nevojitet: Tregojini AI-së çfarë të dhënash dëshironi të nxirrni nga WebElements. Thjesht shkruajeni në gjuhë natyrale — pa nevojë për kod apo selektorë.

- AI nxjerr të dhënat: Inteligjenca jonë artificiale lundron WebElements, përpunon përmbajtjen dinamike dhe nxjerr saktësisht atë që kërkuat.

- Merrni të dhënat tuaja: Merrni të dhëna të pastra dhe të strukturuara gati për eksport si CSV, JSON ose për t'i dërguar drejtpërdrejt te aplikacionet tuaja.

Why use AI for scraping:

- Navigim no-code përmes strukturave hierarkike të elementeve.

- Trajton nxjerrjen e tabelave shkencore komplekse automatikisht.

- Ekzekutimi në cloud lejon nxjerrjen e dataset-it të plotë pa kohë joproduktive lokale.

- Eksport i lehtë në CSV/JSON për përdorim të drejtpërdrejtë në mjetet e analizës shkencore.

- Monitorimi i planifikuar mund të detektojë përditësime në të dhënat e konfirmuara të elementeve.

Web Scraper Pa Kod për WebElements

Alternativa klikoni-dhe-zgjidhni për scraping të fuqizuar nga AI

Disa mjete pa kod si Browse.ai, Octoparse, Axiom dhe ParseHub mund t'ju ndihmojnë të bëni scraping WebElements pa shkruar kod. Këto mjete zakonisht përdorin ndërfaqe vizuale për të zgjedhur të dhënat, edhe pse mund të kenë vështirësi me përmbajtje dinamike komplekse ose masa anti-bot.

Rrjedha Tipike e Punës me Mjete Pa Kod

Sfida të Zakonshme

Kurba e të mësuarit

Kuptimi i selektorëve dhe logjikës së nxjerrjes kërkon kohë

Selektorët prishen

Ndryshimet e faqes mund të prishin të gjithë rrjedhën e punës

Probleme me përmbajtje dinamike

Faqet me shumë JavaScript kërkojnë zgjidhje komplekse

Kufizimet e CAPTCHA

Shumica e mjeteve kërkojnë ndërhyrje manuale për CAPTCHA

Bllokimi i IP

Scraping agresiv mund të çojë në bllokimin e IP-së tuaj

Web Scraper Pa Kod për WebElements

Disa mjete pa kod si Browse.ai, Octoparse, Axiom dhe ParseHub mund t'ju ndihmojnë të bëni scraping WebElements pa shkruar kod. Këto mjete zakonisht përdorin ndërfaqe vizuale për të zgjedhur të dhënat, edhe pse mund të kenë vështirësi me përmbajtje dinamike komplekse ose masa anti-bot.

Rrjedha Tipike e Punës me Mjete Pa Kod

- Instaloni shtesën e shfletuesit ose regjistrohuni në platformë

- Navigoni në faqen e internetit të synuar dhe hapni mjetin

- Zgjidhni elementet e të dhënave për nxjerrje me point-and-click

- Konfiguroni selektorët CSS për çdo fushë të dhënash

- Vendosni rregullat e faqosjes për të scrape faqe të shumta

- Menaxhoni CAPTCHA (shpesh kërkon zgjidhje manuale)

- Konfiguroni planifikimin për ekzekutime automatike

- Eksportoni të dhënat në CSV, JSON ose lidhuni përmes API

Sfida të Zakonshme

- Kurba e të mësuarit: Kuptimi i selektorëve dhe logjikës së nxjerrjes kërkon kohë

- Selektorët prishen: Ndryshimet e faqes mund të prishin të gjithë rrjedhën e punës

- Probleme me përmbajtje dinamike: Faqet me shumë JavaScript kërkojnë zgjidhje komplekse

- Kufizimet e CAPTCHA: Shumica e mjeteve kërkojnë ndërhyrje manuale për CAPTCHA

- Bllokimi i IP: Scraping agresiv mund të çojë në bllokimin e IP-së tuaj

Shembuj kodesh

import requests

from bs4 import BeautifulSoup

import time

# Target URL for a specific element (e.g., Gold)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting the element name from the H1 tag

name = soup.find('h1').get_text().strip()

# Extracting Atomic Number using table label logic

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'An error occurred: {e}')

# Following robots.txt recommendations

time.sleep(1)

scrape_element(url)Kur të Përdoret

Më e mira për faqe HTML statike ku përmbajtja ngarkohet në anën e serverit. Qasja më e shpejtë dhe më e thjeshtë kur renderimi i JavaScript nuk është i nevojshëm.

Avantazhet

- ●Ekzekutimi më i shpejtë (pa overhead të shfletuesit)

- ●Konsumi më i ulët i burimeve

- ●E lehtë për tu paralelizuar me asyncio

- ●E shkëlqyer për API dhe faqe statike

Kufizimet

- ●Nuk mund të ekzekutojë JavaScript

- ●Dështon në SPA dhe përmbajtje dinamike

- ●Mund të ketë vështirësi me sisteme komplekse anti-bot

How to Scrape WebElements with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# Target URL for a specific element (e.g., Gold)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting the element name from the H1 tag

name = soup.find('h1').get_text().strip()

# Extracting Atomic Number using table label logic

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'An error occurred: {e}')

# Following robots.txt recommendations

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Elements are linked from the main periodic table

page.goto('https://www.webelements.com/iron/')

# Wait for the property table to be present

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Follow every element link in the periodic table

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Extracted Data:', data);

await browser.close();

})();Çfarë Mund Të Bëni Me Të Dhënat e WebElements

Eksploroni aplikacionet praktike dhe njohuritë nga të dhënat e WebElements.

Trajnimi i AI në Shkencën e Materialeve

Trajnimi i machine learning models për të parashikuar vetitë e aliazheve të reja bazuar në atributet elementare.

Si të implementohet:

- 1Nxirrni vetitë fizike për të gjithë elementet metalikë.

- 2Pastroni dhe normalizoni vlerat si dendësia dhe pikat e shkrirjes.

- 3Futni të dhënat në model-e regresioni ose parashikimi të materialeve.

- 4Verifikoni parashikimet kundrejt të dhënave eksperimentale ekzistuese të aliazheve.

Përdorni Automatio për të nxjerrë të dhëna nga WebElements dhe ndërtoni këto aplikacione pa shkruar kod.

Çfarë Mund Të Bëni Me Të Dhënat e WebElements

- Trajnimi i AI në Shkencën e Materialeve

Trajnimi i machine learning models për të parashikuar vetitë e aliazheve të reja bazuar në atributet elementare.

- Nxirrni vetitë fizike për të gjithë elementet metalikë.

- Pastroni dhe normalizoni vlerat si dendësia dhe pikat e shkrirjes.

- Futni të dhënat në model-e regresioni ose parashikimi të materialeve.

- Verifikoni parashikimet kundrejt të dhënave eksperimentale ekzistuese të aliazheve.

- Përmbajtje për Aplikacione Edukative

Popullimi i tabelave periodike interaktive për studentët e kimisë me të dhëna të rishikuara nga ekspertët.

- Bëni scraping numrave atomikë, simboleve dhe përshkrimeve të elementeve.

- Nxirrni kontekstin historik dhe detajet e zbulimit.

- Organizoni të dhënat sipas grupit periodik dhe bllokut.

- Integroni të dhënat në një ndërfaqe përdoruesi me struktura vizuale kristalore.

- Analiza e Trendeve Kimike

Vizualizimi i trendeve periodike si energjia e jonizimit ose rrezja atomike përgjatë periodave dhe grupeve.

- Mblidhni të dhënat e vetive për çdo element në rregull numerik.

- Kategorizoni elementet në grupet e tyre përkatëse.

- Përdorni librari grafike për të vizualizuar trendet.

- Identifikoni dhe analizoni pikat anomale të të dhënave në blloqe specifike.

- Menaxhimi i Inventarit të Laboratorit

Popullimi automatik i sistemeve të menaxhimit kimik me të dhëna të sigurisë fizike dhe dendësisë.

- Lidhni listën e inventarit të brendshëm me hyrjet e WebElements.

- Bëni scraping për dendësinë, rreziqet e ruajtjes dhe të dhënat e pikës së shkrirjes.

- Përditësoni database-in e centralizuar të laboratorit përmes API.

- Gjeneroni paralajmërime automatike të sigurisë për elementet me rrezik të lartë.

Superkariko workflow-n tend me automatizimin AI

Automatio kombinon fuqine e agjenteve AI, automatizimin e web-it dhe integrimet inteligjente per te te ndihmuar te arrish me shume ne me pak kohe.

Këshilla Pro Për Scraping të WebElements

Këshilla ekspertësh për nxjerrjen e suksesshme të të dhënave nga WebElements.

Respektoni Crawl-delay

1 të specifikuar në skedarin robots.txt të faqes.

Përdorni Numrin Atomik si primary key për konsistencën e database-it.

Bëni crawl sub-faqet 'history' dhe 'compounds' për një dataset të plotë për çdo element.

Përqendrohuni në selektorët e bazuar në tabela pasi struktura e faqes është shumë tradicionale dhe e qëndrueshme.

Verifikoni të dhënat sipas standardeve IUPAC nëse përdoren për kërkime kritike.

Ruani vlerat numerike si dendësia ose pikat e shkrirjes si floats për analizë më të lehtë.

Deshmi

Cfare thone perdoruesit tane

Bashkohu me mijera perdorues te kenaqur qe kane transformuar workflow-n e tyre

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Te lidhura Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Pyetjet e bera shpesh rreth WebElements

Gjej pergjigje per pyetjet e zakonshme rreth WebElements