Hur man scrapar WebElements: Guide för periodiska systemets data

Extrahera exakt kemisk data om grundämnen från WebElements. Scrapa atomvikter, fysiska egenskaper och upptäcktshistoria för forskning och AI-tillämpningar.

Om WebElements

Upptäck vad WebElements erbjuder och vilka värdefulla data som kan extraheras.

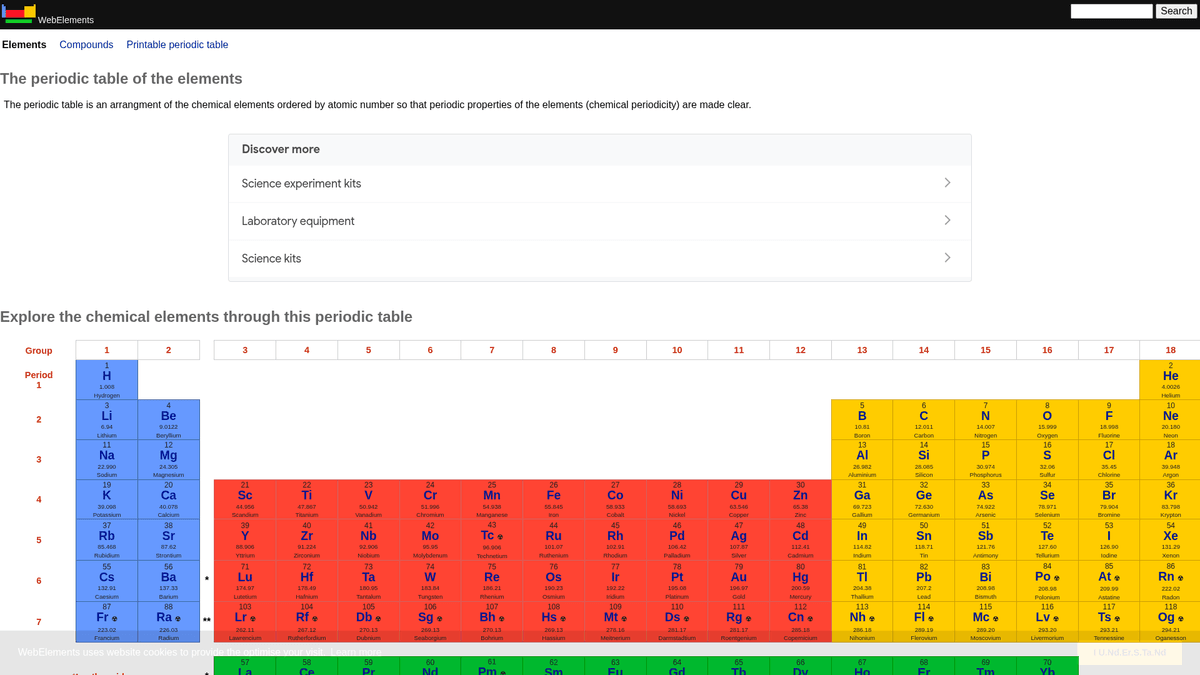

WebElements är ett ledande periodiskt system online som underhålls av Mark Winter vid University of Sheffield. Det lanserades 1993 och var det första periodiska systemet på World Wide Web och har sedan dess blivit en resurs med hög auktoritet för studenter, akademiker och professionella kemister. Sajten erbjuder djup, strukturerad data om varje känt kemiskt grundämne, från standardiserade atomvikter till komplexa elektronkonfigurationer.

Värdet av att scrapa WebElements ligger i dess högkvalitativa, expertgranskade vetenskapliga data. För utvecklare som bygger utbildningsverktyg, forskare som utför trendanalyser över det periodiska systemet eller materialforskare som tränar machine learning-modeller, utgör WebElements en pålitlig och tekniskt rik källa till sanning som är svår att sammanställa manuellt.

Varför Skrapa WebElements?

Upptäck affärsvärdet och användningsfallen för dataextraktion från WebElements.

Insamling av högkvalitativ vetenskaplig data för utveckling av utbildningsverktyg.

Sammanställning av egenskaper hos grundämnen för materialforskning och machine learning-modeller.

Automatisk ifyllnad av laboratorieinventariesystem med kemiska specifikationer.

Historisk analys av upptäckter av grundämnen och vetenskapliga framsteg.

Skapande av omfattande dataset över kemiska egenskaper för akademiska publikationer.

Skrapningsutmaningar

Tekniska utmaningar du kan stöta på när du skrapar WebElements.

Data är spridd över flera undersidor per grundämne (t.ex. /history, /compounds).

Äldre tabellbaserade HTML-layouter kräver exakt selektorslogik.

Förväxling av domännamn med Seleniums 'WebElement'-klass vid sökning efter support.

Skrapa WebElements med AI

Ingen kod krävs. Extrahera data på minuter med AI-driven automatisering.

Hur det fungerar

Beskriv vad du behöver

Berätta för AI vilka data du vill extrahera från WebElements. Skriv det bara på vanligt språk — ingen kod eller selektorer behövs.

AI extraherar datan

Vår artificiella intelligens navigerar WebElements, hanterar dynamiskt innehåll och extraherar exakt det du bad om.

Få dina data

Få ren, strukturerad data redo att exportera som CSV, JSON eller skicka direkt till dina appar och arbetsflöden.

Varför använda AI för skrapning

AI gör det enkelt att skrapa WebElements utan att skriva kod. Vår AI-drivna plattform använder artificiell intelligens för att förstå vilka data du vill ha — beskriv det bara på vanligt språk och AI extraherar dem automatiskt.

How to scrape with AI:

- Beskriv vad du behöver: Berätta för AI vilka data du vill extrahera från WebElements. Skriv det bara på vanligt språk — ingen kod eller selektorer behövs.

- AI extraherar datan: Vår artificiella intelligens navigerar WebElements, hanterar dynamiskt innehåll och extraherar exakt det du bad om.

- Få dina data: Få ren, strukturerad data redo att exportera som CSV, JSON eller skicka direkt till dina appar och arbetsflöden.

Why use AI for scraping:

- No-code-navigering genom hierarkiska strukturer för grundämnen.

- Hanterar extrahering av komplexa vetenskapliga tabeller automatiskt.

- Körning i molnet möjliggör extrahering av hela dataset utan lokal driftstopp.

- Enkel export till CSV/JSON för direkt användning i vetenskapliga analysverktyg.

- Schemalagd övervakning kan upptäcka uppdateringar av bekräftad data för grundämnen.

No-code webbskrapare för WebElements

Peka-och-klicka-alternativ till AI-driven skrapning

Flera no-code-verktyg som Browse.ai, Octoparse, Axiom och ParseHub kan hjälpa dig att skrapa WebElements utan att skriva kod. Dessa verktyg använder vanligtvis visuella gränssnitt för att välja data, även om de kan ha problem med komplext dynamiskt innehåll eller anti-bot-åtgärder.

Typiskt arbetsflöde med no-code-verktyg

Vanliga utmaningar

Inlärningskurva

Att förstå selektorer och extraktionslogik tar tid

Selektorer går sönder

Webbplatsändringar kan förstöra hela ditt arbetsflöde

Problem med dynamiskt innehåll

JavaScript-tunga sidor kräver komplexa lösningar

CAPTCHA-begränsningar

De flesta verktyg kräver manuell hantering av CAPTCHAs

IP-blockering

Aggressiv scraping kan leda till att din IP blockeras

No-code webbskrapare för WebElements

Flera no-code-verktyg som Browse.ai, Octoparse, Axiom och ParseHub kan hjälpa dig att skrapa WebElements utan att skriva kod. Dessa verktyg använder vanligtvis visuella gränssnitt för att välja data, även om de kan ha problem med komplext dynamiskt innehåll eller anti-bot-åtgärder.

Typiskt arbetsflöde med no-code-verktyg

- Installera webbläsartillägg eller registrera dig på plattformen

- Navigera till målwebbplatsen och öppna verktyget

- Välj dataelement att extrahera med point-and-click

- Konfigurera CSS-selektorer för varje datafält

- Ställ in pagineringsregler för att scrapa flera sidor

- Hantera CAPTCHAs (kräver ofta manuell lösning)

- Konfigurera schemaläggning för automatiska körningar

- Exportera data till CSV, JSON eller anslut via API

Vanliga utmaningar

- Inlärningskurva: Att förstå selektorer och extraktionslogik tar tid

- Selektorer går sönder: Webbplatsändringar kan förstöra hela ditt arbetsflöde

- Problem med dynamiskt innehåll: JavaScript-tunga sidor kräver komplexa lösningar

- CAPTCHA-begränsningar: De flesta verktyg kräver manuell hantering av CAPTCHAs

- IP-blockering: Aggressiv scraping kan leda till att din IP blockeras

Kodexempel

import requests

from bs4 import BeautifulSoup

import time

# Mål-URL för ett specifikt grundämne (t.ex. guld)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extraherar grundämnets namn från H1-taggen

name = soup.find('h1').get_text().strip()

# Extraherar atomnummer med hjälp av tabellrubrikslogik

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'An error occurred: {e}')

# Följer rekommendationer i robots.txt

time.sleep(1)

scrape_element(url)När ska det användas

Bäst för statiska HTML-sidor med minimal JavaScript. Idealiskt för bloggar, nyhetssidor och enkla e-handelsproduktsidor.

Fördelar

- ●Snabbaste exekveringen (ingen webbläsaröverhead)

- ●Lägsta resursförbrukning

- ●Lätt att parallellisera med asyncio

- ●Utmärkt för API:er och statiska sidor

Begränsningar

- ●Kan inte köra JavaScript

- ●Misslyckas på SPA:er och dynamiskt innehåll

- ●Kan ha problem med komplexa anti-bot-system

Hur man skrapar WebElements med kod

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# Mål-URL för ett specifikt grundämne (t.ex. guld)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extraherar grundämnets namn från H1-taggen

name = soup.find('h1').get_text().strip()

# Extraherar atomnummer med hjälp av tabellrubrikslogik

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'An error occurred: {e}')

# Följer rekommendationer i robots.txt

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Grundämnen länkas från det huvudsakliga periodiska systemet

page.goto('https://www.webelements.com/iron/')

# Vänta tills egenskapstabellen är tillgänglig

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Följ varje länk till grundämnen i det periodiska systemet

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Extracted Data:', data);

await browser.close();

})();Vad Du Kan Göra Med WebElements-Data

Utforska praktiska tillämpningar och insikter från WebElements-data.

AI-träning för materialvetenskap

Träna machine learning-modeller för att förutsäga egenskaper hos nya legeringar baserat på egenskaper hos grundämnen.

Så här implementerar du:

- 1Extrahera fysiska egenskaper för alla metalliska grundämnen.

- 2Rensa och normalisera värden som densitet och smältpunkter.

- 3Mata in datan i regressions- eller prediktiva materialmodeller.

- 4Verifiera förutsägelser mot befintliga experimentella legeringsdata.

Använd Automatio för att extrahera data från WebElements och bygga dessa applikationer utan att skriva kod.

Vad Du Kan Göra Med WebElements-Data

- AI-träning för materialvetenskap

Träna machine learning-modeller för att förutsäga egenskaper hos nya legeringar baserat på egenskaper hos grundämnen.

- Extrahera fysiska egenskaper för alla metalliska grundämnen.

- Rensa och normalisera värden som densitet och smältpunkter.

- Mata in datan i regressions- eller prediktiva materialmodeller.

- Verifiera förutsägelser mot befintliga experimentella legeringsdata.

- Innehåll till utbildningsappar

Fylla interaktiva periodiska system för kemistudenter med expertgranskad data.

- Scrapa atomnummer, symboler och beskrivningar av grundämnen.

- Extrahera historisk kontext och upptäcktsdetaljer.

- Organisera datan efter periodisk grupp och block.

- Integrera i ett användargränssnitt med visuella kristallstrukturer.

- Analys av kemiska trender

Visualisera periodiska trender som joniseringsenergi eller atomradie över perioder och grupper.

- Samla in egenskapsdata för varje grundämne i numerisk ordning.

- Kategorisera grundämnen i deras respektive grupper.

- Använd grafbibliotek för att visualisera trender.

- Identifiera och analysera avvikande datapunkter i specifika block.

- Hantering av laboratorieinventarier

Automatiskt fylla i system för kemikaliehantering med data om fysisk säkerhet och densitet.

- Matcha interna lagerlistor mot poster i WebElements.

- Scrapa data om densitet, lagringsrisker och smältpunkter.

- Uppdatera den centraliserade labbdatabasen via API.

- Generera automatiska säkerhetsvarningar för högriskämnen.

Superladda ditt arbetsflode med AI-automatisering

Automatio kombinerar kraften av AI-agenter, webbautomatisering och smarta integrationer for att hjalpa dig astadkomma mer pa kortare tid.

Proffstips för Skrapning av WebElements

Expertråd för framgångsrik dataextraktion från WebElements.

Respektera Crawl-delay

1 som anges i sajtens robots.txt-fil.

Använd atomnummer som primärnyckel för databaskonsistens.

Crawla undersidorna 'history' och 'compounds' för ett komplett dataset per grundämne.

Fokusera på tabellbaserade selektorer eftersom sajtens struktur är mycket traditionell och stabil.

Verifiera data mot IUPAC-standarder om den används för kritisk forskning.

Lagra numeriska värden som densitet eller smältpunkter som floats för enklare analys.

Omdomen

Vad vara anvandare sager

Ga med tusentals nojda anvandare som har transformerat sitt arbetsflode

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relaterat Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Vanliga fragor om WebElements

Hitta svar pa vanliga fragor om WebElements