วิธี scraping ข้อมูล Budget Bytes: ดึงข้อมูลสูตรอาหารและต้นทุน

เรียนรู้วิธีการ scraping ข้อมูลจาก Budget Bytes เพื่อดึงข้อมูลส่วนผสม โภชนาการ และข้อมูลต้นทุนต่อหน่วยบริโภค เหมาะสำหรับการวางแผนมื้ออาหารและการวิเคราะห์ราคา

ตรวจพบการป้องกันบอท

- Cloudflare

- WAF และการจัดการบอทระดับองค์กร ใช้ JavaScript challenges, CAPTCHAs และการวิเคราะห์พฤติกรรม ต้องมีระบบอัตโนมัติของเบราว์เซอร์พร้อมการตั้งค่าซ่อนตัว

- การจำกัดอัตรา

- จำกัดคำขอต่อ IP/เซสชันตามเวลา สามารถหลีกเลี่ยงได้ด้วยพร็อกซีหมุนเวียน การหน่วงเวลาคำขอ และการสแกรปแบบกระจาย

- Request Throttling

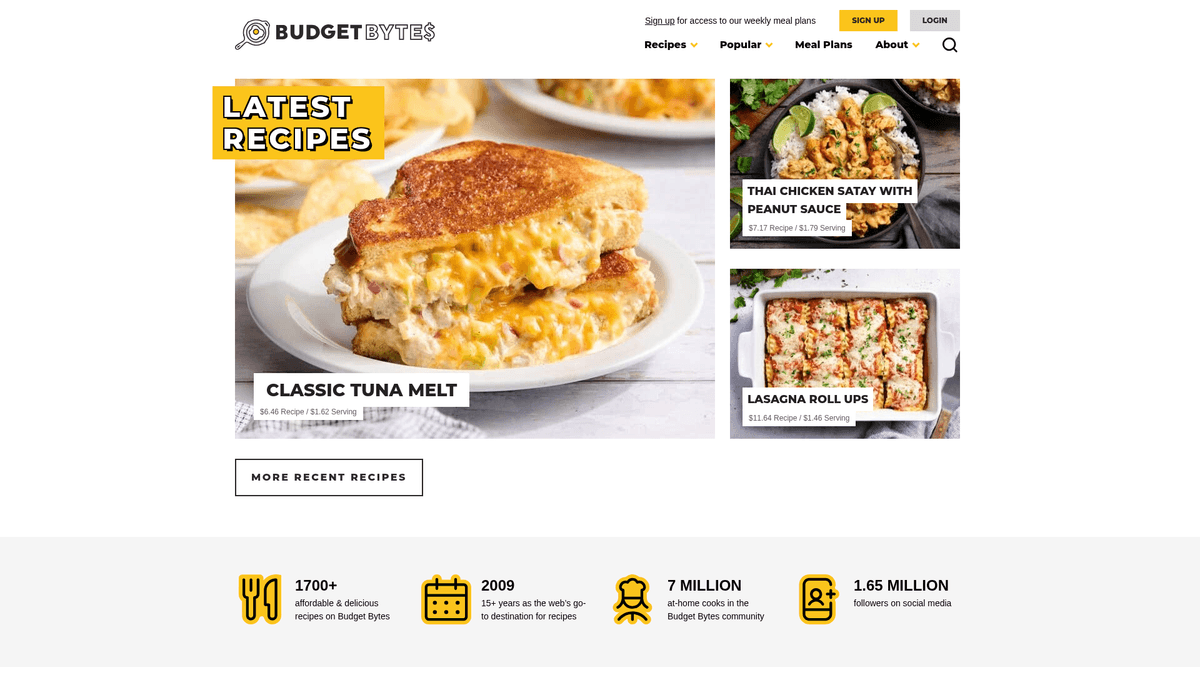

เกี่ยวกับ Budget Bytes

ค้นพบสิ่งที่ Budget Bytes นำเสนอและข้อมูลที่มีค่าที่สามารถดึงได้

ผู้เชี่ยวชาญด้านการทำอาหารแบบประหยัดงบประมาณ

Budget Bytes เป็นเว็บไซต์ทำอาหารที่ได้รับความนิยมอย่างสูง ซึ่งอุทิศตนเพื่อนำเสนอสูตรอาหารแสนอร่อยที่ออกแบบมาสำหรับผู้ที่มีงบประมาณจำกัด ก่อตั้งโดย Beth Moncel ในปี 2009 แพลตฟอร์มนี้ได้กลายเป็นแหล่งข้อมูลสำคัญสำหรับนักเรียน ครอบครัว และใครก็ตามที่ต้องการลดขยะอาหารไปพร้อมกับเพิ่มรสชาติให้สูงสุด เว็บไซต์นี้มีชื่อเสียงในด้านการแจกแจงต้นทุนอย่างละเอียด โดยคำนวณราคาส่วนผสมทุกอย่างเพื่อให้ได้ต้นทุนรวมของสูตรและต้นทุนต่อหน่วยบริโภค

ข้อมูลสูตรอาหารที่ครบถ้วน

เว็บไซต์ประกอบด้วยสูตรอาหารมากกว่า 1,700 สูตร ตั้งแต่ meal prep bowls และอาหารหม้อเดียว ไปจนถึงตัวเลือกมังสวิรัติและอาหารจากหม้อตุ๋นไฟฟ้า แต่ละรายการประกอบด้วยส่วนผสมโดยละเอียด ภาพถ่ายขั้นตอนการทำ ข้อมูลโภชนาการ และรีวิวจากผู้ใช้ วิธีการจัดโครงสร้างนี้ทำให้เว็บไซต์เป็นขุมทรัพย์ข้อมูลสำหรับผู้ที่สนใจจุดตัดระหว่างศาสตร์การทำอาหารและเศรษฐศาสตร์

ทำไมการ scraping Budget Bytes ถึงมีความสำคัญ

การ scraping ข้อมูลนี้มีค่าอย่างยิ่งด้วยเหตุผลหลายประการ ช่วยให้สามารถรวบรวมไอเดียมื้ออาหารต้นทุนต่ำ ติดตามอัตราเงินเฟ้อของอาหารผ่านการวิเคราะห์ต้นทุนส่วนผสม และสร้างชุดข้อมูลสำหรับการวิจัยด้านโภชนาการ นักพัฒนาแอปวางแผนมื้ออาหารและเครื่องมือเปรียบเทียบราคาสินค้าอุปโภคบริโภคมักใช้ข้อมูลนี้เพื่อให้ผู้ใช้ได้รับตัวเลือกที่ดีต่อสุขภาพและราคาไม่แพงตามราคาตลาดจริง

ทำไมต้อง Scrape Budget Bytes?

ค้นพบคุณค่าทางธุรกิจและกรณีการใช้งานสำหรับการดึงข้อมูลจาก Budget Bytes

ติดตามเงินเฟ้อราคาอาหารผ่านการวิเคราะห์ต้นทุนส่วนผสม

รวบรวมไอเดียมื้ออาหารราคาถูกสำหรับแอปพลิเคชันบริหารการเงินส่วนบุคคล

ทำการวิจัยด้านโภชนาการเกี่ยวกับการควบคุมอาหารในราคาประหยัด

สร้างรายการซื้อของอัตโนมัติตามเกณฑ์งบประมาณที่กำหนด

วิเคราะห์แนวโน้มสูตรอาหารและหมวดหมู่อาหารยอดนิยม

สร้างเกณฑ์มาตรฐานราคา (price benchmarks) สำหรับบริการส่งอาหาร

ความท้าทายในการ Scrape

ความท้าทายทางเทคนิคที่คุณอาจพบเมื่อ Scrape Budget Bytes

การข้ามระบบความปลอดภัยของ Cloudflare และการตรวจจับบอต

การดึงข้อมูลที่มีโครงสร้างจากบล็อก WordPress Recipe Maker (WPRM)

การจัดการกับหน่วยวัดที่ไม่สม่ำเสมอในรายการส่วนผสม

การบริหารจัดการ rate limits บน WordPress REST API endpoints

การแปลงสตริง cost-per-serving ที่เป็นไดนามิกให้เป็นค่าตัวเลข

สกัดข้อมูลจาก Budget Bytes ด้วย AI

ไม่ต้องเขียนโค้ด สกัดข้อมูลภายในไม่กี่นาทีด้วยระบบอัตโนมัติที่ขับเคลื่อนด้วย AI

วิธีการทำงาน

อธิบายสิ่งที่คุณต้องการ

บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก Budget Bytes แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

AI สกัดข้อมูล

ปัญญาประดิษฐ์ของเรานำทาง Budget Bytes จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

รับข้อมูลของคุณ

รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

ทำไมต้องใช้ AI ในการสกัดข้อมูล

AI ทำให้การสกัดข้อมูลจาก Budget Bytes เป็นเรื่องง่ายโดยไม่ต้องเขียนโค้ด แพลตฟอร์มที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ของเราเข้าใจว่าคุณต้องการข้อมูลอะไร — แค่อธิบายเป็นภาษาธรรมชาติ แล้ว AI จะสกัดให้โดยอัตโนมัติ

How to scrape with AI:

- อธิบายสิ่งที่คุณต้องการ: บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก Budget Bytes แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

- AI สกัดข้อมูล: ปัญญาประดิษฐ์ของเรานำทาง Budget Bytes จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

- รับข้อมูลของคุณ: รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

Why use AI for scraping:

- สภาพแวดล้อมแบบ no-code สำหรับการสร้างตัว scraper ที่ซับซ้อนได้ทันที

- จัดการ Cloudflare และการป้องกันบอตได้โดยอัตโนมัติ

- กำหนดตารางเวลาทำงานเพื่อดึงข้อมูลสูตรอาหารใหม่รายสัปดาห์โดยอัตโนมัติ

- ผสานการทำงานโดยตรงกับ Google Sheets เพื่อการติดตามต้นทุนแบบสด

No-code web scrapers สำหรับ Budget Bytes

ทางเลือกแบบ point-and-click สำหรับการ scraping ด้วย AI

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape Budget Bytes โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

ความท้าทายทั่วไป

เส้นโค้งการเรียนรู้

การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

Selectors เสีย

การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

ปัญหาเนื้อหาไดนามิก

เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

ข้อจำกัด CAPTCHA

เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

การบล็อก IP

การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

No-code web scrapers สำหรับ Budget Bytes

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape Budget Bytes โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

- ติดตั้งส่วนขยายเบราว์เซอร์หรือสมัครใช้งานแพลตฟอร์ม

- นำทางไปยังเว็บไซต์เป้าหมายและเปิดเครื่องมือ

- เลือกองค์ประกอบข้อมูลที่ต้องการดึงด้วยการชี้และคลิก

- กำหนดค่า CSS selectors สำหรับแต่ละฟิลด์ข้อมูล

- ตั้งค่ากฎการแบ่งหน้าเพื่อ scrape หลายหน้า

- จัดการ CAPTCHA (มักต้องแก้ไขด้วยตนเอง)

- กำหนดค่าการตั้งเวลาสำหรับการรันอัตโนมัติ

- ส่งออกข้อมูลเป็น CSV, JSON หรือเชื่อมต่อผ่าน API

ความท้าทายทั่วไป

- เส้นโค้งการเรียนรู้: การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

- Selectors เสีย: การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

- ปัญหาเนื้อหาไดนามิก: เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

- ข้อจำกัด CAPTCHA: เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

- การบล็อก IP: การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

ตัวอย่างโค้ด

import requests

from bs4 import BeautifulSoup

# URL เป้าหมาย

url = 'https://www.budgetbytes.com/creamy-mushroom-pasta/'

# headers มาตรฐานเพื่อเลียนแบบการทำงานของ browser

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# ดึงข้อมูลสูตรอาหารเบื้องต้น

data = {

'title': soup.find('h1').get_text(strip=True),

'cost_per': soup.find('span', class_='cost-per').get_text(strip=True) if soup.find('span', class_='cost-per') else 'N/A',

'ingredients': [li.get_text(strip=True) for li in soup.find_all('li', class_='wprm-recipe-ingredient')]

}

print(data)

except Exception as e:

print(f'Error: {e}')เมื่อไหร่ควรใช้

เหมาะที่สุดสำหรับหน้า HTML แบบ static ที่มี JavaScript น้อย เหมาะสำหรับบล็อก ไซต์ข่าว และหน้าสินค้า e-commerce ธรรมดา

ข้อดี

- ●ประมวลผลเร็วที่สุด (ไม่มี overhead ของเบราว์เซอร์)

- ●ใช้ทรัพยากรน้อยที่สุด

- ●ง่ายต่อการทำงานแบบขนานด้วย asyncio

- ●เหมาะมากสำหรับ API และหน้า static

ข้อจำกัด

- ●ไม่สามารถรัน JavaScript ได้

- ●ล้มเหลวใน SPA และเนื้อหาไดนามิก

- ●อาจมีปัญหากับระบบ anti-bot ที่ซับซ้อน

วิธีสเครปข้อมูล Budget Bytes ด้วยโค้ด

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL เป้าหมาย

url = 'https://www.budgetbytes.com/creamy-mushroom-pasta/'

# headers มาตรฐานเพื่อเลียนแบบการทำงานของ browser

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# ดึงข้อมูลสูตรอาหารเบื้องต้น

data = {

'title': soup.find('h1').get_text(strip=True),

'cost_per': soup.find('span', class_='cost-per').get_text(strip=True) if soup.find('span', class_='cost-per') else 'N/A',

'ingredients': [li.get_text(strip=True) for li in soup.find_all('li', class_='wprm-recipe-ingredient')]

}

print(data)

except Exception as e:

print(f'Error: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_budget_bytes():

async with async_playwright() as p:

# เปิด browser

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

# ไปที่หน้าสูตรอาหาร

await page.goto('https://www.budgetbytes.com/one-pot-creamy-mushroom-pasta/')

# รอให้ recipe container โหลดเสร็จ

await page.wait_for_selector('.wprm-recipe-container')

# ดึงข้อมูลผ่าน page.evaluate

recipe_data = await page.evaluate('''() => {

return {

title: document.querySelector('.wprm-recipe-name')?.innerText,

total_cost: document.querySelector('.wprm-recipe-cost')?.innerText,

calories: document.querySelector('.wprm-nutrition-label-text-nutrition-value-calories')?.innerText

}

}''')

print(recipe_data)

await browser.close()

asyncio.run(scrape_budget_bytes())Python + Scrapy

import scrapy

class BudgetBytesSpider(scrapy.Spider):

name = 'budget_bytes'

# การใช้ WordPress REST API เพื่อการดึงข้อมูลที่สะอาดกว่า

start_urls = ['https://www.budgetbytes.com/wp-json/wp/v2/posts?per_page=20']

def parse(self, response):

posts = response.json()

for post in posts:

yield {

'id': post.get('id'),

'title': post.get('title', {}).get('rendered'),

'url': post.get('link'),

'published_date': post.get('date'),

'slug': post.get('slug')

}

# จัดการการแบ่งหน้า (pagination) หากมีระบุใน headers

# (ละไว้เพื่อให้โค้ดกระชับ)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// ตั้งค่า user agent เพื่อหลีกเลี่ยงการถูกบล็อกเบื้องต้น

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36');

await page.goto('https://www.budgetbytes.com/one-pot-creamy-mushroom-pasta/', { waitUntil: 'networkidle2' });

const data = await page.evaluate(() => {

const title = document.querySelector('.wprm-recipe-name')?.textContent;

const costPerServing = document.querySelector('.cost-per')?.textContent;

const items = Array.from(document.querySelectorAll('.wprm-recipe-ingredient')).map(i => i.textContent.trim());

return { title, costPerServing, items };

});

console.log(data);

await browser.close();

})();คุณสามารถทำอะไรกับข้อมูล Budget Bytes

สำรวจการใช้งานจริงและข้อมูลเชิงลึกจากข้อมูล Budget Bytes

ระบบติดตามอัตราเงินเฟ้อของราคาอาหาร

ตรวจสอบการเปลี่ยนแปลงของราคาขายของชำแบบเรียลไทม์โดยการ scraping ราคาในระดับส่วนผสมจากหมวดหมู่สูตรอาหารต่างๆ

วิธีการนำไปใช้:

- 1กำหนดเวลา scraping รายสัปดาห์สำหรับฟิลด์ cost-per-serving ของ 100 สูตรอาหารยอดนิยม

- 2เปรียบเทียบค่าแบบเดือนต่อเดือนเพื่อระบุหมวดหมู่ที่มีราคาพุ่งสูงที่สุด

- 3สร้างภาพข้อมูลแสดงความสัมพันธ์ระหว่างส่วนผสมเฉพาะ (เช่น ไข่ หรือ ผลิตภัณฑ์นม) กับต้นทุนรวมของสูตรอาหาร

ใช้ Automatio เพื่อดึงข้อมูลจาก Budget Bytes และสร้างแอปพลิเคชันเหล่านี้โดยไม่ต้องเขียนโค้ด

คุณสามารถทำอะไรกับข้อมูล Budget Bytes

- ระบบติดตามอัตราเงินเฟ้อของราคาอาหาร

ตรวจสอบการเปลี่ยนแปลงของราคาขายของชำแบบเรียลไทม์โดยการ scraping ราคาในระดับส่วนผสมจากหมวดหมู่สูตรอาหารต่างๆ

- กำหนดเวลา scraping รายสัปดาห์สำหรับฟิลด์ cost-per-serving ของ 100 สูตรอาหารยอดนิยม

- เปรียบเทียบค่าแบบเดือนต่อเดือนเพื่อระบุหมวดหมู่ที่มีราคาพุ่งสูงที่สุด

- สร้างภาพข้อมูลแสดงความสัมพันธ์ระหว่างส่วนผสมเฉพาะ (เช่น ไข่ หรือ ผลิตภัณฑ์นม) กับต้นทุนรวมของสูตรอาหาร

- แอปวางแผนมื้ออาหารอัจฉริยะ

เพิ่มข้อมูลลงในฐานข้อมูลสำหรับแอปโภชนาการที่แนะนำสูตรอาหารตามงบประมาณรายวันที่เข้มงวดของผู้ใช้

- scraping ชื่อสูตรอาหาร, cost-per-serving และแท็กอาหาร (Vegan, GF)

- กรองสูตรอาหารที่มีต้นทุนต่ำกว่า $2 ต่อมื้อ

- ส่งออกข้อมูลไปยัง API สำหรับใช้งานบนแอปพลิเคชันมือถือ

- เครื่องมือเพิ่มประสิทธิภาพ Macro-to-Cost

ค้นหาสูตรอาหาร 'โปรตีนต่อดอลลาร์' ที่ดีที่สุดเพื่อช่วยเหลือนักกีฬาหรือผู้รักสุขภาพที่มีงบจำกัด

- ดึงทั้งข้อมูลโภชนาการ (กรัมของโปรตีน) และข้อมูลต้นทุนสูตรอาหาร

- คำนวณอัตราส่วนโปรตีนต่อต้นทุน (Protein/Cost) สำหรับทุกรายการ

- จัดอันดับสูตรอาหารเพื่อค้นหามื้ออาหารประหยัดที่ให้โปรตีนสูงและคุ้มค่าที่สุด

- ระบบแนะนำการจัดการวัตถุดิบ

ช่วยผู้ใช้ลดขยะอาหารโดยการระบุสูตรอาหารจากวัตถุดิบที่มีอยู่ในตู้กับข้าวที่ดึงมาจากเว็บไซต์

- scraping และทำให้รายการส่วนผสมเป็นมาตรฐานในฐานข้อมูลที่ค้นหาได้

- อนุญาตให้ผู้ใช้ป้อนส่วนผสมที่พวกเขามีอยู่

- จับคู่ข้อมูลที่ผู้ใช้ป้อนกับข้อมูลที่ scrape มาเพื่อแนะนำมื้ออาหารถัดไปที่มีต้นทุนต่ำที่สุด

เพิ่มพลังให้เวิร์กโฟลว์ของคุณด้วย ระบบอัตโนมัติ AI

Automatio รวมพลังของ AI agents การอัตโนมัติเว็บ และการผสานรวมอัจฉริยะเพื่อช่วยให้คุณทำงานได้มากขึ้นในเวลาน้อยลง

เคล็ดลับมืออาชีพสำหรับการ Scrape Budget Bytes

คำแนะนำจากผู้เชี่ยวชาญสำหรับการดึงข้อมูลจาก Budget Bytes อย่างประสบความสำเร็จ

เข้าถึง WordPress REST API ที่ /wp-json/wp/v2/posts เพื่อรับข้อมูล JSON ที่มีโครงสร้างและรวดเร็วโดยไม่ต้องทำการ parsing HTML

มองหาแท็กสคริปต์ 'ld+json' ในส่วน head เพื่อดึงข้อมูล metadata ของสูตรอาหารจาก Schema.org รวมถึงเวลาเตรียมและข้อมูลโภชนาการ

ใช้ residential proxies เพื่อหลีกเลี่ยงข้อผิดพลาด 403 Forbidden ที่เกิดจากระบบความปลอดภัยของ Cloudflare ระหว่างการ scraping ข้อมูลจำนวนมาก

ตั้งค่าดีเลย์ 3-5 วินาทีระหว่างการส่ง request เพื่อเป็นการให้เกียรติเซิร์ฟเวอร์และหลีกเลี่ยงการถูกทำ IP blacklisting ชั่วคราว

ตรวจสอบ CSS classes ของ 'WPRM' (WordPress Recipe Maker) เพื่อให้ได้ selector ที่สม่ำเสมอในรูปแบบสูตรอาหารต่างๆ

บันทึกรูปภาพที่ได้จากการ scraping ไว้ในเครื่องหรือผ่านลิงก์ CDN เพื่อป้องกันการเกิดรูปภาพเสีย (broken image) ในข้อมูลที่ส่งออก

คำรับรอง

ผู้ใช้ของเราพูดอย่างไร

เข้าร่วมกับผู้ใช้ที่พึงพอใจนับพันที่ได้เปลี่ยนแปลงเวิร์กโฟลว์ของพวกเขา

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ที่เกี่ยวข้อง Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

คำถามที่พบบ่อยเกี่ยวกับ Budget Bytes

ค้นหาคำตอบสำหรับคำถามทั่วไปเกี่ยวกับ Budget Bytes