วิธี scrape BureauxLocaux: คู่มือข้อมูลอสังหาริมทรัพย์เพื่อการพาณิชย์

ดึงข้อมูลอสังหาริมทรัพย์เชิงพาณิชย์จาก BureauxLocaux scrape ราคาสำนักงาน ตำแหน่งคลังสินค้า และรายละเอียดตัวแทนทั่วฝรั่งเศสเพื่อการวิจัยตลาด

ตรวจพบการป้องกันบอท

- Cloudflare

- WAF และการจัดการบอทระดับองค์กร ใช้ JavaScript challenges, CAPTCHAs และการวิเคราะห์พฤติกรรม ต้องมีระบบอัตโนมัติของเบราว์เซอร์พร้อมการตั้งค่าซ่อนตัว

- CSRF Protection

- การจำกัดอัตรา

- จำกัดคำขอต่อ IP/เซสชันตามเวลา สามารถหลีกเลี่ยงได้ด้วยพร็อกซีหมุนเวียน การหน่วงเวลาคำขอ และการสแกรปแบบกระจาย

- User-Agent Filtering

- JavaScript Challenge

- ต้องมีการเรียกใช้ JavaScript เพื่อเข้าถึงเนื้อหา คำขอแบบง่ายจะล้มเหลว ต้องใช้เบราว์เซอร์ headless เช่น Playwright หรือ Puppeteer

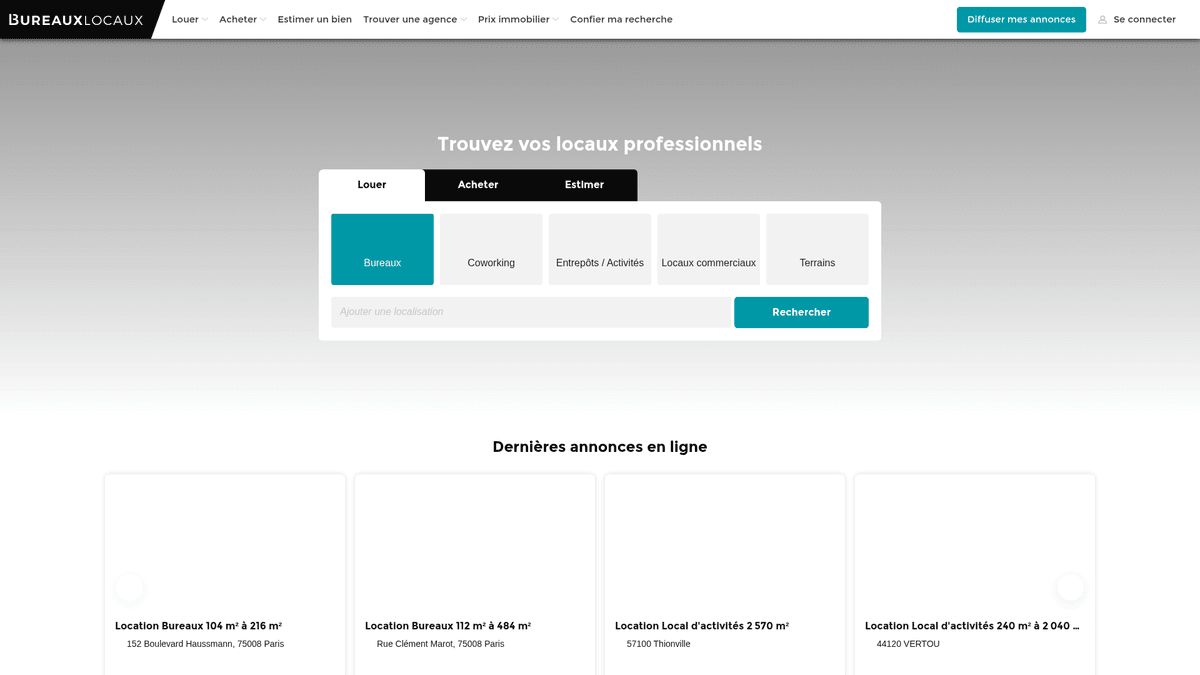

เกี่ยวกับ BureauxLocaux

ค้นพบสิ่งที่ BureauxLocaux นำเสนอและข้อมูลที่มีค่าที่สามารถดึงได้

ตลาดอสังหาริมทรัพย์ระดับมืออาชีพของฝรั่งเศส

BureauxLocaux เป็นแพลตฟอร์มดิจิทัลชั้นนำในฝรั่งเศสที่อุทิศให้กับอสังหาริมทรัพย์ระดับมืออาชีพ โดยอำนวยความสะดวกในการเช่าและขายสำนักงาน คลังสินค้า พื้นที่ค้าปลีก และ coworking hubs แพลตฟอร์มนี้เป็นของ CoStar Group ซึ่งรวบรวมข้อมูลจากหน่วยงานเฉพาะทางกว่า 1,800 แห่ง และมีรายการประกาศที่ใช้งานอยู่มากกว่า 72,000 รายการ ทำให้เป็นแหล่งข้อมูลที่ชัดเจนสำหรับข้อมูลเชิงลึกด้านอสังหาริมทรัพย์แบบ B2B

ข้อมูลเชิงลึกด้านการตลาดที่ครอบคลุม

แพลตฟอร์มนี้ให้มุมมองที่ละเอียดเกี่ยวกับภูมิทัศน์เชิงพาณิชย์ของฝรั่งเศส ตั้งแต่ย่านธุรกิจในปารีสที่มีความต้องการสูงไปจนถึงศูนย์กลางโลจิสติกส์ในลียงและมาร์เซย์ ทำหน้าที่เป็นสะพานเชื่อมสำคัญระหว่างผู้ค้นหาอสังหาริมทรัพย์และนายหน้าเฉพาะทาง โดยให้ข้อมูลจำเพาะทางเทคนิคโดยละเอียดที่นอกเหนือไปจากจุดราคาเพียงอย่างเดียว

ทำไมข้อมูลนี้จึงสำคัญ

การ scrape BureauxLocaux เป็นสิ่งจำเป็นสำหรับนักพัฒนาอสังหาริมทรัพย์ นักลงทุน และนักผังเมือง รายการของแพลตฟอร์มให้ข้อมูลแบบเรียลไทม์เกี่ยวกับแนวโน้มราคาเช่า อัตราว่าง และระดับประสิทธิภาพพลังงาน (DPE) ซึ่งสำคัญมากสำหรับการสร้าง predictive market models และการระบุโอกาสการลงทุนที่ให้ผลตอบแทนสูง

ทำไมต้อง Scrape BureauxLocaux?

ค้นพบคุณค่าทางธุรกิจและกรณีการใช้งานสำหรับการดึงข้อมูลจาก BureauxLocaux

ติดตามความผันผวนของราคาเช่าเชิงพาณิชย์ทั่วเมืองใหญ่ในฝรั่งเศส

เปรียบเทียบพอร์ตโฟลิโอและส่วนแบ่งการตลาดของตัวแทนอสังหาริมทรัพย์เฉพาะทาง

ระบุลีดที่มีศักยภาพสูงสำหรับบริการปรับปรุงและตกแต่งสำนักงาน

ติดตามอัตราการว่างของคลังสินค้าอุตสาหกรรมเพื่อการวางแผนโลจิสติกส์

วิเคราะห์การเติบโตของพื้นที่ coworking เทียบกับการเช่าสำนักงานแบบดั้งเดิม

รวบรวมข้อมูลการฝึกสอนสำหรับ model AI ในการประเมินราคาอสังหาริมทรัพย์

ความท้าทายในการ Scrape

ความท้าทายทางเทคนิคที่คุณอาจพบเมื่อ Scrape BureauxLocaux

การข้ามระบบการจัดการ bot ของ Cloudflare และการท้าทายด้วย JavaScript

การดึงเนื้อหาแบบ dynamic ที่โหลดผ่านคำขอ AJAX ภายใน

การจัดการ CSRF tokens ที่จำเป็นสำหรับการเข้าถึงข้อมูลการติดต่อของตัวแทนโดยละเอียด

การจัดระเบียบรูปแบบข้อมูลราคาที่กระจัดกระจาย (ตร.ม./ปี เทียบกับ ต้นทุนต่อที่นั่งรายเดือน)

การปรับตัวให้เข้ากับการเปลี่ยนแปลงโครงสร้างบ่อยครั้งในตารางคุณสมบัติของอสังหาริมทรัพย์

สกัดข้อมูลจาก BureauxLocaux ด้วย AI

ไม่ต้องเขียนโค้ด สกัดข้อมูลภายในไม่กี่นาทีด้วยระบบอัตโนมัติที่ขับเคลื่อนด้วย AI

วิธีการทำงาน

อธิบายสิ่งที่คุณต้องการ

บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก BureauxLocaux แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

AI สกัดข้อมูล

ปัญญาประดิษฐ์ของเรานำทาง BureauxLocaux จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

รับข้อมูลของคุณ

รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

ทำไมต้องใช้ AI ในการสกัดข้อมูล

AI ทำให้การสกัดข้อมูลจาก BureauxLocaux เป็นเรื่องง่ายโดยไม่ต้องเขียนโค้ด แพลตฟอร์มที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ของเราเข้าใจว่าคุณต้องการข้อมูลอะไร — แค่อธิบายเป็นภาษาธรรมชาติ แล้ว AI จะสกัดให้โดยอัตโนมัติ

How to scrape with AI:

- อธิบายสิ่งที่คุณต้องการ: บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก BureauxLocaux แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

- AI สกัดข้อมูล: ปัญญาประดิษฐ์ของเรานำทาง BureauxLocaux จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

- รับข้อมูลของคุณ: รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

Why use AI for scraping:

- ข้ามระบบความปลอดภัยของ Cloudflare ได้อย่างไร้รอยต่อโดยไม่ต้องเขียนโค้ดเอง

- จัดการการเรนเดอร์ JavaScript โดยอัตโนมัติสำหรับรายการประกาศแบบ dynamic

- การตั้งเวลาทำงานช่วยให้ตรวจสอบตลาดและแจ้งเตือนรายวันได้โดยอัตโนมัติ

- ใช้ premium residential proxies เพื่อหลีกเลี่ยงการจำกัดอัตราการส่งข้อมูลตาม IP

- Visual selector ช่วยให้เลือกเป้าหมายข้อมูลจำเพาะทางเทคนิคของอสังหาริมทรัพย์ที่ซับซ้อนได้ง่าย

No-code web scrapers สำหรับ BureauxLocaux

ทางเลือกแบบ point-and-click สำหรับการ scraping ด้วย AI

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape BureauxLocaux โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

ความท้าทายทั่วไป

เส้นโค้งการเรียนรู้

การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

Selectors เสีย

การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

ปัญหาเนื้อหาไดนามิก

เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

ข้อจำกัด CAPTCHA

เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

การบล็อก IP

การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

No-code web scrapers สำหรับ BureauxLocaux

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape BureauxLocaux โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

- ติดตั้งส่วนขยายเบราว์เซอร์หรือสมัครใช้งานแพลตฟอร์ม

- นำทางไปยังเว็บไซต์เป้าหมายและเปิดเครื่องมือ

- เลือกองค์ประกอบข้อมูลที่ต้องการดึงด้วยการชี้และคลิก

- กำหนดค่า CSS selectors สำหรับแต่ละฟิลด์ข้อมูล

- ตั้งค่ากฎการแบ่งหน้าเพื่อ scrape หลายหน้า

- จัดการ CAPTCHA (มักต้องแก้ไขด้วยตนเอง)

- กำหนดค่าการตั้งเวลาสำหรับการรันอัตโนมัติ

- ส่งออกข้อมูลเป็น CSV, JSON หรือเชื่อมต่อผ่าน API

ความท้าทายทั่วไป

- เส้นโค้งการเรียนรู้: การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

- Selectors เสีย: การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

- ปัญหาเนื้อหาไดนามิก: เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

- ข้อจำกัด CAPTCHA: เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

- การบล็อก IP: การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

ตัวอย่างโค้ด

import requests

from bs4 import BeautifulSoup

# หมายเหตุ: อาจถูกบล็อกโดย Cloudflare หากไม่มี headers/proxies ขั้นสูง

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# ตัวอย่าง: การเลือกบัตรรายการประกาศ

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'Scraping failed: {e}')เมื่อไหร่ควรใช้

เหมาะที่สุดสำหรับหน้า HTML แบบ static ที่มี JavaScript น้อย เหมาะสำหรับบล็อก ไซต์ข่าว และหน้าสินค้า e-commerce ธรรมดา

ข้อดี

- ●ประมวลผลเร็วที่สุด (ไม่มี overhead ของเบราว์เซอร์)

- ●ใช้ทรัพยากรน้อยที่สุด

- ●ง่ายต่อการทำงานแบบขนานด้วย asyncio

- ●เหมาะมากสำหรับ API และหน้า static

ข้อจำกัด

- ●ไม่สามารถรัน JavaScript ได้

- ●ล้มเหลวใน SPA และเนื้อหาไดนามิก

- ●อาจมีปัญหากับระบบ anti-bot ที่ซับซ้อน

วิธีสเครปข้อมูล BureauxLocaux ด้วยโค้ด

Python + Requests

import requests

from bs4 import BeautifulSoup

# หมายเหตุ: อาจถูกบล็อกโดย Cloudflare หากไม่มี headers/proxies ขั้นสูง

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# ตัวอย่าง: การเลือกบัตรรายการประกาศ

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# แนะนำให้เปิดใช้งานด้วย stealth mode หรือกำหนด UA เฉพาะ

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# ไปที่หน้าผลลัพธ์การค้นหา

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# รอให้รายการประกาศเรนเดอร์เสร็จ

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Contact agent"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# วนลูปผ่านบัตรประกาศอสังหาริมทรัพย์แต่ละใบในหน้าเว็บ

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# การจัดการหน้าถัดไป: หาลิงก์ 'Next'

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// ตั้งค่า User-Agent ที่ดูสมจริง

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// ดึงข้อมูลจากองค์ประกอบของรายการประกาศ

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();คุณสามารถทำอะไรกับข้อมูล BureauxLocaux

สำรวจการใช้งานจริงและข้อมูลเชิงลึกจากข้อมูล BureauxLocaux

การทำดัชนีค่าเช่าเชิงพาณิชย์

นักวิเคราะห์การเงินสามารถสร้างดัชนีต้นทุนการเช่าสำนักงานแบบไดนามิกเพื่อแนะนำลูกค้าองค์กรเกี่ยวกับกลยุทธ์ด้านสถานที่ตั้ง

วิธีการนำไปใช้:

- 1scrape รายการสำนักงานที่เปิดประกาศอยู่ทั้งหมดในเมืองใหญ่ของฝรั่งเศสทุกสัปดาห์

- 2คำนวณราคาต่อตารางเมตรต่อปีสำหรับแต่ละรายการ

- 3จัดกลุ่มข้อมูลตามเขต (Arrondissement) เพื่อระบุกลุ่มราคา

- 4แสดงผล 'Price Heatmap' โดยใช้เครื่องมือสร้างแผนที่เช่น Tableau

ใช้ Automatio เพื่อดึงข้อมูลจาก BureauxLocaux และสร้างแอปพลิเคชันเหล่านี้โดยไม่ต้องเขียนโค้ด

คุณสามารถทำอะไรกับข้อมูล BureauxLocaux

- การทำดัชนีค่าเช่าเชิงพาณิชย์

นักวิเคราะห์การเงินสามารถสร้างดัชนีต้นทุนการเช่าสำนักงานแบบไดนามิกเพื่อแนะนำลูกค้าองค์กรเกี่ยวกับกลยุทธ์ด้านสถานที่ตั้ง

- scrape รายการสำนักงานที่เปิดประกาศอยู่ทั้งหมดในเมืองใหญ่ของฝรั่งเศสทุกสัปดาห์

- คำนวณราคาต่อตารางเมตรต่อปีสำหรับแต่ละรายการ

- จัดกลุ่มข้อมูลตามเขต (Arrondissement) เพื่อระบุกลุ่มราคา

- แสดงผล 'Price Heatmap' โดยใช้เครื่องมือสร้างแผนที่เช่น Tableau

- การหาลีดธุรกิจอสังหาริมทรัพย์

ผู้ให้บริการ B2B สามารถค้นหาบริษัทที่กำลังย้ายเข้าสู่พื้นที่ใหม่ซึ่งต้องการการตั้งค่า IT เฟอร์นิเจอร์ หรือประกันภัย

- กำหนดเป้าหมายรายการที่ระบุว่า 'ว่างล่าสุด' หรือ 'ใหม่ในตลาด'

- ดึงรายละเอียดการติดต่อของหน่วยงานที่ลงประกาศเพื่อการติดต่อสร้างพันธมิตร

- ติดตามการนำรายการออกจากระบบเพื่อประมาณการว่าบริษัทเซ็นสัญญาเช่าเมื่อใด

- สร้างรายการ CRM อัตโนมัติสำหรับโครงการปรับปรุงสำนักงานที่มีศักยภาพรายใหม่

- การติดตามระยะเวลาการว่างของพื้นที่

นักวิจัยเศรษฐกิจสามารถตรวจสอบระยะเวลาที่อสังหาริมทรัพย์อุตสาหกรรมค้างอยู่ในตลาดเพื่อประเมินสุขภาพเศรษฐกิจในท้องถิ่น

- scrape รายการคลังสินค้าทั้งหมดและจัดเก็บวันที่ 'พบครั้งแรก'

- ตรวจสอบอย่างต่อเนื่องว่ารายการใดที่ยังคงใช้งานอยู่เทียบกับรายการที่ถูกนำออก

- คำนวณค่าเฉลี่ย 'ระยะเวลาอยู่ในตลาด' (Time on Market - ToM) สำหรับแต่ละเขตอุตสาหกรรม

- เชื่อมโยง ToM ที่สูงกับภาวะเศรษฐกิจถดถอยในระดับภูมิภาคที่เฉพาะเจาะจง

- ระบบกรองการลงทุนอัตโนมัติ

นักลงทุนสามารถรับการแจ้งเตือนทันทีเมื่ออสังหาริมทรัพย์มีราคาลดลงต่ำกว่าเกณฑ์ที่กำหนดในพื้นที่เฉพาะ

- ตั้งค่าการ scrape รายวันสำหรับหมวดหมู่เฉพาะเช่น 'Vente de Bureaux' (ขายสำนักงาน)

- เปรียบเทียบราคาเสนอขายรายวันกับค่าเฉลี่ยย้อนหลังสำหรับรหัสไปรษณีย์นั้นๆ

- ตั้งค่าการแจ้งเตือนหากรายการใดมีราคาต่ำกว่าค่าเฉลี่ยของตลาด 15%

- ส่งออกดีลที่ผ่านการกรองแล้วไปยัง Google Sheet เพื่อการตรวจสอบทันที

เพิ่มพลังให้เวิร์กโฟลว์ของคุณด้วย ระบบอัตโนมัติ AI

Automatio รวมพลังของ AI agents การอัตโนมัติเว็บ และการผสานรวมอัจฉริยะเพื่อช่วยให้คุณทำงานได้มากขึ้นในเวลาน้อยลง

เคล็ดลับมืออาชีพสำหรับการ Scrape BureauxLocaux

คำแนะนำจากผู้เชี่ยวชาญสำหรับการดึงข้อมูลจาก BureauxLocaux อย่างประสบความสำเร็จ

ใช้ residential proxies คุณภาพสูงจากฝรั่งเศสโดยเฉพาะเพื่อหลีกเลี่ยงการบล็อกตามภูมิภาค

ตรวจสอบ 'HT' (Hors Taxes - ไม่รวมภาษี) และ 'HC' (Hors Charges - ไม่รวมค่าธรรมเนียม) ใน price parsers เสมอเพื่อป้องกันข้อมูลคลาดเคลื่อน

ตรวจสอบแท็บ 'Network' เพื่อหา internal JSON endpoints ที่ใช้สำหรับการโหลดข้อมูลแบบ dynamic

หมุนเวียน User-Agents และ browser fingerprints เพื่อป้องกันการตรวจจับโดยการวิเคราะห์พฤติกรรมของ Cloudflare

กำหนดช่วงเวลาหยุดพักแบบสุ่ม (3-10 วินาที) ระหว่างการโหลดหน้าเว็บเพื่อเลียนแบบพฤติกรรมมนุษย์

จัดเก็บ Listing Reference ID เป็นคีย์เฉพาะเพื่อติดตามการเปลี่ยนแปลงราคาเมื่อเวลาผ่านไปโดยไม่บันทึกข้อมูลซ้ำ

คำรับรอง

ผู้ใช้ของเราพูดอย่างไร

เข้าร่วมกับผู้ใช้ที่พึงพอใจนับพันที่ได้เปลี่ยนแปลงเวิร์กโฟลว์ของพวกเขา

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ที่เกี่ยวข้อง Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

คำถามที่พบบ่อยเกี่ยวกับ BureauxLocaux

ค้นหาคำตอบสำหรับคำถามทั่วไปเกี่ยวกับ BureauxLocaux