วิธีดึงข้อมูล (Scrape) SeLoger Bureaux & Commerces

เรียนรู้วิธีดึงข้อมูล (Scrape) SeLoger Bureaux & Commerces สำหรับข้อมูลอสังหาริมทรัพย์เพื่อการพาณิชย์ ดึงราคา พื้นที่ และข้อมูลเอเจนซี่...

ตรวจพบการป้องกันบอท

- DataDome

- การตรวจจับบอทแบบเรียลไทม์ด้วยโมเดล ML วิเคราะห์ลายนิ้วมืออุปกรณ์ สัญญาณเครือข่าย และรูปแบบพฤติกรรม พบบ่อยในเว็บไซต์อีคอมเมิร์ซ

- Cloudflare

- WAF และการจัดการบอทระดับองค์กร ใช้ JavaScript challenges, CAPTCHAs และการวิเคราะห์พฤติกรรม ต้องมีระบบอัตโนมัติของเบราว์เซอร์พร้อมการตั้งค่าซ่อนตัว

- Google reCAPTCHA

- ระบบ CAPTCHA ของ Google v2 ต้องมีการโต้ตอบของผู้ใช้ v3 ทำงานเงียบๆ ด้วยคะแนนความเสี่ยง สามารถแก้ได้ด้วยบริการ CAPTCHA

- การจำกัดอัตรา

- จำกัดคำขอต่อ IP/เซสชันตามเวลา สามารถหลีกเลี่ยงได้ด้วยพร็อกซีหมุนเวียน การหน่วงเวลาคำขอ และการสแกรปแบบกระจาย

- การบล็อก IP

- บล็อก IP ของศูนย์ข้อมูลที่รู้จักและที่อยู่ที่ถูกทำเครื่องหมาย ต้องใช้พร็อกซีที่อยู่อาศัยหรือมือถือเพื่อหลีกเลี่ยงอย่างมีประสิทธิภาพ

- ลายนิ้วมือเบราว์เซอร์

- ระบุบอทผ่านลักษณะเฉพาะของเบราว์เซอร์: canvas, WebGL, ฟอนต์, ปลั๊กอิน ต้องมีการปลอมแปลงหรือโปรไฟล์เบราว์เซอร์จริง

เกี่ยวกับ SeLoger Bureaux & Commerces

ค้นพบสิ่งที่ SeLoger Bureaux & Commerces นำเสนอและข้อมูลที่มีค่าที่สามารถดึงได้

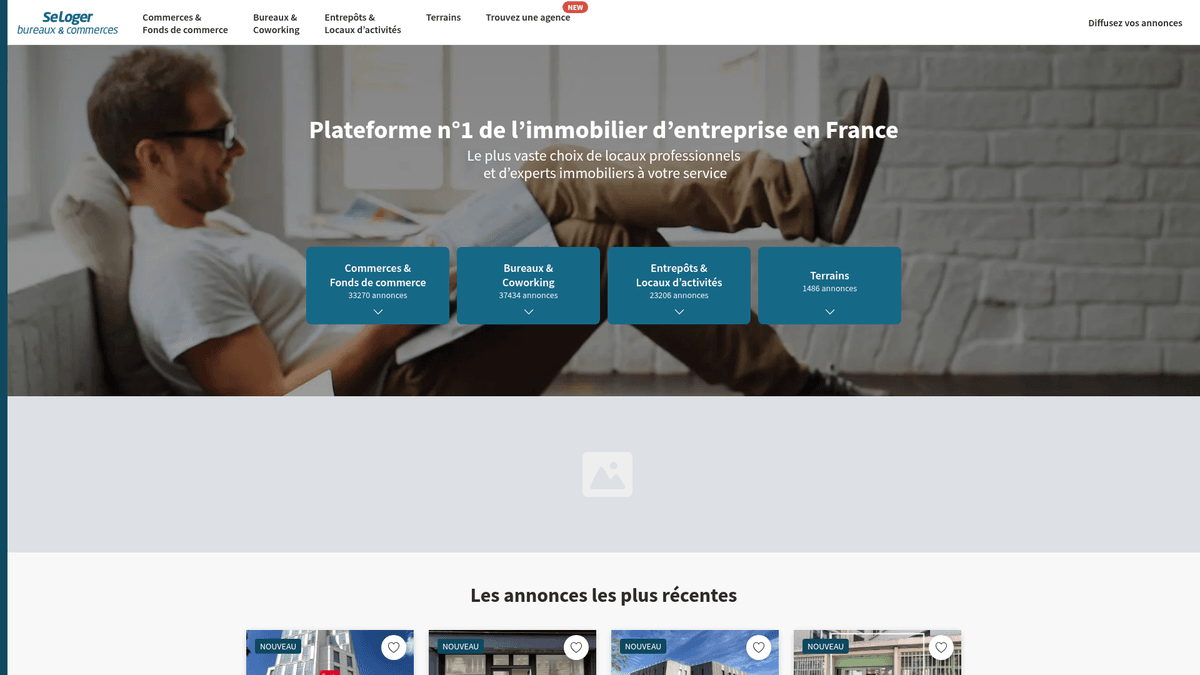

ผู้นำด้านอสังหาริมทรัพย์เพื่อการพาณิชย์ในฝรั่งเศส

SeLoger Bureaux & Commerces เป็นพอร์ทัลอสังหาริมทรัพย์ระดับมืออาชีพเฉพาะทางของ SeLoger Group ซึ่งเป็นเครือข่ายอสังหาริมทรัพย์ชั้นนำในฝรั่งเศส ทำหน้าที่เป็นตลาดกลางสำหรับการทำธุรกรรมแบบ business-to-business โดยเฉพาะ ซึ่งรวมถึงพื้นที่สำนักงาน คลังสินค้า หน้าร้านค้าปลีก และที่ดินเพื่อการพัฒนาเชิงพาณิชย์ แพลตฟอร์มนี้ถูกใช้งานโดยเอเจนซี่ระดับชาติรายใหญ่และนายหน้าอิสระเพื่อเชื่อมต่อกับนักลงทุนมืออาชีพและเจ้าของธุรกิจทั่วประเทศ

มูลค่าของข้อมูล

การดึงข้อมูล (Scraping) เว็บไซต์นี้มีค่าอย่างยิ่งสำหรับนักลงทุนอสังหาริมทรัพย์และนักวิเคราะห์ตลาดที่ต้องการติดตาม ภาพรวมอสังหาริมทรัพย์เพื่อการพาณิชย์ในฝรั่งเศส การดึงข้อมูลประกาศปัจจุบันช่วยให้ธุรกิจสามารถติดตามแนวโน้มราคาต่อตารางเมตร ระบุศูนย์กลางการค้าที่กำลังเติบโต และตรวจสอบพอร์ตโฟลิโอของเอเจนซี่คู่แข่ง ข้อมูลนี้จำเป็นอย่างยิ่งสำหรับการประเมินมูลค่าทรัพย์สินที่แม่นยำและค้นหาโอกาสในการลงทุนที่ให้ผลตอบแทนสูงในตลาดฝรั่งเศส

ทำไมต้อง Scrape SeLoger Bureaux & Commerces?

ค้นพบคุณค่าทางธุรกิจและกรณีการใช้งานสำหรับการดึงข้อมูลจาก SeLoger Bureaux & Commerces

ดำเนินการวิจัยตลาดอสังหาริมทรัพย์ในฝรั่งเศสและวิเคราะห์แนวโน้มเชิงพาณิชย์

ตรวจสอบราคาโดยอัตโนมัติสำหรับทรัพย์สินเพื่อการลงทุนในจังหวัดต่างๆ

สร้าง leads สำหรับผู้ให้บริการ B2B เช่น บริษัทขนย้ายสำนักงานหรือซัพพลายเออร์เฟอร์นิเจอร์

รวบรวมข้อมูลเชิงลึกของคู่แข่งเกี่ยวกับความครอบคลุมของพอร์ทัลอสังหาริมทรัพย์และพอร์ตโฟลิโอของเอเจนซี่

รวบรวมข้อมูลย้อนหลังสำหรับการสร้างโมเดลการประเมินมูลค่าทรัพย์สินแบบอัตโนมัติ

ติดตามโอกาสการค้าปลีกใหม่ๆ สำหรับการวางแผนขยายธุรกิจ

ความท้าทายในการ Scrape

ความท้าทายทางเทคนิคที่คุณอาจพบเมื่อ Scrape SeLoger Bureaux & Commerces

การป้องกันของ DataDome ที่เข้มงวดซึ่งตรวจจับและบล็อก headless browser มาตรฐาน

ความเสี่ยงทางกฎหมายที่สำคัญที่เกี่ยวข้องกับการนำข้อมูลเชิงพาณิชย์ไปใช้ซ้ำตามบรรทัดฐานในอดีต

ความต้องการเทคนิคการปลอมแปลง TLS และ JA3 fingerprint ที่ซับซ้อน

การเปลี่ยนแปลงโครงสร้าง DOM ของหน้าเว็บ (front-end) บ่อยครั้งซึ่งทำให้ CSS selectors แบบคงที่ใช้งานไม่ได้

การจำกัดอัตราคำขอ (rate limiting) ที่เข้มงวดและการทำ IP blacklisting อัตโนมัติสำหรับคำขอความถี่สูง

สกัดข้อมูลจาก SeLoger Bureaux & Commerces ด้วย AI

ไม่ต้องเขียนโค้ด สกัดข้อมูลภายในไม่กี่นาทีด้วยระบบอัตโนมัติที่ขับเคลื่อนด้วย AI

วิธีการทำงาน

อธิบายสิ่งที่คุณต้องการ

บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก SeLoger Bureaux & Commerces แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

AI สกัดข้อมูล

ปัญญาประดิษฐ์ของเรานำทาง SeLoger Bureaux & Commerces จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

รับข้อมูลของคุณ

รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

ทำไมต้องใช้ AI ในการสกัดข้อมูล

AI ทำให้การสกัดข้อมูลจาก SeLoger Bureaux & Commerces เป็นเรื่องง่ายโดยไม่ต้องเขียนโค้ด แพลตฟอร์มที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ของเราเข้าใจว่าคุณต้องการข้อมูลอะไร — แค่อธิบายเป็นภาษาธรรมชาติ แล้ว AI จะสกัดให้โดยอัตโนมัติ

How to scrape with AI:

- อธิบายสิ่งที่คุณต้องการ: บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก SeLoger Bureaux & Commerces แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

- AI สกัดข้อมูล: ปัญญาประดิษฐ์ของเรานำทาง SeLoger Bureaux & Commerces จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

- รับข้อมูลของคุณ: รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

Why use AI for scraping:

- จัดการระบบ anti-bot ที่ซับซ้อนอย่าง DataDome และ Cloudflare ได้โดยอัตโนมัติ

- ไม่ต้องเขียนโค้ดเพื่อตั้งค่ากระบวนการดึงข้อมูลทรัพย์สินในทุกหมวดหมู่

- รันบนคลาวด์พร้อมระบบกำหนดเวลาขั้นสูงเพื่อติดตามประกาศใหม่รายวัน

- ข้ามความท้าทายในการเรนเดอร์ JavaScript โดยไม่ต้องตั้งค่าเบราว์เซอร์ด้วยตนเอง

- ส่งออกข้อมูลที่มีโครงสร้างไปยัง Google Sheets, CSV หรือ Webhooks ได้โดยตรง

No-code web scrapers สำหรับ SeLoger Bureaux & Commerces

ทางเลือกแบบ point-and-click สำหรับการ scraping ด้วย AI

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape SeLoger Bureaux & Commerces โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

ความท้าทายทั่วไป

เส้นโค้งการเรียนรู้

การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

Selectors เสีย

การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

ปัญหาเนื้อหาไดนามิก

เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

ข้อจำกัด CAPTCHA

เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

การบล็อก IP

การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

No-code web scrapers สำหรับ SeLoger Bureaux & Commerces

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape SeLoger Bureaux & Commerces โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

- ติดตั้งส่วนขยายเบราว์เซอร์หรือสมัครใช้งานแพลตฟอร์ม

- นำทางไปยังเว็บไซต์เป้าหมายและเปิดเครื่องมือ

- เลือกองค์ประกอบข้อมูลที่ต้องการดึงด้วยการชี้และคลิก

- กำหนดค่า CSS selectors สำหรับแต่ละฟิลด์ข้อมูล

- ตั้งค่ากฎการแบ่งหน้าเพื่อ scrape หลายหน้า

- จัดการ CAPTCHA (มักต้องแก้ไขด้วยตนเอง)

- กำหนดค่าการตั้งเวลาสำหรับการรันอัตโนมัติ

- ส่งออกข้อมูลเป็น CSV, JSON หรือเชื่อมต่อผ่าน API

ความท้าทายทั่วไป

- เส้นโค้งการเรียนรู้: การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

- Selectors เสีย: การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

- ปัญหาเนื้อหาไดนามิก: เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

- ข้อจำกัด CAPTCHA: เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

- การบล็อก IP: การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

ตัวอย่างโค้ด

import requests

from bs4 import BeautifulSoup

# หมายเหตุ: SeLoger ใช้ DataDome; requests มาตรฐานมักจะถูกบล็อก

# แนะนำให้ใช้ไลบรารีเฉพาะทางอย่าง curl_cffi สำหรับ TLS fingerprinting

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# ใช้ impersonate เพื่อข้ามการบล็อกด้วย TLS fingerprinting

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# ตัวอย่าง selector สำหรับชื่อประกาศ

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Listing: {title.get_text(strip=True)}')

else:

print(f'Blocked by Anti-Bot. Status Code: {response.status_code}')

except Exception as e:

print(f'Error encountered: {e}')เมื่อไหร่ควรใช้

เหมาะที่สุดสำหรับหน้า HTML แบบ static ที่มี JavaScript น้อย เหมาะสำหรับบล็อก ไซต์ข่าว และหน้าสินค้า e-commerce ธรรมดา

ข้อดี

- ●ประมวลผลเร็วที่สุด (ไม่มี overhead ของเบราว์เซอร์)

- ●ใช้ทรัพยากรน้อยที่สุด

- ●ง่ายต่อการทำงานแบบขนานด้วย asyncio

- ●เหมาะมากสำหรับ API และหน้า static

ข้อจำกัด

- ●ไม่สามารถรัน JavaScript ได้

- ●ล้มเหลวใน SPA และเนื้อหาไดนามิก

- ●อาจมีปัญหากับระบบ anti-bot ที่ซับซ้อน

วิธีสเครปข้อมูล SeLoger Bureaux & Commerces ด้วยโค้ด

Python + Requests

import requests

from bs4 import BeautifulSoup

# หมายเหตุ: SeLoger ใช้ DataDome; requests มาตรฐานมักจะถูกบล็อก

# แนะนำให้ใช้ไลบรารีเฉพาะทางอย่าง curl_cffi สำหรับ TLS fingerprinting

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# ใช้ impersonate เพื่อข้ามการบล็อกด้วย TLS fingerprinting

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# ตัวอย่าง selector สำหรับชื่อประกาศ

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Listing: {title.get_text(strip=True)}')

else:

print(f'Blocked by Anti-Bot. Status Code: {response.status_code}')

except Exception as e:

print(f'Error encountered: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_bucom():

async with async_playwright() as p:

# การตั้งค่า Headless=False ช่วยหลีกเลี่ยงการตรวจจับ bot ขั้นพื้นฐานได้บางส่วน

browser = await p.chromium.launch(headless=False)

context = await browser.new_context(

user_agent='Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36'

)

page = await context.new_page()

try:

# กำหนดเป้าหมายหมวดหมู่เชิงพาณิชย์และเมืองที่เจาะจง

await page.goto('https://www.seloger-bureaux-commerces.com/achat/bureau/lyon', wait_until='networkidle')

# รอให้การ์ดรายการประกาศเรนเดอร์เสร็จ

await page.wait_for_selector('div[data-testid="listing-card"]', timeout=15000)

listings = await page.query_selector_all('div[data-testid="listing-card"]')

for card in listings:

title = await card.query_selector('h2')

price = await card.query_selector('span[class*="Price"]')

print(f"Title: {await title.inner_text()} | Price: {await price.inner_text()}")

except Exception as e:

print(f'Scraping failed: {e}')

finally:

await browser.close()

asyncio.run(scrape_bucom())Python + Scrapy

import scrapy

class SeLogerBucomSpider(scrapy.Spider):

name = 'bucom_spider'

allowed_domains = ['seloger-bureaux-commerces.com']

start_urls = ['https://www.seloger-bureaux-commerces.com/location/boutique']

custom_settings = {

'DOWNLOAD_DELAY': 5,

'RANDOMIZE_DOWNLOAD_DELAY': True,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'COOKIES_ENABLED': True

}

def parse(self, response):

# ดึงข้อมูลจาก container ของผลลัพธ์รายการประกาศ

for listing in response.css('div[class*="Card_container"]'):

yield {

'title': listing.css('h2::text').get(),

'price': listing.css('span[class*="Price"]::text').get(),

'surface': listing.css('span[class*="Surface"]::text').get(),

'link': listing.css('a::attr(href)').get()

}

# การจัดการการแบ่งหน้าแบบง่าย

next_page = response.css('a[class*="PaginationNext"]::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer-extra');

const StealthPlugin = require('puppeteer-extra-plugin-stealth');

puppeteer.use(StealthPlugin());

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// จำลองพฤติกรรมมนุษย์ด้วย viewport และ user agent

await page.setViewport({ width: 1280, height: 800 });

try {

await page.goto('https://www.seloger-bureaux-commerces.com/location/bureau/paris', {

waitUntil: 'networkidle2'

});

const results = await page.evaluate(() => {

return Array.from(document.querySelectorAll('a[class*="Card_title"]')).map(el => ({

title: el.innerText,

url: el.href

}));

});

console.log(results);

} catch (err) {

console.error('Extraction Error:', err);

} finally {

await browser.close();

}

})();คุณสามารถทำอะไรกับข้อมูล SeLoger Bureaux & Commerces

สำรวจการใช้งานจริงและข้อมูลเชิงลึกจากข้อมูล SeLoger Bureaux & Commerces

ดัชนีราคาค่าเช่าเพื่อการพาณิชย์

จัดทำเกณฑ์มาตรฐานสำหรับค่าเช่าเชิงพาณิชย์ในแผนกต่างๆ ของฝรั่งเศสเพื่อการประเมินมูลค่าทรัพย์สิน

วิธีการนำไปใช้:

- 1ดึงข้อมูลประกาศที่ใช้งานอยู่ทั้งหมดทุกเดือนสำหรับภูมิภาคเป้าหมาย

- 2ทำความสะอาดและจัดระเบียบข้อมูลราคาและพื้นที่ให้อยู่ในหน่วยมาตรฐาน

- 3สรุปราคาเฉลี่ยต่อตารางเมตรตามเมืองและประเภททรัพย์สิน

- 4แสดงภาพแนวโน้มในเครื่องมือ BI เช่น Tableau หรือ PowerBI

ใช้ Automatio เพื่อดึงข้อมูลจาก SeLoger Bureaux & Commerces และสร้างแอปพลิเคชันเหล่านี้โดยไม่ต้องเขียนโค้ด

คุณสามารถทำอะไรกับข้อมูล SeLoger Bureaux & Commerces

- ดัชนีราคาค่าเช่าเพื่อการพาณิชย์

จัดทำเกณฑ์มาตรฐานสำหรับค่าเช่าเชิงพาณิชย์ในแผนกต่างๆ ของฝรั่งเศสเพื่อการประเมินมูลค่าทรัพย์สิน

- ดึงข้อมูลประกาศที่ใช้งานอยู่ทั้งหมดทุกเดือนสำหรับภูมิภาคเป้าหมาย

- ทำความสะอาดและจัดระเบียบข้อมูลราคาและพื้นที่ให้อยู่ในหน่วยมาตรฐาน

- สรุปราคาเฉลี่ยต่อตารางเมตรตามเมืองและประเภททรัพย์สิน

- แสดงภาพแนวโน้มในเครื่องมือ BI เช่น Tableau หรือ PowerBI

- การตรวจสอบเอเจนซี่คู่แข่ง

ติดตามรายการทรัพย์สินและประสิทธิภาพของเอเจนซี่อสังหาริมทรัพย์คู่แข่งในตลาดฝรั่งเศส

- ดึงชื่อตัวแทน/เอเจนซี่และหมายเลขอ้างอิงทรัพย์สิน

- ระบุระยะเวลาที่ทรัพย์สินยังคงอยู่ในรายการประกาศก่อนที่จะถูกนำออก

- วิเคราะห์ส่วนแบ่งการตลาดของเอเจนซี่เฉพาะรายภายในย่านที่มีมูลค่าสูง

- สร้างรายงานเกี่ยวกับกลยุทธ์การกำหนดราคาของคู่แข่ง

- การสร้าง Lead สำหรับการย้ายที่ตั้งธุรกิจ B2B

ระบุธุรกิจที่มีแนวโน้มว่าจะย้ายหรือขยายเข้าสู่พื้นที่สำนักงานใหม่

- กรองข้อมูลประกาศที่ทำเครื่องหมายว่า 'ใหม่' (New) หรือ 'พร้อมใช้งานทันที' (Available Immediately)

- ติดตามอาคารสำนักงานเฉพาะแห่งเพื่อดูว่าผู้เช่าปัจจุบันย้ายออกเมื่อใด

- ตรวจสอบที่อยู่ที่ดึงมาได้กับฐานข้อมูลการจดทะเบียนบริษัท

- ติดต่อธุรกิจที่กำลังจะย้ายที่ตั้งด้วยข้อเสนอบริการที่ปรับแต่งให้เหมาะสม

- การค้นหาโอกาส Arbitrage ในการลงทุน

คัดกรองทรัพย์สินที่มีราคาต่ำกว่าค่าเฉลี่ยของตลาดในท้องถิ่นอย่างมีนัยสำคัญโดยอัตโนมัติ

- กำหนดค่าเฉลี่ยพื้นฐานโดยใช้ข้อมูลย้อนหลัง 6 เดือนที่ดึงมา

- ตั้งค่าตัวดึงข้อมูลรายวันสำหรับประกาศเชิงพาณิชย์ใหม่

- คำนวณราคาต่อตารางเมตรสำหรับแต่ละประกาศใหม่และเปรียบเทียบกับค่าพื้นฐาน

- ตั้งค่าแจ้งเตือนทางอีเมลทันทีสำหรับประกาศที่มีราคาต่ำกว่าค่าเฉลี่ย 20%

- การวางแผนขยายสาขาค้าปลีก

ค้นหาทำเลที่ตั้งที่เหมาะสมที่สุดสำหรับหน้าร้านใหม่ตามความพร้อมของพื้นที่และต้นทุนในละแวกนั้น

- ดึงข้อมูลพื้นที่ว่างของร้านค้าปลีก (boutique) ในศูนย์กลางเมืองต่างๆ

- ทำแผนที่ความหนาแน่นของพื้นที่เชิงพาณิชย์ที่ว่างโดยใช้ข้อมูล GPS

- วิเคราะห์ความสัมพันธ์ระหว่างจำนวนคนเดินเท้า (foot traffic proxies) และราคาค่าเช่า

- ส่งออกข้อมูลไปยังระบบ GIS เพื่อการวิเคราะห์เชิงพื้นที่

เพิ่มพลังให้เวิร์กโฟลว์ของคุณด้วย ระบบอัตโนมัติ AI

Automatio รวมพลังของ AI agents การอัตโนมัติเว็บ และการผสานรวมอัจฉริยะเพื่อช่วยให้คุณทำงานได้มากขึ้นในเวลาน้อยลง

เคล็ดลับมืออาชีพสำหรับการ Scrape SeLoger Bureaux & Commerces

คำแนะนำจากผู้เชี่ยวชาญสำหรับการดึงข้อมูลจาก SeLoger Bureaux & Commerces อย่างประสบความสำเร็จ

ใช้ French residential proxies ที่มีความน่าเชื่อถือสูงเพื่อให้กลมกลืนไปกับ traffic ปกติในท้องถิ่น

แบ่ง query การค้นหาตามรหัสไปรษณีย์ที่เจาะจง (เช่น 75001, 75008) เพื่อข้ามขีดจำกัดการแสดงผลลัพธ์ที่ 1,000 รายการ

หมุนเวียน TLS fingerprints และ browser headers บ่อยๆ เพื่อหลีกเลี่ยงการตรวจจับ JA3 โดย DataDome

กำหนดให้มีการหน่วงเวลาแบบสุ่มเหมือนมนุษย์ (3-10 วินาที) และการเคลื่อนที่ของเมาส์ระหว่างการโต้ตอบกับหน้าเว็บ

ตรวจสอบ network tab เพื่อหาการเรียก API 'next/data' ซึ่งมักจะมี JSON ที่สะอาดพร้อมรายละเอียดของทรัพย์สิน

ระบุ Referer header ให้ชี้ไปยังหน้าโฮมเพจของ SeLoger เสมอเมื่อทำการส่งคำขอ deep-link

คำรับรอง

ผู้ใช้ของเราพูดอย่างไร

เข้าร่วมกับผู้ใช้ที่พึงพอใจนับพันที่ได้เปลี่ยนแปลงเวิร์กโฟลว์ของพวกเขา

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ที่เกี่ยวข้อง Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

คำถามที่พบบ่อยเกี่ยวกับ SeLoger Bureaux & Commerces

ค้นหาคำตอบสำหรับคำถามทั่วไปเกี่ยวกับ SeLoger Bureaux & Commerces