WebElements Verileri Nasıl Çekilir: Periyodik Tablo Veri Rehberi

WebElements üzerinden kesin kimyasal element verilerini çıkarın. Araştırma ve AI uygulamaları için atom ağırlıklarını, fiziksel özellikleri ve keşif geçmişini...

WebElements Hakkında

WebElements'in sunduklarını ve çıkarılabilecek değerli verileri keşfedin.

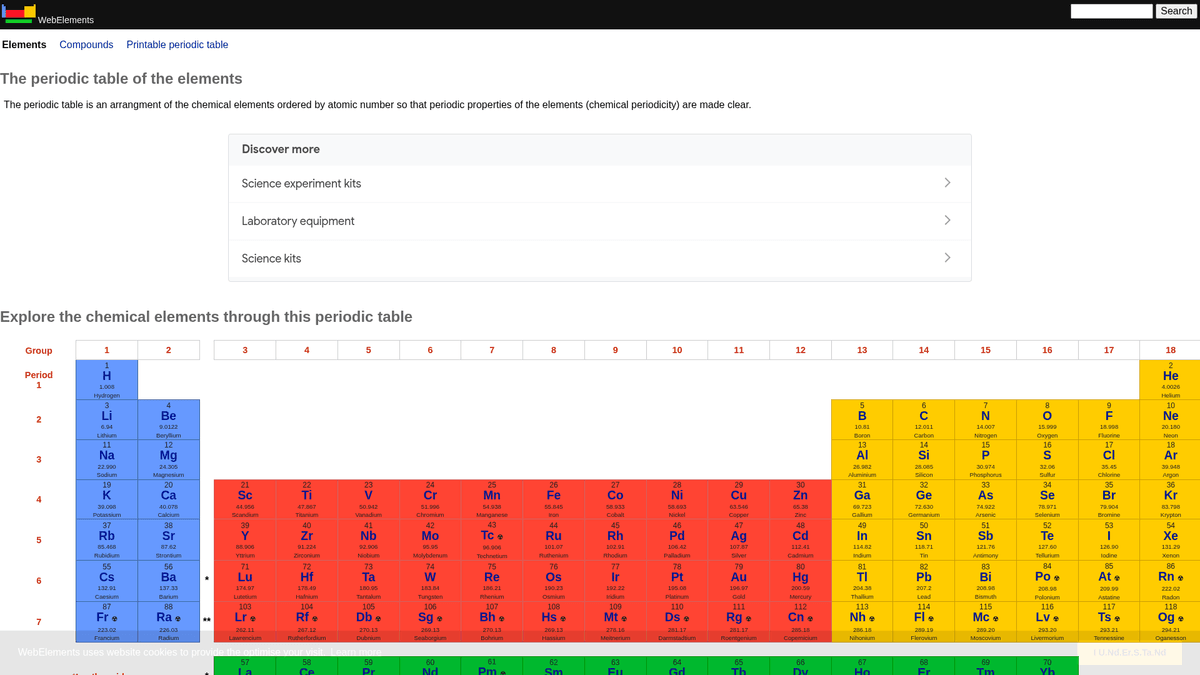

WebElements, Sheffield Üniversitesi'nden Mark Winter tarafından yönetilen prestijli bir çevrimiçi periyodik tablodur. 1993 yılında yayına giren site, World Wide Web üzerindeki ilk periyodik tablo olma özelliğini taşır ve o zamandan beri öğrenciler, akademisyenler ve profesyonel kimyagerler için yüksek otoriteye sahip bir kaynak haline gelmiştir. Site, standart atom ağırlıklarından karmaşık elektronik konfigürasyonlara kadar bilinen her kimyasal element hakkında derinlemesine ve yapılandırılmış veriler sunar.

WebElements verilerini çekmenin değeri, sunduğu yüksek kaliteli ve hakemli bilimsel verilerde yatar. Eğitim araçları geliştiren yazılımcılar, periyodik tablo genelinde eğilim analizi yapan araştırmacılar veya malzeme biliminde machine learning modelleri eğiten uzmanlar için WebElements, manuel olarak toplanması zor olan, güvenilir ve teknik açıdan zengin bir bilgi kaynağı sağlar.

Neden WebElements Kazımalı?

WebElements'den veri çıkarmanın iş değerini ve kullanım durumlarını keşfedin.

Eğitim aracı geliştirme için yüksek kaliteli bilimsel veri toplama.

Malzeme bilimi araştırmaları ve machine learning modelleri için element özelliklerini bir araya getirme.

Laboratuvar envanter sistemlerinin kimyasal spesifikasyonlarla otomatik olarak doldurulması.

Element keşiflerinin ve bilimsel ilerlemenin tarihsel analizi.

Akademik yayınlar için kapsamlı kimyasal özellik veri setlerinin oluşturulması.

Kazıma Zorlukları

WebElements kazırken karşılaşabileceğiniz teknik zorluklar.

Verilerin her element için birden fazla alt sayfaya (/history, /compounds gibi) yayılmış olması.

Eski tablo tabanlı HTML düzenlerinin hassas seçim mantığı gerektirmesi.

Destek ararken Selenium'un 'WebElement' sınıfı ile alan adı karışıklığı yaşanması.

AI ile WebElements Kazıyın

Kod gerekmez. AI destekli otomasyonla dakikalar içinde veri çıkarın.

Nasıl Çalışır

İhtiyacınızı tanımlayın

AI'ya WebElements üzerinden hangi verileri çıkarmak istediğinizi söyleyin. Doğal dilde yazmanız yeterli — kod veya seçiciler gerekmez.

AI verileri çıkarır

Yapay zekamız WebElements'i dolaşır, dinamik içerikleri işler ve tam olarak istediğiniz verileri çıkarır.

Verilerinizi alın

CSV, JSON olarak dışa aktarmaya veya doğrudan uygulamalarınıza göndermeye hazır temiz, yapılandırılmış veriler alın.

Kazıma için neden AI kullanmalısınız

AI, kod yazmadan WebElements'i kazımayı kolaylaştırır. Yapay zeka destekli platformumuz hangi verileri istediğinizi anlar — doğal dilde tanımlayın, AI otomatik olarak çıkarsın.

How to scrape with AI:

- İhtiyacınızı tanımlayın: AI'ya WebElements üzerinden hangi verileri çıkarmak istediğinizi söyleyin. Doğal dilde yazmanız yeterli — kod veya seçiciler gerekmez.

- AI verileri çıkarır: Yapay zekamız WebElements'i dolaşır, dinamik içerikleri işler ve tam olarak istediğiniz verileri çıkarır.

- Verilerinizi alın: CSV, JSON olarak dışa aktarmaya veya doğrudan uygulamalarınıza göndermeye hazır temiz, yapılandırılmış veriler alın.

Why use AI for scraping:

- Hiyerarşik element yapıları arasında kod yazmadan gezinme.

- Karmaşık bilimsel tabloların ayıklanmasını otomatik olarak yönetir.

- Cloud üzerinden yürütme, yerel kesinti olmadan tüm veri setinin çıkarılmasına olanak tanır.

- Bilimsel analiz araçlarında doğrudan kullanım için CSV/JSON formatında kolay dışa aktarma.

- Planlanmış izleme özelliği, onaylanmış element verilerindeki güncellemeleri tespit edebilir.

WebElements için Kodsuz Web Kazıyıcılar

AI destekli kazımaya tıkla ve seç alternatifleri

Browse.ai, Octoparse, Axiom ve ParseHub gibi birçok kodsuz araç, kod yazmadan WebElements kazımanıza yardımcı olabilir. Bu araçlar genellikle veri seçmek için görsel arayüzler kullanır, ancak karmaşık dinamik içerik veya anti-bot önlemleriyle zorlanabilirler.

Kodsuz Araçlarla Tipik İş Akışı

Yaygın Zorluklar

Öğrenme eğrisi

Seçicileri ve çıkarma mantığını anlamak zaman alır

Seçiciler bozulur

Web sitesi değişiklikleri tüm iş akışınızı bozabilir

Dinamik içerik sorunları

JavaScript ağırlıklı siteler karmaşık çözümler gerektirir

CAPTCHA sınırlamaları

Çoğu araç CAPTCHA için manuel müdahale gerektirir

IP engelleme

Agresif scraping IP'nizin engellenmesine yol açabilir

WebElements için Kodsuz Web Kazıyıcılar

Browse.ai, Octoparse, Axiom ve ParseHub gibi birçok kodsuz araç, kod yazmadan WebElements kazımanıza yardımcı olabilir. Bu araçlar genellikle veri seçmek için görsel arayüzler kullanır, ancak karmaşık dinamik içerik veya anti-bot önlemleriyle zorlanabilirler.

Kodsuz Araçlarla Tipik İş Akışı

- Tarayıcı eklentisini kurun veya platforma kaydolun

- Hedef web sitesine gidin ve aracı açın

- Çıkarmak istediğiniz veri öğelerini tıklayarak seçin

- Her veri alanı için CSS seçicileri yapılandırın

- Birden fazla sayfayı scrape etmek için sayfalama kuralları ayarlayın

- CAPTCHA'ları yönetin (genellikle manuel çözüm gerektirir)

- Otomatik çalıştırmalar için zamanlama yapılandırın

- Verileri CSV, JSON'a aktarın veya API ile bağlanın

Yaygın Zorluklar

- Öğrenme eğrisi: Seçicileri ve çıkarma mantığını anlamak zaman alır

- Seçiciler bozulur: Web sitesi değişiklikleri tüm iş akışınızı bozabilir

- Dinamik içerik sorunları: JavaScript ağırlıklı siteler karmaşık çözümler gerektirir

- CAPTCHA sınırlamaları: Çoğu araç CAPTCHA için manuel müdahale gerektirir

- IP engelleme: Agresif scraping IP'nizin engellenmesine yol açabilir

Kod Örnekleri

import requests

from bs4 import BeautifulSoup

import time

# Belirli bir element için hedef URL (örn. Altın)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# H1 etiketinden element adını çıkarma

name = soup.find('h1').get_text().strip()

# Tablo etiketi mantığını kullanarak Atom Numarasını çıkarma

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atom Numarası: {atomic_number}')

except Exception as e:

print(f'Bir hata oluştu: {e}')

# robots.txt önerilerine uyarak

time.sleep(1)

scrape_element(url)Ne Zaman Kullanılır

Minimal JavaScript içeren statik HTML sayfaları için en iyisi. Bloglar, haber siteleri ve basit e-ticaret ürün sayfaları için idealdir.

Avantajlar

- ●En hızlı çalışma (tarayıcı yükü yok)

- ●En düşük kaynak tüketimi

- ●asyncio ile kolayca paralelleştirilebilir

- ●API'ler ve statik sayfalar için harika

Sınırlamalar

- ●JavaScript çalıştıramaz

- ●SPA'larda ve dinamik içerikte başarısız olur

- ●Karmaşık anti-bot sistemleriyle zorlanabilir

Kod ile WebElements Nasıl Kazınır

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# Belirli bir element için hedef URL (örn. Altın)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# H1 etiketinden element adını çıkarma

name = soup.find('h1').get_text().strip()

# Tablo etiketi mantığını kullanarak Atom Numarasını çıkarma

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atom Numarası: {atomic_number}')

except Exception as e:

print(f'Bir hata oluştu: {e}')

# robots.txt önerilerine uyarak

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Elementler ana periyodik tablodan bağlanır

page.goto('https://www.webelements.com/iron/')

# Özellik tablosunun hazır olmasını bekle

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Periyodik tablodaki her element bağlantısını takip et

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Çıkarılan Veri:', data);

await browser.close();

})();WebElements Verileriyle Neler Yapabilirsiniz

WebElements verilerinden pratik uygulamaları ve içgörüleri keşfedin.

Malzeme Bilimi AI Eğitimi

Element özelliklerine dayalı olarak yeni alaşımların özelliklerini tahmin etmek için machine learning modelleri eğitmek.

Nasıl uygulanır:

- 1Tüm metalik elementlerin fiziksel özelliklerini çıkarın.

- 2Yoğunluk ve erime noktası gibi değerleri temizleyin ve normalize edin.

- 3Verileri regresyon veya tahmine dayalı malzeme modellerine aktarın.

- 4Tahminleri mevcut deneysel alaşım verileriyle doğrulayın.

WebElements sitesinden veri çıkarmak ve kod yazmadan bu uygulamaları oluşturmak için Automatio kullanın.

WebElements Verileriyle Neler Yapabilirsiniz

- Malzeme Bilimi AI Eğitimi

Element özelliklerine dayalı olarak yeni alaşımların özelliklerini tahmin etmek için machine learning modelleri eğitmek.

- Tüm metalik elementlerin fiziksel özelliklerini çıkarın.

- Yoğunluk ve erime noktası gibi değerleri temizleyin ve normalize edin.

- Verileri regresyon veya tahmine dayalı malzeme modellerine aktarın.

- Tahminleri mevcut deneysel alaşım verileriyle doğrulayın.

- Eğitici Uygulama İçeriği

Kimya öğrencileri için hazırlanan etkileşimli periyodik tabloları hakemli verilerle doldurmak.

- Atom numaralarını, sembolleri ve element açıklamalarını çekin.

- Tarihsel bağlamı ve keşif ayrıntılarını çıkarın.

- Verileri periyodik grup ve bloklara göre düzenleyin.

- Görsel kristal yapıları ile bir kullanıcı arayüzüne entegre edin.

- Kimyasal Eğilim Analizi

Periyotlar ve gruplar boyunca iyonlaşma enerjisi veya atom yarıçapı gibi periyodik eğilimleri görselleştirmek.

- Her element için özellik verilerini sayısal sırayla toplayın.

- Elementleri kendi gruplarına göre kategorize edin.

- Eğilimleri görselleştirmek için grafik kütüphanelerini kullanın.

- Belirli bloklardaki anormal veri noktalarını tanımlayın ve analiz edin.

- Laboratuvar Envanter Yönetimi

Kimyasal yönetim sistemlerini fiziksel güvenlik ve yoğunluk verileriyle otomatik olarak doldurmak.

- Dahili envanter listesini WebElements girişleriyle eşleştirin.

- Yoğunluk, depolama tehlikeleri ve erime noktası verilerini çekin.

- API aracılığıyla merkezi laboratuvar veritabanını güncelleyin.

- Yüksek riskli elementler için otomatik güvenlik uyarıları oluşturun.

İş akışınızı güçlendirin Yapay Zeka Otomasyonu

Automatio, yapay zeka ajanlari, web otomasyonu ve akilli entegrasyonlarin gucunu birlestirerek daha az zamanda daha fazlasini basarmaniza yardimci olur.

WebElements Kazımak için Pro İpuçları

WebElements'den başarılı veri çıkarmak için uzman tavsiyeler.

Sitenin robots.txt dosyasında belirtilen Crawl-delay: 1 kuralına uyun.

Veritabanı tutarlılığı için Atom Numarasını (Atomic Number) birincil anahtar olarak kullanın.

Her element için tam bir veri seti elde etmek amacıyla 'history' (tarihçe) ve 'compounds' (bileşikler) alt sayfalarını da tarayın.

Site yapısı oldukça geleneksel ve kararlı olduğu için tablo tabanlı seçicilere (selectors) odaklanın.

Kritik araştırmalarda kullanacaksanız verileri IUPAC standartlarına göre doğrulayın.

Analizi kolaylaştırmak için yoğunluk veya erime noktası gibi sayısal değerleri float olarak saklayın.

Referanslar

Kullanicilarimiz Ne Diyor

Is akisini donusturen binlerce memnun kullaniciya katilin

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

İlgili Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

WebElements Hakkında Sık Sorulan Sorular

WebElements hakkında sık sorulan soruların cevaplarını bulun