Cómo extraer datos de BureauxLocaux: Guía de datos de Real Estate comercial

Extrae datos inmobiliarios comerciales de BureauxLocaux. Obtén precios de oficinas, ubicaciones de almacenes y detalles de agentes en Francia para estudios de...

Protección Anti-Bot Detectada

- Cloudflare

- WAF y gestión de bots de nivel empresarial. Usa desafíos JavaScript, CAPTCHAs y análisis de comportamiento. Requiere automatización de navegador con configuración sigilosa.

- CSRF Protection

- Limitación de velocidad

- Limita solicitudes por IP/sesión en el tiempo. Se puede eludir con proxies rotativos, retrasos en solicitudes y scraping distribuido.

- User-Agent Filtering

- Desafío JavaScript

- Requiere ejecutar JavaScript para acceder al contenido. Las solicitudes simples fallan; se necesita un navegador headless como Playwright o Puppeteer.

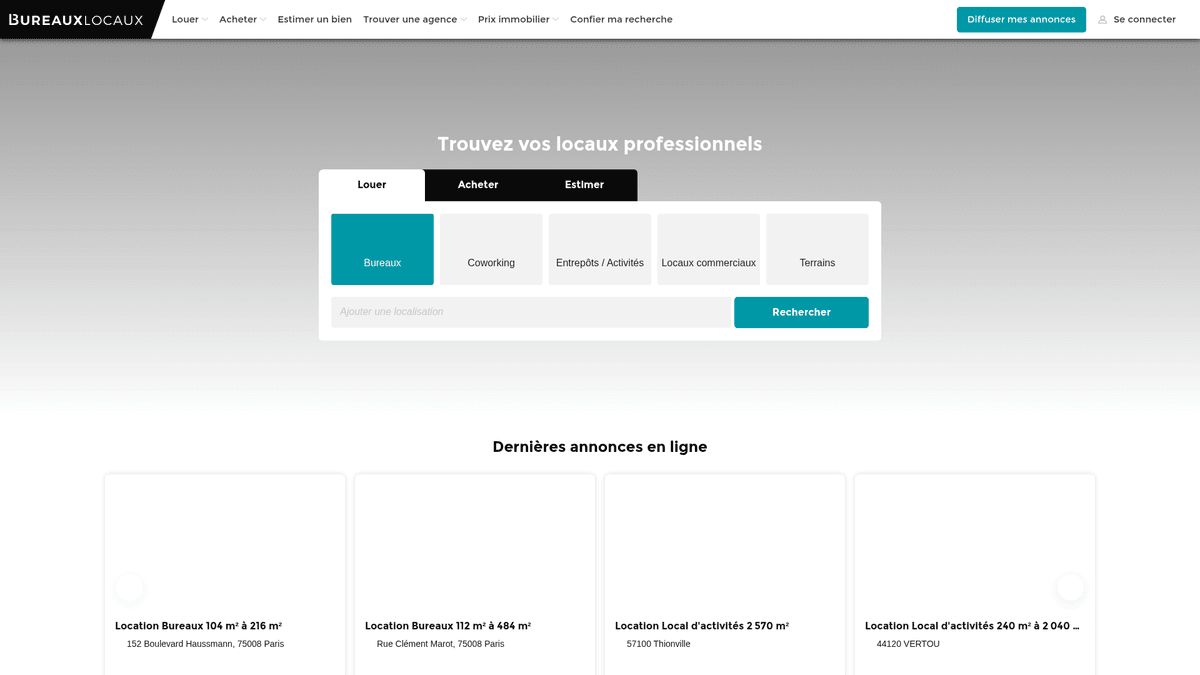

Acerca de BureauxLocaux

Descubre qué ofrece BureauxLocaux y qué datos valiosos se pueden extraer.

El Marketplace Inmobiliario Profesional de Francia

BureauxLocaux es la principal plataforma digital en Francia dedicada al sector inmobiliario profesional, facilitando el arrendamiento y la venta de oficinas, almacenes, locales comerciales y centros de coworking. Propiedad de CoStar Group, la plataforma centraliza datos de más de 1,800 agencias especializadas y alberga más de 72,000 anuncios activos, convirtiéndose en una fuente definitiva de información sobre propiedades B2B.

Inteligencia de Mercado Integral

La plataforma ofrece una visión detallada del panorama comercial francés, desde los distritos de negocios de alta demanda en París hasta los centros logísticos en Lyon y Marsella. Sirve como un puente vital entre quienes buscan propiedades y los corredores especializados, proporcionando especificaciones técnicas detalladas que van más allá de los simples puntos de precio.

Por Qué Son Importantes los Datos

Extraer datos de BureauxLocaux es esencial para desarrolladores inmobiliarios, inversores y planificadores urbanos. Los anuncios de la plataforma proporcionan datos en tiempo real sobre tendencias de precios de alquiler, tasas de desocupación y calificaciones de rendimiento energético (DPE), que son críticos para construir un model de predicción de mercado e identificar oportunidades de inversión de alto rendimiento.

¿Por Qué Scrapear BureauxLocaux?

Descubre el valor comercial y los casos de uso para extraer datos de BureauxLocaux.

Inteligencia del mercado comercial

Monitorea en tiempo real las fluctuaciones de precios de alquiler y venta de oficinas y almacenes en diferentes regiones francesas para identificar centros de negocios emergentes.

Generación de leads B2B

Identifica agencias inmobiliarias comerciales especializadas en nichos específicos como logística o retail de lujo para ofrecer servicios profesionales como equipamiento de oficinas o seguros.

Búsqueda de oportunidades de inversión

Detecta propiedades infravaloradas u oportunidades urgentes de subarriendo en los principales distritos de negocios de París mediante el seguimiento de las bajadas de precio y la duración del anuncio.

Seguimiento del suministro industrial

Analiza la disponibilidad y las especificaciones técnicas de almacenes industriales e instalaciones de almacenamiento para dar soporte a la planificación de la logística y la cadena de suministro.

Análisis de indicadores económicos

Utiliza las tasas de desocupación comercial y la disponibilidad de metros cuadrados como indicadores adelantados del crecimiento o declive económico regional en las principales ciudades francesas.

Desafíos de Scraping

Desafíos técnicos que puedes encontrar al scrapear BureauxLocaux.

Protección avanzada de DataDome

BureauxLocaux utiliza DataDome, un sofisticado sistema de gestión de bots que identifica y bloquea navegadores headless mediante análisis de comportamiento y fingerprint.

Información de contacto bloqueada por interacción

Los datos sensibles, como los números de teléfono de los agentes, suelen estar ocultos tras botones que requieren un clic físico para revelarse, lo que puede activar desafíos de verificación adicionales.

Restricciones de tráfico geográfico

El sitio frecuentemente limita o bloquea por completo el tráfico proveniente de direcciones IP no europeas para evitar intentos de scraping global mientras atiende a los usuarios locales.

Formatos de datos fragmentados

Los precios se listan de forma inconsistente como precio por puesto de trabajo, precio por m2/año o alquiler mensual total, lo que requiere una lógica de normalización compleja durante la extracción.

Scrapea BureauxLocaux con IA

Sin código necesario. Extrae datos en minutos con automatización impulsada por IA.

Cómo Funciona

Describe lo que necesitas

Dile a la IA qué datos quieres extraer de BureauxLocaux. Solo escríbelo en lenguaje natural — sin código ni selectores.

La IA extrae los datos

Nuestra inteligencia artificial navega BureauxLocaux, maneja contenido dinámico y extrae exactamente lo que pediste.

Obtén tus datos

Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Por Qué Usar IA para el Scraping

La IA facilita el scraping de BureauxLocaux sin escribir código. Nuestra plataforma impulsada por inteligencia artificial entiende qué datos quieres — solo descríbelo en lenguaje natural y la IA los extrae automáticamente.

How to scrape with AI:

- Describe lo que necesitas: Dile a la IA qué datos quieres extraer de BureauxLocaux. Solo escríbelo en lenguaje natural — sin código ni selectores.

- La IA extrae los datos: Nuestra inteligencia artificial navega BureauxLocaux, maneja contenido dinámico y extrae exactamente lo que pediste.

- Obtén tus datos: Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Why use AI for scraping:

- Superar la seguridad de DataDome: Automatio está diseñado para navegar a través de escudos avanzados contra bots como DataDome sin activar bloqueos, garantizando una recolección de datos consistente.

- Extracción de datos visual: El selector visual sin código te permite señalar y hacer clic en atributos técnicos complejos, como calificaciones energéticas o servicios del edificio, sin escribir selectores CSS personalizados.

- Proxies franceses integrados: Conecta fácilmente proxies residenciales franceses para imitar el comportamiento de navegación local, lo cual es esencial para acceder a anuncios regionales y evitar bloqueos por reputación de IP.

- Interacciones de UI automatizadas: Configura la herramienta para gestionar automáticamente el banner de consentimiento de cookies de Axeptio y hacer clic en los botones de 'Revelar' para capturar detalles de contacto ocultos.

Scrapers Sin Código para BureauxLocaux

Alternativas de apuntar y clic al scraping con IA

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear BureauxLocaux. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

Desafíos Comunes

Curva de aprendizaje

Comprender selectores y lógica de extracción lleva tiempo

Los selectores se rompen

Los cambios en el sitio web pueden romper todo el flujo de trabajo

Problemas con contenido dinámico

Los sitios con mucho JavaScript requieren soluciones complejas

Limitaciones de CAPTCHA

La mayoría de herramientas requieren intervención manual para CAPTCHAs

Bloqueo de IP

El scraping agresivo puede resultar en el bloqueo de tu IP

Scrapers Sin Código para BureauxLocaux

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear BureauxLocaux. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

- Instalar extensión del navegador o registrarse en la plataforma

- Navegar al sitio web objetivo y abrir la herramienta

- Seleccionar con point-and-click los elementos de datos a extraer

- Configurar selectores CSS para cada campo de datos

- Configurar reglas de paginación para scrapear múltiples páginas

- Resolver CAPTCHAs (frecuentemente requiere intervención manual)

- Configurar programación para ejecuciones automáticas

- Exportar datos a CSV, JSON o conectar vía API

Desafíos Comunes

- Curva de aprendizaje: Comprender selectores y lógica de extracción lleva tiempo

- Los selectores se rompen: Los cambios en el sitio web pueden romper todo el flujo de trabajo

- Problemas con contenido dinámico: Los sitios con mucho JavaScript requieren soluciones complejas

- Limitaciones de CAPTCHA: La mayoría de herramientas requieren intervención manual para CAPTCHAs

- Bloqueo de IP: El scraping agresivo puede resultar en el bloqueo de tu IP

Ejemplos de Código

import requests

from bs4 import BeautifulSoup

# Nota: Esto puede ser bloqueado por Cloudflare sin encabezados/proxies avanzados

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Ejemplo: Selección de tarjetas de anuncios

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Anuncio: {title} | Precio: {price}')

except Exception as e:

print(f'Error en la extracción: {e}')Cuándo Usar

Mejor para páginas HTML estáticas donde el contenido se carga del lado del servidor. El enfoque más rápido y simple cuando no se requiere renderizado de JavaScript.

Ventajas

- ●Ejecución más rápida (sin sobrecarga del navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar con asyncio

- ●Excelente para APIs y páginas estáticas

Limitaciones

- ●No puede ejecutar JavaScript

- ●Falla en SPAs y contenido dinámico

- ●Puede tener dificultades con sistemas anti-bot complejos

Cómo Scrapear BureauxLocaux con Código

Python + Requests

import requests

from bs4 import BeautifulSoup

# Nota: Esto puede ser bloqueado por Cloudflare sin encabezados/proxies avanzados

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Ejemplo: Selección de tarjetas de anuncios

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Anuncio: {title} | Precio: {price}')

except Exception as e:

print(f'Error en la extracción: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# Se recomienda el lanzamiento con stealth o un UA específico

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# Navegar a los resultados de búsqueda

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# Esperar a que se rendericen los anuncios

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Contactar agente"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# Iterar a través de cada tarjeta de propiedad en la página

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# Paginación: Encontrar el enlace a la página 'Siguiente'

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Configurar un User-Agent realista

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// Extraer datos de los elementos del anuncio

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();Qué Puedes Hacer Con Los Datos de BureauxLocaux

Explora aplicaciones prácticas e insights de los datos de BureauxLocaux.

Indexación de Alquileres Comerciales

Los analistas financieros pueden construir un índice dinámico de costos de alquiler de oficinas para asesorar a clientes corporativos sobre estrategia de ubicación.

Cómo implementar:

- 1Extraer semanalmente todos los anuncios de oficinas activos en las principales ciudades francesas.

- 2Calcular el precio por metro cuadrado al año para cada entrada.

- 3Agrupar datos por distrito (Arrondissement) para identificar conglomerados de precios.

- 4Visualizar el 'Mapa de Calor de Precios' utilizando una herramienta de mapeo como Tableau.

Usa Automatio para extraer datos de BureauxLocaux y crear estas aplicaciones sin escribir código.

Qué Puedes Hacer Con Los Datos de BureauxLocaux

- Indexación de Alquileres Comerciales

Los analistas financieros pueden construir un índice dinámico de costos de alquiler de oficinas para asesorar a clientes corporativos sobre estrategia de ubicación.

- Extraer semanalmente todos los anuncios de oficinas activos en las principales ciudades francesas.

- Calcular el precio por metro cuadrado al año para cada entrada.

- Agrupar datos por distrito (Arrondissement) para identificar conglomerados de precios.

- Visualizar el 'Mapa de Calor de Precios' utilizando una herramienta de mapeo como Tableau.

- Generación de Leads Inmobiliarios

Los proveedores de servicios B2B pueden encontrar empresas que se mudan a nuevos espacios y que requieren configuración de TI, mobiliario o seguros.

- Apuntar a anuncios marcados como 'Recientemente Disponible' o 'Nuevo en el Mercado'.

- Extraer los datos de contacto de la agencia del anuncio para prospección de alianzas.

- Rastrear la eliminación de propiedades para estimar cuándo una empresa ha firmado con éxito un contrato de arrendamiento.

- Automatizar una entrada en el CRM para nuevos proyectos potenciales de renovación de oficinas.

- Seguimiento de Duración de Vacantes

Los investigadores económicos pueden monitorear cuánto tiempo permanecen las propiedades industriales en el mercado para medir la salud económica local.

- Extraer todos los anuncios de almacenes y almacenar su fecha de 'Primera aparición'.

- Verificar continuamente qué anuncios siguen activos frente a los eliminados.

- Calcular el 'Tiempo en el Mercado' (ToM) promedio para cada zona industrial.

- Correlacionar un ToM alto con recesiones económicas regionales específicas.

- Automatización de Filtros de Inversión

Los inversores pueden recibir alertas instantáneas cuando las propiedades caen por debajo de un cierto umbral de precio en áreas específicas.

- Configurar una extracción diaria para categorías específicas como 'Venta de Bureaux'.

- Comparar el precio diario con el promedio histórico para ese código postal específico.

- Activar una notificación si una propiedad tiene un precio un 15% inferior al promedio del mercado.

- Exportar las ofertas filtradas a una Google Sheet para revisión inmediata.

Potencia tu flujo de trabajo con Automatizacion IA

Automatio combina el poder de agentes de IA, automatizacion web e integraciones inteligentes para ayudarte a lograr mas en menos tiempo.

Consejos Pro para Scrapear BureauxLocaux

Consejos expertos para extraer datos exitosamente de BureauxLocaux.

Priorizar proxies residenciales franceses

Utilizar proxies basados en Francia es la forma más efectiva de evitar ser detectado por los filtros de seguridad regionales del sitio.

Tener en cuenta los sufijos de impuestos

Asegúrate de que tus parsers de precios reconozcan 'HT' (Hors Taxes) y 'HC' (Hors Charges) para calcular con precisión el coste total de los anuncios comerciales.

Monitorear solicitudes XHR internas

Inspecciona el tráfico de red para encontrar los endpoints JSON internos que el sitio utiliza para cargar los anuncios y lograr una extracción más eficiente y estructurada.

Implementar retrasos aleatorios

Introduce tiempos de espera variables entre las cargas de página y las interacciones para replicar patrones de navegación humana y mantenerse por debajo de los umbrales de rate-limiting.

Gestionar el consentimiento de cookies primero

Asegúrate de que tu scraper interactúe con el modal de consentimiento de cookies o lo oculte al entrar, para evitar que se superponga y bloquee el acceso a los elementos del anuncio.

Testimonios

Lo Que Dicen Nuestros Usuarios

Unete a miles de usuarios satisfechos que han transformado su flujo de trabajo

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Preguntas Frecuentes Sobre BureauxLocaux

Encuentra respuestas a preguntas comunes sobre BureauxLocaux