Cómo hacer scraping de We Work Remotely: La guía definitiva

Aprende cómo extraer ofertas de trabajo de We Work Remotely. Extrae títulos de puestos, empresas, salarios y más para investigación de mercado o tu propio...

Protección Anti-Bot Detectada

- Cloudflare

- WAF y gestión de bots de nivel empresarial. Usa desafíos JavaScript, CAPTCHAs y análisis de comportamiento. Requiere automatización de navegador con configuración sigilosa.

- Bloqueo de IP

- Bloquea IPs de centros de datos conocidos y direcciones marcadas. Requiere proxies residenciales o móviles para eludir efectivamente.

- Limitación de velocidad

- Limita solicitudes por IP/sesión en el tiempo. Se puede eludir con proxies rotativos, retrasos en solicitudes y scraping distribuido.

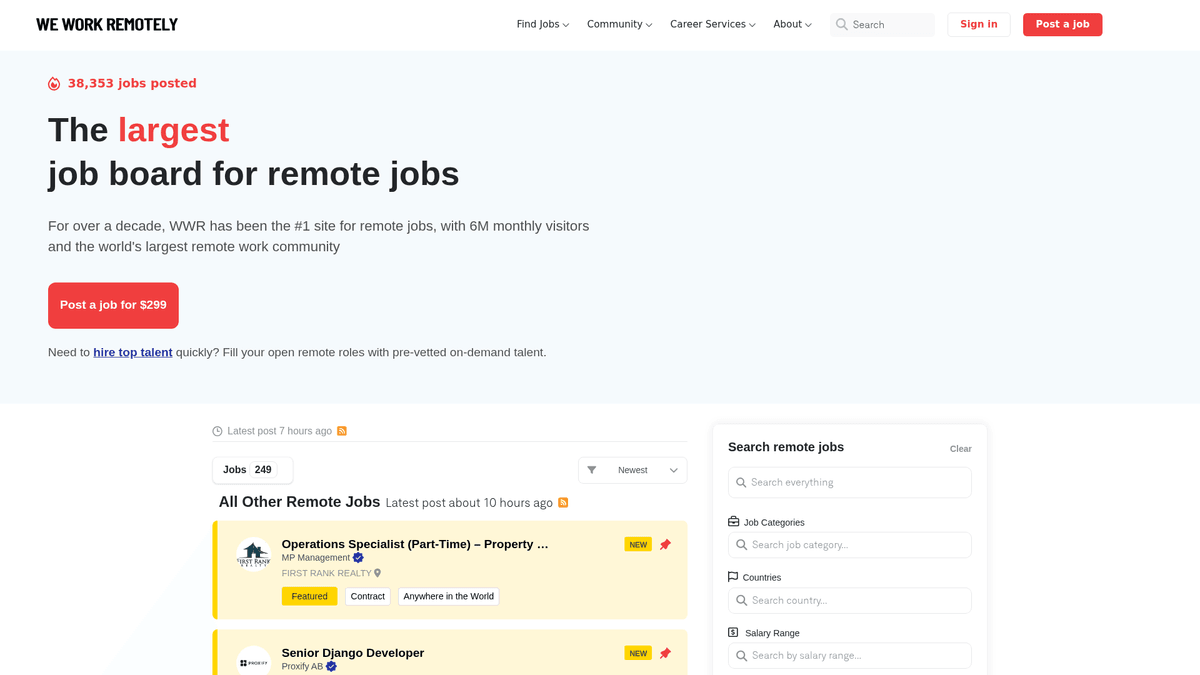

Acerca de We Work Remotely

Descubre qué ofrece We Work Remotely y qué datos valiosos se pueden extraer.

El centro para el talento remoto global

We Work Remotely (WWR) es la comunidad de trabajo remoto más establecida a nivel mundial, con más de 6 millones de visitantes mensuales. Sirve como destino principal para las empresas que se alejan de los modelos tradicionales basados en oficinas, ofreciendo una amplia gama de ofertas en desarrollo de software, diseño, marketing y soporte al cliente.

Datos estructurados de alta calidad

La plataforma es conocida por sus datos altamente estructurados. Cada listado suele contener requisitos regionales específicos, rangos de salario y perfiles de empresa detallados. Esta estructura la convierte en un objetivo ideal para el web scraping, ya que los datos son consistentes y fáciles de categorizar para casos de uso secundarios.

Valor estratégico para profesionales de datos

Para reclutadores e investigadores de mercado, WWR es una mina de oro. El scraping de este sitio permite el seguimiento en tiempo real de las tendencias de contratación, el benchmark de salarios en diferentes sectores técnicos y la generación de leads para servicios B2B dirigidos a empresas remote-first. Proporciona una visión transparente del mercado laboral remoto global.

¿Por Qué Scrapear We Work Remotely?

Descubre el valor comercial y los casos de uso para extraer datos de We Work Remotely.

Análisis de la demanda del mercado

Rastrea qué lenguajes de programación, frameworks y habilidades blandas son tendencia en el panorama del trabajo remoto para mantenerte a la vanguardia de los cambios del mercado.

benchmark de salarios

Extrae datos salariales de los listados para crear informes de compensación exhaustivos para empresas remotas en diversos roles técnicos y creativos.

Generación de leads B2B

Identifica empresas que están escalando activamente sus equipos remotos para ofrecer servicios especializados como tecnología de RR.HH., soluciones de nómina o consultoría de contratación.

Agregación de empleos de nicho

Impulsa una bolsa de trabajo especializada filtrando y agregando listados remotos de alta calidad en nichos específicos como Web3, AI o Diseño.

Inteligencia competitiva

Monitorea la velocidad de contratación y las preferencias geográficas de tus competidores para entender su estrategia de crecimiento y sus posibles áreas de expansión.

Desafíos de Scraping

Desafíos técnicos que puedes encontrar al scrapear We Work Remotely.

Detección de bots de Cloudflare

WWR utiliza la capa de seguridad de Cloudflare, que puede detectar y bloquear scripts automatizados estándar que no imitan adecuadamente el comportamiento de un navegador humano.

Datos salariales no estructurados

La información salarial a menudo está incrustada en las descripciones de texto en formatos variados, lo que requiere patrones regex complejos para extraerla y normalizarla en valores numéricos.

Carga de contenido dinámico

Navegar entre los listados generales y la paginación de 'Cargar más' requiere un extractor capaz de manejar solicitudes asíncronas sin perder la integridad de los datos.

Estructuras HTML variables

Los anuncios destacados y los anuncios estándar a veces utilizan clases CSS ligeramente diferentes, lo que requiere selectores flexibles para garantizar que no se pierda ningún empleo.

Scrapea We Work Remotely con IA

Sin código necesario. Extrae datos en minutos con automatización impulsada por IA.

Cómo Funciona

Describe lo que necesitas

Dile a la IA qué datos quieres extraer de We Work Remotely. Solo escríbelo en lenguaje natural — sin código ni selectores.

La IA extrae los datos

Nuestra inteligencia artificial navega We Work Remotely, maneja contenido dinámico y extrae exactamente lo que pediste.

Obtén tus datos

Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Por Qué Usar IA para el Scraping

La IA facilita el scraping de We Work Remotely sin escribir código. Nuestra plataforma impulsada por inteligencia artificial entiende qué datos quieres — solo descríbelo en lenguaje natural y la IA los extrae automáticamente.

How to scrape with AI:

- Describe lo que necesitas: Dile a la IA qué datos quieres extraer de We Work Remotely. Solo escríbelo en lenguaje natural — sin código ni selectores.

- La IA extrae los datos: Nuestra inteligencia artificial navega We Work Remotely, maneja contenido dinámico y extrae exactamente lo que pediste.

- Obtén tus datos: Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Why use AI for scraping:

- Manejo automatizado de anti-bots: Automatio maneja de forma nativa la rotación de proxies y la huella digital del navegador para eludir Cloudflare y otras medidas de seguridad sin configuración manual.

- Selección visual sin código: Selecciona fácilmente títulos de trabajo, nombres de empresas y descripciones mediante una interfaz de apuntar y hacer clic, en lugar de escribir selectores CSS o XPath complejos.

- Monitoreo programado: Configura tu extractor para que se ejecute cada hora o día para detectar y extraer automáticamente las ofertas de trabajo remoto más recientes en el momento en que se publiquen.

- Exportación de datos fluida: Envía directamente tus listados de trabajo extraídos a Google Sheets, Airtable o un Webhook para alimentar tu aplicación o CRM en tiempo real.

Scrapers Sin Código para We Work Remotely

Alternativas de apuntar y clic al scraping con IA

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear We Work Remotely. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

Desafíos Comunes

Curva de aprendizaje

Comprender selectores y lógica de extracción lleva tiempo

Los selectores se rompen

Los cambios en el sitio web pueden romper todo el flujo de trabajo

Problemas con contenido dinámico

Los sitios con mucho JavaScript requieren soluciones complejas

Limitaciones de CAPTCHA

La mayoría de herramientas requieren intervención manual para CAPTCHAs

Bloqueo de IP

El scraping agresivo puede resultar en el bloqueo de tu IP

Scrapers Sin Código para We Work Remotely

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear We Work Remotely. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

- Instalar extensión del navegador o registrarse en la plataforma

- Navegar al sitio web objetivo y abrir la herramienta

- Seleccionar con point-and-click los elementos de datos a extraer

- Configurar selectores CSS para cada campo de datos

- Configurar reglas de paginación para scrapear múltiples páginas

- Resolver CAPTCHAs (frecuentemente requiere intervención manual)

- Configurar programación para ejecuciones automáticas

- Exportar datos a CSV, JSON o conectar vía API

Desafíos Comunes

- Curva de aprendizaje: Comprender selectores y lógica de extracción lleva tiempo

- Los selectores se rompen: Los cambios en el sitio web pueden romper todo el flujo de trabajo

- Problemas con contenido dinámico: Los sitios con mucho JavaScript requieren soluciones complejas

- Limitaciones de CAPTCHA: La mayoría de herramientas requieren intervención manual para CAPTCHAs

- Bloqueo de IP: El scraping agresivo puede resultar en el bloqueo de tu IP

Ejemplos de Código

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Enviar solicitud con headers personalizados

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Seleccionar listados de empleo

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Empleo: {title} | Empresa: {company}')

except Exception as e:

print(f'Error: {e}')Cuándo Usar

Mejor para páginas HTML estáticas donde el contenido se carga del lado del servidor. El enfoque más rápido y simple cuando no se requiere renderizado de JavaScript.

Ventajas

- ●Ejecución más rápida (sin sobrecarga del navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar con asyncio

- ●Excelente para APIs y páginas estáticas

Limitaciones

- ●No puede ejecutar JavaScript

- ●Falla en SPAs y contenido dinámico

- ●Puede tener dificultades con sistemas anti-bot complejos

Cómo Scrapear We Work Remotely con Código

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Enviar solicitud con headers personalizados

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Seleccionar listados de empleo

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Empleo: {title} | Empresa: {company}')

except Exception as e:

print(f'Error: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def run():

async with async_playwright() as p:

# Lanzar navegador headless

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

await page.goto('https://weworkremotely.com/')

# Esperar a que cargue el contenedor principal

await page.wait_for_selector('.jobs-container')

jobs = await page.query_selector_all('li.feature')

for job in jobs:

title = await job.query_selector('.title')

if title:

print(await title.inner_text())

await browser.close()

asyncio.run(run())Python + Scrapy

import scrapy

class WwrSpider(scrapy.Spider):

name = 'wwr_spider'

start_urls = ['https://weworkremotely.com/']

def parse(self, response):

# Iterar a través de los elementos del listado

for job in response.css('li.feature'):

yield {

'title': job.css('span.title::text').get(),

'company': job.css('span.company::text').get(),

'url': response.urljoin(job.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://weworkremotely.com/');

// Extraer datos usando evaluate

const jobs = await page.evaluate(() => {

return Array.from(document.querySelectorAll('li.feature')).map(li => ({

title: li.querySelector('.title')?.innerText.trim(),

company: li.querySelector('.company')?.innerText.trim()

}));

});

console.log(jobs);

await browser.close();

})();Qué Puedes Hacer Con Los Datos de We Work Remotely

Explora aplicaciones prácticas e insights de los datos de We Work Remotely.

Agregador de empleos remotos

Construye una plataforma de búsqueda de empleo especializada para nichos técnicos específicos como Rust o AI.

Cómo implementar:

- 1Extraer WWR diariamente en busca de nuevos listados

- 2Filtrar por palabras clave y categorías específicas

- 3Almacenar los datos en una base de datos con capacidad de búsqueda

- 4Automatizar publicaciones en redes sociales para nuevos empleos

Usa Automatio para extraer datos de We Work Remotely y crear estas aplicaciones sin escribir código.

Qué Puedes Hacer Con Los Datos de We Work Remotely

- Agregador de empleos remotos

Construye una plataforma de búsqueda de empleo especializada para nichos técnicos específicos como Rust o AI.

- Extraer WWR diariamente en busca de nuevos listados

- Filtrar por palabras clave y categorías específicas

- Almacenar los datos en una base de datos con capacidad de búsqueda

- Automatizar publicaciones en redes sociales para nuevos empleos

- Análisis de tendencias salariales

Analiza los datos salariales remotos para determinar benchmarks de compensación global en diversos roles.

- Extraer campos salariales de las descripciones de los puestos

- Normalizar los datos en una sola moneda

- Segmentar por rol de trabajo y nivel de experiencia

- Generar informes trimestrales de mercado

- Generación de leads para HR Tech

Identifica empresas que contratan agresivamente equipos remotos para vender software de RR.HH., nómina y beneficios.

- Monitorear la lista de las '100 mejores empresas remotas'

- Rastrear la frecuencia de nuevas publicaciones de empleo

- Identificar a los tomadores de decisiones en las empresas contratantes

- Realizar prospección con soluciones B2B personalizadas

- Tendencias históricas de contratación

Analiza datos a largo plazo para comprender cómo cambia la demanda de trabajo remoto estacional o económicamente.

- Archivar listados durante más de 12 meses

- Calcular las tasas de crecimiento por categoría

- Visualizar tendencias utilizando herramientas de BI

- Predecir la demanda futura de habilidades

Potencia tu flujo de trabajo con Automatizacion IA

Automatio combina el poder de agentes de IA, automatizacion web e integraciones inteligentes para ayudarte a lograr mas en menos tiempo.

Consejos Pro para Scrapear We Work Remotely

Consejos expertos para extraer datos exitosamente de We Work Remotely.

Procesa primero los feeds RSS

Revisa los endpoints /remote-jobs.rss de varias categorías; ofrecen XML estructurado que es significativamente más fácil y rápido de procesar que el HTML principal.

Utiliza URLs específicas por categoría

Dirígete a URLs como /categories/remote-programming-jobs para obtener resultados más limpios y evitar el ruido de la página de inicio principal.

Rota proxies residenciales

Para evitar el límite de tasa en las páginas de detalles, utiliza proxies residenciales, ya que es menos probable que sean marcados como bots en comparación con las IPs de centros de datos.

Enfócate en los metadatos JSON-LD

Muchas páginas de empleo incluyen datos estructurados en formato JSON-LD dentro del HTML, lo que proporciona datos limpios y listos para usar de los títulos y descripciones de los puestos.

Aleatoriza los intervalos de solicitud

Implementa retrasos similares a los humanos entre los clics en los diferentes listados de trabajo para evitar que la seguridad del sitio identifique un patrón robótico.

Monitorea la sección 'Top 100'

Extrae los datos de la página 'Top 100 Companies' por separado para identificar objetivos de contratación de alto valor que publican constantemente en la plataforma.

Testimonios

Lo Que Dicen Nuestros Usuarios

Unete a miles de usuarios satisfechos que han transformado su flujo de trabajo

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape Freelancer.com: A Complete Technical Guide

How to Scrape Upwork: A Comprehensive Technical Guide

How to Scrape Arc.dev: The Complete Guide to Remote Job Data

How to Scrape Toptal | Toptal Web Scraper Guide

How to Scrape Guru.com: A Comprehensive Web Scraping Guide

How to Scrape Fiverr | Fiverr Web Scraper Guide

How to Scrape Indeed: 2025 Guide for Job Market Data

How to Scrape Charter Global | IT Services & Job Board Scraper

Preguntas Frecuentes Sobre We Work Remotely

Encuentra respuestas a preguntas comunes sobre We Work Remotely