Cómo hacer scraping de WebElements: Guía de datos de la tabla periódica

Extraiga datos precisos de elementos químicos de WebElements. Haga scraping de pesos atómicos, propiedades físicas e historia de descubrimientos para...

Acerca de WebElements

Descubre qué ofrece WebElements y qué datos valiosos se pueden extraer.

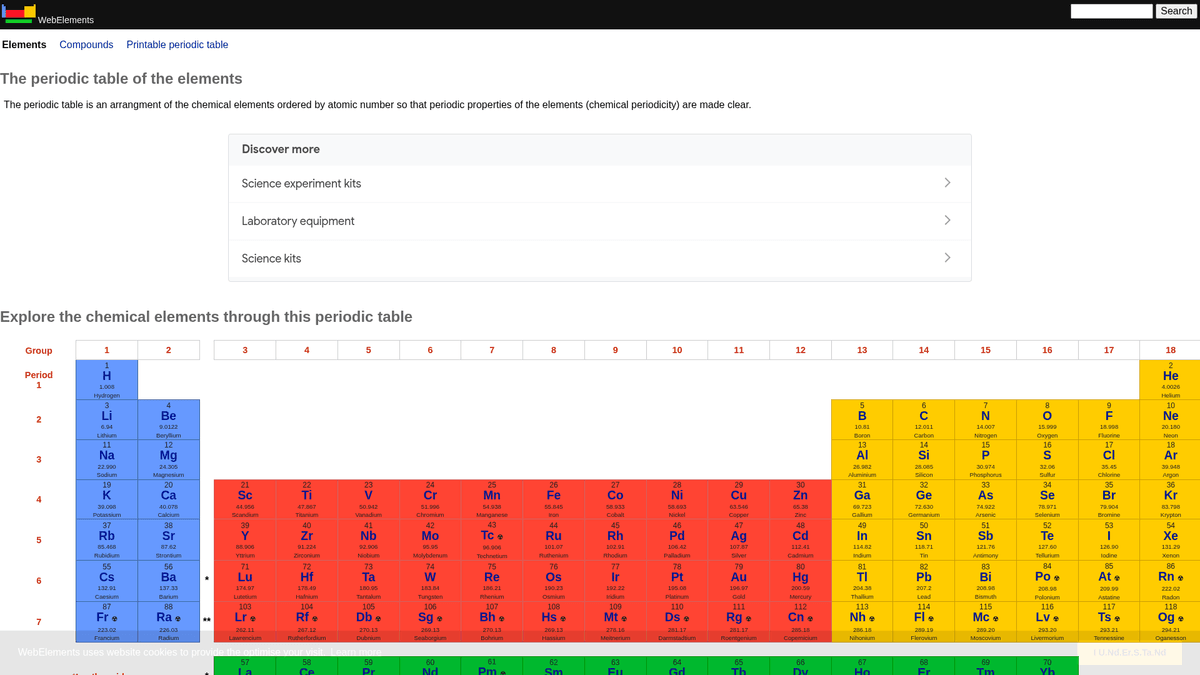

WebElements es una tabla periódica en línea de primer nivel mantenida por Mark Winter en la University of Sheffield. Lanzada en 1993, fue la primera tabla periódica en la World Wide Web y desde entonces se ha convertido en un recurso de alta autoridad para estudiantes, académicos y químicos profesionales. El sitio ofrece datos estructurados y profundos sobre cada elemento químico conocido, desde pesos atómicos estándar hasta configuraciones electrónicas complejas.

El valor de hacer scraping en WebElements reside en sus datos científicos de alta calidad revisados por pares. Para desarrolladores que crean herramientas educativas, investigadores que realizan análisis de tendencias en la tabla periódica o científicos de materiales que entrenan machine learning models, WebElements proporciona una fuente de verdad confiable y técnicamente rica que es difícil de agregar manualmente.

¿Por Qué Scrapear WebElements?

Descubre el valor comercial y los casos de uso para extraer datos de WebElements.

Poblamiento de bases de datos científicas

Agregue datos atómicos y químicos revisados por pares en bases de datos centralizadas para la investigación académica y el análisis de materiales a gran escala.

Desarrollo de herramientas educativas

Extraiga datos estructurados para alimentar aplicaciones de tablas periódicas personalizadas, plataformas de aprendizaje móvil y tarjetas interactivas para el aula.

Modelado predictivo de materiales

Recopile propiedades numéricas como radios atómicos y electronegatividad como características de entrenamiento para modelos de machine learning en ciencia de materiales.

Integración en quimioinformática

Integre datos exhaustivos de isótopos y termodinámica directamente en sistemas de gestión de laboratorios y software de cálculo estequiométrico.

Cronologías científicas históricas

Recopile fechas de descubrimiento, origen de los nombres y contexto histórico de los 118 elementos para crear cronologías científicas digitales.

Desafíos de Scraping

Desafíos técnicos que puedes encontrar al scrapear WebElements.

Estructura de subpáginas fragmentada

Los datos de un solo elemento a menudo se dividen en múltiples sub-URLs específicas como /atoms, /history o /compounds, lo que requiere un rastreo en varios pasos.

Codificación de símbolos especiales

Analizar y almacenar correctamente la notación científica, superíndices, subíndices y caracteres griegos requiere un manejo estricto de UTF-8 para evitar la corrupción de datos.

Requisitos de normalización de unidades

Extraer datos numéricos brutos requiere eliminar mediante programación unidades como 'pm', 'K' o 'g cm-3' y convertir la notación científica en floats estándar.

Variaciones de tablas basadas en etiquetas

Los datos se almacenan en tablas genéricas sin IDs únicos, lo que significa que los scrapers deben identificar los campos revisando el contenido de texto de las etiquetas en lugar de las clases CSS.

Scrapea WebElements con IA

Sin código necesario. Extrae datos en minutos con automatización impulsada por IA.

Cómo Funciona

Describe lo que necesitas

Dile a la IA qué datos quieres extraer de WebElements. Solo escríbelo en lenguaje natural — sin código ni selectores.

La IA extrae los datos

Nuestra inteligencia artificial navega WebElements, maneja contenido dinámico y extrae exactamente lo que pediste.

Obtén tus datos

Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Por Qué Usar IA para el Scraping

La IA facilita el scraping de WebElements sin escribir código. Nuestra plataforma impulsada por inteligencia artificial entiende qué datos quieres — solo descríbelo en lenguaje natural y la IA los extrae automáticamente.

How to scrape with AI:

- Describe lo que necesitas: Dile a la IA qué datos quieres extraer de WebElements. Solo escríbelo en lenguaje natural — sin código ni selectores.

- La IA extrae los datos: Nuestra inteligencia artificial navega WebElements, maneja contenido dinámico y extrae exactamente lo que pediste.

- Obtén tus datos: Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Why use AI for scraping:

- Mapeo visual de datos: Utilice una interfaz de apuntar y hacer clic para mapear propiedades químicas complejas a campos de datos específicos sin escribir selectores CSS o XPaths personalizados.

- Seguimiento recursivo de enlaces: Configure fácilmente la herramienta para visitar la tabla periódica principal y seguir automáticamente los enlaces a cada elemento y sus subpáginas correspondientes.

- Limpieza automática de datos: Utilice herramientas de formateo integradas para eliminar automáticamente unidades y símbolos científicos durante el proceso de extracción, garantizando salidas numéricas limpias.

- Monitoreo programado: Configure el scraper para que se ejecute automáticamente a intervalos para capturar actualizaciones de pesos atómicos o propiedades recién descubiertas a medida que la IUPAC las confirme.

Scrapers Sin Código para WebElements

Alternativas de apuntar y clic al scraping con IA

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear WebElements. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

Desafíos Comunes

Curva de aprendizaje

Comprender selectores y lógica de extracción lleva tiempo

Los selectores se rompen

Los cambios en el sitio web pueden romper todo el flujo de trabajo

Problemas con contenido dinámico

Los sitios con mucho JavaScript requieren soluciones complejas

Limitaciones de CAPTCHA

La mayoría de herramientas requieren intervención manual para CAPTCHAs

Bloqueo de IP

El scraping agresivo puede resultar en el bloqueo de tu IP

Scrapers Sin Código para WebElements

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear WebElements. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

- Instalar extensión del navegador o registrarse en la plataforma

- Navegar al sitio web objetivo y abrir la herramienta

- Seleccionar con point-and-click los elementos de datos a extraer

- Configurar selectores CSS para cada campo de datos

- Configurar reglas de paginación para scrapear múltiples páginas

- Resolver CAPTCHAs (frecuentemente requiere intervención manual)

- Configurar programación para ejecuciones automáticas

- Exportar datos a CSV, JSON o conectar vía API

Desafíos Comunes

- Curva de aprendizaje: Comprender selectores y lógica de extracción lleva tiempo

- Los selectores se rompen: Los cambios en el sitio web pueden romper todo el flujo de trabajo

- Problemas con contenido dinámico: Los sitios con mucho JavaScript requieren soluciones complejas

- Limitaciones de CAPTCHA: La mayoría de herramientas requieren intervención manual para CAPTCHAs

- Bloqueo de IP: El scraping agresivo puede resultar en el bloqueo de tu IP

Ejemplos de Código

import requests

from bs4 import BeautifulSoup

import time

# Target URL for a specific element (e.g., Gold)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting the element name from the H1 tag

name = soup.find('h1').get_text().strip()

# Extracting Atomic Number using table label logic

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'An error occurred: {e}')

# Following robots.txt recommendations

time.sleep(1)

scrape_element(url)Cuándo Usar

Mejor para páginas HTML estáticas donde el contenido se carga del lado del servidor. El enfoque más rápido y simple cuando no se requiere renderizado de JavaScript.

Ventajas

- ●Ejecución más rápida (sin sobrecarga del navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar con asyncio

- ●Excelente para APIs y páginas estáticas

Limitaciones

- ●No puede ejecutar JavaScript

- ●Falla en SPAs y contenido dinámico

- ●Puede tener dificultades con sistemas anti-bot complejos

Cómo Scrapear WebElements con Código

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# Target URL for a specific element (e.g., Gold)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting the element name from the H1 tag

name = soup.find('h1').get_text().strip()

# Extracting Atomic Number using table label logic

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'An error occurred: {e}')

# Following robots.txt recommendations

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Elements are linked from the main periodic table

page.goto('https://www.webelements.com/iron/')

# Wait for the property table to be present

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Follow every element link in the periodic table

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Extracted Data:', data);

await browser.close();

})();Qué Puedes Hacer Con Los Datos de WebElements

Explora aplicaciones prácticas e insights de los datos de WebElements.

Entrenamiento de IA en Ciencia de Materiales

Entrenamiento de machine learning models para predecir las propiedades de nuevas aleaciones basadas en atributos elementales.

Cómo implementar:

- 1Extraer propiedades físicas de todos los elementos metálicos.

- 2Limpiar y normalizar valores como densidad y puntos de fusión.

- 3Ingresar los datos en regression o predictive material models.

- 4Verificar las predicciones contra datos experimentales de aleaciones existentes.

Usa Automatio para extraer datos de WebElements y crear estas aplicaciones sin escribir código.

Qué Puedes Hacer Con Los Datos de WebElements

- Entrenamiento de IA en Ciencia de Materiales

Entrenamiento de machine learning models para predecir las propiedades de nuevas aleaciones basadas en atributos elementales.

- Extraer propiedades físicas de todos los elementos metálicos.

- Limpiar y normalizar valores como densidad y puntos de fusión.

- Ingresar los datos en regression o predictive material models.

- Verificar las predicciones contra datos experimentales de aleaciones existentes.

- Contenido para Apps Educativas

Poblar tablas periódicas interactivas para estudiantes de química con datos revisados por pares.

- Extraer números atómicos, símbolos y descripciones de elementos.

- Obtener el contexto histórico y detalles del descubrimiento.

- Organizar los datos por grupo y bloque periódico.

- Integrar en una interfaz de usuario con estructuras cristalinas visuales.

- Análisis de Tendencias Químicas

Visualización de tendencias periódicas como la energía de ionización o el radio atómico a través de periodos y grupos.

- Recopilar datos de propiedades para cada elemento en orden numérico.

- Categorizar elementos en sus respectivos grupos.

- Usar librerías de gráficos para visualizar tendencias.

- Identificar y analizar puntos de datos anómalos en bloques específicos.

- Gestión de Inventario de Laboratorio

Población automática de sistemas de gestión química con datos de seguridad física y densidad.

- Mapear la lista de inventario interno con las entradas de WebElements.

- Extraer datos de densidad, riesgos de almacenamiento y puntos de fusión.

- Actualizar la base de datos centralizada del laboratorio vía API.

- Generar alertas de seguridad automatizadas para elementos de alto riesgo.

Potencia tu flujo de trabajo con Automatizacion IA

Automatio combina el poder de agentes de IA, automatizacion web e integraciones inteligentes para ayudarte a lograr mas en menos tiempo.

Consejos Pro para Scrapear WebElements

Consejos expertos para extraer datos exitosamente de WebElements.

Aprovechar patrones de URL predecibles

Los elementos siguen una estructura /element_name/ constante, lo que permite generar URLs de destino mediante programación para los 118 elementos en lugar de rastrear la página de inicio.

Identificar datos mediante selectores hermanos

Dado que el sitio carece de IDs de elementos únicos, identifique los puntos de datos localizando el texto de la celda de la etiqueta (por ejemplo, 'Melting point') y seleccionando el elemento 'td' hermano inmediatamente posterior.

Garantizar el soporte de UTF-8

Configure siempre su entorno de scraping en UTF-8 para capturar correctamente caracteres científicos como Å, ± y letras griegas comunes en la notación química.

Implementar retardos de rastreo

Al ser un recurso académico alojado por la University of Sheffield, la mejor práctica es seguir el retardo del robots.txt de 1 segundo para evitar la sobrecarga del servidor.

Apuntar a subpáginas granulares

Para obtener datos de alta precisión, como las vidas medias de isótopos específicos, realice el scraping de las subpáginas dedicadas /isotopes.html en lugar de las páginas de resumen para obtener una mejor exactitud.

Testimonios

Lo Que Dicen Nuestros Usuarios

Unete a miles de usuarios satisfechos que han transformado su flujo de trabajo

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Preguntas Frecuentes Sobre WebElements

Encuentra respuestas a preguntas comunes sobre WebElements