Як скрапити MakerWorld: дані 3D model та статистика дизайнерів

Дізнайтеся, як скрапити MakerWorld для отримання списків 3D model, кількості завантажень та статистики авторів. Ефективно витягуйте цінні тренди 3D-друку та...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- Цифровий відбиток браузера

- Ідентифікує ботів за характеристиками браузера: canvas, WebGL, шрифти, плагіни. Потребує підміни або реальних профілів браузера.

- Dynamic CSS Classes

- CAPTCHA

- Тест запит-відповідь для підтвердження, що користувач — людина. Може бути на основі зображень, тексту або невидимим. Часто потребує сторонніх сервісів розв'язання.

Про MakerWorld

Дізнайтеся, що пропонує MakerWorld та які цінні дані можна витягнути.

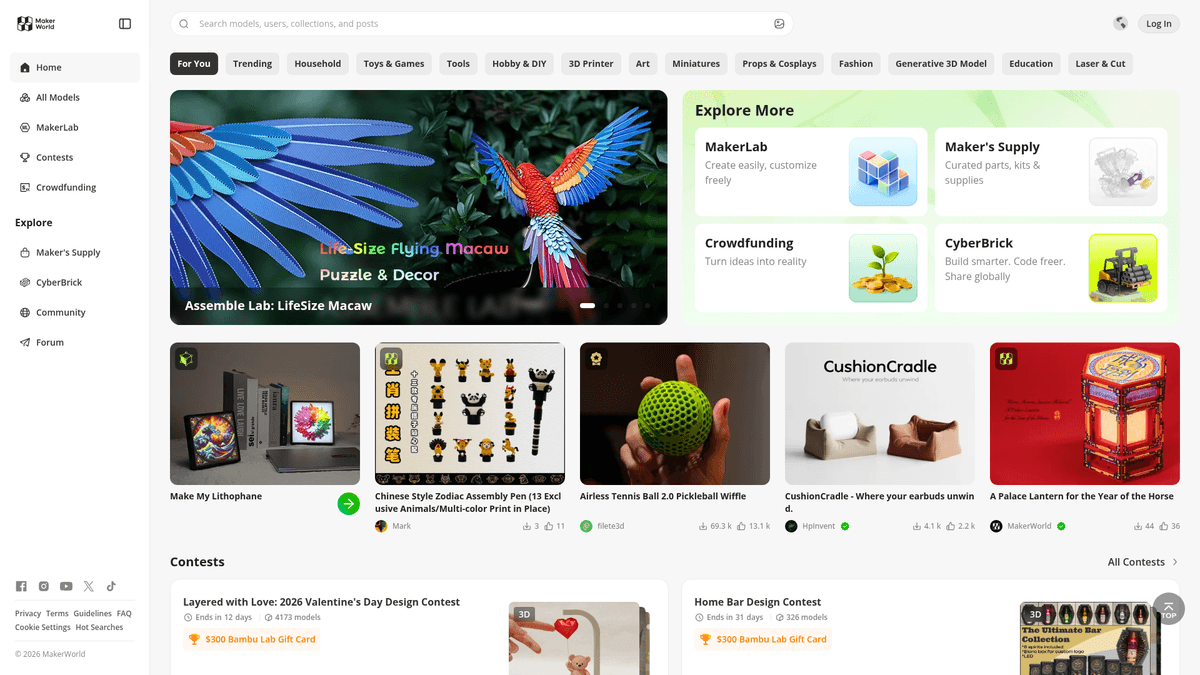

Провідний хаб для 3D-друку

MakerWorld — це комплексна платформа для обміну 3D model, розроблена Bambu Lab, призначена для безшовної інтеграції з їхньою екосистемою 3D-принтерів. На відміну від традиційних репозиторіїв, MakerWorld фокусується на досвіді друку «в один клік» завдяки інтеграції з Bambu Studio та Handy App, розміщуючи високоякісні 3D-файли (STLs, 3MFs) та детальні профілі друку.

Екосистема спільноти, багата на дані

Веб-сайт містить багато даних, включаючи назви model, детальні описи, кількість завантажень, лайків та інформацію про профілі авторів. Спільнота 3D-друку активно використовує його для пошуку нових проєктів та відстеження популярності різних дизайнів через соціальні метрики та рейтинги успішності друку. Платформа організовує контент у різноманітні категорії, такі як функціональні інструменти, декоративне мистецтво та механічні деталі.

Стратегічна бізнес-цінність

Скрапінг MakerWorld є цінним для дослідження ринку, визначення трендових категорій в адитивному виробництві та моніторингу результативності дизайнерів. Дані можна використовувати для агрегації 3D-активів, аналізу зростання екосистеми апаратного забезпечення з open-source та моніторингу конкурентних активів на ринку 3D-друку. Ця інформація допомагає бізнесу та дослідникам розуміти вподобання споживачів та технологічні тренди в 3D-моделюванні.

Чому Варто Парсити MakerWorld?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з MakerWorld.

Відстеження тенденцій ринку 3D-друку та популярних ніш у різних категоріях

Аналіз зростання авторів та метрик популярності дизайнерів для пошуку талантів

Агрегація метаданих для пошукових систем 3D model та управління активами

Моніторинг нових завантажень у конкретних категоріях, таких як функціональні або декоративні деталі

Конкурентний аналіз активів 3D-друку та результативності профілів друку

Дослідження використання філаменту та популярності матеріалів на основі відомих model

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу MakerWorld.

Значна залежність від JavaScript для рендерингу контенту (архітектура React SPA)

Складні CSS-селектори, що використовують динамічні імена класів Material UI

Агресивні механізми виявлення та блокування ботів Cloudflare

Динамічне завантаження контенту через нескінченне прокручування та кнопки 'Load More'

Обмеження частоти запитів (rate limiting) на високочастотні запити до профілів та API endpoints

Скрапінг MakerWorld за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з MakerWorld. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по MakerWorld, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг MakerWorld без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з MakerWorld. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по MakerWorld, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Обробка складних React-сторінок з рендерингом JavaScript без коду та налаштувань

- Автоматичне керування динамічними сітками списків та зображеннями з lazy-loading

- Запланований скрапінг для відстеження зростання кількості завантажень з часом без ручного втручання

- Автоматичний обхід виявлення браузера та нестабільності селекторів за допомогою вилучення на основі AI

- Прямий експорт у JSON, CSV або Google Sheets для негайного аналізу ринку

No-code веб-парсери для MakerWorld

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити MakerWorld без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для MakerWorld

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити MakerWorld без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

# Basic requests often fail on MakerWorld due to Cloudflare and React rendering

url = 'https://makerworld.com/en/models'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9'

}

try:

# This will likely return a Cloudflare challenge or a JS skeleton

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Note: Actual content won't be here as it requires JS rendering

print('Site reached, but content is dynamic.')

else:

print(f'Blocked by Cloudflare: HTTP {response.status_code}')

except Exception as e:

print(f'Error: {e}')Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити MakerWorld за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

# Basic requests often fail on MakerWorld due to Cloudflare and React rendering

url = 'https://makerworld.com/en/models'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9'

}

try:

# This will likely return a Cloudflare challenge or a JS skeleton

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Note: Actual content won't be here as it requires JS rendering

print('Site reached, but content is dynamic.')

else:

print(f'Blocked by Cloudflare: HTTP {response.status_code}')

except Exception as e:

print(f'Error: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_makerworld():

with sync_playwright() as p:

# Launching with stealth-like headers

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://makerworld.com/en/models', wait_until='networkidle')

# Wait for the model cards which are rendered via React

page.wait_for_selector("div[data-testid='model-card']")

models = page.query_selector_all("div[data-testid='model-card']")

for model in models:

# Using standard attributes often more stable than CSS classes

title = model.query_selector('h3').inner_text()

print(f'Model Found: {title}')

browser.close()

scrape_makerworld()Python + Scrapy

import scrapy

from scrapy_playwright.page import PageMethod

class MakerworldSpider(scrapy.Spider):

name = 'makerworld'

start_urls = ['https://makerworld.com/en/models']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(

url,

meta=dict(

playwright=True,

playwright_page_methods=[

PageMethod('wait_for_selector', "div[data-testid='model-card']"),

],

)

)

def parse(self, response):

# Scrapy-playwright allows parsing the JS-rendered HTML

for model in response.css("div[data-testid='model-card']"):

yield {

'title': model.css('h3::text').get(),

'downloads': model.css('span.stats-downloads::text').get(),

'link': response.urljoin(model.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0');

await page.goto('https://makerworld.com/en/models', { waitUntil: 'networkidle2' });

// Wait for the React component to mount

await page.waitForSelector("div[data-testid='model-card']");

const models = await page.evaluate(() => {

const cards = Array.from(document.querySelectorAll("div[data-testid='model-card']"));

return cards.map(card => ({

title: card.querySelector('h3')?.innerText,

link: card.querySelector('a')?.href

}));

});

console.log(models);

await browser.close();

})();Що Можна Робити З Даними MakerWorld

Досліджуйте практичні застосування та інсайти з даних MakerWorld.

Аналіз ринку 3D-друку

Аналізуйте, які типи model (функціональні чи декоративні) є найбільш популярними, щоб зрозуміти світовий ринковий попит.

Як реалізувати:

- 1Скрапінг топ-категорій для отримання метаданих model та кількості завантажень

- 2Агрегація метрик щотижня для відстеження темпів зростання з часом

- 3Візуалізація трендів для виявлення нових ніш у 3D-друці

Використовуйте Automatio для витягування даних з MakerWorld та створення цих додатків без написання коду.

Що Можна Робити З Даними MakerWorld

- Аналіз ринку 3D-друку

Аналізуйте, які типи model (функціональні чи декоративні) є найбільш популярними, щоб зрозуміти світовий ринковий попит.

- Скрапінг топ-категорій для отримання метаданих model та кількості завантажень

- Агрегація метрик щотижня для відстеження темпів зростання з часом

- Візуалізація трендів для виявлення нових ніш у 3D-друці

- Відстеження впливу авторів

Визначайте найбільш ефективних дизайнерів для пошуку талантів або можливостей спонсорства в індустрії апаратного забезпечення.

- Скрапінг сторінок профілів авторів для отримання загальної статистики завантажень та підписників

- Моніторинг частоти нових завантажень на кожного дизайнера щомісяця

- Ранжування авторів на основі співвідношення залученості до завантажень

- Прогнозування попиту на матеріали

Прогнозуйте попит на філамент, аналізуючи типи матеріалів, необхідних для популярних model на платформі.

- Вилучення 'Вимог до філаменту' з профілів друку model

- Підсумовування необхідних матеріалів для найбільш популярних model

- Аналіз найбільш затребуваних кольорів та типів філаменту (PLA, PETG тощо)

- Агрегатор пошуку 3D-активів

Створіть пошуковий індекс 3D model з декількох платформ, таких як MakerWorld, для легшого пошуку користувачами.

- Вилучення назв model, тегів та URL-адрес мініатюр із MakerWorld

- Індексація метаданих у централізованій базі даних із повнотекстовим пошуком

- Надання прямих посилань на оригінальні сторінки MakerWorld для трафіку

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу MakerWorld

Експертні поради для успішного витягування даних з MakerWorld.

Завжди використовуйте headless browser із плагіном 'Stealth' для обходу розширеного виявлення ботів Cloudflare.

Орієнтуйтеся на стабільні атрибути, такі як data-testid, а не на динамічні імена класів Material UI, які часто змінюються.

Впроваджуйте поведінку, що імітує людське прокручування, для ефективного запуску завантаження зображень із lazy-loaded та статистики.

Моніторьте вкладку Network на наявність внутрішніх JSON API endpoints, які можуть бути доступні з правильними заголовками та tokens.

Використовуйте високоякісні резидентні проксі, щоб уникнути блокування IP під час масштабного або багатопотокового вилучення даних.

Рандомізуйте затримки між запитами та діями, щоб імітувати поведінку реального користувача та залишатися непоміченим.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape American Museum of Natural History (AMNH)

Часті запитання про MakerWorld

Знайдіть відповіді на поширені запитання про MakerWorld