Як скрапити Pollen.com: посібник із витягування локальних даних про алергію

Дізнайтеся, як скрапити Pollen.com для отримання локальних прогнозів алергії, рівнів пилку та основних алергенів. Отримуйте щоденні дані для досліджень та...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- Блокування IP

- Блокує відомі IP дата-центрів та позначені адреси. Потребує резидентних або мобільних проксі для ефективного обходу.

- AngularJS Rendering

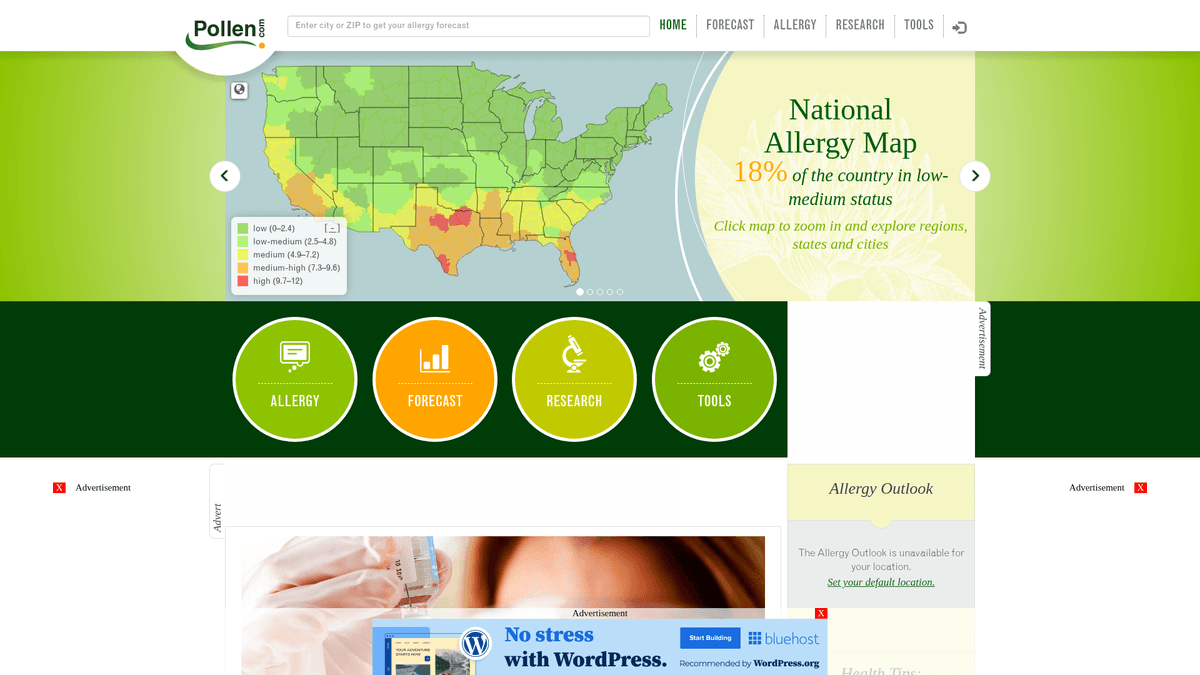

Про Pollen.com

Дізнайтеся, що пропонує Pollen.com та які цінні дані можна витягнути.

Комплексні дані про алергію в США

Pollen.com — це провідний портал про здоров'я та навколишнє середовище, що надає високоточну локальну інформацію про алергію та прогнози на всій території США. Платформа, якою володіє та керує IQVIA, провідна аналітична компанія у сфері охорони здоров'я, пропонує конкретні дані про кількість пилку та типи алергенів на основі ZIP-кодів. Це критично важливий ресурс для людей із сезонними респіраторними захворюваннями та медичних працівників, які відстежують екологічні тренди в охороні здоров'я.

Цінні дані для громадського здоров'я

Вебсайт містить структуровані дані, включаючи індекс пилку від 0 до 12, категорії основних алергенів, таких як дерева, бур'яни та трави, а також детальні 5-денні прогнози. Для розробників і дослідників ці дані дають уявлення про регіональні екологічні тригери та історичні патерни алергії, які важко зібрати із загальних сайтів погоди.

Бізнес та дослідницька корисність

Скрапінг Pollen.com корисний для створення додатків для моніторингу здоров'я, оптимізації ланцюжків постачання фармацевтичних препаратів проти алергії та проведення академічних досліджень щодо впливу кліматичних змін на цикли запилення. Автоматизуючи витягування цих даних, організації можуть надавати реальну користь алергікам по всій країні.

Чому Варто Парсити Pollen.com?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з Pollen.com.

Створення персоналізованих систем оповіщення про алергію для медичних додатків

Прогнозування трендів попиту на локальні ліки проти алергії

Проведення екологічних досліджень регіональних сезонів запилення

Агрегація гіперлокальних даних про здоров'я для новинних та погодних порталів

Аналіз історичних патернів алергії для міського планування охорони здоров'я

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу Pollen.com.

Динамічний рендеринг контенту за допомогою AngularJS потребує автоматизації браузера або headless-скраперів

Основні дані прогнозу завантажуються через асинхронні внутрішні виклики API, захищені сесією

Суворе обмеження частоти запитів (rate limiting) при повторюваних пошуках за ZIP-кодами може призвести до тимчасових IP-банів

Захист Cloudflare часто активує перевірки для User-Agent, що не належать браузерам

Скрапінг Pollen.com за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з Pollen.com. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по Pollen.com, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг Pollen.com без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з Pollen.com. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по Pollen.com, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Автоматичний рендеринг JavaScript обробляє складні дані графіків AngularJS без додаткового коду

- Вбудована ротація проксі успішно обходить захист Cloudflare та обмеження за IP-адресою

- Заплановані запуски дозволяють повністю автоматизувати щоденний збір даних за тисячами ZIP-кодів

- Інтерфейс без коду (no-code) дозволяє легко налаштувати витягування даних для конкретних географічних регіонів

No-code веб-парсери для Pollen.com

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Pollen.com без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для Pollen.com

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Pollen.com без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

# Примітка: Це захоплює статичні метадані новин.

# Основні дані прогнозу потребують рендерингу JavaScript або прямого доступу до внутрішнього API.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Витягування базових заголовків новин із бічної панелі

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'Останні новини про алергію: {news}')

except Exception as e:

print(f'Сталася помилка: {e}')Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити Pollen.com за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

# Примітка: Це захоплює статичні метадані новин.

# Основні дані прогнозу потребують рендерингу JavaScript або прямого доступу до внутрішнього API.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Витягування базових заголовків новин із бічної панелі

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'Останні новини про алергію: {news}')

except Exception as e:

print(f'Сталася помилка: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

browser = playwright.chromium.launch(headless=True)

page = browser.new_page()

# Перехід до прогнозу для конкретного ZIP-коду

page.goto('https://www.pollen.com/forecast/current/pollen/20001')

# Очікування, поки AngularJS відрендерить динамічний індекс пилку

page.wait_for_selector('.forecast-level')

data = {

'pollen_index': page.inner_text('.forecast-level'),

'status': page.inner_text('.forecast-level-desc'),

'allergens': [el.inner_text() for el in page.query_selector_all('.top-allergen-item span')]

}

print(f'Дані для 20001: {data}')

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class PollenSpider(scrapy.Spider):

name = 'pollen_spider'

start_urls = ['https://www.pollen.com/forecast/current/pollen/20001']

def parse(self, response):

# Для динамічного контенту використовуйте Scrapy-Playwright або подібне middleware

# Цей стандартний метод parse обробляє статичні елементи, як-от заголовки

yield {

'url': response.url,

'page_title': response.css('title::text').get(),

'news_headlines': response.css('article h2 a::text').getall()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Встановлення User-Agent для імітації справжнього браузера

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64)');

await page.goto('https://www.pollen.com/forecast/current/pollen/20001');

// Очікування появи динамічного рівня прогнозу

await page.waitForSelector('.forecast-level');

const data = await page.evaluate(() => ({

pollenIndex: document.querySelector('.forecast-level')?.innerText,

description: document.querySelector('.forecast-level-desc')?.innerText,

location: document.querySelector('h1')?.innerText

}));

console.log(data);

await browser.close();

})();Що Можна Робити З Даними Pollen.com

Досліджуйте практичні застосування та інсайти з даних Pollen.com.

Персоналізовані сповіщення про алергію

Мобільні додатки для здоров'я можуть надавати користувачам сповіщення в реальному часі, коли рівень пилку в їхній місцевості досягає високих показників.

Як реалізувати:

- 1Скрапінг щоденних прогнозів для ZIP-кодів користувачів

- 2Визначення моментів, коли індекс пилку перевищує поріг «Високий» (7.3+)

- 3Надсилання автоматичних push-сповіщень або SMS-повідомлень користувачеві

Використовуйте Automatio для витягування даних з Pollen.com та створення цих додатків без написання коду.

Що Можна Робити З Даними Pollen.com

- Персоналізовані сповіщення про алергію

Мобільні додатки для здоров'я можуть надавати користувачам сповіщення в реальному часі, коли рівень пилку в їхній місцевості досягає високих показників.

- Скрапінг щоденних прогнозів для ZIP-кодів користувачів

- Визначення моментів, коли індекс пилку перевищує поріг «Високий» (7.3+)

- Надсилання автоматичних push-сповіщень або SMS-повідомлень користувачеві

- Прогнозування попиту на ліки

Фармацевтичні рітейлери можуть оптимізувати рівень запасів, зіставляючи локальні сплески пилку з прогнозованим попитом на антигістамінні препарати.

- Витягування даних 5-денного прогнозу в основних мегаполісах

- Ідентифікація майбутніх періодів високої активності алергенів

- Координація розподілу запасів у місцеві аптеки до настання піку

- Екологічний скоринг нерухомості

Сайти з оголошеннями про нерухомість можуть додавати «Рейтинг алергії», щоб допомогти чутливим покупцям оцінити якість повітря в районі.

- Агрегація історичних даних про пилок для конкретних районів міста

- Розрахунок середньорічного показника інтенсивності пилку

- Відображення показника як додаткової характеристики на сторінці об'єкта нерухомості

- Дослідження змін клімату

Екологи можуть відстежувати тривалість та інтенсивність сезонів запилення з часом, щоб вивчати вплив клімату.

- Щоденний скрапінг видів та індексів пилку протягом весняного та осіннього сезонів

- Порівняння дат початку та закінчення запилення з історичними середніми показниками

- Аналіз даних на предмет трендів, що вказують на довші або інтенсивніші сезони алергії

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу Pollen.com

Експертні поради для успішного витягування даних з Pollen.com.

Орієнтуйтеся на внутрішні API-ендпоінти, знайдені в мережевому трафіку, для прямого доступу до даних у форматі JSON.

Використовуйте резидентні проксі для ротації вашої IP-адреси, щоб уникнути спрацьовування захисту Cloudflare.

Скрапте дані щодня рано вранці (близько 7

00 за східним часом), щоб отримати найсвіжіші оновлення прогнозів.

Переконайтеся, що ваш скрапер виконує JavaScript, оскільки Pollen.com використовує AngularJS для відображення значень індексів.

Впроваджуйте випадкову затримку (sleep) від 3 до 10 секунд між запитами для різних ZIP-кодів.

Регулярно моніторте структуру сайту, оскільки назви класів AngularJS можуть змінюватися під час оновлень.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape American Museum of Natural History (AMNH)

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Poll-Maker: A Comprehensive Web Scraping Guide

Часті запитання про Pollen.com

Знайдіть відповіді на поширені запитання про Pollen.com