Як скрапити SeLoger Bureaux & Commerces

Дізнайтеся, як скрапити SeLoger Bureaux & Commerces для отримання даних про комерційну нерухомість. Витягуйте ціни, площі та інформацію про агентства, обходячи...

Виявлено захист від ботів

- DataDome

- Виявлення ботів у реальному часі з ML-моделями. Аналізує цифровий відбиток пристрою, мережеві сигнали та патерни поведінки. Поширений на сайтах електронної комерції.

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- Google reCAPTCHA

- Система CAPTCHA від Google. v2 потребує взаємодії користувача, v3 працює приховано з оцінкою ризиків. Можна вирішити за допомогою сервісів CAPTCHA.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- Блокування IP

- Блокує відомі IP дата-центрів та позначені адреси. Потребує резидентних або мобільних проксі для ефективного обходу.

- Цифровий відбиток браузера

- Ідентифікує ботів за характеристиками браузера: canvas, WebGL, шрифти, плагіни. Потребує підміни або реальних профілів браузера.

Про SeLoger Bureaux & Commerces

Дізнайтеся, що пропонує SeLoger Bureaux & Commerces та які цінні дані можна витягнути.

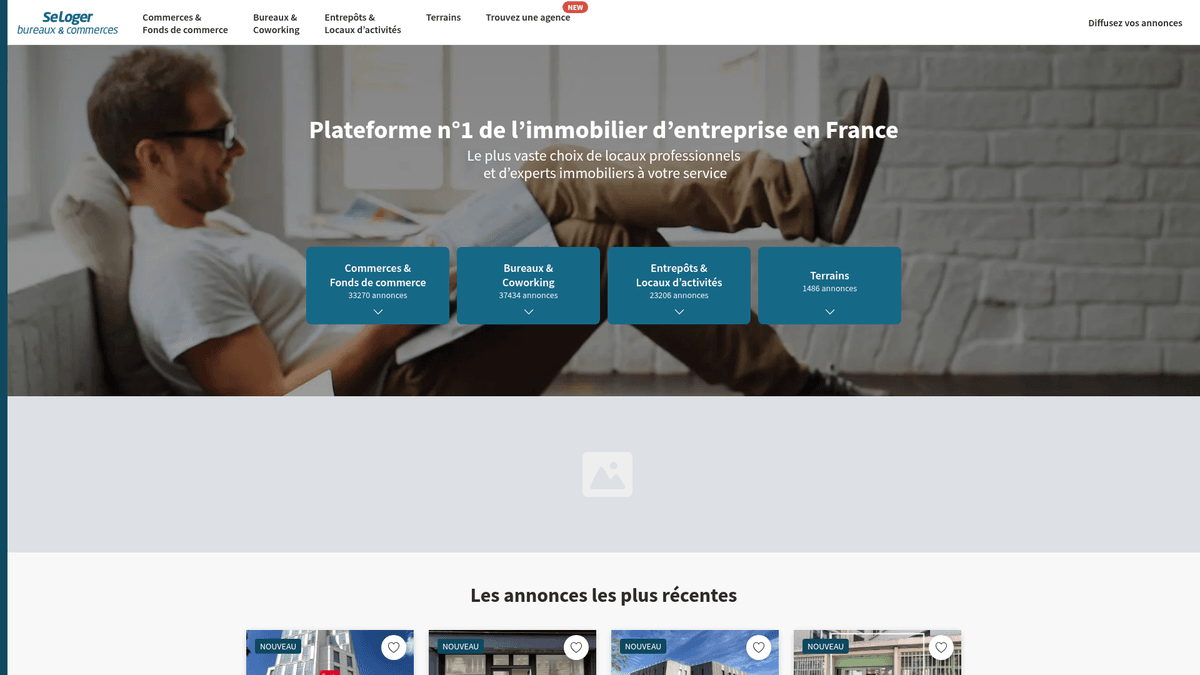

Лідер на ринку комерційної нерухомості Франції

SeLoger Bureaux & Commerces — це спеціалізований портал професійної нерухомості групи SeLoger, провідної мережі з нерухомості у Франції. Він виступає як виділений маркетплейс для B2B транзакцій, представляючи офісні приміщення, склади, торгові площі та земельні ділянки для комерційної забудови. Платформу використовують великі національні агентства та незалежні брокери для зв'язку з професійними інвесторами та власниками бізнесу по всій країні.

Цінність даних

Скрапінг цього вебсайту має велике значення для інвесторів у нерухомість та ринкових аналітиків, яким необхідно моніторити ландшафт комерційної нерухомості Франції. Витягуючи актуальні дані про оголошення, компанії можуть відстежувати тенденції ціни за квадратний метр, виявляти нові комерційні хаби та моніторити портфелі конкурентних агентств. Ці дані є важливими для проведення точної оцінки майна та виявлення високоприбуткових інвестиційних можливостей на французькому ринку.

Чому Варто Парсити SeLoger Bureaux & Commerces?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з SeLoger Bureaux & Commerces.

Проведення досліджень ринку нерухомості Франції та аналіз комерційних трендів.

Автоматизація моніторингу цін на інвестиційну нерухомість у різних департаментах.

Генерація лідів для постачальників B2B послуг, таких як мувінгові компанії або постачальники меблів.

Збір конкурентної розвідки щодо охоплення ринку порталами та портфелів агентств.

Збір історичних даних для побудови моделей автоматизованої оцінки нерухомості.

Моніторинг нових можливостей для роздрібної торгівлі при плануванні розширення бізнесу.

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу SeLoger Bureaux & Commerces.

Агресивний захист DataDome, який виявляє та блокує стандартні headless браузери.

Значні юридичні ризики, пов'язані з комерційним використанням даних на основі минулих прецедентів.

Необхідність використання складних методів імітації TLS та JA3 fingerprint.

Часті зміни структури DOM фронтенду, що порушує роботу статичних CSS-селекторів.

Суворе обмеження частоти запитів та автоматичне внесення IP до чорного списку за високу інтенсивність звернень.

Скрапінг SeLoger Bureaux & Commerces за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з SeLoger Bureaux & Commerces. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по SeLoger Bureaux & Commerces, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг SeLoger Bureaux & Commerces без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з SeLoger Bureaux & Commerces. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по SeLoger Bureaux & Commerces, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Автоматично обробляє складні анти-бот системи, такі як DataDome та Cloudflare.

- Не потребує програмування для налаштування потоків вилучення даних для будь-якої категорії.

- Запускається у хмарі з розширеним плануванням для щоденного відстеження нових оголошень.

- Долає труднощі рендерингу JavaScript без ручного налаштування браузера.

- Експортує структуровані дані безпосередньо в Google Sheets, CSV або через Webhooks.

No-code веб-парсери для SeLoger Bureaux & Commerces

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити SeLoger Bureaux & Commerces без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для SeLoger Bureaux & Commerces

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити SeLoger Bureaux & Commerces без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

# Примітка: SeLoger використовує DataDome; стандартні requests, ймовірно, будуть заблоковані.

# Рекомендуються спеціалізовані бібліотеки типу curl_cffi для TLS fingerprinting.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Використання impersonate для обходу блокувань TLS fingerprinting

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Приклад селектора для назв об'єктів

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Оголошення: {title.get_text(strip=True)}')

else:

print(f'Заблоковано анти-ботом. Статус-код: {response.status_code}')

except Exception as e:

print(f'Виникла помилка: {e}')Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити SeLoger Bureaux & Commerces за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

# Примітка: SeLoger використовує DataDome; стандартні requests, ймовірно, будуть заблоковані.

# Рекомендуються спеціалізовані бібліотеки типу curl_cffi для TLS fingerprinting.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Використання impersonate для обходу блокувань TLS fingerprinting

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Приклад селектора для назв об'єктів

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Оголошення: {title.get_text(strip=True)}')

else:

print(f'Заблоковано анти-ботом. Статус-код: {response.status_code}')

except Exception as e:

print(f'Виникла помилка: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_bucom():

async with async_playwright() as p:

# Headless=False допомагає уникнути деяких базових тригерів виявлення ботів

browser = await p.chromium.launch(headless=False)

context = await browser.new_context(

user_agent='Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36'

)

page = await context.new_page()

try:

# Обираємо конкретну комерційну категорію та місто

await page.goto('https://www.seloger-bureaux-commerces.com/achat/bureau/lyon', wait_until='networkidle')

# Чекаємо на рендеринг карток оголошень

await page.wait_for_selector('div[data-testid="listing-card"]', timeout=15000)

listings = await page.query_selector_all('div[data-testid="listing-card"]')

for card in listings:

title = await card.query_selector('h2')

price = await card.query_selector('span[class*="Price"]')

print(f"Назва: {await title.inner_text()} | Ціна: {await price.inner_text()}")

except Exception as e:

print(f'Скрапінг не вдався: {e}')

finally:

await browser.close()

asyncio.run(scrape_bucom())Python + Scrapy

import scrapy

class SeLogerBucomSpider(scrapy.Spider):

name = 'bucom_spider'

allowed_domains = ['seloger-bureaux-commerces.com']

start_urls = ['https://www.seloger-bureaux-commerces.com/location/boutique']

custom_settings = {

'DOWNLOAD_DELAY': 5,

'RANDOMIZE_DOWNLOAD_DELAY': True,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'COOKIES_ENABLED': True

}

def parse(self, response):

# Витягуємо дані з контейнера результатів оголошень

for listing in response.css('div[class*="Card_container"]'):

yield {

'title': listing.css('h2::text').get(),

'price': listing.css('span[class*="Price"]::text').get(),

'surface': listing.css('span[class*="Surface"]::text').get(),

'link': listing.css('a::attr(href)').get()

}

# Проста обробка пагінації

next_page = response.css('a[class*="PaginationNext"]::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer-extra');

const StealthPlugin = require('puppeteer-extra-plugin-stealth');

puppeteer.use(StealthPlugin());

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Імітуємо поведінку людини за допомогою viewport та агента

await page.setViewport({ width: 1280, height: 800 });

try {

await page.goto('https://www.seloger-bureaux-commerces.com/location/bureau/paris', {

waitUntil: 'networkidle2'

});

const results = await page.evaluate(() => {

return Array.from(document.querySelectorAll('a[class*="Card_title"]')).map(el => ({

title: el.innerText,

url: el.href

}));

});

console.log(results);

} catch (err) {

console.error('Помилка витягування:', err);

} finally {

await browser.close();

}

})();Що Можна Робити З Даними SeLoger Bureaux & Commerces

Досліджуйте практичні застосування та інсайти з даних SeLoger Bureaux & Commerces.

Індекс цін на оренду комерційної нерухомості

Створення еталону для комерційної оренди в різних департаментах Франції для оцінки вартості майна.

Як реалізувати:

- 1Щомісячний скрапінг усіх активних оголошень у цільових регіонах.

- 2Очищення та нормалізація даних про ціну та площу до єдиних одиниць виміру.

- 3Агрегація середньої ціни за квадратний метр за містами та типами нерухомості.

- 4Візуалізація трендів у BI інструментах, таких як Tableau або PowerBI.

Використовуйте Automatio для витягування даних з SeLoger Bureaux & Commerces та створення цих додатків без написання коду.

Що Можна Робити З Даними SeLoger Bureaux & Commerces

- Індекс цін на оренду комерційної нерухомості

Створення еталону для комерційної оренди в різних департаментах Франції для оцінки вартості майна.

- Щомісячний скрапінг усіх активних оголошень у цільових регіонах.

- Очищення та нормалізація даних про ціну та площу до єдиних одиниць виміру.

- Агрегація середньої ціни за квадратний метр за містами та типами нерухомості.

- Візуалізація трендів у BI інструментах, таких як Tableau або PowerBI.

- Моніторинг конкуруючих агентств

Відстеження інвентарю та ефективності роботи конкуруючих агентств нерухомості на французькому ринку.

- Витяг імен агентів/агентств та референтних номерів об'єктів.

- Визначення тривалості перебування об'єктів у списку до їх видалення.

- Аналіз частки ринку конкретних агентств у престижних районах.

- Створення звітів про цінові стратегії конкурентів.

- Генерація B2B лідів для релокації

Виявлення компаній, які, ймовірно, планують переїзд або розширення у нові офісні приміщення.

- Фільтрація оголошень з позначкою 'Нове' або 'Доступно негайно'.

- Моніторинг конкретних офісних будівель для відстеження моменту звільнення приміщень орендарями.

- Зіставлення отриманих адрес із базами даних реєстрації компаній.

- Зв'язок із компаніями, що переїжджають, із персоналізованими пропозиціями послуг.

- Пошук інвестиційного арбітражу

Автоматичне виявлення об'єктів, виставлених за ціною, значно нижчою за середньоринкову в даному регіоні.

- Встановлення базових середніх показників на основі історичних даних скрапінгу за 6 місяців.

- Налаштування щоденного скрапера для нових комерційних оголошень.

- Розрахунок ціни за кв.м для кожного нового оголошення та порівняння з базовим рівнем.

- Запуск миттєвого сповіщення електронною поштою для оголошень, ціна яких на 20% нижча за середню.

- Планування розширення роздрібної мережі

Пошук ідеального місця для нових торгових точок на основі доступності та вартості оренди в районі.

- Скрапінг доступності торгових точок (бутиків) у центрах кількох міст.

- Картографування щільності доступних комерційних площ за допомогою GPS-даних.

- Аналіз кореляції між показниками пішохідного трафіку та вартістю оренди.

- Експорт результатів у GIS систему для просторового аналізу.

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу SeLoger Bureaux & Commerces

Експертні поради для успішного витягування даних з SeLoger Bureaux & Commerces.

Використовуйте високонадійні французькі residential проксі, щоб змішатися з легітимним місцевим трафіком.

Розділяйте пошукові запити за конкретними поштовими індексами (наприклад, 75001, 75008), щоб обійти ліміт у 1000 видимих результатів.

Регулярно змінюйте TLS fingerprints та заголовки браузера, щоб уникнути JA3 виявлення системою DataDome.

Впроваджуйте випадкові затримки, імітуючи поведінку людини (3-10 секунд), та рухи миші між взаємодіями зі сторінкою.

Відстежуйте вкладку мережі (network tab) на предмет викликів 'next/data' API; вони часто містять чисті JSON об'єкти з деталями нерухомості.

Завжди включайте заголовок Referer, що вказує на головну сторінку SeLoger, при виконанні запитів за прямими посиланнями.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Часті запитання про SeLoger Bureaux & Commerces

Знайдіть відповіді на поширені запитання про SeLoger Bureaux & Commerces