Як парсити We Work Remotely: повний посібник

Дізнайтеся, як збирати вакансії з We Work Remotely. Отримуйте назви посад, дані про компанії, зарплати та іншу інформацію для аналізу ринку або власних...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- Блокування IP

- Блокує відомі IP дата-центрів та позначені адреси. Потребує резидентних або мобільних проксі для ефективного обходу.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

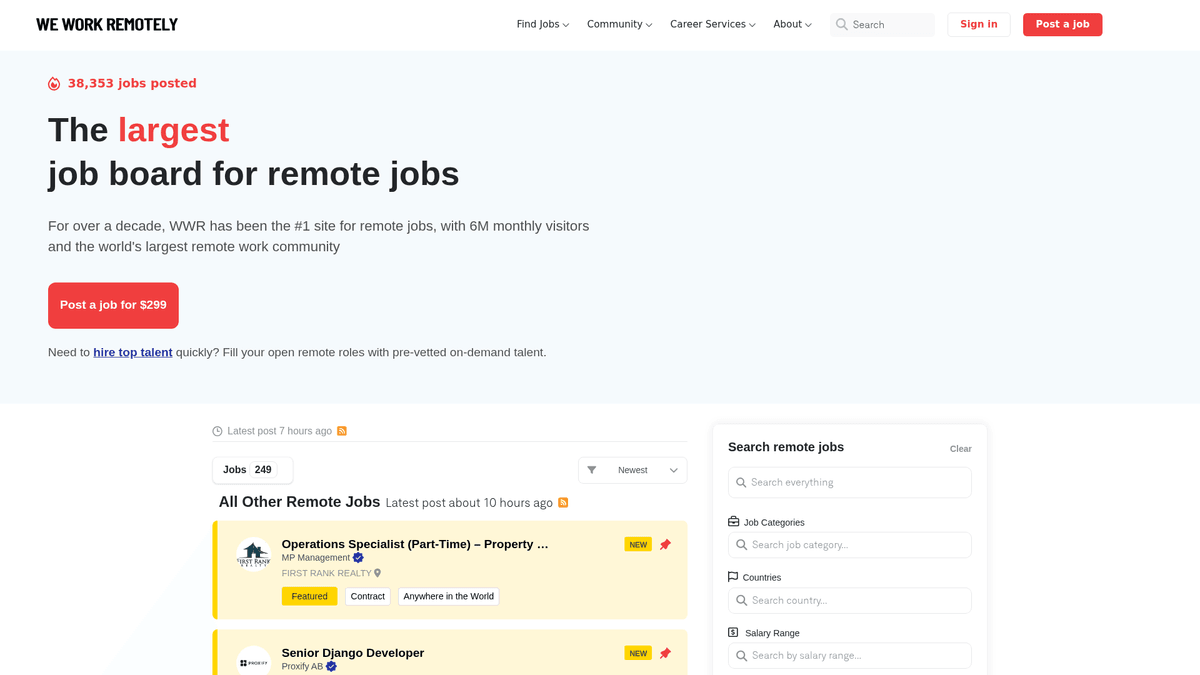

Про We Work Remotely

Дізнайтеся, що пропонує We Work Remotely та які цінні дані можна витягнути.

Центр глобальних талантів для віддаленої роботи

We Work Remotely (WWR) — це найстаріша та найбільша спільнота віддаленої роботи у світі, яку щомісяця відвідують понад 6 мільйонів користувачів. Платформа є основним майданчиком для компаній, що відмовляються від традиційних офісних моделей, пропонуючи вакансії у сферах розробки ПЗ, дизайну, маркетингу та клієнтської підтримки.

Високоякісні структуровані дані

Платформа відома своїми чітко структурованими даними. Кожне оголошення зазвичай містить вимоги до регіону, діапазони зарплат та детальні профілі компаній. Така структура робить сайт ідеальним об'єктом для веб-скрейпінгу, оскільки дані є послідовними та легкими для категоризації.

Стратегічна цінність для аналітиків даних

Для рекрутерів та дослідників ринку WWR є справжнім скарбом. Парсинг цього сайту дозволяє в реальному часі відстежувати тренди найму, проводити benchmark заробітних плат у різних технічних секторах та генерувати ліди для B2B-сервісів, орієнтованих на remote-first компанії. Це забезпечує прозорий погляд на глобальний ринок дистанційної праці.

Чому Варто Парсити We Work Remotely?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з We Work Remotely.

Створення нішевого порталу або агрегатора віддалених вакансій

Проведення конкурентного аналізу зарплат у різних галузях

Пошук компаній, що активно наймають персонал на віддалену роботу

Моніторинг глобального попиту на конкретні технічні навички

Генерація лідів для постачальників HR-технологій та сервісів

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу We Work Remotely.

Спрацювання захисту Cloudflare від ботів

Обробка невідповідностей у тегах локацій

Парсинг різноманітних форматів зарплат в описах

Управління лімітами IP під час масового збору даних зі сторінок вакансій

Скрапінг We Work Remotely за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з We Work Remotely. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по We Work Remotely, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг We Work Remotely без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з We Work Remotely. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по We Work Remotely, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Налаштування парсингу без коду через візуальний інтерфейс

- Автоматична обробка анти-бот систем та проксі

- Запуск за розкладом для оновлення списків вакансій у реальному часі

- Прямий експорт у JSON, CSV або Google Sheets

- Виконання у хмарі без використання локальних ресурсів

No-code веб-парсери для We Work Remotely

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити We Work Remotely без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для We Work Remotely

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити We Work Remotely без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Надсилання запиту з кастомними заголовками

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Пошук списків вакансій

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Job: {title} | Company: {company}')

except Exception as e:

print(f'Error: {e}')Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити We Work Remotely за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Надсилання запиту з кастомними заголовками

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Пошук списків вакансій

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Job: {title} | Company: {company}')

except Exception as e:

print(f'Error: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def run():

async with async_playwright() as p:

# Запуск браузера у headless режимі

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

await page.goto('https://weworkremotely.com/')

# Очікування завантаження основного контейнера

await page.wait_for_selector('.jobs-container')

jobs = await page.query_selector_all('li.feature')

for job in jobs:

title = await job.query_selector('.title')

if title:

print(await title.inner_text())

await browser.close()

asyncio.run(run())Python + Scrapy

import scrapy

class WwrSpider(scrapy.Spider):

name = 'wwr_spider'

start_urls = ['https://weworkremotely.com/']

def parse(self, response):

# Ітерація по елементах списку вакансій

for job in response.css('li.feature'):

yield {

'title': job.css('span.title::text').get(),

'company': job.css('span.company::text').get(),

'url': response.urljoin(job.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://weworkremotely.com/');

// Вилучення даних за допомогою evaluate

const jobs = await page.evaluate(() => {

return Array.from(document.querySelectorAll('li.feature')).map(li => ({

title: li.querySelector('.title')?.innerText.trim(),

company: li.querySelector('.company')?.innerText.trim()

}));

});

console.log(jobs);

await browser.close();

})();Що Можна Робити З Даними We Work Remotely

Досліджуйте практичні застосування та інсайти з даних We Work Remotely.

Агрегатор віддалених вакансій

Створення спеціалізованої платформи для пошуку роботи у вузьких нішах, як-от Rust або AI.

Як реалізувати:

- 1Щоденний парсинг WWR для пошуку нових оголошень

- 2Фільтрація за ключовими словами та категоріями

- 3Збереження даних у базі з можливістю пошуку

- 4Автоматизація публікацій нових вакансій у соцмережах

Використовуйте Automatio для витягування даних з We Work Remotely та створення цих додатків без написання коду.

Що Можна Робити З Даними We Work Remotely

- Агрегатор віддалених вакансій

Створення спеціалізованої платформи для пошуку роботи у вузьких нішах, як-от Rust або AI.

- Щоденний парсинг WWR для пошуку нових оголошень

- Фільтрація за ключовими словами та категоріями

- Збереження даних у базі з можливістю пошуку

- Автоматизація публікацій нових вакансій у соцмережах

- Аналіз трендів заробітних плат

Аналіз даних про зарплати на віддаленій роботі для визначення глобальних стандартів компенсації.

- Вилучення даних про зарплату з описів вакансій

- Нормалізація даних до єдиної валюти

- Сегментація за ролями та рівнем досвіду

- Підготовка щоквартальних звітів по ринку

- Генерація лідів для HR Tech

Пошук компаній, що активно розширюють віддалені команди, для продажу ПЗ для HR, розрахунку зарплат та управління пільгами.

- Моніторинг списку 'Top 100 Remote Companies'

- Відстеження частоти появи нових вакансій

- Пошук осіб, що приймають рішення в компаніях

- Персоналізовані B2B-пропозиції

- Історичні тренди найму

Аналіз довгострокових даних для розуміння того, як попит на віддалену роботу змінюється сезонно або економічно.

- Архівування оголошень протягом 12+ місяців

- Розрахунок темпів зростання за категоріями

- Візуалізація трендів за допомогою BI-інструментів

- Прогнозування попиту на певні навички

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу We Work Remotely

Експертні поради для успішного витягування даних з We Work Remotely.

Використовуйте endpoint /remote-jobs.rss для отримання чистішого XML-фіду, який легко зчитується програмами та дозволяє уникнути складного парсингу HTML.

Використовуйте ротацію резидентних проксі, щоб обійти захисні екрани Cloudflare та уникнути постійних банів за IP під час інтенсивного збору даних.

Впроваджуйте рандомізовані затримки між запитами, щоб імітувати поведінку реального користувача та уникати лімітів (rate limits).

Нормалізуйте дані про місцезнаходження

наприклад, змінюйте 'Anywhere' на 'Global' або 'Remote' для більш точної фільтрації у вашій базі даних.

Вказуйте у заголовках User-Agent рядок популярного браузера, щоб сайт не ідентифікував ваш запит як простий скрипт-скрейпер.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape Freelancer.com: A Complete Technical Guide

How to Scrape Upwork: A Comprehensive Technical Guide

How to Scrape Arc.dev: The Complete Guide to Remote Job Data

How to Scrape Toptal | Toptal Web Scraper Guide

How to Scrape Guru.com: A Comprehensive Web Scraping Guide

How to Scrape Fiverr | Fiverr Web Scraper Guide

How to Scrape Indeed: 2025 Guide for Job Market Data

How to Scrape Charter Global | IT Services & Job Board Scraper

Часті запитання про We Work Remotely

Знайдіть відповіді на поширені запитання про We Work Remotely