Як скрапити WebElements: Посібник із даних періодичної таблиці

Витягуйте точні дані про хімічні елементи з WebElements. Скрапте атомні ваги, фізичні властивості та історію відкриттів для досліджень та AI-застосунків.

Про WebElements

Дізнайтеся, що пропонує WebElements та які цінні дані можна витягнути.

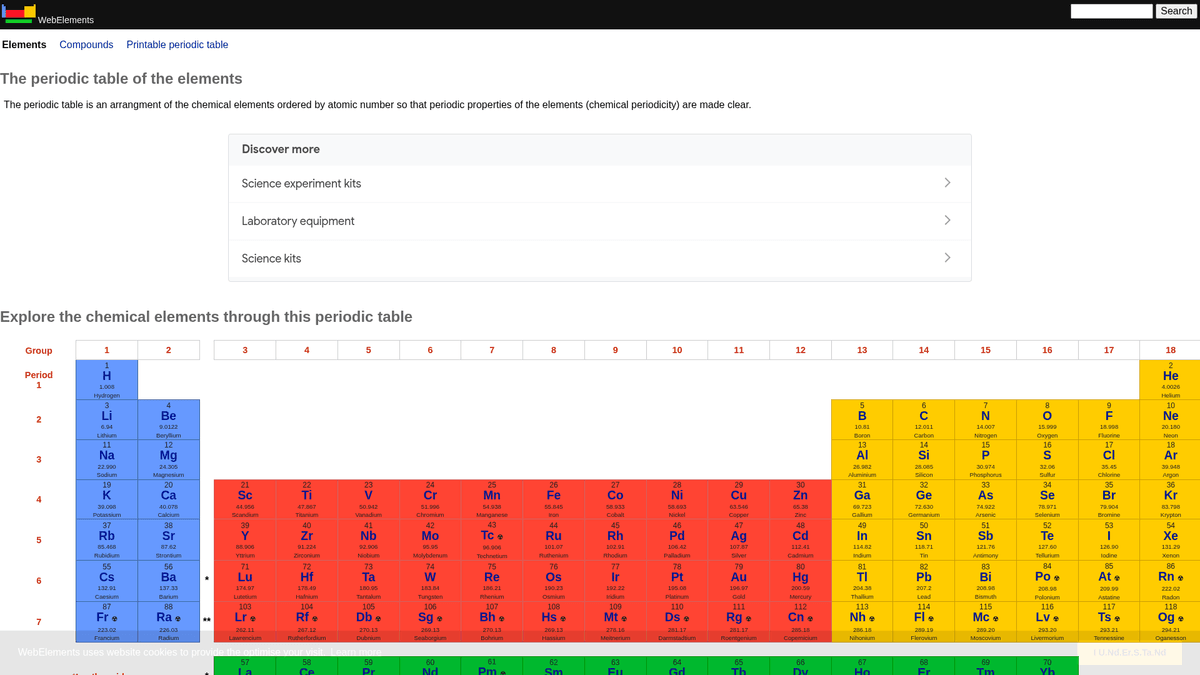

WebElements — це провідна онлайн-періодична таблиця, яку підтримує Марк Вінтер з Університету Шеффілда. Запущена в 1993 році, вона стала першою періодичною таблицею у Всесвітній павутині і відтоді перетворилася на авторитетний ресурс для студентів, науковців та професійних хіміків. Сайт пропонує глибокі структуровані дані про кожен відомий хімічний елемент: від стандартних атомних ваг до складних електронних конфігурацій.

Цінність скрапінгу WebElements полягає у високоякісних, рецензованих наукових даних. Для розробників освітніх інструментів, дослідників, що проводять аналіз тенденцій у періодичній таблиці, або матеріалознавців, які навчають machine learning model, WebElements є надійним і технічно багатим джерелом істини, яке важко зібрати вручну.

Чому Варто Парсити WebElements?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з WebElements.

Збір високоякісних наукових даних для розробки освітніх інструментів.

Агрегація властивостей елементів для досліджень у матеріалознавстві та machine learning model.

Автоматичне наповнення систем інвентаризації лабораторій хімічними характеристиками.

Історичний аналіз відкриттів елементів та наукового прогресу.

Створення комплексних наборів даних про хімічні властивості для академічних публікацій.

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу WebElements.

Дані розподілені за кількома підсторінками для кожного елемента (наприклад, /history, /compounds).

Застарілі макети HTML на основі таблиць вимагають точної логіки вибору селекторів.

Плутанина в назві домену з класом Selenium 'WebElement' під час пошуку технічної підтримки.

Скрапінг WebElements за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з WebElements. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по WebElements, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг WebElements без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з WebElements. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по WebElements, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Навігація за ієрархічними структурами елементів без коду.

- Автоматична обробка вилучення складних наукових таблиць.

- Хмарне виконання дозволяє витягувати повні набори даних без простою локального обладнання.

- Легкий експорт у CSV/JSON для безпосереднього використання в інструментах наукового аналізу.

- Запланований моніторинг може виявляти оновлення підтверджених даних про елементи.

No-code веб-парсери для WebElements

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити WebElements без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для WebElements

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити WebElements без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

import time

# Цільова URL-адреса для конкретного елемента (наприклад, золото)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Витягнення назви елемента з тегу H1

name = soup.find('h1').get_text().strip()

# Витягнення атомного номера за допомогою логіки міток таблиці

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Елемент: {name}, Атомний номер: {atomic_number}')

except Exception as e:

print(f'Сталася помилка: {e}')

# Дотримання рекомендацій robots.txt

time.sleep(1)

scrape_element(url)Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити WebElements за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# Цільова URL-адреса для конкретного елемента (наприклад, золото)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Витягнення назви елемента з тегу H1

name = soup.find('h1').get_text().strip()

# Витягнення атомного номера за допомогою логіки міток таблиці

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Елемент: {name}, Атомний номер: {atomic_number}')

except Exception as e:

print(f'Сталася помилка: {e}')

# Дотримання рекомендацій robots.txt

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Елементи доступні за посиланнями з головної періодичної таблиці

page.goto('https://www.webelements.com/iron/')

# Очікування появи таблиці властивостей

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Перехід за кожним посиланням на елемент у періодичній таблиці

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Extracted Data:', data);

await browser.close();

})();Що Можна Робити З Даними WebElements

Досліджуйте практичні застосування та інсайти з даних WebElements.

Навчання AI для матеріалознавства

Навчання machine learning model для прогнозування властивостей нових сплавів на основі характеристик елементів.

Як реалізувати:

- 1Витягніть фізичні властивості для всіх металевих елементів.

- 2Очистіть та нормалізуйте значення, такі як щільність і точки плавлення.

- 3Введіть дані в регресійні або прогнозні матеріалознавчі model.

- 4Перевірте прогнози на основі існуючих експериментальних даних про сплави.

Використовуйте Automatio для витягування даних з WebElements та створення цих додатків без написання коду.

Що Можна Робити З Даними WebElements

- Навчання AI для матеріалознавства

Навчання machine learning model для прогнозування властивостей нових сплавів на основі характеристик елементів.

- Витягніть фізичні властивості для всіх металевих елементів.

- Очистіть та нормалізуйте значення, такі як щільність і точки плавлення.

- Введіть дані в регресійні або прогнозні матеріалознавчі model.

- Перевірте прогнози на основі існуючих експериментальних даних про сплави.

- Контент для освітніх додатків

Наповнення інтерактивних періодичних таблиць для студентів-хіміків рецензованими даними.

- Зберіть атомні номери, символи та описи елементів.

- Витягніть історичний контекст та деталі відкриття.

- Організуйте дані за періодичними групами та блоками.

- Інтегруйте в інтерфейс користувача з візуалізацією кристалічних структур.

- Аналіз хімічних закономірностей

Візуалізація періодичних тенденцій, таких як енергія іонізації або атомний радіус, у періодах і групах.

- Зберіть дані про властивості кожного елемента в числовому порядку.

- Класифікуйте елементи за відповідними групами.

- Використовуйте бібліотеки для побудови графіків, щоб візуалізувати закономірності.

- Ідентифікуйте та аналізуйте аномальні точки даних у конкретних блоках.

- Управління лабораторними запасами

Автоматичне наповнення систем управління хімічними речовинами даними про фізичну безпеку та щільність.

- Зіставте внутрішній інвентарний список із записами WebElements.

- Скрапте дані про щільність, небезпеку зберігання та точку плавлення.

- Оновіть централізовану лабораторну базу даних через API.

- Генеруйте автоматичні попередження з безпеки для елементів високого ризику.

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу WebElements

Експертні поради для успішного витягування даних з WebElements.

Дотримуйтесь Crawl-delay

1, зазначеного у файлі robots.txt сайту.

Використовуйте Атомний номер як первинний ключ для узгодженості бази даних.

Скрапте підсторінки «history» та «compounds» для отримання повного набору даних про кожен елемент.

Зосередьтеся на селекторах на основі таблиць, оскільки структура сайту є традиційною та стабільною.

Перевіряйте дані на відповідність стандартам IUPAC, якщо вони використовуються для критично важливих досліджень.

Зберігайте числові значення, такі як щільність або точка плавлення, у форматі float для полегшення аналізу.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Часті запитання про WebElements

Знайдіть відповіді на поширені запитання про WebElements