BureauxLocaux Scrapen: Leitfaden für Gewerbeimmobiliendaten

Extrahieren Sie Gewerbeimmobiliendaten von BureauxLocaux. Scrapen Sie Büropreise, Lagerstandorte und Maklerdetails in ganz Frankreich für Ihre Marktanalyse.

Anti-Bot-Schutz erkannt

- Cloudflare

- Enterprise-WAF und Bot-Management. Nutzt JavaScript-Challenges, CAPTCHAs und Verhaltensanalyse. Erfordert Browser-Automatisierung mit Stealth-Einstellungen.

- CSRF Protection

- Rate Limiting

- Begrenzt Anfragen pro IP/Sitzung über Zeit. Kann mit rotierenden Proxys, Anfrageverzögerungen und verteiltem Scraping umgangen werden.

- User-Agent Filtering

- JavaScript-Challenge

- Erfordert JavaScript-Ausführung zum Zugriff auf Inhalte. Einfache Anfragen scheitern; Headless-Browser wie Playwright oder Puppeteer nötig.

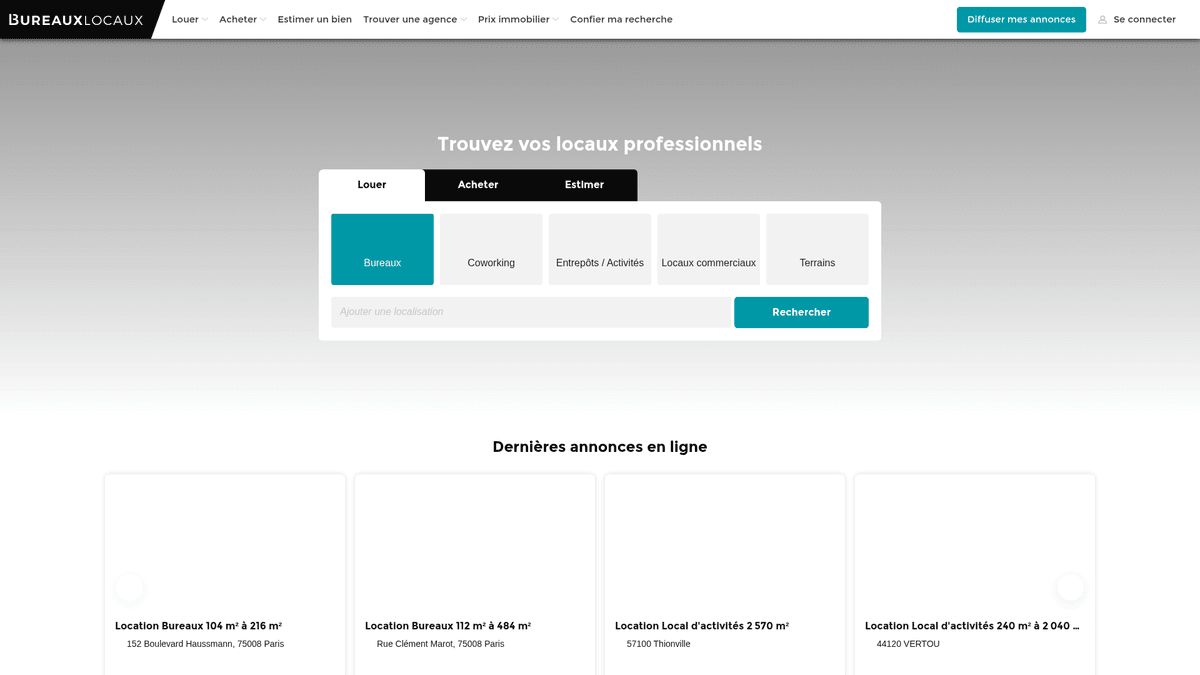

Über BureauxLocaux

Entdecken Sie, was BureauxLocaux bietet und welche wertvollen Daten extrahiert werden können.

Frankreichs führender Marktplatz für Gewerbeimmobilien

BureauxLocaux ist die führende digitale Plattform in Frankreich für professionelle Immobilien und erleichtert die Vermietung und den Verkauf von Büros, Lagerhallen, Einzelhandelsflächen und Coworking-Hubs. Die Plattform, die zur CoStar Group gehört, zentralisiert Daten von über 1.800 spezialisierten Agenturen und hostet mehr als 72.000 aktive Listings, was sie zu einer maßgeblichen Quelle für B2B-Immobilien-Insights macht.

Umfassende Market Intelligence

Die Plattform bietet eine detaillierte Sicht auf die französische Gewerbelandschaft, von den stark nachgefragten Pariser Geschäftsvierteln bis hin zu Logistikzentren in Lyon und Marseille. Sie dient als wichtige Brücke zwischen Immobiliensuchenden und spezialisierten Maklern und liefert detaillierte technische Spezifikationen, die über einfache Preispunkte hinausgehen.

Warum die Daten wichtig sind

Das Scrapen von BureauxLocaux ist für Immobilienentwickler, Investoren und Stadtplaner von entscheidender Bedeutung. Die Listings der Plattform liefern Echtzeitdaten zu Mietpreistrends, Leerstandsquoten und Energieeffizienzbewertungen (DPE), die für die Erstellung prädiktiver Marktmodelle und die Identifizierung renditestarker Investitionsmöglichkeiten kritisch sind.

Warum BureauxLocaux Scrapen?

Entdecken Sie den Geschäftswert und die Anwendungsfälle für die Datenextraktion von BureauxLocaux.

Gewerbliche Marktintelligenz

Überwachen Sie Miet- und Verkaufspreisschwankungen für Büros und Lagerhallen in verschiedenen französischen Regionen in Echtzeit, um aufstrebende Geschäftszentren zu identifizieren.

B2B-Lead-Generierung

Identifizieren Sie Gewerbeimmobilienagenturen, die auf spezifische Nischen wie Logistik oder High-End-Einzelhandel spezialisiert sind, um professionelle Dienstleistungen wie Büroausstattungen oder Versicherungen anzubieten.

Identifizierung von Investmentmöglichkeiten

Finden Sie unterbewertete Immobilien oder dringende Untervermietungsmöglichkeiten in erstklassigen Pariser Geschäftsvierteln, indem Sie Preisnachlässe und die Dauer der Inserate verfolgen.

Verfolgung des industriellen Angebots

Analysieren Sie die Verfügbarkeit und die technischen Spezifikationen von Industriehallen und Lagereinrichtungen, um die Logistik- und Lieferkettenplanung zu unterstützen.

Analyse wirtschaftlicher Indikatoren

Nutzen Sie gewerbliche Leerstandsquoten und die Verfügbarkeit von Quadratmetern als Frühindikatoren für regionales Wirtschaftswachstum oder -rückgang in französischen Großstädten.

Scraping-Herausforderungen

Technische Herausforderungen beim Scrapen von BureauxLocaux.

Fortgeschrittener DataDome-Schutz

BureauxLocaux nutzt DataDome, ein hochentwickeltes Bot-Management-System, das Headless-Browser durch Verhaltens- und Fingerprint-Analysen identifiziert und blockiert.

Interaktionsgeschützte Kontaktinformationen

Sensible Daten wie Makler-Telefonnummern sind oft hinter Schaltflächen verborgen, die einen physischen Klick erfordern, was zusätzliche Verifizierungsherausforderungen auslösen kann.

Geografische Zugriffsbeschränkungen

Die Website drosselt oder blockiert häufig Traffic von nicht-europäischen IP-Adressen, um globale Scraping-Versuche zu verhindern, während lokale Nutzer bedient werden.

Fragmentierte Datenformate

Preise werden inkonsistent als Preis pro Arbeitsplatz, Preis pro m²/Jahr oder als monatliche Gesamtmiete angegeben, was eine komplexe Normalisierungslogik während der Extraktion erfordert.

Scrape BureauxLocaux mit KI

Kein Code erforderlich. Extrahiere Daten in Minuten mit KI-gestützter Automatisierung.

So funktioniert's

Beschreibe, was du brauchst

Sag der KI, welche Daten du von BureauxLocaux extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

KI extrahiert die Daten

Unsere künstliche Intelligenz navigiert BureauxLocaux, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

Erhalte deine Daten

Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Warum KI zum Scraping nutzen

KI macht es einfach, BureauxLocaux zu scrapen, ohne Code zu schreiben. Unsere KI-gestützte Plattform nutzt künstliche Intelligenz, um zu verstehen, welche Daten du möchtest — beschreibe es einfach in natürlicher Sprache und die KI extrahiert sie automatisch.

How to scrape with AI:

- Beschreibe, was du brauchst: Sag der KI, welche Daten du von BureauxLocaux extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

- KI extrahiert die Daten: Unsere künstliche Intelligenz navigiert BureauxLocaux, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

- Erhalte deine Daten: Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Why use AI for scraping:

- Umgehung der DataDome-Sicherheit: Automatio ist darauf ausgelegt, fortgeschrittene Bot-Schutzmechanismen wie DataDome zu umgehen, ohne Blockaden auszulösen, was eine konsistente Datensammlung gewährleistet.

- Visuelle Datenextraktion: Der No-Code Visual Selector ermöglicht es Ihnen, komplexe technische Attribute wie Energieeffizienzklassen oder Gebäudeausstattungen per Point-and-Click auszuwählen, ohne eigene CSS-Selektoren schreiben zu müssen.

- Integrierte französische Proxies: Verbinden Sie ganz einfach französische Residential-Proxies, um lokales Browsing-Verhalten zu simulieren. Dies ist essenziell für den Zugriff auf regionale Anzeigen und zur Vermeidung von IP-Reputations-Blockaden.

- Automatisierte UI-Interaktionen: Konfigurieren Sie das Tool so, dass es automatisch das Axeptio Cookie-Consent-Banner verarbeitet und auf 'Anzeigen'-Buttons klickt, um verborgene Kontaktdetails zu erfassen.

No-Code Web Scraper für BureauxLocaux

Point-and-Click-Alternativen zum KI-gestützten Scraping

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von BureauxLocaux helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

Häufige Herausforderungen

Lernkurve

Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

Selektoren brechen

Website-Änderungen können den gesamten Workflow zerstören

Probleme mit dynamischen Inhalten

JavaScript-lastige Seiten erfordern komplexe Workarounds

CAPTCHA-Einschränkungen

Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

IP-Sperrung

Aggressives Scraping kann zur Sperrung Ihrer IP führen

No-Code Web Scraper für BureauxLocaux

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von BureauxLocaux helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

- Browser-Erweiterung installieren oder auf der Plattform registrieren

- Zur Zielwebseite navigieren und das Tool öffnen

- Per Point-and-Click die zu extrahierenden Datenelemente auswählen

- CSS-Selektoren für jedes Datenfeld konfigurieren

- Paginierungsregeln zum Scrapen mehrerer Seiten einrichten

- CAPTCHAs lösen (erfordert oft manuelle Eingabe)

- Zeitplanung für automatische Ausführungen konfigurieren

- Daten als CSV, JSON exportieren oder per API verbinden

Häufige Herausforderungen

- Lernkurve: Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

- Selektoren brechen: Website-Änderungen können den gesamten Workflow zerstören

- Probleme mit dynamischen Inhalten: JavaScript-lastige Seiten erfordern komplexe Workarounds

- CAPTCHA-Einschränkungen: Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

- IP-Sperrung: Aggressives Scraping kann zur Sperrung Ihrer IP führen

Code-Beispiele

import requests

from bs4 import BeautifulSoup

# Hinweis: Dies könnte ohne fortgeschrittene Header/Proxies von Cloudflare blockiert werden

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Beispiel: Listing-Karten auswählen

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Preis: {price}')

except Exception as e:

print(f'Scraping fehlgeschlagen: {e}')Wann verwenden

Am besten für statische HTML-Seiten, bei denen Inhalte serverseitig geladen werden. Der schnellste und einfachste Ansatz, wenn kein JavaScript-Rendering erforderlich ist.

Vorteile

- ●Schnellste Ausführung (kein Browser-Overhead)

- ●Geringster Ressourcenverbrauch

- ●Einfach zu parallelisieren mit asyncio

- ●Ideal für APIs und statische Seiten

Einschränkungen

- ●Kann kein JavaScript ausführen

- ●Scheitert bei SPAs und dynamischen Inhalten

- ●Kann bei komplexen Anti-Bot-Systemen Probleme haben

Wie man BureauxLocaux mit Code scrapt

Python + Requests

import requests

from bs4 import BeautifulSoup

# Hinweis: Dies könnte ohne fortgeschrittene Header/Proxies von Cloudflare blockiert werden

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Beispiel: Listing-Karten auswählen

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Preis: {price}')

except Exception as e:

print(f'Scraping fehlgeschlagen: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# Launching mit Stealth oder spezifischem UA wird empfohlen

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# Zu den Suchergebnissen navigieren

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# Auf das Rendern der Listings warten

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Makler kontaktieren"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# Jedes Immobilien-Kärtchen auf der Seite durchlaufen

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# Pagination: Link zur 'Nächsten' Seite finden

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Realistischen User-Agent setzen

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// Daten aus den Listing-Elementen extrahieren

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();Was Sie mit BureauxLocaux-Daten machen können

Entdecken Sie praktische Anwendungen und Erkenntnisse aus BureauxLocaux-Daten.

Indexierung von Gewerbemieten

Finanzanalysten können einen dynamischen Index für Büromietkosten erstellen, um Firmenkunden bei der Standortstrategie zu beraten.

So implementieren Sie es:

- 1Scrapen Sie wöchentlich alle aktiven Büro-Listings in den wichtigsten französischen Städten.

- 2Berechnen Sie den Preis pro Quadratmeter pro Jahr für jeden Eintrag.

- 3Gruppieren Sie die Daten nach Stadtbezirken (Arrondissements), um Preiscluster zu identifizieren.

- 4Visualisieren Sie die 'Preis-Heatmap' mit einem Mapping-Tool wie Tableau.

Verwenden Sie Automatio, um Daten von BureauxLocaux zu extrahieren und diese Anwendungen ohne Code zu erstellen.

Was Sie mit BureauxLocaux-Daten machen können

- Indexierung von Gewerbemieten

Finanzanalysten können einen dynamischen Index für Büromietkosten erstellen, um Firmenkunden bei der Standortstrategie zu beraten.

- Scrapen Sie wöchentlich alle aktiven Büro-Listings in den wichtigsten französischen Städten.

- Berechnen Sie den Preis pro Quadratmeter pro Jahr für jeden Eintrag.

- Gruppieren Sie die Daten nach Stadtbezirken (Arrondissements), um Preiscluster zu identifizieren.

- Visualisieren Sie die 'Preis-Heatmap' mit einem Mapping-Tool wie Tableau.

- Lead-Generierung für Immobilien

B2B-Dienstleister können Unternehmen finden, die in neue Räumlichkeiten ziehen und IT-Einrichtung, Möbel oder Versicherungen benötigen.

- Targeten Sie Listings, die als 'Kürzlich verfügbar' oder 'Neu auf dem Markt' markiert sind.

- Extrahieren Sie die Kontaktdaten der inserierenden Agentur für Partnerschaftsanfragen.

- Verfolgen Sie die Entfernung von Immobilien, um abzuschätzen, wann ein Unternehmen erfolgreich einen Mietvertrag unterzeichnet hat.

- Automatisieren Sie einen CRM-Eintrag für neue potenzielle Bürorenovierungsprojekte.

- Verfolgung der Leerstandsdauer

Wirtschaftsforscher können überwachen, wie lange Industrieimmobilien am Markt bleiben, um die lokale wirtschaftliche Gesundheit zu messen.

- Scrapen Sie alle Lagerhallen-Listings und speichern Sie deren 'Zuerst gesehen'-Datum.

- Überprüfen Sie kontinuierlich, welche Listings noch aktiv sind vs. welche entfernt wurden.

- Berechnen Sie die durchschnittliche Verweildauer am Markt (Time on Market - ToM) für jede Industriezone.

- Korrelieren Sie eine hohe ToM mit spezifischen regionalen Wirtschaftsabschwüngen.

- Automatisierung von Investment-Filtern

Investoren können sofortige Benachrichtigungen erhalten, wenn Immobilien in bestimmten Gebieten unter einen gewissen Preisschwellenwert fallen.

- Richten Sie einen täglichen Scrape für spezifische Kategorien wie 'Vente de Bureaux' (Büroverkauf) ein.

- Vergleichen Sie den Tagespreis mit dem historischen Durchschnitt für die jeweilige Postleitzahl.

- Lösen Sie eine Benachrichtigung aus, wenn ein Listing 15 % unter dem Marktdurchschnitt eingepreist ist.

- Exportieren Sie die gefilterten Deals in ein Google Sheet zur sofortigen Überprüfung.

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Profi-Tipps für das Scrapen von BureauxLocaux

Expertentipps für die erfolgreiche Datenextraktion von BureauxLocaux.

Französische Residential-IPs bevorzugen

Die Verwendung von Proxies mit Standort in Frankreich ist der effektivste Weg, um nicht von den regionalen Sicherheitsfiltern der Website markiert zu werden.

Steuerliche Suffixe berücksichtigen

Stellen Sie sicher, dass Ihre Preis-Parser 'HT' (Hors Taxes - ohne Steuern) und 'HC' (Hors Charges - ohne Nebenkosten) erkennen, um die Gesamtkosten von gewerblichen Anzeigen korrekt zu berechnen.

Interne XHR-Anfragen überwachen

Untersuchen Sie den Netzwerkverkehr, um die internen JSON-Endpunkte zu finden, die die Seite zum Laden der Anzeigen nutzt, um eine effizientere und strukturiertere Extraktion zu ermöglichen.

Randomisierte Verzögerungen implementieren

Führen Sie variable Pausenzeiten zwischen den Seitenaufrufen und Interaktionen ein, um menschliche Browsing-Muster zu imitieren und unter den Grenzwerten für Rate-Limiting zu bleiben.

Cookie-Einwilligungen zuerst bearbeiten

Stellen Sie sicher, dass Ihr Scraper beim Laden der Seite mit dem Cookie-Consent-Modal interagiert oder dieses ausblendet, um zu verhindern, dass es über den Elementen der Anzeige liegt und den Zugriff blockiert.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Häufig gestellte Fragen zu BureauxLocaux

Finden Sie Antworten auf häufige Fragen zu BureauxLocaux