Hugging Face Scraping: Der vollständige technische Leitfaden

Meistern Sie das Hugging Face Scraping zur Extraktion von AI models, Datensätzen und Metadaten. Lernen Sie, Cloudflare zu umgehen und die Datenerfassung für...

Anti-Bot-Schutz erkannt

- Cloudflare

- Enterprise-WAF und Bot-Management. Nutzt JavaScript-Challenges, CAPTCHAs und Verhaltensanalyse. Erfordert Browser-Automatisierung mit Stealth-Einstellungen.

- Rate Limiting

- Begrenzt Anfragen pro IP/Sitzung über Zeit. Kann mit rotierenden Proxys, Anfrageverzögerungen und verteiltem Scraping umgangen werden.

- IP-Blockierung

- Blockiert bekannte Rechenzentrums-IPs und markierte Adressen. Erfordert Residential- oder Mobile-Proxys zur effektiven Umgehung.

- Bot Detection

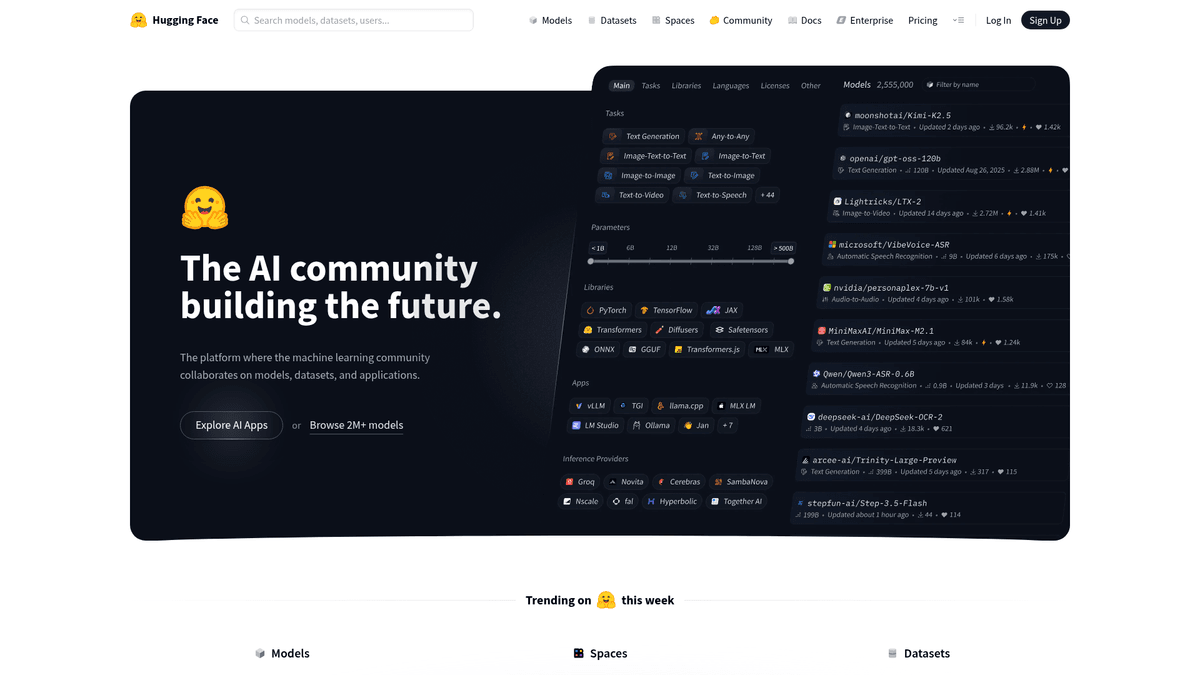

Über Hugging Face

Entdecken Sie, was Hugging Face bietet und welche wertvollen Daten extrahiert werden können.

Hugging Face ist die führende Plattform und Community für machine learning und künstliche Intelligenz, oft als das GitHub für KI bezeichnet. Es bietet einen zentralen Hub, auf dem Forscher und Entwickler models, Datensätze und Demo-Anwendungen, bekannt als Spaces, teilen, entdecken und gemeinsam daran arbeiten. Es hostet Beiträge von großen Technologieunternehmen wie Google, Meta und Microsoft sowie eine riesige Community unabhängiger Entwickler. Die Plattform enthält eine enorme Menge an strukturierten Daten, einschließlich Metriken zur model Performance, Datensatz-Konfigurationen, Protokolle der Benutzeraktivität und Informationen zur Bibliothekskompatibilität.

Das Scraping von Hugging Face ist äußerst wertvoll für Organisationen, die Competitive Intelligence betreiben, die Einführung spezifischer KI-Frameworks verfolgen oder Metadaten für die akademische Forschung aggregieren möchten. Durch das Extrahieren von Daten von der Plattform können Benutzer trendige models überwachen, Top-Mitwirkende identifizieren und über die sich schnell entwickelnde Landschaft der generativen KI auf dem Laufenden bleiben. Die Plattform organisiert Inhalte nach Aufgaben wie Natural Language Processing (NLP), Computer Vision und Audio, was sie zu einem kritischen Repository für den state-of-the-art im Bereich machine learning macht.

Warum Hugging Face Scrapen?

Entdecken Sie den Geschäftswert und die Anwendungsfälle für die Datenextraktion von Hugging Face.

AI-Markttrendanalyse

Durch das Scraping von Hugging Face können Forscher überwachen, welche model-Architekturen und AI-Aufgaben an Dynamik gewinnen, indem sie Downloadzahlen und Community-Likes im Zeitverlauf verfolgen.

Wettbewerbsanalyse

Tech-Unternehmen können den open-source-Output von Wettbewerbern wie Meta, Google und Mistral verfolgen, um über deren neueste Veröffentlichungen und model-benchmarks informiert zu bleiben.

Lead-Generierung für Forscher

Das Extrahieren von Autoren- und Mitwirkendenprofilen hilft Recruiting-Teams dabei, leistungsstarke AI-Forscher und Entwickler zu finden, die in der open-source-Community aktiv sind.

Entdeckung und Indexierung von Datensätzen

Der Aufbau eines benutzerdefinierten, durchsuchbaren Index von Nischen-Datensätzen in verschiedenen Sprachen und Modalitäten hilft Data Scientists dabei, Trainingsdaten zu finden, die in der Such-UI oft verborgen bleiben.

Investment- und Marktforschung

Venture-Capital-Geber nutzen Metadaten von trending models als Indikator, um die kommerzielle Tragfähigkeit und die Entwicklerakzeptanz aufstrebender AI-Startups zu messen.

Scraping-Herausforderungen

Technische Herausforderungen beim Scrapen von Hugging Face.

Cloudflare Anti-Bot-Schutz

Hugging Face nutzt Cloudflare, um automatisierten Traffic zu reduzieren, was bei Standard-Scraping-Skripten häufig zu JS-Challenges oder CAPTCHAs führt.

Dynamische React-Architektur

Die Website setzt stark auf Client-Side-Rendering, was bedeutet, dass model-Listen und Metadaten oft eine vollständige Browser-Umgebung benötigen, um korrekt geladen zu werden.

Striktes rate limiting

Das Senden zu vieler Anfragen an model-Cards oder die internen JSON-Endpunkte führt schnell zu '429 Too Many Requests'-Fehlern und temporären IP-Sperren.

Unstrukturierte model-Beschreibungen

Während technische Metadaten strukturiert sind, befinden sich spezifische model-Details oft in Markdown-basierten README-Dateien, deren Format von Autor zu Autor variiert.

Scrape Hugging Face mit KI

Kein Code erforderlich. Extrahiere Daten in Minuten mit KI-gestützter Automatisierung.

So funktioniert's

Beschreibe, was du brauchst

Sag der KI, welche Daten du von Hugging Face extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

KI extrahiert die Daten

Unsere künstliche Intelligenz navigiert Hugging Face, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

Erhalte deine Daten

Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Warum KI zum Scraping nutzen

KI macht es einfach, Hugging Face zu scrapen, ohne Code zu schreiben. Unsere KI-gestützte Plattform nutzt künstliche Intelligenz, um zu verstehen, welche Daten du möchtest — beschreibe es einfach in natürlicher Sprache und die KI extrahiert sie automatisch.

How to scrape with AI:

- Beschreibe, was du brauchst: Sag der KI, welche Daten du von Hugging Face extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

- KI extrahiert die Daten: Unsere künstliche Intelligenz navigiert Hugging Face, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

- Erhalte deine Daten: Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Why use AI for scraping:

- Visuelle No-Code-Auswahl: Automatio ermöglicht es Ihnen, verschachtelte model-Daten und Download-Metriken über eine einfache Point-and-Click-Oberfläche auszuwählen, wodurch die manuelle Zuweisung von CSS-Selektoren entfällt.

- Integriertes Proxy-Management: Die Plattform übernimmt automatisch die Rotation von Residential Proxies und das Fingerprint-Spoofing, damit Ihr Scraper den Cloudflare-Schutz ohne Unterbrechungen umgehen kann.

- Headless-Browser-Rendering: Automatio führt JavaScript nativ aus und stellt so sicher, dass alle React-gerenderten Inhalte auf model- und Datensatzseiten vollständig geladen sind, bevor die Extraktion beginnt.

- Automatisierte Cloud-Zeitpläne: Sie können Ihre Hugging Face Scraper so planen, dass sie täglich oder wöchentlich ausgeführt werden und Ihre Datenbank automatisch mit den neuesten trending models aktualisieren.

No-Code Web Scraper für Hugging Face

Point-and-Click-Alternativen zum KI-gestützten Scraping

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von Hugging Face helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

Häufige Herausforderungen

Lernkurve

Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

Selektoren brechen

Website-Änderungen können den gesamten Workflow zerstören

Probleme mit dynamischen Inhalten

JavaScript-lastige Seiten erfordern komplexe Workarounds

CAPTCHA-Einschränkungen

Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

IP-Sperrung

Aggressives Scraping kann zur Sperrung Ihrer IP führen

No-Code Web Scraper für Hugging Face

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von Hugging Face helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

- Browser-Erweiterung installieren oder auf der Plattform registrieren

- Zur Zielwebseite navigieren und das Tool öffnen

- Per Point-and-Click die zu extrahierenden Datenelemente auswählen

- CSS-Selektoren für jedes Datenfeld konfigurieren

- Paginierungsregeln zum Scrapen mehrerer Seiten einrichten

- CAPTCHAs lösen (erfordert oft manuelle Eingabe)

- Zeitplanung für automatische Ausführungen konfigurieren

- Daten als CSV, JSON exportieren oder per API verbinden

Häufige Herausforderungen

- Lernkurve: Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

- Selektoren brechen: Website-Änderungen können den gesamten Workflow zerstören

- Probleme mit dynamischen Inhalten: JavaScript-lastige Seiten erfordern komplexe Workarounds

- CAPTCHA-Einschränkungen: Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

- IP-Sperrung: Aggressives Scraping kann zur Sperrung Ihrer IP führen

Code-Beispiele

import requests

from bs4 import BeautifulSoup

url = 'https://huggingface.co/models?sort=downloads'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting model articles

models = soup.find_all('article')

for model in models:

name = model.find('h4').text.strip()

print(f'Model Name: {name}')

except Exception as e:

print(f'Error occurred: {e}')Wann verwenden

Am besten für statische HTML-Seiten, bei denen Inhalte serverseitig geladen werden. Der schnellste und einfachste Ansatz, wenn kein JavaScript-Rendering erforderlich ist.

Vorteile

- ●Schnellste Ausführung (kein Browser-Overhead)

- ●Geringster Ressourcenverbrauch

- ●Einfach zu parallelisieren mit asyncio

- ●Ideal für APIs und statische Seiten

Einschränkungen

- ●Kann kein JavaScript ausführen

- ●Scheitert bei SPAs und dynamischen Inhalten

- ●Kann bei komplexen Anti-Bot-Systemen Probleme haben

Wie man Hugging Face mit Code scrapt

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://huggingface.co/models?sort=downloads'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting model articles

models = soup.find_all('article')

for model in models:

name = model.find('h4').text.strip()

print(f'Model Name: {name}')

except Exception as e:

print(f'Error occurred: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_hf():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://huggingface.co/models')

# Wait for model list to render

page.wait_for_selector('article')

models = page.query_selector_all('article h4')

for m in models:

print(m.inner_text())

browser.close()

scrape_hf()Python + Scrapy

import scrapy

class HuggingFaceSpider(scrapy.Spider):

name = 'hf_spider'

start_urls = ['https://huggingface.co/models']

def parse(self, response):

for model in response.css('article'):

yield {

'title': model.css('h4::text').get(),

'author': model.css('span.text-gray-400::text').get()

}

# Handle pagination

next_page = response.css('a[aria-label="Next"]::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://huggingface.co/models');

// Wait for the dynamic content to load

await page.waitForSelector('article');

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('article h4')).map(h => h.innerText);

});

console.log(data);

await browser.close();

})();Was Sie mit Hugging Face-Daten machen können

Entdecken Sie praktische Anwendungen und Erkenntnisse aus Hugging Face-Daten.

Identifizierung von KI-Markttrends

Unternehmen profitieren davon, zu identifizieren, welche KI-Aufgaben weltweit am meisten an Zugkraft gewinnen.

So implementieren Sie es:

- 1Monatliches Scraping der Download-Zahlen für alle models innerhalb spezifischer Task-Kategorien.

- 2Aggregieren der Daten, um das prozentuale Wachstum nach Kategorie zu sehen.

- 3Identifizierung von Breakout-Modellen, die plötzliche Spitzen in der Popularität zeigen.

Verwenden Sie Automatio, um Daten von Hugging Face zu extrahieren und diese Anwendungen ohne Code zu erstellen.

Was Sie mit Hugging Face-Daten machen können

- Identifizierung von KI-Markttrends

Unternehmen profitieren davon, zu identifizieren, welche KI-Aufgaben weltweit am meisten an Zugkraft gewinnen.

- Monatliches Scraping der Download-Zahlen für alle models innerhalb spezifischer Task-Kategorien.

- Aggregieren der Daten, um das prozentuale Wachstum nach Kategorie zu sehen.

- Identifizierung von Breakout-Modellen, die plötzliche Spitzen in der Popularität zeigen.

- Competitive Intelligence

Technologiefirmen verfolgen den open-source Output von Wettbewerbern wie Meta oder Google, um an der Spitze zu bleiben.

- Einrichten eines gezielten Scrapes für spezifische Organisationsprofile auf Hugging Face.

- Überwachung auf neue Repository-Erstellungen oder Updates bestehender model cards.

- Benachrichtigung der Produkt-Teams, wenn ein Wettbewerber ein neues model in einem relevanten Bereich veröffentlicht.

- Lead-Generierung für Tech-Talente

Recruiter finden erstklassige KI-Forscher, indem sie die Beitragsqualität und den Einfluss auf die Community analysieren.

- Extrahieren von Autorenlisten aus leistungsstarken models mit über 100.000 Downloads.

- Scraping von Benutzerprofilen, um verknüpfte soziale Medien oder persönliche Websites zu finden.

- Filtern nach Personen mit einer konsistenten Historie populärer open-source Beiträge.

- Akademische Forschungsdatensätze

Forscher analysieren die kollaborative Natur und die Entwicklung des KI-Forschungs-Ökosystems.

- Scraping von Metadaten einschließlich Autorenlisten, Zitationszahlen und Organisationszugehörigkeiten.

- Abbildung der Beziehungen zwischen verschiedenen Organisationen und einzelnen Mitwirkenden.

- Anwendung von Netzwerkanalysen zur Visualisierung der Hubs im KI-Forschungs-Ökosystem.

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Profi-Tipps für das Scrapen von Hugging Face

Expertentipps für die erfolgreiche Datenextraktion von Hugging Face.

YAML Front Matter gezielt nutzen

Die meisten Hugging Face README-Dateien enthalten oben einen strukturierten YAML-Block; diesen direkt zu scrapen liefert die zuverlässigsten Metadaten für tags und Lizenzen.

Netzwerkanfragen untersuchen

Hugging Face nutzt oft interne API-Endpunkte, um model-Listen abzurufen; diese JSON-Antworten direkt anzusteuern, kann schneller und stabiler sein als HTML-Scraping.

Die offizielle API bevorzugen

Für die einfache Extraktion von Metadaten sollte immer zuerst die offizielle 'huggingface_hub' Python-Bibliothek geprüft werden, da diese seltener blockiert wird als das Web-Interface.

Residential Proxies nutzen

Um das aggressive IP-basierte rate limiting der Seite zu vermeiden, sollten hochwertige Residential Proxies anstelle von Datacenter-IPs verwendet werden, die leicht markiert werden.

config.json für technische Daten scrapen

Für tiefe technische Details wie Architekturtyp und parameters-Anzahl sollte der Link zur 'config.json'-Datei innerhalb des model-Repositorys extrahiert werden.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape American Museum of Natural History (AMNH)

Häufig gestellte Fragen zu Hugging Face

Finden Sie Antworten auf häufige Fragen zu Hugging Face