MakerWorld Scraping: 3D-model-Daten & Designer-Statistiken

Erfahren Sie, wie Sie MakerWorld nach 3D-model-Listings, Download-Zahlen und Creator-Statistiken scrapen. Extrahieren Sie wertvolle 3D-Druck-Trends und...

Anti-Bot-Schutz erkannt

- Cloudflare

- Enterprise-WAF und Bot-Management. Nutzt JavaScript-Challenges, CAPTCHAs und Verhaltensanalyse. Erfordert Browser-Automatisierung mit Stealth-Einstellungen.

- Rate Limiting

- Begrenzt Anfragen pro IP/Sitzung über Zeit. Kann mit rotierenden Proxys, Anfrageverzögerungen und verteiltem Scraping umgangen werden.

- Browser-Fingerprinting

- Identifiziert Bots anhand von Browser-Eigenschaften: Canvas, WebGL, Schriftarten, Plugins. Erfordert Spoofing oder echte Browser-Profile.

- Dynamic CSS Classes

- CAPTCHA

- Challenge-Response-Test zur Verifizierung menschlicher Benutzer. Kann bildbasiert, textbasiert oder unsichtbar sein. Erfordert oft Drittanbieter-Lösungsdienste.

Über MakerWorld

Entdecken Sie, was MakerWorld bietet und welche wertvollen Daten extrahiert werden können.

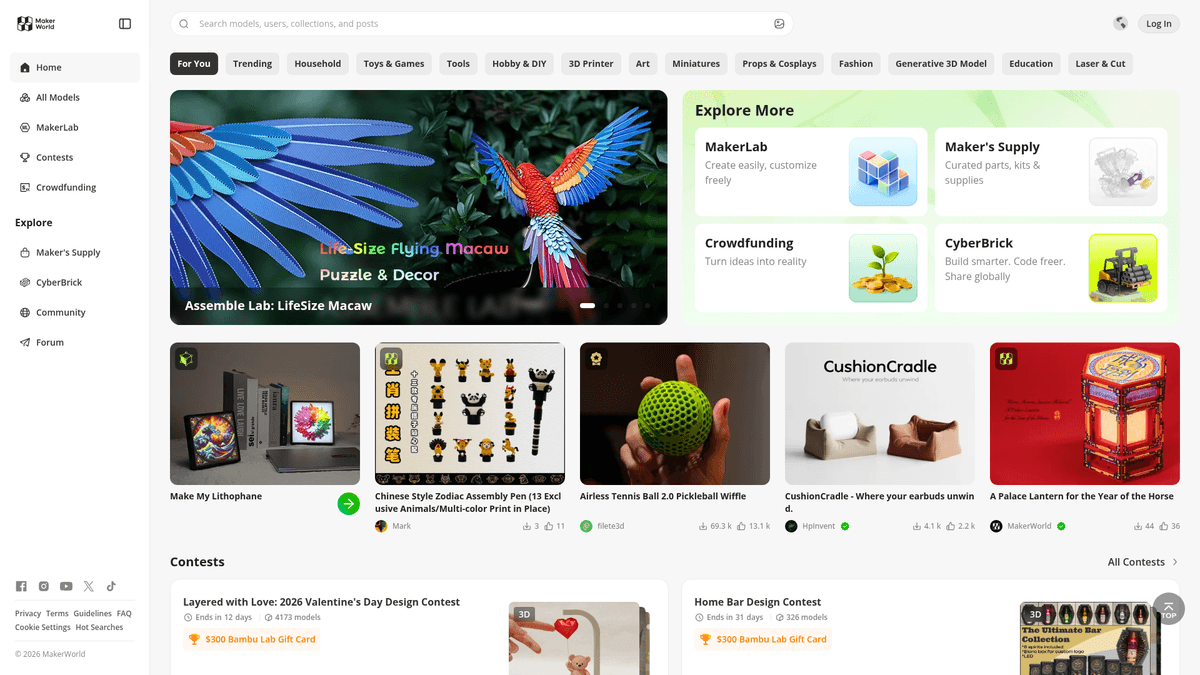

Der erstklassige Hub für den 3D-Druck

MakerWorld ist eine umfassende Plattform zum Teilen von 3D-models, die von Bambu Lab entwickelt wurde, um sich nahtlos in deren Ökosystem von 3D-Druckern zu integrieren. Im Gegensatz zu herkömmlichen Repositories konzentriert sich MakerWorld auf ein „One-Click“-Druckerlebnis durch die Integration von Bambu Studio und der Handy App und hostet hochwertige 3D-Dateien (STLs, 3MFs) sowie detaillierte Druckprofile.

Datenreiches Community-Ökosystem

Die Website enthält reichhaltige Daten wie model-Titel, detaillierte Beschreibungen, Download-Zahlen, Likes und Informationen zu Erstellerprofilen. Sie wird von der 3D-Druck-Community intensiv genutzt, um neue Projekte zu entdecken und die Popularität verschiedener Designs über soziale Metriken und Druckerfolgsbewertungen zu verfolgen. Die Plattform organisiert Inhalte in verschiedene Kategorien wie funktionale Werkzeuge, dekorative Kunst und mechanische Teile.

Strategischer Geschäftswert

Das Scraping von MakerWorld ist wertvoll für die Marktforschung, die Identifizierung von Trendkategorien in der additiven Fertigung und die Überwachung der Leistung von Designern. Die Daten können verwendet werden, um 3D-Assets zu aggregieren, das Wachstum des open-source Hardware-Ökosystems zu analysieren und Wettbewerbs-Assets auf dem 3D-Druckmarkt zu überwachen. Diese Informationen helfen Unternehmen und Forschern, Verbraucherpräferenzen und technologische Trends in der 3D-Modellierung zu verstehen.

Warum MakerWorld Scrapen?

Entdecken Sie den Geschäftswert und die Anwendungsfälle für die Datenextraktion von MakerWorld.

Trend-Prognosen

Identifizieren Sie, welche 3D-model-Stile, wie zum Beispiel bewegliche Designs oder funktionale Werkzeuge, die meiste Resonanz finden, um Marktveränderungen voraus zu sein.

Wettbewerber-Benchmark

Überwachen Sie die Download-zu-Like-Verhältnisse und Engagement-Metriken anderer Designer, um Ihre eigene Content-Strategie zu verbessern und Belohnungspunkte zu maximieren.

Analyse des Hardware-Ökosystems

Verfolgen Sie die Beliebtheit und das Volumen dedizierter Druckprofile für spezifische Druckermodelle, um das Wachstum des Hardware-Ökosystems zu verstehen.

Überwachung von Creator-Prämien

Automatisieren Sie die Verfolgung von Punkten und 'Boosts' über mehrere Profile hinweg, um die Einlösung von Geschenkkarten für volumenstarke Designer zu optimieren.

Aggregation von Nischen-Inhalten

Erstellen Sie spezialisierte Suchmaschinen oder Verzeichnisse für spezifische Interessen, wie Zubehör für Tabletop-Gaming oder mechanische Ersatzteile.

Sentiment- und Review-Mining

Scrapen Sie Nutzerkommentare und Feedback, um häufige Druckfehler oder gewünschte Verbesserungen für bestimmte model-Kategorien zu verstehen.

Scraping-Herausforderungen

Technische Herausforderungen beim Scrapen von MakerWorld.

Schutz durch Cloudflare und Turnstile

MakerWorld verwendet aggressive Bot-Erkennung und Sicherheits-Challenges, die Standard-Anfragen blockieren und fortgeschrittene Bypass-Techniken erfordern.

Dynamisches React-Rendering

Die Plattform ist eine Single-Page-Application, bei der model-Daten nicht im initialen HTML vorhanden sind und einen Headless-Browser zur Ausführung benötigen.

Instabile CSS-Selektoren

Die Website verwendet Material UI mit dynamischen Klassennamen, die sich häufig ändern, was die Wartung traditioneller selektorenbasierter Scraper erschwert.

Striktes Rate Limiting

Zu schnelle Anfragen führen zu temporären IP-Sperren oder anhaltenden Sicherheitsprüfungen, was randomisierte Verzögerungen und Proxy-Rotation erforderlich macht.

Scrape MakerWorld mit KI

Kein Code erforderlich. Extrahiere Daten in Minuten mit KI-gestützter Automatisierung.

So funktioniert's

Beschreibe, was du brauchst

Sag der KI, welche Daten du von MakerWorld extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

KI extrahiert die Daten

Unsere künstliche Intelligenz navigiert MakerWorld, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

Erhalte deine Daten

Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Warum KI zum Scraping nutzen

KI macht es einfach, MakerWorld zu scrapen, ohne Code zu schreiben. Unsere KI-gestützte Plattform nutzt künstliche Intelligenz, um zu verstehen, welche Daten du möchtest — beschreibe es einfach in natürlicher Sprache und die KI extrahiert sie automatisch.

How to scrape with AI:

- Beschreibe, was du brauchst: Sag der KI, welche Daten du von MakerWorld extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

- KI extrahiert die Daten: Unsere künstliche Intelligenz navigiert MakerWorld, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

- Erhalte deine Daten: Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Why use AI for scraping:

- Zero-Config Bot-Abwehr: Automatio verarbeitet automatisch komplexes Browser-Fingerprinting und Header, um die Sicherheitsbarrieren von MakerWorld ohne manuelles Coding zu umgehen.

- Präzision durch visuelle Selektoren: Wählen Sie komplexe Material UI-Elemente und verschachtelte Datenpunkte einfach über eine intuitive Benutzeroberfläche aus, die verschleierte CSS-Klassennamen umgeht.

- Automatisierte Paginierung: Verwalten Sie mühelos Infinite Scroll und 'Mehr laden'-Buttons mit einem einzigen Klick, um Tausende von Modellen aus Kategorie-Seiten zu extrahieren.

- Cloud-basierte Zeitplanung: Konfigurieren Sie Ihren Scraper so, dass er in festgelegten Intervallen läuft, um Änderungen bei Download-Zahlen und Beliebtheits-Rankings über die Zeit konsistent zu verfolgen.

No-Code Web Scraper für MakerWorld

Point-and-Click-Alternativen zum KI-gestützten Scraping

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von MakerWorld helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

Häufige Herausforderungen

Lernkurve

Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

Selektoren brechen

Website-Änderungen können den gesamten Workflow zerstören

Probleme mit dynamischen Inhalten

JavaScript-lastige Seiten erfordern komplexe Workarounds

CAPTCHA-Einschränkungen

Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

IP-Sperrung

Aggressives Scraping kann zur Sperrung Ihrer IP führen

No-Code Web Scraper für MakerWorld

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von MakerWorld helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

- Browser-Erweiterung installieren oder auf der Plattform registrieren

- Zur Zielwebseite navigieren und das Tool öffnen

- Per Point-and-Click die zu extrahierenden Datenelemente auswählen

- CSS-Selektoren für jedes Datenfeld konfigurieren

- Paginierungsregeln zum Scrapen mehrerer Seiten einrichten

- CAPTCHAs lösen (erfordert oft manuelle Eingabe)

- Zeitplanung für automatische Ausführungen konfigurieren

- Daten als CSV, JSON exportieren oder per API verbinden

Häufige Herausforderungen

- Lernkurve: Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

- Selektoren brechen: Website-Änderungen können den gesamten Workflow zerstören

- Probleme mit dynamischen Inhalten: JavaScript-lastige Seiten erfordern komplexe Workarounds

- CAPTCHA-Einschränkungen: Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

- IP-Sperrung: Aggressives Scraping kann zur Sperrung Ihrer IP führen

Code-Beispiele

import requests

from bs4 import BeautifulSoup

# Einfache Requests scheitern bei MakerWorld oft wegen Cloudflare und React-Rendering

url = 'https://makerworld.com/en/models'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9'

}

try:

# Dies wird wahrscheinlich eine Cloudflare-Challenge oder ein JS-Skelett zurückgeben

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Hinweis: Der eigentliche Inhalt wird hier nicht angezeigt, da JS-Rendering erforderlich ist

print('Seite erreicht, aber der Inhalt ist dynamisch.')

else:

print(f'Von Cloudflare blockiert: HTTP {response.status_code}')

except Exception as e:

print(f'Fehler: {e}')Wann verwenden

Am besten für statische HTML-Seiten, bei denen Inhalte serverseitig geladen werden. Der schnellste und einfachste Ansatz, wenn kein JavaScript-Rendering erforderlich ist.

Vorteile

- ●Schnellste Ausführung (kein Browser-Overhead)

- ●Geringster Ressourcenverbrauch

- ●Einfach zu parallelisieren mit asyncio

- ●Ideal für APIs und statische Seiten

Einschränkungen

- ●Kann kein JavaScript ausführen

- ●Scheitert bei SPAs und dynamischen Inhalten

- ●Kann bei komplexen Anti-Bot-Systemen Probleme haben

Wie man MakerWorld mit Code scrapt

Python + Requests

import requests

from bs4 import BeautifulSoup

# Einfache Requests scheitern bei MakerWorld oft wegen Cloudflare und React-Rendering

url = 'https://makerworld.com/en/models'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9'

}

try:

# Dies wird wahrscheinlich eine Cloudflare-Challenge oder ein JS-Skelett zurückgeben

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Hinweis: Der eigentliche Inhalt wird hier nicht angezeigt, da JS-Rendering erforderlich ist

print('Seite erreicht, aber der Inhalt ist dynamisch.')

else:

print(f'Von Cloudflare blockiert: HTTP {response.status_code}')

except Exception as e:

print(f'Fehler: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_makerworld():

with sync_playwright() as p:

# Start mit stealth-ähnlichen Headern

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://makerworld.com/en/models', wait_until='networkidle')

# Warten auf die model-Karten, die über React gerendert werden

page.wait_for_selector("div[data-testid='model-card']")

models = page.query_selector_all("div[data-testid='model-card']")

for model in models:

# Standard-Attribute sind oft stabiler als CSS-Klassen

title = model.query_selector('h3').inner_text()

print(f'model gefunden: {title}')

browser.close()

scrape_makerworld()Python + Scrapy

import scrapy

from scrapy_playwright.page import PageMethod

class MakerworldSpider(scrapy.Spider):

name = 'makerworld'

start_urls = ['https://makerworld.com/en/models']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(

url,

meta=dict(

playwright=True,

playwright_page_methods=[

PageMethod('wait_for_selector', "div[data-testid='model-card']"),

],

)

)

def parse(self, response):

# Scrapy-playwright ermöglicht das Parsen des per JS gerenderten HTMLs

for model in response.css("div[data-testid='model-card']"):

yield {

'title': model.css('h3::text').get(),

'downloads': model.css('span.stats-downloads::text').get(),

'link': response.urljoin(model.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Einen realistischen User-Agent setzen

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0');

await page.goto('https://makerworld.com/en/models', { waitUntil: 'networkidle2' });

// Warten, bis die React-Komponente gemountet ist

await page.waitForSelector("div[data-testid='model-card']");

const models = await page.evaluate(() => {

const cards = Array.from(document.querySelectorAll("div[data-testid='model-card']"));

return cards.map(card => ({

title: card.querySelector('h3')?.innerText,

link: card.querySelector('a')?.href

}));

});

console.log(models);

await browser.close();

})();Was Sie mit MakerWorld-Daten machen können

Entdecken Sie praktische Anwendungen und Erkenntnisse aus MakerWorld-Daten.

3D-Druck-Marktanalyse

Analysieren Sie, welche Arten von models (funktional vs. dekorativ) am beliebtesten sind, um die globale Marktnachfrage zu verstehen.

So implementieren Sie es:

- 1Scrapen der Top-Kategorien nach model-Metadaten und Download-Zahlen

- 2Wöchentliches Aggregieren von Metriken, um Wachstumsraten im Zeitverlauf zu verfolgen

- 3Visualisieren von Trends zur Identifizierung neuer 3D-Druck-Nischen

Verwenden Sie Automatio, um Daten von MakerWorld zu extrahieren und diese Anwendungen ohne Code zu erstellen.

Was Sie mit MakerWorld-Daten machen können

- 3D-Druck-Marktanalyse

Analysieren Sie, welche Arten von models (funktional vs. dekorativ) am beliebtesten sind, um die globale Marktnachfrage zu verstehen.

- Scrapen der Top-Kategorien nach model-Metadaten und Download-Zahlen

- Wöchentliches Aggregieren von Metriken, um Wachstumsraten im Zeitverlauf zu verfolgen

- Visualisieren von Trends zur Identifizierung neuer 3D-Druck-Nischen

- Tracking des Creator-Einflusses

Identifizieren Sie leistungsstarke Designer, um Talente zu scouten oder Sponsoring-Möglichkeiten im Hardware-Bereich zu finden.

- Scrapen von Ersteller-Profilseiten für Gesamt-Downloads und Follower-Statistiken

- Überwachen der Frequenz neuer Uploads pro Designer jeden Monat

- Ranking der Ersteller basierend auf dem Verhältnis von Engagement zu Downloads

- Prognose des Materialbedarfs

Prognostizieren Sie den Filamentbedarf durch die Analyse der Materialtypen, die von beliebten models auf der Plattform benötigt werden.

- Extrahieren von 'Filament-Anforderungen' aus model-Druckprofilen

- Summieren der benötigten Materialien über die meistgefragten models

- Analysieren der am häufigsten angeforderten Filament-Farben und -Typen (PLA, PETG, etc.)

- Such-Aggregator für 3D-Assets

Erstellen Sie einen durchsuchbaren Index von 3D-models von mehreren Plattformen wie MakerWorld für eine einfachere Benutzerentdeckung.

- Extrahieren von model-Titeln, Tags und Thumbnail-URLs von MakerWorld

- Indexieren der Metadaten in einer zentralen Datenbank mit Volltextsuche

- Bereitstellen von Deep-Links zu den ursprünglichen MakerWorld-Listing-Seiten für Traffic

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Profi-Tipps für das Scrapen von MakerWorld

Expertentipps für die erfolgreiche Datenextraktion von MakerWorld.

Mobile User-Agents emulieren

Mobile Layouts sind oft weniger komplex und können manchmal aggressive Anti-Bot-Maßnahmen umgehen, die für Desktop-Browser entwickelt wurden.

Sitemaps für direkte URLs nutzen

Prüfen Sie die /sitemap.xml, um direkte model-URLs zu finden; dies ist effizienter als das Crawlen von Suchergebnissen und verringert das Risiko, blockiert zu werden.

Stabile Attribute anvisieren

Konzentrieren Sie sich auf data-testid oder stabile strukturelle HTML-Attribute anstelle von dynamischen Klassennamen, um sicherzustellen, dass Ihr Scraper nach UI-Updates robust bleibt.

Interaktionsmuster randomisieren

Vermeiden Sie statische Muster, indem Sie Ihre Wartezeiten zwischen Klicks oder Scroll-Vorgängen auf zufällige Intervalle zwischen 5 und 15 Sekunden einstellen, um menschliches Verhalten zu simulieren.

Premium Residential Proxies rotieren

Verwenden Sie hochwertige Residential IPs, um eine Entdeckung zu vermeiden, da Datencenter-Proxies häufig von Cloudflare markiert und blockiert werden.

Interne JSON-Endpunkte überwachen

Untersuchen Sie den Netzwerkverkehr, um interne API-Aufrufe zu finden, die strukturierte JSON-Daten zurückgeben, welche oft einfacher zu parsen sind als HTML.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape American Museum of Natural History (AMNH)

Häufig gestellte Fragen zu MakerWorld

Finden Sie Antworten auf häufige Fragen zu MakerWorld