So scrapen Sie SeLoger Bureaux & Commerces

Erfahren Sie, wie Sie SeLoger Bureaux & Commerces für Gewerbeimmobiliendaten scrapen. Extrahieren Sie Preise, Flächen und Agenturinfos, während Sie...

Anti-Bot-Schutz erkannt

- DataDome

- Echtzeit-Bot-Erkennung mit ML-Modellen. Analysiert Geräte-Fingerabdruck, Netzwerksignale und Verhaltensmuster. Häufig auf E-Commerce-Seiten.

- Cloudflare

- Enterprise-WAF und Bot-Management. Nutzt JavaScript-Challenges, CAPTCHAs und Verhaltensanalyse. Erfordert Browser-Automatisierung mit Stealth-Einstellungen.

- Google reCAPTCHA

- Googles CAPTCHA-System. v2 erfordert Benutzerinteraktion, v3 läuft unsichtbar mit Risikobewertung. Kann mit CAPTCHA-Diensten gelöst werden.

- Rate Limiting

- Begrenzt Anfragen pro IP/Sitzung über Zeit. Kann mit rotierenden Proxys, Anfrageverzögerungen und verteiltem Scraping umgangen werden.

- IP-Blockierung

- Blockiert bekannte Rechenzentrums-IPs und markierte Adressen. Erfordert Residential- oder Mobile-Proxys zur effektiven Umgehung.

- Browser-Fingerprinting

- Identifiziert Bots anhand von Browser-Eigenschaften: Canvas, WebGL, Schriftarten, Plugins. Erfordert Spoofing oder echte Browser-Profile.

Über SeLoger Bureaux & Commerces

Entdecken Sie, was SeLoger Bureaux & Commerces bietet und welche wertvollen Daten extrahiert werden können.

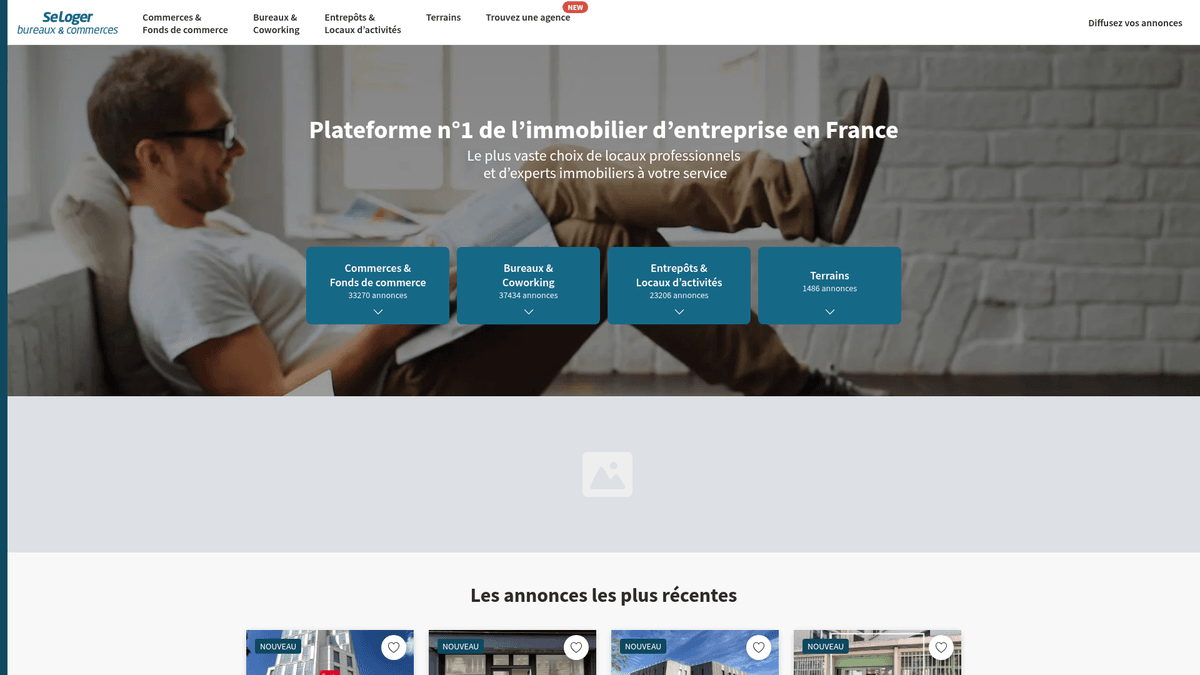

Der Marktführer für französische Gewerbeimmobilien

SeLoger Bureaux & Commerces ist das spezialisierte Portal für Gewerbeimmobilien der SeLoger Group, dem führenden Immobiliennetzwerk in Frankreich. Es dient als dedizierter Marktplatz für B2B-Transaktionen und umfasst Büroflächen, Lagerhallen, Ladenlokale und gewerbliche Baugrundstücke. Die Plattform wird von großen nationalen Agenturen und unabhängigen Maklern genutzt, um mit professionellen Investoren und Geschäftsinhabern im ganzen Land in Kontakt zu treten.

Wert der Daten

Das Scrapen dieser Website ist äußerst wertvoll für Immobilieninvestoren und Marktanalysten, die die französische Gewerbeimmobilienlandschaft überwachen müssen. Durch das Extrahieren aktueller Listungsdaten können Unternehmen Trends beim Preis pro Quadratmeter verfolgen, aufstrebende Gewerbezentren identifizieren und die Portfolios von Wettbewerbern überwachen. Diese Daten sind essenziell für präzise Immobilienbewertungen und die Identifizierung hochrentabler Investment-Möglichkeiten auf dem französischen Markt.

Warum SeLoger Bureaux & Commerces Scrapen?

Entdecken Sie den Geschäftswert und die Anwendungsfälle für die Datenextraktion von SeLoger Bureaux & Commerces.

Analyse der gewerblichen Rendite

Verfolgen Sie Mietrenditen und Verkaufspreise, um die profitabelsten Regionen für Investitionen in Gewerbeimmobilien in ganz Frankreich zu identifizieren.

Bestandstracking der Konkurrenz

Überwachen Sie die Portfoliogrößen und den Umschlag von Anzeigen konkurrierender Immobilienagenturen, um deren Marktanteil in bestimmten Städten und Departements zu bewerten.

Leads für Unternehmensumzüge

Identifizieren Sie Unternehmen, die Büros räumen oder in neue Räumlichkeiten ziehen, um B2B-Dienstleistungen wie professionelle Umzüge, Innenausbau oder Unternehmensversicherungen anzubieten.

Erkenntnisse zur Stadtentwicklung

Sammeln Sie Daten über Leerstandsquoten im Einzelhandel und Ladendichte, um Stadtplanungsprojekte und lokale Wirtschaftsentwicklungsstrategien für Kommunen zu unterstützen.

Preisalarme in Echtzeit

Überwachen Sie bestimmte hochfrequentierte Departements auf neue Anzeigen, die unter dem Marktdurchschnitt liegen, um von unterbewerteten gewerblichen Investmentmöglichkeiten zu profitieren.

Scraping-Herausforderungen

Technische Herausforderungen beim Scrapen von SeLoger Bureaux & Commerces.

Fortschrittlicher DataDome-Schutz

Die Plattform nutzt DataDome, um Mausbewegungen, Hardware-Signaturen und Verhaltensmuster zu analysieren und automatisierte Besucher sofort zu blockieren.

Cloudflare WAF-Filter

Aggressive Firewall-Regeln identifizieren und verwerfen Anfragen von Rechenzentren oder solche mit inkonsistenten TLS-Fingerprints, die nicht mit echten Browsern übereinstimmen.

JavaScript-lastiges Rendering

Da es sich um eine moderne Next.js-Anwendung handelt, sind die Inhalte dynamisch. Das bedeutet, dass Standard-HTML-Scraper oft leere Tags anstelle der tatsächlichen Anzeigendaten sehen.

Begrenzung der Paginierung

Suchergebnisse sind oft auf maximal 1.000 Anzeigen begrenzt, was granulare Suchanfragen nach Postleitzahlen erfordert, um den vollständigen Datensatz zu extrahieren.

Versteckte Kontaktelemente

Telefonnummern von Maklern sind häufig hinter interaktiven Schaltflächen verborgen, die spezifische Event-Trigger erfordern, um die zugrunde liegenden Kontaktdaten preiszugeben.

Scrape SeLoger Bureaux & Commerces mit KI

Kein Code erforderlich. Extrahiere Daten in Minuten mit KI-gestützter Automatisierung.

So funktioniert's

Beschreibe, was du brauchst

Sag der KI, welche Daten du von SeLoger Bureaux & Commerces extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

KI extrahiert die Daten

Unsere künstliche Intelligenz navigiert SeLoger Bureaux & Commerces, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

Erhalte deine Daten

Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Warum KI zum Scraping nutzen

KI macht es einfach, SeLoger Bureaux & Commerces zu scrapen, ohne Code zu schreiben. Unsere KI-gestützte Plattform nutzt künstliche Intelligenz, um zu verstehen, welche Daten du möchtest — beschreibe es einfach in natürlicher Sprache und die KI extrahiert sie automatisch.

How to scrape with AI:

- Beschreibe, was du brauchst: Sag der KI, welche Daten du von SeLoger Bureaux & Commerces extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

- KI extrahiert die Daten: Unsere künstliche Intelligenz navigiert SeLoger Bureaux & Commerces, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

- Erhalte deine Daten: Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Why use AI for scraping:

- Integrierte Anti-Bot-Umgehung: Automatio nutzt fortschrittliche Technologie, um menschliche Hardware- und Browser-Signaturen zu imitieren, sodass Sie DataDome und Cloudflare ohne Konfiguration umgehen können.

- No-Code visuelle Auswahl: Die visuelle Benutzeroberfläche ermöglicht es Ihnen, Preise, Flächen und Energieeffizienzklassen per Mausklick auszuwählen, ohne komplexen Code schreiben oder warten zu müssen.

- Integration französischer Proxies: Verbinden Sie ganz einfach französische Residential-Proxies, um sicherzustellen, dass Ihre Scraping-Sessions wie legitimer lokaler Traffic aus dem Zielland erscheinen.

- Automatisierte mehrstufige Flows: Erstellen Sie komplexe Sequenzen, die das Klicken auf versteckte Schaltflächen und das Navigieren durch tiefe Paginierungsstrukturen automatisch in der Cloud beinhalten.

No-Code Web Scraper für SeLoger Bureaux & Commerces

Point-and-Click-Alternativen zum KI-gestützten Scraping

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von SeLoger Bureaux & Commerces helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

Häufige Herausforderungen

Lernkurve

Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

Selektoren brechen

Website-Änderungen können den gesamten Workflow zerstören

Probleme mit dynamischen Inhalten

JavaScript-lastige Seiten erfordern komplexe Workarounds

CAPTCHA-Einschränkungen

Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

IP-Sperrung

Aggressives Scraping kann zur Sperrung Ihrer IP führen

No-Code Web Scraper für SeLoger Bureaux & Commerces

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von SeLoger Bureaux & Commerces helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

- Browser-Erweiterung installieren oder auf der Plattform registrieren

- Zur Zielwebseite navigieren und das Tool öffnen

- Per Point-and-Click die zu extrahierenden Datenelemente auswählen

- CSS-Selektoren für jedes Datenfeld konfigurieren

- Paginierungsregeln zum Scrapen mehrerer Seiten einrichten

- CAPTCHAs lösen (erfordert oft manuelle Eingabe)

- Zeitplanung für automatische Ausführungen konfigurieren

- Daten als CSV, JSON exportieren oder per API verbinden

Häufige Herausforderungen

- Lernkurve: Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

- Selektoren brechen: Website-Änderungen können den gesamten Workflow zerstören

- Probleme mit dynamischen Inhalten: JavaScript-lastige Seiten erfordern komplexe Workarounds

- CAPTCHA-Einschränkungen: Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

- IP-Sperrung: Aggressives Scraping kann zur Sperrung Ihrer IP führen

Code-Beispiele

import requests

from bs4 import BeautifulSoup

# Hinweis: SeLoger verwendet DataDome; Standard-Requests werden wahrscheinlich blockiert.

# Spezialisierte Bibliotheken wie curl_cffi werden für TLS-Fingerprinting empfohlen.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Verwendung von impersonate, um TLS-Fingerprinting-Blockaden zu umgehen

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Beispiel-Selektor für Immobilientitel

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Inserat: {title.get_text(strip=True)}')

else:

print(f'Blockiert durch Anti-Bot. Status-Code: {response.status_code}')

except Exception as e:

print(f'Fehler aufgetreten: {e}')Wann verwenden

Am besten für statische HTML-Seiten, bei denen Inhalte serverseitig geladen werden. Der schnellste und einfachste Ansatz, wenn kein JavaScript-Rendering erforderlich ist.

Vorteile

- ●Schnellste Ausführung (kein Browser-Overhead)

- ●Geringster Ressourcenverbrauch

- ●Einfach zu parallelisieren mit asyncio

- ●Ideal für APIs und statische Seiten

Einschränkungen

- ●Kann kein JavaScript ausführen

- ●Scheitert bei SPAs und dynamischen Inhalten

- ●Kann bei komplexen Anti-Bot-Systemen Probleme haben

Wie man SeLoger Bureaux & Commerces mit Code scrapt

Python + Requests

import requests

from bs4 import BeautifulSoup

# Hinweis: SeLoger verwendet DataDome; Standard-Requests werden wahrscheinlich blockiert.

# Spezialisierte Bibliotheken wie curl_cffi werden für TLS-Fingerprinting empfohlen.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Verwendung von impersonate, um TLS-Fingerprinting-Blockaden zu umgehen

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Beispiel-Selektor für Immobilientitel

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Inserat: {title.get_text(strip=True)}')

else:

print(f'Blockiert durch Anti-Bot. Status-Code: {response.status_code}')

except Exception as e:

print(f'Fehler aufgetreten: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_bucom():

async with async_playwright() as p:

# Headless=False hilft, einige grundlegende Bot-Erkennungs-Trigger zu vermeiden

browser = await p.chromium.launch(headless=False)

context = await browser.new_context(

user_agent='Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36'

)

page = await context.new_page()

try:

# Ziel: spezifische Gewerbekategorie und Stadt

await page.goto('https://www.seloger-bureaux-commerces.com/achat/bureau/lyon', wait_until='networkidle')

# Warten, bis Inseratskarten gerendert sind

await page.wait_for_selector('div[data-testid="listing-card"]', timeout=15000)

listings = await page.query_selector_all('div[data-testid="listing-card"]')

for card in listings:

title = await card.query_selector('h2')

price = await card.query_selector('span[class*="Price"]')

print(f"Titel: {await title.inner_text()} | Preis: {await price.inner_text()}")

except Exception as e:

print(f'Scraping fehlgeschlagen: {e}')

finally:

await browser.close()

asyncio.run(scrape_bucom())Python + Scrapy

import scrapy

class SeLogerBucomSpider(scrapy.Spider):

name = 'bucom_spider'

allowed_domains = ['seloger-bureaux-commerces.com']

start_urls = ['https://www.seloger-bureaux-commerces.com/location/boutique']

custom_settings = {

'DOWNLOAD_DELAY': 5,

'RANDOMIZE_DOWNLOAD_DELAY': True,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'COOKIES_ENABLED': True

}

def parse(self, response):

# Extrahiere Daten aus dem Container der Ergebnisliste

for listing in response.css('div[class*="Card_container"]'):

yield {

'title': listing.css('h2::text').get(),

'price': listing.css('span[class*="Price"]::text').get(),

'surface': listing.css('span[class*="Surface"]::text').get(),

'link': listing.css('a::attr(href)').get()

}

# Einfache Handhabung der Paginierung

next_page = response.css('a[class*="PaginationNext"]::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer-extra');

const StealthPlugin = require('puppeteer-extra-plugin-stealth');

puppeteer.use(StealthPlugin());

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Simuliere menschliches Verhalten mit Viewport und Agent

await page.setViewport({ width: 1280, height: 800 });

try {

await page.goto('https://www.seloger-bureaux-commerces.com/location/bureau/paris', {

waitUntil: 'networkidle2'

});

const results = await page.evaluate(() => {

return Array.from(document.querySelectorAll('a[class*="Card_title"]')).map(el => ({

title: el.innerText,

url: el.href

}));

});

console.log(results);

} catch (err) {

console.error('Extraktionsfehler:', err);

} finally {

await browser.close();

}

})();Was Sie mit SeLoger Bureaux & Commerces-Daten machen können

Entdecken Sie praktische Anwendungen und Erkenntnisse aus SeLoger Bureaux & Commerces-Daten.

Mietpreisindex für Gewerbeimmobilien

Erstellen Sie eine Benchmark für Gewerbemieten in verschiedenen französischen Departements zur Immobilienbewertung.

So implementieren Sie es:

- 1Scrapen Sie monatlich alle aktiven Inserate für Zielregionen.

- 2Bereinigen und normalisieren Sie Preis- und Flächenangaben in eine Standardeinheit.

- 3Aggregieren Sie den durchschnittlichen Preis pro Quadratmeter nach Stadt und Immobilientyp.

- 4Visualisieren Sie Trends in einem BI-Tool wie Tableau oder PowerBI.

Verwenden Sie Automatio, um Daten von SeLoger Bureaux & Commerces zu extrahieren und diese Anwendungen ohne Code zu erstellen.

Was Sie mit SeLoger Bureaux & Commerces-Daten machen können

- Mietpreisindex für Gewerbeimmobilien

Erstellen Sie eine Benchmark für Gewerbemieten in verschiedenen französischen Departements zur Immobilienbewertung.

- Scrapen Sie monatlich alle aktiven Inserate für Zielregionen.

- Bereinigen und normalisieren Sie Preis- und Flächenangaben in eine Standardeinheit.

- Aggregieren Sie den durchschnittlichen Preis pro Quadratmeter nach Stadt und Immobilientyp.

- Visualisieren Sie Trends in einem BI-Tool wie Tableau oder PowerBI.

- Überwachung von Wettbewerbsagenturen

Verfolgen Sie den Bestand und die Performance konkurrierender Immobilienagenturen auf dem französischen Markt.

- Extrahieren Sie Namen von Maklern/Agenturen und Referenznummern der Immobilien.

- Identifizieren Sie, wie lange Immobilien gelistet bleiben, bevor sie entfernt werden.

- Analysieren Sie den Marktanteil spezifischer Agenturen in hochwertigen Vierteln.

- Erstellen Sie Berichte über Preisstrategien der Wettbewerber.

- B2B-Relocation Lead-Generierung

Identifizieren Sie Unternehmen, die wahrscheinlich umziehen oder in neue Büroflächen expandieren.

- Filtern Sie nach Inseraten, die als 'Neu' oder 'Sofort verfügbar' markiert sind.

- Überwachen Sie spezifische Bürogebäude, um zu sehen, wann aktuelle Mieter ausziehen.

- Gleichen Sie gescrapte Adressen mit Unternehmensdatenbanken ab.

- Kontaktieren Sie umziehende Unternehmen mit maßgeschneiderten Serviceangeboten.

- Erkennung von Investment-Arbitrage

Markieren Sie automatisch Immobilien, die deutlich unter dem lokalen Marktdurchschnitt gelistet sind.

- Erstellen Sie Basis-Durchschnittswerte mit historischen Scraping-Daten aus 6 Monaten.

- Richten Sie einen täglichen Scraper für neue Gewerbeinserate ein.

- Berechnen Sie den Preis pro m² für jedes neue Inserat und vergleichen Sie ihn mit dem Basiswert.

- Lösen Sie eine sofortige E-Mail-Benachrichtigung für Inserate aus, die 20 % unter dem Durchschnitt liegen.

- Expansionsplanung für den Einzelhandel

Finden Sie den idealen Standort für neue Ladenlokale basierend auf Verfügbarkeit und Nachbarschaftskosten.

- Scrapen Sie die Verfügbarkeit von Ladenlokalen (Boutiquen) in mehreren Stadtzentren.

- Kartieren Sie die Dichte verfügbarer Gewerbeflächen mittels GPS-Daten.

- Analysieren Sie die Korrelation zwischen Passantenfrequenz-Proxies und Mietpreisen.

- Exportieren Sie die Ergebnisse in ein GIS-System für räumliche Analysen.

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Profi-Tipps für das Scrapen von SeLoger Bureaux & Commerces

Expertentipps für die erfolgreiche Datenextraktion von SeLoger Bureaux & Commerces.

Fokus auf französische Residential-IPs

Die Verwendung lokaler französischer Residential-Proxies ist der effektivste Weg, um Geolocation-basierte Blockaden zu vermeiden und das Auftreten von Captchas zu reduzieren.

JSON-LD Metadaten extrahieren

Suchen Sie im Quellcode der Seite nach schema.org-Daten, da diese oft eine sauberere und strukturiertere Version der Immobiliendetails liefern.

Interaktives Verhalten randomisieren

Implementieren Sie zufällige Pausen und variierende Scroll-Geschwindigkeiten, damit Ihre automatisierten Browser-Sessions von echten menschlichen Marktforschern nicht zu unterscheiden sind.

Suchbereiche unterteilen

Anstatt ganze Regionen zu durchsuchen, sollten Sie nach einzelnen Postleitzahlen scrapen, um sicherzustellen, dass Sie nicht an das Limit für die Sichtbarkeit der Ergebnisse stoßen.

Synchronisierung mit der Seitenstruktur

Überwachen Sie die Website alle paar Wochen auf Layout-Updates, da die Plattform häufig CSS-Klassen anpasst, um statische Methoden zur Datenextraktion zu unterbinden.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Häufig gestellte Fragen zu SeLoger Bureaux & Commerces

Finden Sie Antworten auf häufige Fragen zu SeLoger Bureaux & Commerces