Съвети за персонализиране на шаблона на YCombinator Scraper

1. Добавяне на повече действия за извличане на допълнителна информация

За да съберете повече данни от уебсайта YCombinator, можете да актуализирате скрипта на скрепера, за да включите допълнителни действия. Обичайните части от информацията, които може да искате да извлечете, включват:

- Описания на компаниите: Намерете HTML тага или класа, който съдържа описанието на всяка компания.

- Информация за основателите: Идентифицирайте тага или класа, в който се споменава информация за основателя.

- Данни за финансирането: Обърнете внимание на раздела или атрибутите, които показват информация за финансирането.

За да добавите тези действия:

- Разгледайте уебстраницата: Отворете уебстраницата в браузъра и използвайте инструменти като Chrome DevTools, за да проверите елементите, съдържащи желаната информация.

- Актуализирайте скрипта за скрепер: Модифицирайте скрипта, за да включи правила за извличане на тези нови елементи, обикновено чрез добавяне на нови редове код, които идентифицират и събират тези елементи.

Пример (ако приемем, че става въпрос за скрипт на Python):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

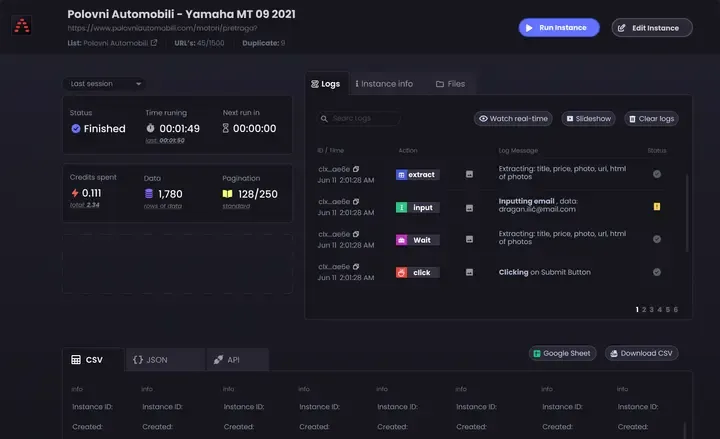

2. Настройване на периодично скрепиране

За да поддържате данните си актуални, настройте график за автоматично стартиране на скрепера. Това може да се направи с помощта на различни инструменти:

- Cron jobs (Linux): Насрочете скрипта да се изпълнява на определени интервали. Пример: За да стартирате скрепера всеки ден в полунощ:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Програмист на задачи (Windows): Подобно на задачите cron, планирайте скрепера да се изпълнява в определено време.

- Облачни услуги: Използвайте облачни услуги за планиране, като AWS CloudWatch Events, Google Cloud Scheduler или Heroku Scheduler, за да стартирате периодично скрепера си.

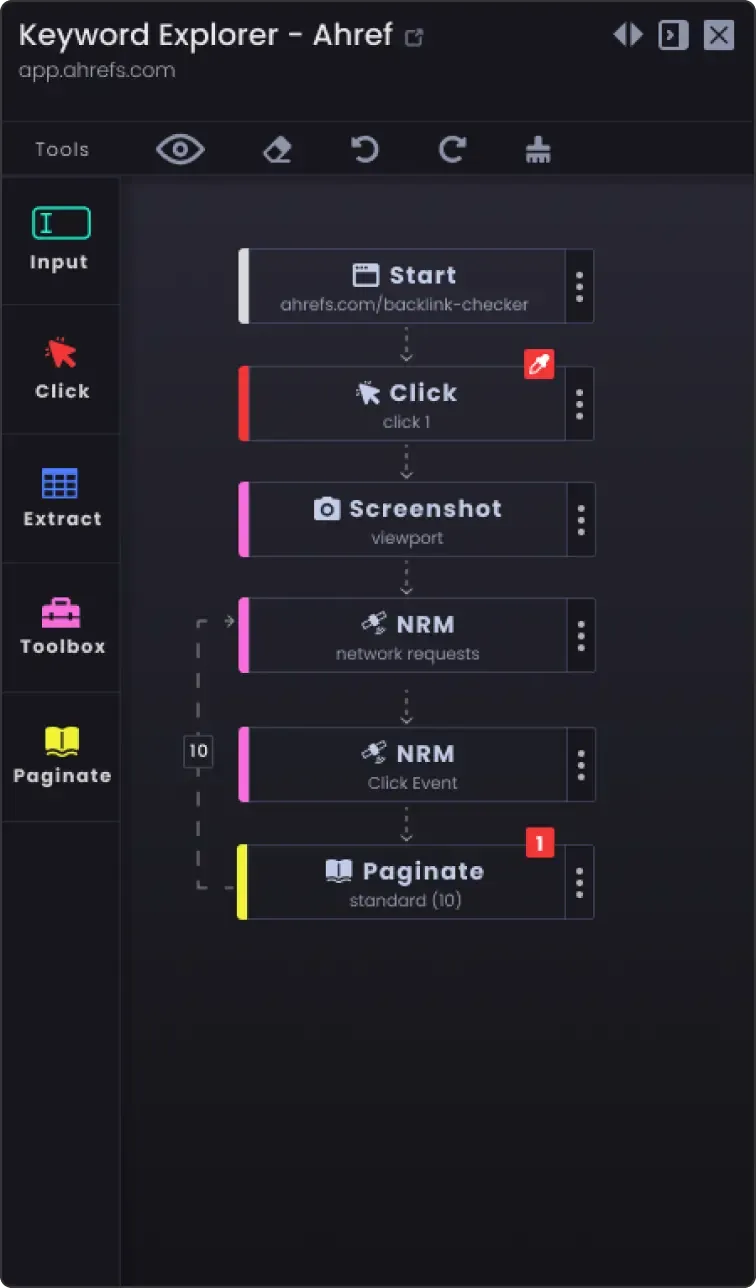

3. Възможност за страниране, за да сканирате повече от една страница

Уебсайтовете често разделят информацията на няколко страници. За да изстържете всички страници:

- Идентифицирайте механизма за странициране: Инспектирайте уебсайта, за да видите как се справя със страницирането (напр. бутон за следваща страница, номера на страници).

- Актуализирайте скрипта: Добавете логика в скрипта за навигация по страниците. Обикновено това включва увеличаване на номера на страницата в URL адреса или щракване върху бутона "следваща".

Пример (псевдокод на Python):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Няма повече данни за остъргване save_data(data) page_number += 1

4. Опции за персонализиране

- Обработка на грешки: Добавете обработка на грешки, за да гарантирате, че скреперът ще продължи да работи, дори ако се сблъска с проблеми като проблеми в мрежата или неочаквани промени в структурата на уебстраницата.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

Опции за съхранение на данни: Вземете решение къде и как да съхранявате иззетите данни. Опциите включват:

CSV файлове: Лесно се четат и записват с помощта на модула csv на Python.

Бази данни: Съхранявайте данните в бази данни като SQLite, MySQL или MongoDB за по-сложни заявки и по-добра цялост на данните.

Съхранение в облак: Записвайте данни в облачни услуги за съхранение като AWS S3 или Google Cloud Storage.

Почистване и валидиране на данни: Добавете стъпки за почистване и валидиране на набраните данни, за да се гарантира, че те са точни и използваеми.

if not company_name: continue # Пропуснете, ако липсва име на компания

- Регистриране: Въведете регистриране, за да проследявате напредъка на остъргването и всички срещнати проблеми. Използвайте модула за

регистриране на Python.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Като следвате тези съвети, можете да персонализирате шаблона за скрепер на YCombinator, за да отговаря на вашите специфични нужди, и да гарантирате, че събирате изчерпателна и актуална информация.