Sfaturi pentru personalizarea șablonului YCombinator Scraper

1. Adăugarea mai multor acțiuni pentru a extrage informații suplimentare

Pentru a colecta mai multe date de pe site-ul web YCombinator, puteți actualiza scriptul scraperului pentru a include acțiuni suplimentare. Printre informațiile comune pe care ați putea dori să le extrageți se numără:

- Descrieri ale companiilor: Localizați eticheta sau clasa HTML care conține descrierea fiecărei companii.

- Informații despre fondator: Identificați tag-ul sau clasa în care sunt menționate detaliile fondatorului.

- Detalii privind finanțarea: Rețineți secțiunea sau atributele care afișează informațiile privind finanțarea.

Pentru a adăuga aceste acțiuni:

- Inspectați pagina web: Deschideți pagina web într-un browser și utilizați instrumente precum Chrome DevTools pentru a inspecta elementele care conțin informațiile dorite.

- Actualizați scriptul scraper: Modificați scriptul pentru a include reguli de extragere pentru aceste noi elemente, de obicei prin adăugarea de noi linii de cod care identifică și colectează aceste elemente.

Exemplu (presupunând un script Python):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

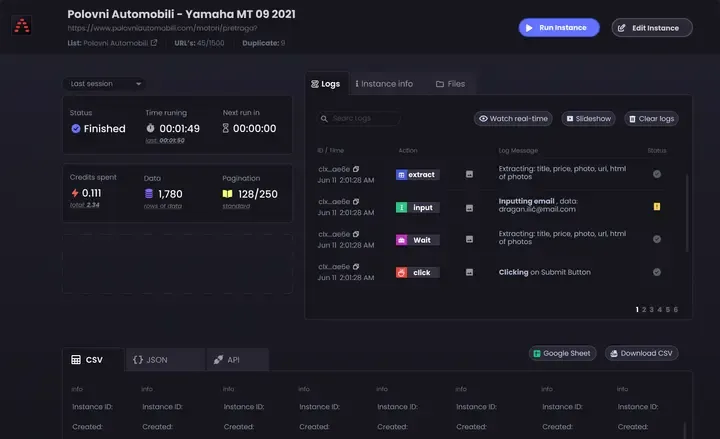

2. Configurarea Scraping-ului periodic

Pentru a vă menține datele actualizate, configurați un program pentru ca scraperul dvs. să ruleze automat. Acest lucru se poate face folosind diverse instrumente:

- Cron jobs (Linux): Programați scriptul să ruleze la anumite intervale. Exemplu: Pentru a rula scraperul zilnic la miezul nopții:

0 0 * * * * /usr/bin/python3 /path/to/your_scraper.py

- Programator de activități (Windows): Similar cu cron jobs, programați scraperul dvs. să ruleze la anumite ore.

- Servicii cloud: Utilizați servicii de programare bazate pe cloud, cum ar fi AWS CloudWatch Events, Google Cloud Scheduler sau Heroku Scheduler, pentru a rula periodic scraperul dvs.

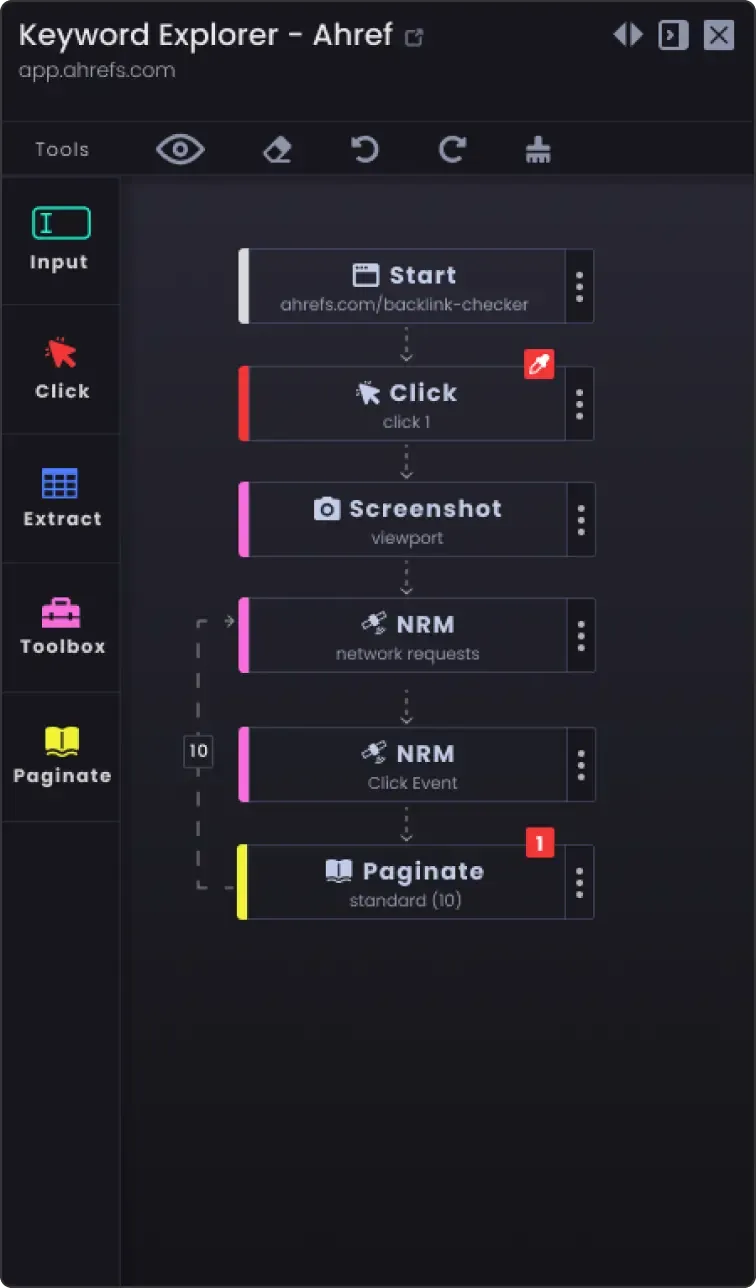

3. Opțiunea de paginare pentru a extrage mai mult de o pagină

Site-urile web împart adesea informațiile în mai multe pagini. Pentru a răzui toate paginile:

- Identificați mecanismul de paginare: Inspectați site-ul web pentru a vedea cum gestionează paginarea (de exemplu, butonul pagina următoare, numerele paginilor).

- Actualizați scriptul: Adăugați logică la scriptul dvs. pentru a naviga prin pagini. Aceasta implică, de obicei, incrementarea unui număr de pagină în URL sau apăsarea butonului "următor".

Exemplu (pseudocod Python):

page_number = 1 while True: url = f"https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # No more data to scrape save_data(data) page_number += 1

4. Opțiuni de personalizare

- Gestionarea erorilor: Adăugați gestionarea erorilor pentru a vă asigura că scraperul continuă să ruleze chiar dacă întâmpină probleme precum probleme de rețea sau modificări neașteptate în structura paginii web.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f"Error: {e}") continue

Opțiuni de stocare a datelor: Decideți unde și cum să stocați datele eliminate. Opțiunile includ:

Fișiere CSV: Ușor de citit și de scris folosind modulul csv din Python.

Baze de date: Stocați datele în baze de date precum SQLite, MySQL sau MongoDB pentru interogări mai complexe și o mai bună integritate a datelor.

Stocare în cloud: Salvați datele în servicii de stocare în cloud precum AWS S3 sau Google Cloud Storage.

Curățarea și validarea datelor: Adăugați pași pentru curățarea și validarea datelor răzuite pentru a vă asigura că acestea sunt exacte și utilizabile.

if not company_name: continue # Săriți peste dacă numele companiei lipsește

- Înregistrare: Implementați jurnalizarea pentru a ține evidența progresului scraping-ului și a oricăror probleme întâmpinate. Utilizați modulul de

logare Python.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Urmând aceste sfaturi, puteți personaliza șablonul YCombinator Scraper pentru a vă satisface nevoile specifice și pentru a vă asigura că colectați informații complete și actualizate.