Dicas para personalizar o modelo do raspador do YCombinator

1. Adicionar mais acções para extrair informações adicionais

Para recolher mais dados do site do YCombinator, pode atualizar o script do scraper para incluir acções adicionais. As informações comuns que você pode querer extrair incluem:

- Descrições da empresa: Localizar a tag ou classe HTML que contém a descrição de cada empresa.

- Informações do fundador: Identificar a etiqueta ou classe onde os detalhes do fundador são mencionados.

- Detalhes do financiamento: Anote a secção ou os atributos que apresentam as informações de financiamento.

Para adicionar estas acções:

- Inspecionar a página Web: Abra a página Web num browser e utilize ferramentas como o Chrome DevTools para inspecionar os elementos que contêm as informações pretendidas.

- Atualizar o script do scraper: Modificar o script para incluir regras de extração para estes novos elementos, normalmente adicionando novas linhas de código que identificam e recolhem estes elementos.

Exemplo (assumindo um script Python):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Configurar a raspagem periódica

Para manter seus dados atualizados, configure um cronograma para que seu raspador seja executado automaticamente. Isso pode ser feito usando várias ferramentas:

- Trabalhos Cron (Linux): Programe o script para ser executado em intervalos específicos. Exemplo: Para executar o scraper diariamente à meia-noite:

0 0 * * * * /usr/bin/python3 /path/to/your_scraper.py

- Agendador de tarefas (Windows): Semelhante aos trabalhos cron, agende seu raspador para ser executado em horários específicos.

- Serviços em nuvem: Use serviços de agendamento baseados em nuvem, como o AWS CloudWatch Events, o Google Cloud Scheduler ou o Heroku Scheduler para executar periodicamente seu raspador.

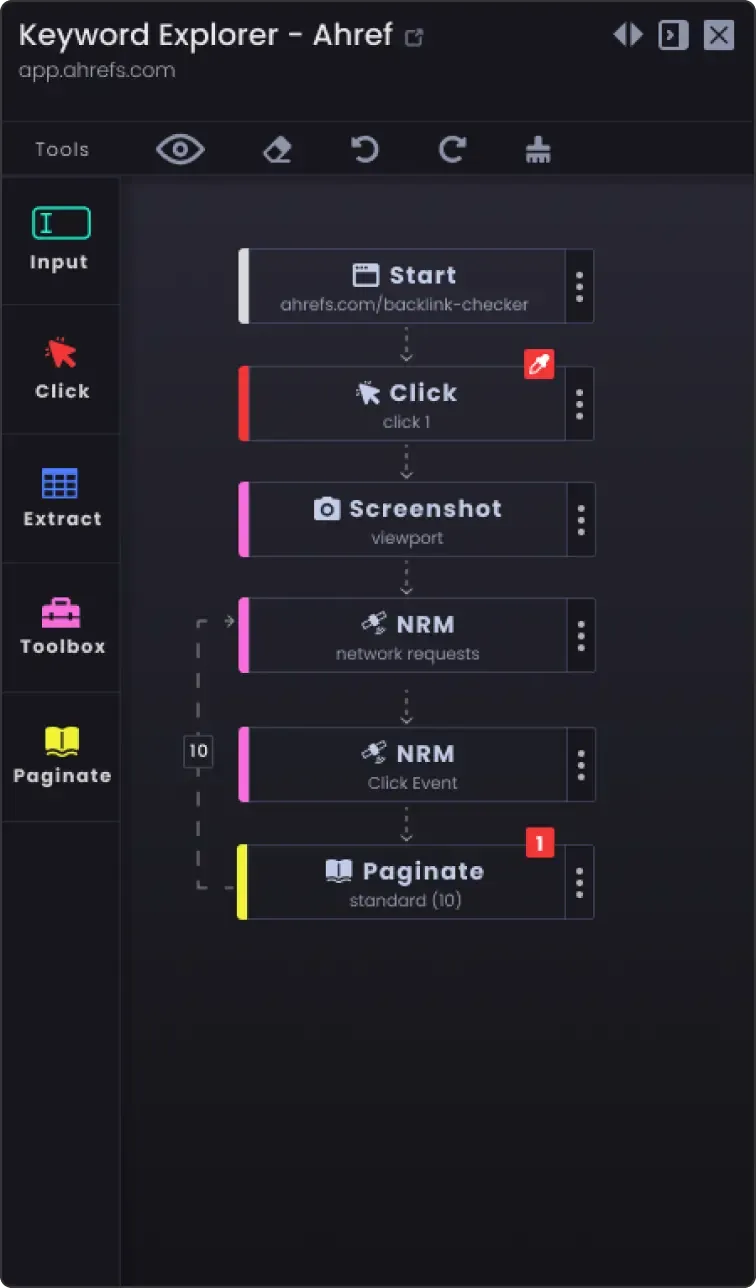

3. Opção de paginação para raspar mais do que uma página

Os sítios Web dividem frequentemente a informação em várias páginas. Para raspar todas as páginas:

- Identificar o mecanismo de paginação: Inspecionar o sítio Web para ver como lida com a paginação (por exemplo, botão de página seguinte, números de página).

- Atualizar o script: Adicione lógica ao seu script para navegar pelas páginas. Normalmente, isto envolve o incremento de um número de página no URL ou o clique no botão "seguinte".

Exemplo (pseudo-código Python):

número_de_pagina = 1 while True: url = f "https://example.com/companies?page={número_de_pagina}" response = requests.get(url) data = extract_data(response.text) if not data: break # Não há mais dados para extrair save_data(data) número_de_pagina += 1

4. Opções de personalização

- Tratamento de erros: Adicione o tratamento de erros para garantir que o raspador continua a funcionar mesmo que encontre problemas como problemas de rede ou alterações inesperadas na estrutura da página Web.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

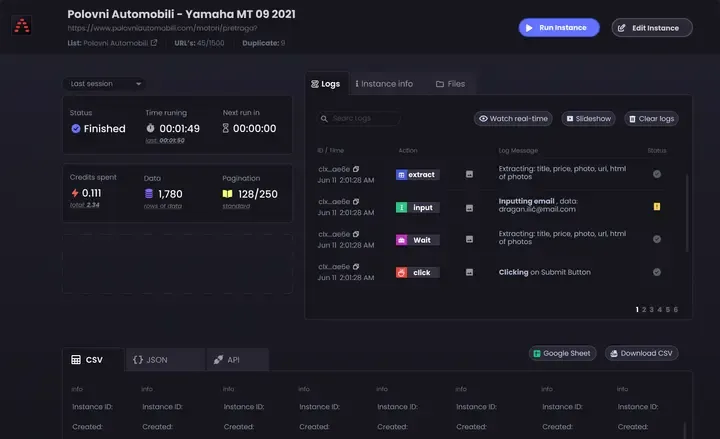

Opções de armazenamento de dados: Decidir onde e como armazenar os dados extraídos. As opções incluem:

Ficheiros CSV: Fáceis de ler e escrever utilizando o módulo csv do Python.

Bases de dados: Armazene os dados em bancos de dados como SQLite, MySQL ou MongoDB para consultas mais complexas e melhor integridade dos dados.

Armazenamento na nuvem: Guarde os dados em serviços de armazenamento na nuvem, como o AWS S3 ou o Google Cloud Storage.

Limpeza e validação de dados: Adicione passos para limpar e validar os dados extraídos para garantir que são exactos e utilizáveis.

if not company_name: continue # Ignorar se o nome da empresa estiver ausente

- Registo: Implemente o registo para acompanhar o progresso da recolha de dados e quaisquer problemas encontrados. Utilize o módulo

de registo do Python.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Raspagem da página {número_da_página}')

Seguindo estas sugestões, pode personalizar o YCombinator Scraper Template para satisfazer as suas necessidades específicas e garantir a recolha de informações completas e actualizadas.