Automate Anything on the Web! Build powerful web bots, scrape data, and automate repetitive tasks with AI and without writing code.

Try Automatio.ai for Free! →

黑客新闻 - Post URL Scraper

Automate 黑客新闻 - Post URL Scraper using pre-made template in just a few clicks

Automate NowTry it for free, no credit card required 👌

定制提示

定制 YCombinator Scraper 模板的技巧

1.添加更多操作以提取更多信息

要从 YCombinator 网站上收集更多数据,可以更新刮板脚本,加入更多操作。你可能想提取的常见信息包括

- 公司描述:找到包含每家公司描述的 HTML 标签或类。

- 创始人信息:确定提及创始人详细信息的标签或类。

- 资金详情:注意显示资金信息的部分或属性。

添加这些操作

- 检查网页:在浏览器中打开网页,使用 Chrome DevTools 等工具检查包含所需信息的元素。

- 更新刮板脚本:修改脚本以包含这些新元素的提取规则,通常是通过添加新的代码行来识别和收集这些元素。

示例(假设使用 Python 脚本):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text2.设置定期抓取

为了保持数据的最新状态,请为您的搜索器设置一个自动运行时间表。这可以使用各种工具来完成:

- Cron 作业(Linux):例如,要在每天午夜运行刮擦程序,可使用以下工具: Cron jobs(Linux):安排脚本在特定时间间隔运行:每天午夜运行刮擦程序:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py- 任务调度程序(Windows):与 cron 作业类似,可安排刮板在特定时间运行。

- 云服务:使用基于云的调度服务,如 AWS CloudWatch Events、Google Cloud Scheduler 或 Heroku Scheduler,定期运行刮板。

3.分页选项可抓取多个页面

网站通常会将信息分割成多个页面。要抓取所有页面,需要

- 确定分页机制:检查网站,查看它是如何处理分页的(例如,下一页按钮、页码)。

- 更新脚本:在脚本中添加浏览页面的逻辑。这通常涉及递增 URL 中的页码或点击 "下一页 "按钮。

示例(Python 伪代码):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # 没有更多数据要抓取 save_data(data) page_number += 14.自定义选项

- 错误处理:添加错误处理,确保即使遇到网络问题或网页结构意外更改等问题,刮擦程序也能继续运行。

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue数据存储选项:决定在何处以及如何存储报废数据。选项包括

CSV 文件:使用 Python 的

csv模块可轻松读写。数据库:将数据存储在 SQLite、MySQL 或 MongoDB 等数据库中,以实现更复杂的查询和更好的数据完整性。

云存储:将数据保存到 AWS S3 或 Google Cloud Storage 等云存储服务中。

数据清理和验证:添加清理和验证刮擦数据的步骤,以确保数据的准确性和可用性。

if not company_name: continue # 如果缺少公司名称,则跳过- 记录日志:实施日志记录,以跟踪刮擦进度和遇到的任何问题。使用 Python 的

日志模块。

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')按照这些提示,您可以定制 YCombinator 刮板模板,以满足您的特定需求,确保您收集到全面的最新信息。

Table of Content

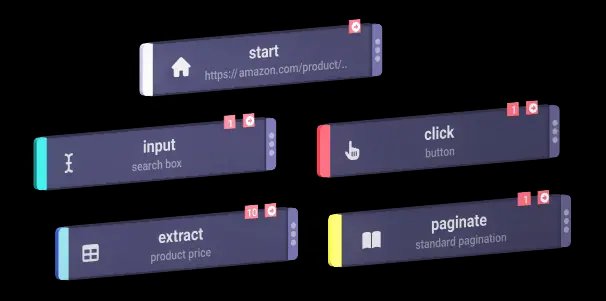

Action List

- start

- extract

- extract

- extract

- extract

- extract

- extract

- extract

- extract

- extract

- extract

- paginate