Patarimai, kaip pritaikyti "YCombinator Scraper" šabloną

1. Pridėti daugiau veiksmų papildomai informacijai išgauti

Norėdami surinkti daugiau duomenų iš "YCombinator" svetainės, galite atnaujinti skreperio scenarijų ir įtraukti papildomų veiksmų. Įprasta informacija, kurią galite norėti išgauti, yra tokia:

- Įmonių aprašymai: Suraskite HTML žymą arba klasę, kurioje yra kiekvienos įmonės aprašymas.

- Informacija apie steigėjus: Nustatykite žymą arba klasę, kurioje minima informacija apie steigėją.

- Informacija apie finansavimą: Atkreipkite dėmesį į skirsnį arba atributus, kuriuose pateikiama finansavimo informacija.

Norėdami pridėti šiuos veiksmus:

- Apžiūrėkite tinklalapį: Atidarykite tinklalapį naršyklėje ir naudodamiesi tokiomis priemonėmis kaip "Chrome DevTools" apžiūrėkite elementus, kuriuose pateikiama norima informacija.

- Atnaujinkite skreperio scenarijų: Pakeiskite scenarijų, kad į jį būtų įtrauktos šių naujų elementų ištraukimo taisyklės, paprastai pridėdami naujų kodo eilučių, kuriomis šie elementai nustatomi ir surenkami.

Pavyzdys (daroma prielaida, kad tai "Python" scenarijus):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Periodinio nuskaitymo nustatymas

Kad duomenys būtų nuolat atnaujinami, nustatykite tvarkaraštį, pagal kurį grandiklis būtų paleidžiamas automatiškai. Tai galima padaryti naudojant įvairius įrankius:

- "Cron jobs" (Linux): Planuokite scenarijų paleisti tam tikrais intervalais: Norėdami paleisti grandiklį kasdien vidurnaktį:

/usr/bin/python3 /path/to/your_scraper.py

- Užduočių planuoklis (Windows): Panašiai kaip "cron" užduočių atveju, suplanuokite, kad grandiklis būtų paleistas tam tikru laiku.

- Debesijos paslaugos: Naudokite debesų planavimo paslaugas, pavyzdžiui, "AWS CloudWatch Events", "Google Cloud Scheduler" arba "Heroku Scheduler", kad periodiškai paleistumėte savo grandiklį.

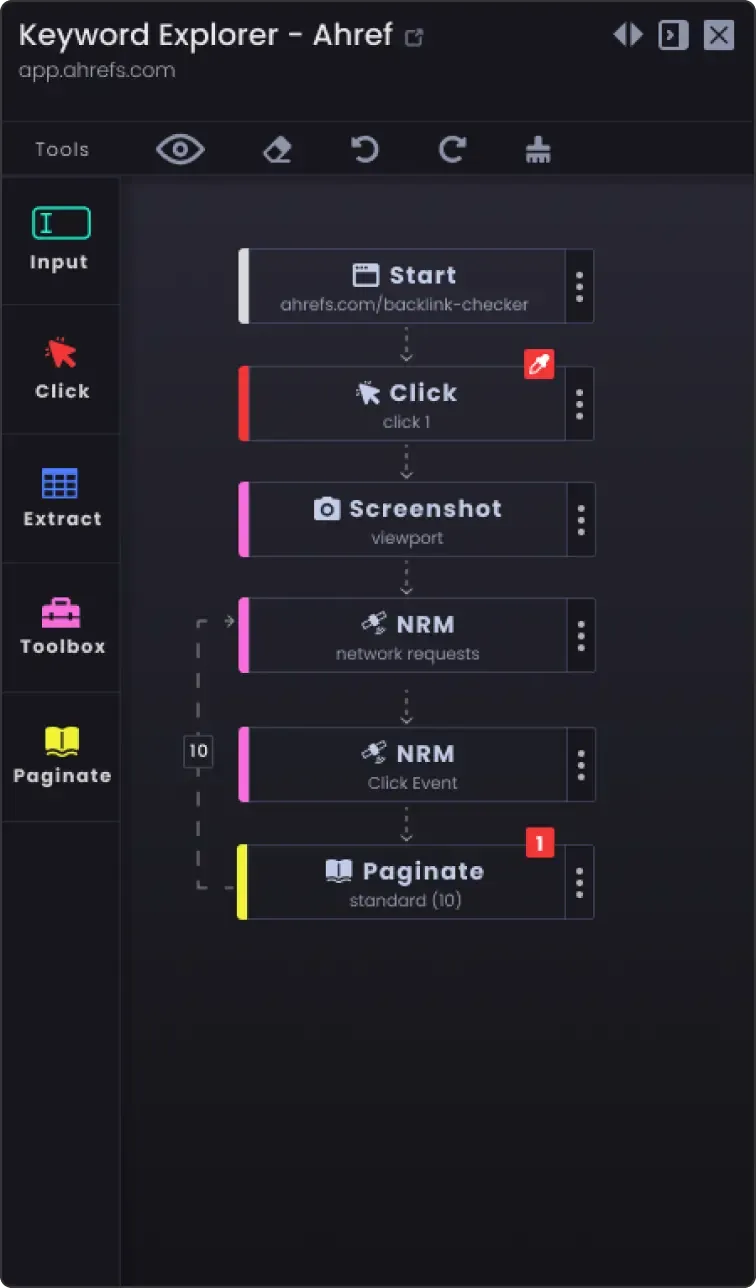

3. Puslapių žymėjimo parinktis, kad galėtumėte nuskaityti daugiau nei vieną puslapį

Interneto svetainėse informacija dažnai suskaidoma į kelis puslapius. Norėdami nuskaityti visus puslapius:

- Nustatykite puslapiavimo mechanizmą: Patikrinkite svetainę ir sužinokite, kaip joje tvarkomas puslapiavimas (pvz., kito puslapio mygtukas, puslapių numeriai).

- Atnaujinkite scenarijų: Į scenarijų įtraukite logiką, kad galėtumėte naršyti po puslapius. Paprastai tai apima puslapio numerio didinimą URL arba mygtuko "Kitas" paspaudimą.

Pavyzdys (Python pseudokodas):

puslapio_numeris = 1 while True: url = f "https://example.com/companies?page={straipo_numeris}" response = requests.get(url) data = extract_data(response.text) if not data: break # Daugiau duomenų nebereikia nuskaityti save_data(data) page_number += 1

4. Pritaikymo parinktys

- Klaidų tvarkymas: Pridėkite klaidų tvarkymą, kad užtikrintumėte, jog grandiklis toliau veiktų, net jei susiduriama su tokiomis problemomis kaip tinklo problemos ar netikėti tinklalapio struktūros pokyčiai.

bandymas: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

Duomenų saugojimo parinktys: Nuspręskite, kur ir kaip saugoti ištrintus duomenis. Pasirinktys:

CSV failai: Lengva skaityti ir rašyti naudojant "Python" csv modulį.

Duomenų bazės: Duomenys saugomi duomenų bazėse, pavyzdžiui, SQLite, MySQL arba MongoDB, kad būtų galima atlikti sudėtingesnes užklausas ir užtikrinti geresnį duomenų vientisumą.

Debesų saugykla: Įrašykite duomenis į debesų saugyklas, pavyzdžiui, AWS S3 arba "Google Cloud Storage".

Duomenų valymas ir patvirtinimas: Įtraukite veiksmus, kuriais valomi ir patvirtinami nuskaityti duomenys, kad jie būtų tikslūs ir tinkami naudoti.

if not company_name: continue # Praleiskite, jei nėra įmonės pavadinimo

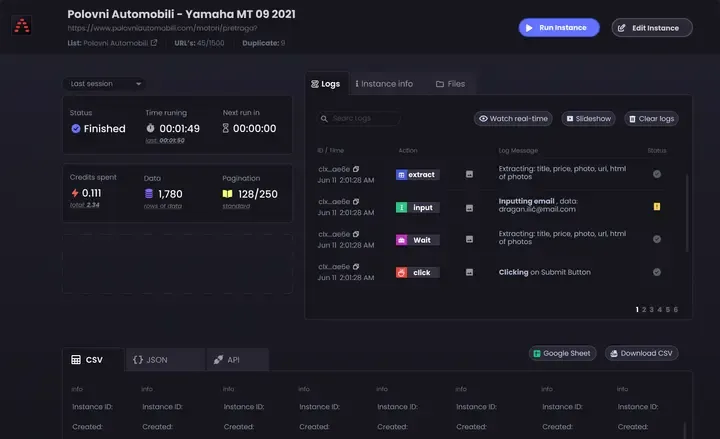

- Registravimas: Įdiekite registravimą, kad galėtumėte sekti duomenų nuskaitymo eigą ir visas iškilusias problemas. Naudokite "Python"

registravimo modulį.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Laikydamiesi šių patarimų, galite pritaikyti "YCombinator Scraper" šabloną pagal savo konkrečius poreikius ir užtikrinti, kad rinksite išsamią ir naujausią informaciją.