Tipps zur Anpassung der YCombinator Scraper-Vorlage

1. Hinzufügen weiterer Aktionen zum Extrahieren zusätzlicher Informationen

Um mehr Daten von der YCombinator-Website zu sammeln, können Sie das Scraper-Skript aktualisieren und zusätzliche Aktionen hinzufügen. Zu den üblichen Informationen, die Sie extrahieren möchten, gehören:

- Unternehmensbeschreibungen: Suchen Sie den HTML-Tag oder die Klasse, die die Beschreibung der einzelnen Unternehmen enthält.

- Informationen über den Firmengründer: Identifizieren Sie den Tag oder die Klasse, in dem/der die Gründerdetails erwähnt werden.

- Details zur Finanzierung: Notieren Sie den Abschnitt oder die Attribute, die Informationen zur Finanzierung anzeigen.

So fügen Sie diese Aktionen hinzu:

- Untersuchen Sie die Webseite: Öffnen Sie die Webseite in einem Browser und verwenden Sie Tools wie Chrome DevTools, um die Elemente zu untersuchen, die die gewünschten Informationen enthalten.

- Aktualisieren Sie das Scraper-Skript: Ändern Sie das Skript so, dass es Extraktionsregeln für diese neuen Elemente enthält, in der Regel durch Hinzufügen neuer Codezeilen, die diese Elemente identifizieren und sammeln.

Beispiel (ausgehend von einem Python-Skript):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Regelmäßiges Scraping einrichten

Um Ihre Daten auf dem neuesten Stand zu halten, sollten Sie einen Zeitplan einrichten, nach dem Ihr Scraper automatisch ausgeführt wird. Dies kann mit verschiedenen Tools erfolgen:

- Cron-Jobs (Linux): Planen Sie das Skript so, dass es in bestimmten Abständen ausgeführt wird. Beispiel: Um den Scraper täglich um Mitternacht auszuführen:

0 0 * * * /usr/bin/python3 /pfad/zu/ihr_scraper.py

- Aufgabenplaner (Windows): Ähnlich wie bei Cron-Jobs können Sie Ihren Scraper so planen, dass er zu bestimmten Zeiten ausgeführt wird.

- Cloud-Dienste: Verwenden Sie Cloud-basierte Zeitplanungsdienste wie AWS CloudWatch Events, Google Cloud Scheduler oder Heroku Scheduler, um Ihren Scraper regelmäßig auszuführen.

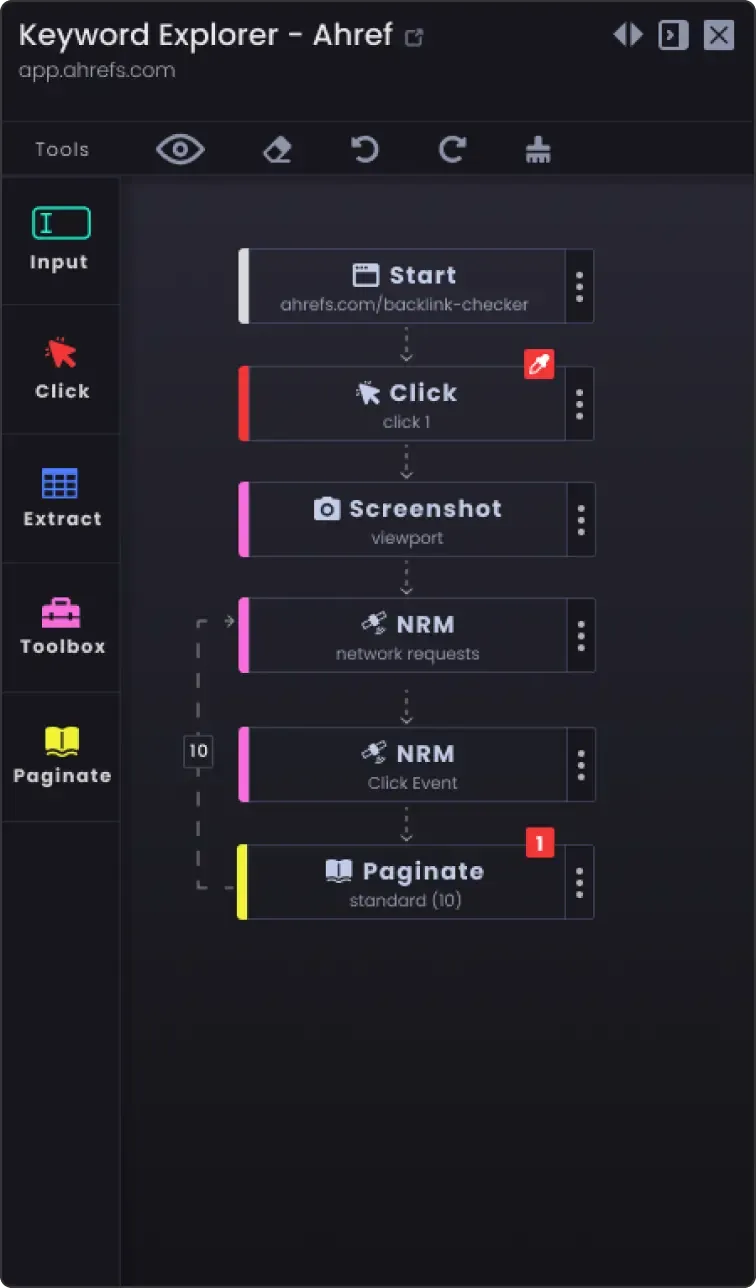

3. Paginierungsoption zum Scrapen von mehr als einer Seite

Websites teilen Informationen oft in mehrere Seiten auf. So scrapen Sie alle Seiten:

- Identifizieren Sie den Paginierungsmechanismus: Untersuchen Sie die Website, um zu sehen, wie sie die Paginierung handhabt (z. B. Schaltfläche "Nächste Seite", Seitenzahlen).

- Aktualisieren Sie das Skript: Fügen Sie eine Logik in Ihr Skript ein, um durch die Seiten zu navigieren. Dazu gehört in der Regel das Inkrementieren einer Seitenzahl in der URL oder das Klicken auf die Schaltfläche "Weiter".

Beispiel (Python-Pseudocode):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Keine weiteren Daten zum Scrapen save_data(data) page_number += 1

4. Anpassungsoptionen

- Fehlerbehandlung: Fügen Sie eine Fehlerbehandlung hinzu, um sicherzustellen, dass der Scraper weiterläuft, auch wenn er auf Probleme wie Netzwerkprobleme oder unerwartete Änderungen in der Webseitenstruktur stößt.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Fehler: {e}") continue

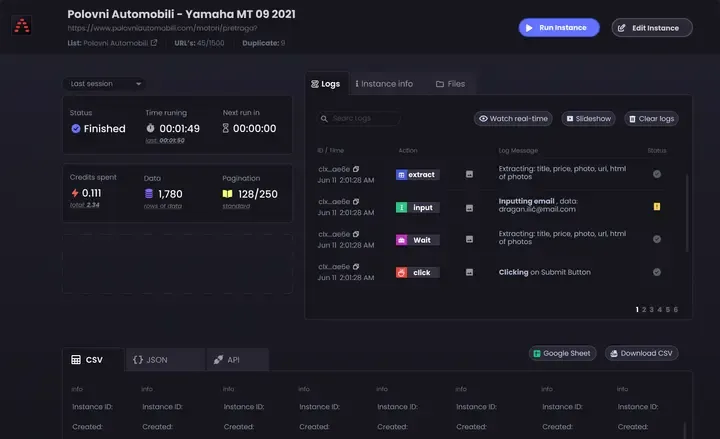

Optionen für die Datenspeicherung: Entscheiden Sie, wo und wie die gesammelten Daten gespeichert werden sollen. Folgende Optionen sind möglich:

CSV-Dateien: Einfach zu lesen und zu schreiben mit dem csv-Modul von Python.

Datenbanken: Speichern Sie Daten in Datenbanken wie SQLite, MySQL oder MongoDB für komplexere Abfragen und bessere Datenintegrität.

Cloud-Speicher: Speichern Sie Daten in Cloud-Speicherdiensten wie AWS S3 oder Google Cloud Storage.

Datenbereinigung und -validierung: Fügen Sie Schritte zur Bereinigung und Validierung der gescrapten Daten hinzu, um sicherzustellen, dass sie korrekt und brauchbar sind.

if not company_name: continue # Überspringen, wenn der Firmenname fehlt

- Protokollierung: Implementieren Sie eine Protokollierung, um den Fortschritt des Scrapings und alle aufgetretenen Probleme zu verfolgen. Verwenden Sie das

Logging-Modul von Python.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Wenn Sie diese Tipps befolgen, können Sie die YCombinator Scraper-Vorlage an Ihre spezifischen Bedürfnisse anpassen und sicherstellen, dass Sie umfassende und aktuelle Informationen sammeln.