Tips til at tilpasse YCombinator Scraper-skabelonen

1. Tilføjelse af flere handlinger for at udtrække yderligere oplysninger

Hvis du vil indsamle flere data fra YCombinator-webstedet, kan du opdatere scraperens script til at omfatte yderligere handlinger. Almindelige oplysninger, du måske ønsker at udtrække, omfatter:

- Virksomhedsbeskrivelser: Find det HTML-tag eller den klasse, der indeholder beskrivelsen af hver virksomhed.

- Oplysninger om grundlæggeren: Identificer det tag eller den klasse, hvor grundlæggerens detaljer er nævnt.

- Detaljer om finansiering: Bemærk det afsnit eller de attributter, der viser finansieringsoplysninger.

Sådan tilføjer du disse handlinger:

- Undersøg websiden: Åbn websiden i en browser, og brug værktøjer som Chrome DevTools til at inspicere de elementer, der indeholder de ønskede oplysninger.

- Opdater scraper-scriptet: Ændr scriptet, så det indeholder udtræksregler for disse nye elementer, normalt ved at tilføje nye kodelinjer, der identificerer og indsamler disse elementer.

Eksempel (forudsat at det er et Python-script):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Opsætning af periodisk scraping

For at holde dine data opdaterede skal du opsætte en tidsplan for, hvornår din scraper skal køre automatisk. Dette kan gøres ved hjælp af forskellige værktøjer:

- Cron-jobs (Linux): Planlæg scriptet til at køre med bestemte intervaller. Eksempel: For at køre scraperen dagligt ved midnat:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Opgavestyring (Windows): I lighed med cron-jobs kan du planlægge, at din scraper skal køre på bestemte tidspunkter.

- Cloud-tjenester: Brug cloud-baserede planlægningstjenester som AWS CloudWatch Events, Google Cloud Scheduler eller Heroku Scheduler til at køre din scraper med jævne mellemrum.

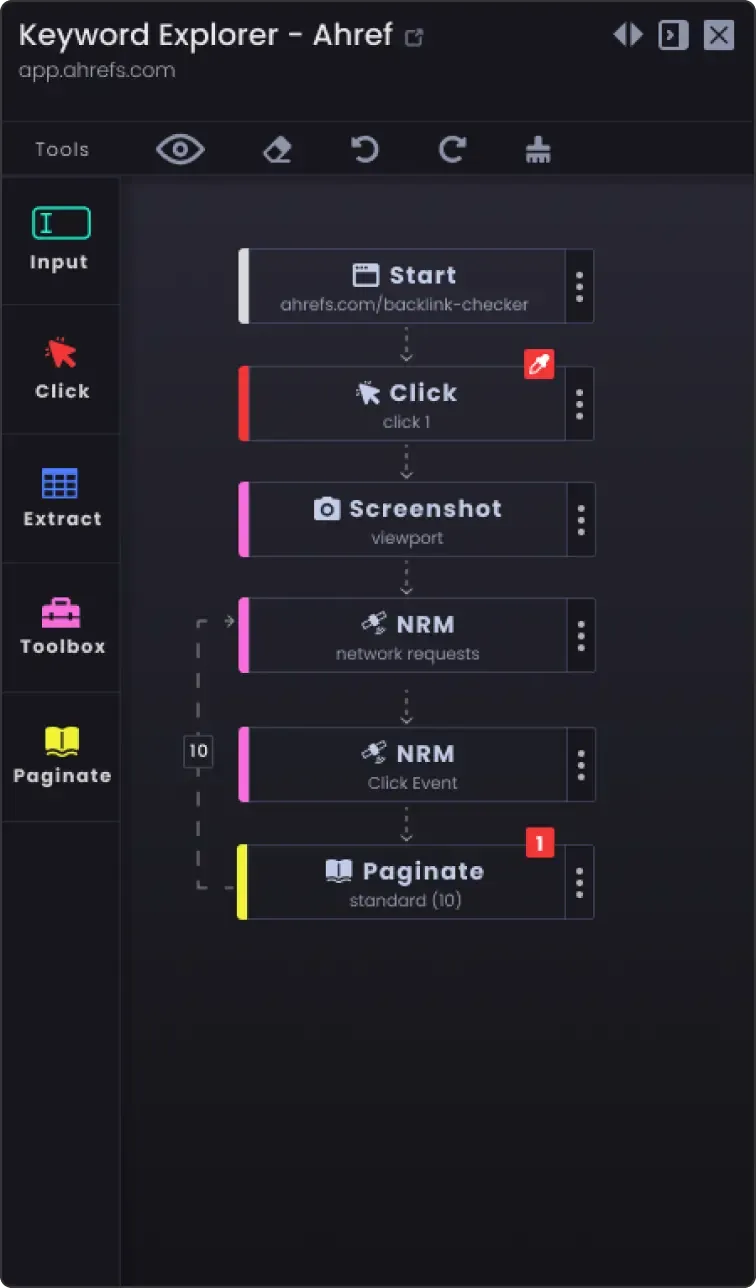

3. Pagineringsmulighed for at skrabe mere end én side

Hjemmesider deler ofte information op på flere sider. For at scrape alle siderne:

- Identificer pagineringsmekanismen: Undersøg hjemmesiden for at se, hvordan den håndterer paginering (f.eks. næste side-knap, sidenumre).

- Opdater scriptet: Tilføj logik til dit script for at navigere gennem siderne. Det indebærer normalt at øge et sidenummer i URL'en eller at klikke på knappen "næste".

Eksempel (Python-pseudokode):

page_number = 1 while True: url = f"https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Ikke flere data at scrape save_data(data) page_number += 1

4. Tilpasningsmuligheder

- Fejlhåndtering: Tilføj fejlhåndtering for at sikre, at scraperen fortsætter med at køre, selv om den støder på problemer som netværksproblemer eller uventede ændringer i websidens struktur.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f"Fejl: {e}") continue

Muligheder for datalagring: Bestem, hvor og hvordan de skrottede data skal gemmes. Valgmulighederne omfatter:

CSV-filer: Let at læse og skrive ved hjælp af Pythons csv-modul.

Databaser: Gem data i databaser som SQLite, MySQL eller MongoDB for at få mere komplekse forespørgsler og bedre dataintegritet.

Lagring iskyen: Gem data i cloud storage-tjenester som AWS S3 eller Google Cloud Storage.

Rensning og validering afdata: Tilføj trin til at rense og validere de skrabede data for at sikre, at de er nøjagtige og brugbare.

if not company_name: continue # Spring over, hvis firmanavnet mangler

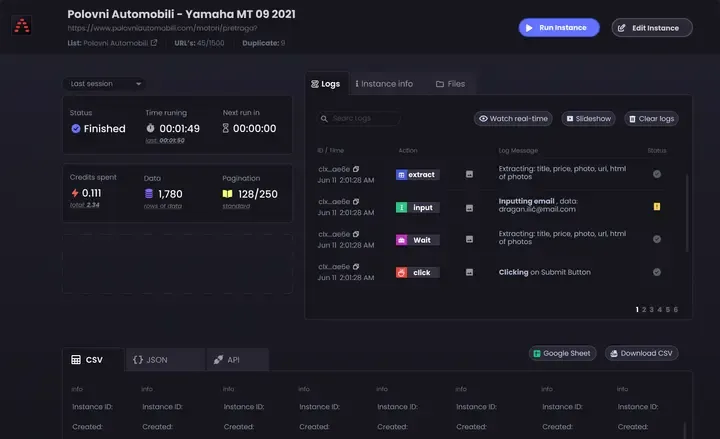

- Logning: Implementer logning for at holde styr på scrapingens fremskridt og eventuelle problemer. Brug Pythons

logningsmodul.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Ved at følge disse tips kan du tilpasse YCombinator Scraper Template, så den opfylder dine specifikke behov og sikrer, at du indsamler omfattende og opdaterede oplysninger.