Consejos para personalizar la plantilla de YCombinator Scraper

1. Añadir más acciones para extraer información adicional

Para recopilar más datos del sitio web de YCombinator, puede actualizar la secuencia de comandos del raspador para incluir acciones adicionales. Entre la información más común que puede querer extraer se incluyen:

- Descripciones de empresas: Localice la etiqueta o clase HTML que contiene la descripción de cada empresa.

- Información sobre el fundador: Identifique la etiqueta o clase donde se mencionan los detalles del fundador.

- Detalles definanciación: Localice la sección o los atributos que muestran la información de financiación.

Para añadir estas acciones

- Inspeccione la página web: Abra la página web en un navegador y utilice herramientas como Chrome DevTools para inspeccionar los elementos que contienen la información deseada.

- Actualizar el script del scraper: Modificar el script para incluir reglas de extracción para estos nuevos elementos, normalmente añadiendo nuevas líneas de código que identifiquen y recojan estos elementos.

Ejemplo (suponiendo un script en Python):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Configurar el scraping periódico

Para mantener sus datos actualizados, establezca un calendario para que su scraper se ejecute automáticamente. Para ello, puede utilizar varias herramientas:

- Cron jobs (Linux): Programe el script para que se ejecute a intervalos específicos. Ejemplo: Para ejecutar el scraper diariamente a medianoche:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Programador de tareas (Windows): Similar a cron jobs, programa tu scraper para que se ejecute a horas específicas.

- Servicios en la nube: Utiliza servicios de programación basados en la nube como AWS CloudWatch Events, Google Cloud Scheduler o Heroku Scheduler para ejecutar periódicamente tu scraper.

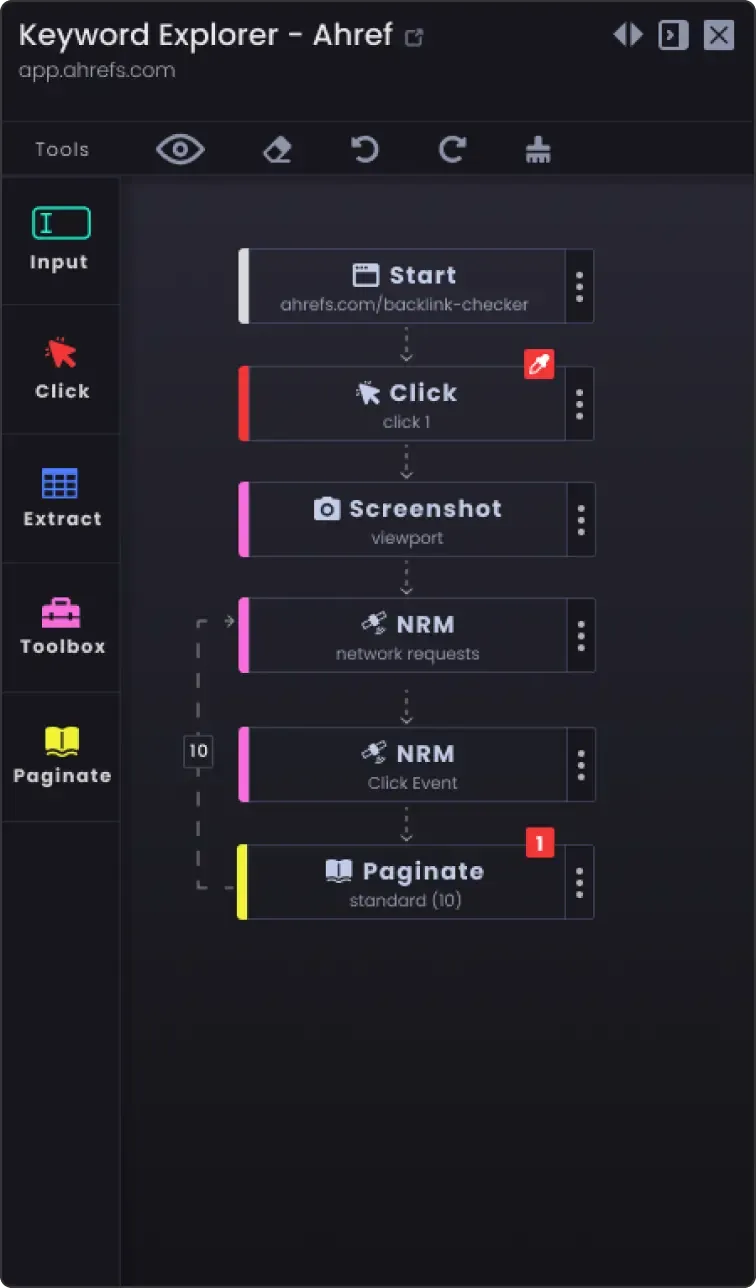

3. Opción de paginación para raspar más de una página

Los sitios web a menudo dividen la información en varias páginas. Para raspar todas las páginas:

- Identifique el mecanismo de paginación: Inspeccione el sitio web para ver cómo maneja la paginación (por ejemplo, botón de página siguiente, números de página).

- Actualice el script: Añade lógica al script para navegar por las páginas. Esto suele implicar incrementar un número de página en la URL o hacer clic en el botón "siguiente".

Ejemplo (pseudocódigo Python):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # No hay más datos para scrapear save_data(data) page_number += 1

4. Opciones de personalización

- Gestión de errores: Añade la gestión de errores para asegurar que el scraper continúa funcionando incluso si se encuentra con problemas de red o cambios inesperados en la estructura de la página web.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

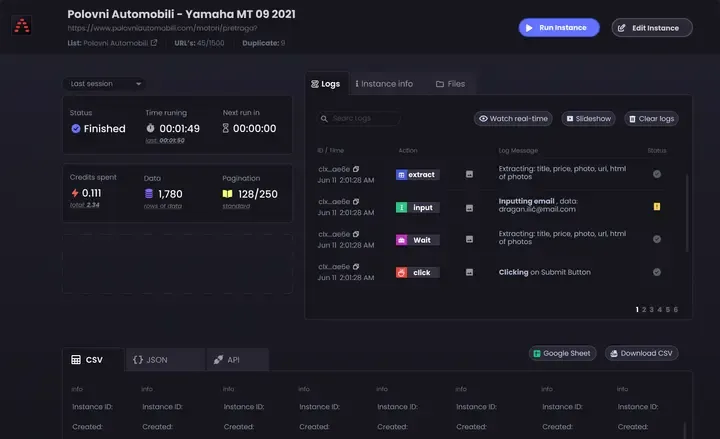

Opciones de almacenamiento de datos: Decide dónde y cómo almacenar los datos desechados. Las opciones incluyen:

Archivos CSV: Fáciles de leer y escribir utilizando el módulo csv de Python.

Bases de datos: Almacenar los datos en bases de datos como SQLite, MySQL o MongoDB para consultas más complejas y una mejor integridad de los datos.

Almacenamiento en la nube: Guarda los datos en servicios de almacenamiento en la nube como AWS S3 o Google Cloud Storage.

Limpieza y validación de datos: Añade pasos para limpiar y validar los datos raspados para asegurarte de que son precisos y utilizables.

if not nombre_empresa: continuar # Omitir si falta el nombre de la empresa

- Registro: Implementar el registro para realizar un seguimiento del progreso del scraping y de los problemas encontrados. Utilice el módulo de

registro de Python.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Raspando página {número_de_página}')

Siguiendo estos consejos, puede personalizar la plantilla de raspado de YCombinator para satisfacer sus necesidades específicas y asegurarse de recopilar información completa y actualizada.