Советы по настройке шаблона YCombinator Scraper

1. Добавление дополнительных действий для извлечения дополнительной информации

Чтобы собрать больше данных с сайта YCombinator, вы можете обновить скрипт скрепера, добавив в него дополнительные действия. К общим фрагментам информации, которую вы можете захотеть извлечь, относятся:

- Описания компаний: Найдите HTML-тег или класс, содержащий описание каждой компании.

- Информация об основателе: Определите тег или класс, в котором упоминается информация об основателе.

- Сведения о финансировании: Отметьте раздел или атрибуты, в которых отображается информация о финансировании.

Чтобы добавить эти действия:

- Осмотрите веб-страницу: Откройте веб-страницу в браузере и с помощью таких инструментов, как Chrome DevTools, проверьте элементы, содержащие нужную информацию.

- Обновите скрипт скрепера: Измените скрипт, чтобы включить правила извлечения этих новых элементов, обычно добавляя новые строки кода, которые идентифицируют и собирают эти элементы.

Пример (предполагается, что сценарий написан на Python):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Настройка периодического скрапинга

Чтобы поддерживать данные в актуальном состоянии, установите расписание для автоматического запуска скрепера. Это можно сделать с помощью различных инструментов:

- Задания Cron (Linux): Запланируйте запуск скрипта через определенные промежутки времени. Пример: Чтобы запускать скребок ежедневно в полночь:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Планировщик задач (Windows): Аналогично заданиям cron, планируйте запуск скрепера в определенное время.

- Облачные сервисы: Используйте облачные сервисы планирования, такие как AWS CloudWatch Events, Google Cloud Scheduler или Heroku Scheduler, чтобы периодически запускать ваш скрепер.

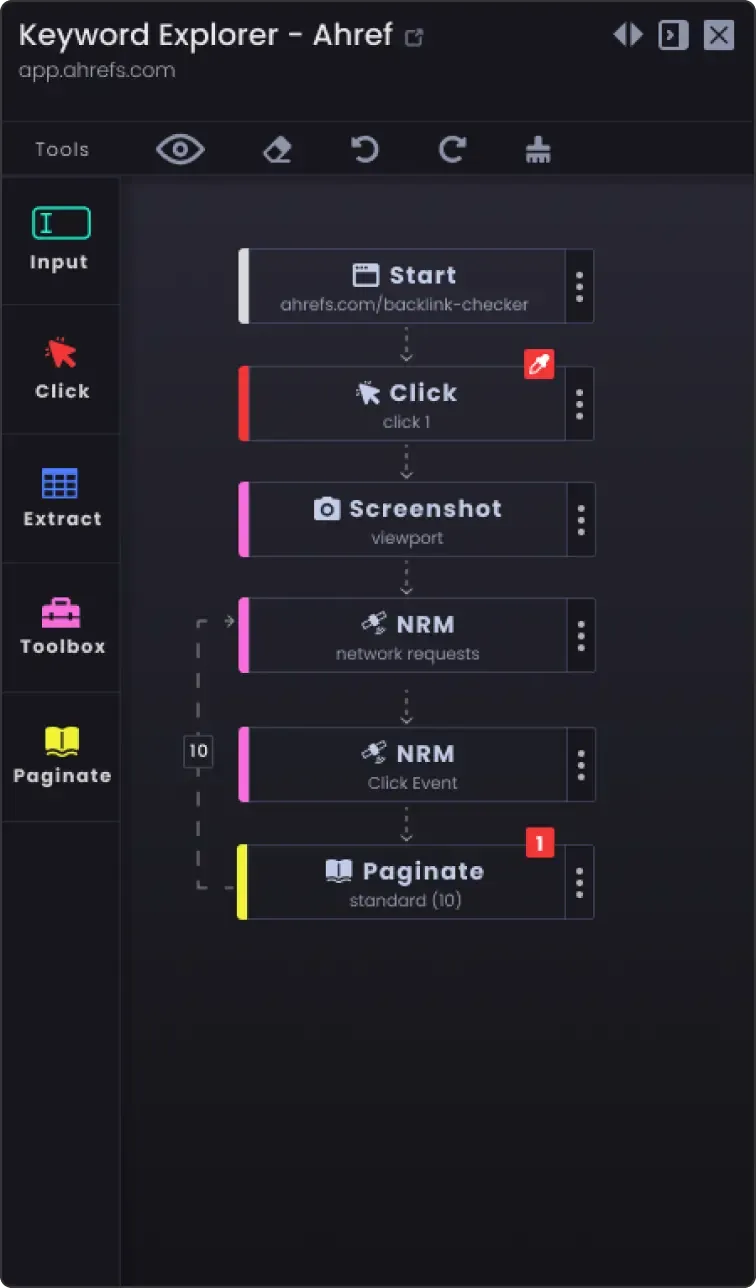

3. Опция пагинации для соскабливания более чем одной страницы

Веб-сайты часто разбивают информацию на несколько страниц. Чтобы соскрести все страницы:

- Определите механизм пагинации: проверьте сайт, чтобы узнать, как он работает с пагинацией (например, кнопка следующей страницы, номера страниц).

- Обновите скрипт: Добавьте в скрипт логику для навигации по страницам. Обычно это включает в себя увеличение номера страницы в URL или нажатие кнопки "следующая".

Пример (псевдокод на языке Python):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Больше нет данных для соскоба save_data(data) page_number += 1

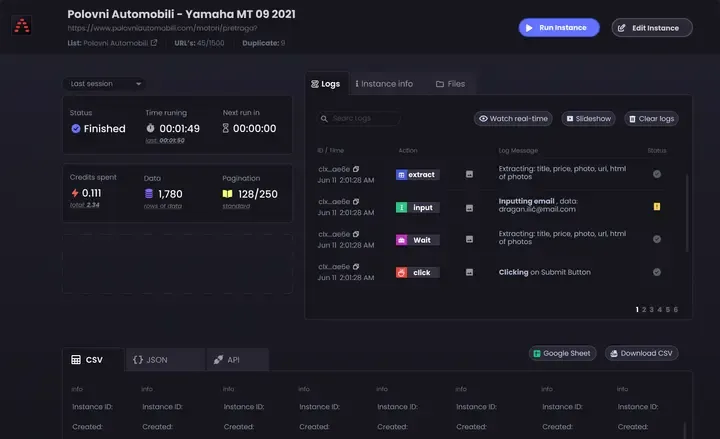

4. Параметры настройки

- Обработка ошибок: Добавьте обработку ошибок, чтобы скрепер продолжал работать даже при возникновении таких проблем, как неполадки в сети или неожиданные изменения в структуре веб-страницы.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

Варианты хранения данных: Решите, где и как хранить отбракованные данные. Варианты включают:

CSV-файлы: Легко читаются и записываются с помощью модуля csv в Python.

Базы данных: Храните данные в базах данных, таких как SQLite, MySQL или MongoDB, для более сложных запросов и лучшей целостности данных.

Облачные хранилища: Сохраняйте данные в облачных хранилищах, таких как AWS S3 или Google Cloud Storage.

Очистка и проверка данных: Добавьте шаги по очистке и проверке собранных данных, чтобы убедиться в их точности и пригодности для использования.

if not company_name: continue # Пропустить, если название компании отсутствует

- Ведение журнала: Реализуйте ведение журнала, чтобы отслеживать прогресс в работе с данными и любые возникшие проблемы. Используйте модуль

протоколирования Python.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Следуя этим советам, вы сможете настроить шаблон скрепера YCombinator под свои нужды и обеспечить сбор полной и актуальной информации.