Y콤비네이터 스크레이퍼 템플릿 커스터마이징 팁

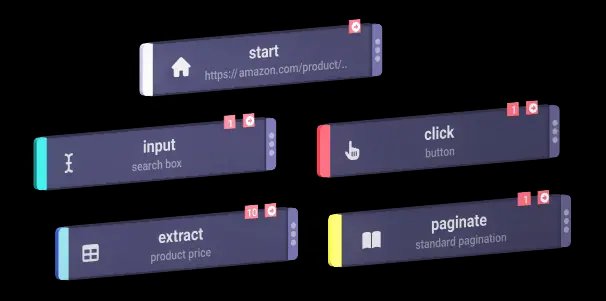

1. 추가 액션을 추가하여 추가 정보 추출하기

와이콤비네이터 웹사이트에서 더 많은 데이터를 수집하려면 스크래퍼의 스크립트를 업데이트하여 추가 액션을 포함할 수 있습니다. 추출할 수 있는 일반적인 정보는 다음과 같습니다:

- 회사 설명: 각 회사에 대한 설명이 포함된 HTML 태그 또는 클래스를 찾습니다.

- 설립자 정보: 설립자 세부 정보가 언급된 태그 또는 클래스를 식별합니다.

- 펀딩 세부 정보: 펀딩 정보를 표시하는 섹션 또는 속성을 확인합니다.

이러한 작업을 추가하려면 다음과 같이 하세요:

- 웹페이지를 살펴봅니다: 브라우저에서 웹페이지를 열고 Chrome 개발자 도구와 같은 도구를 사용하여 원하는 정보가 포함된 요소를 검사합니다.

- 스크래퍼 스크립트 업데이트: 일반적으로 이러한 요소를 식별하고 수집하는 새 코드 줄을 추가하여 이러한 새 요소에 대한 추출 규칙을 포함하도록 스크립트를 수정합니다.

예제(Python 스크립트 가정):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. 주기적 스크래핑 설정

데이터를 최신 상태로 유지하려면 스크래퍼가 자동으로 실행되도록 일정을 설정하세요. 다양한 도구를 사용하여 이 작업을 수행할 수 있습니다:

- Cron 작업(Linux): 특정 간격으로 스크립트가 실행되도록 예약합니다. 예시: 매일 자정에 스크레이퍼를 실행하려면 다음과 같이 하세요:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- 작업 스케줄러(Windows): 크론 작업과 마찬가지로 스크레이퍼가 특정 시간에 실행되도록 예약합니다.

- 클라우드 서비스: AWS CloudWatch 이벤트, Google 클라우드 스케줄러 또는 Heroku 스케줄러와 같은 클라우드 기반 스케줄링 서비스를 사용하여 스크래퍼를 주기적으로 실행하세요.

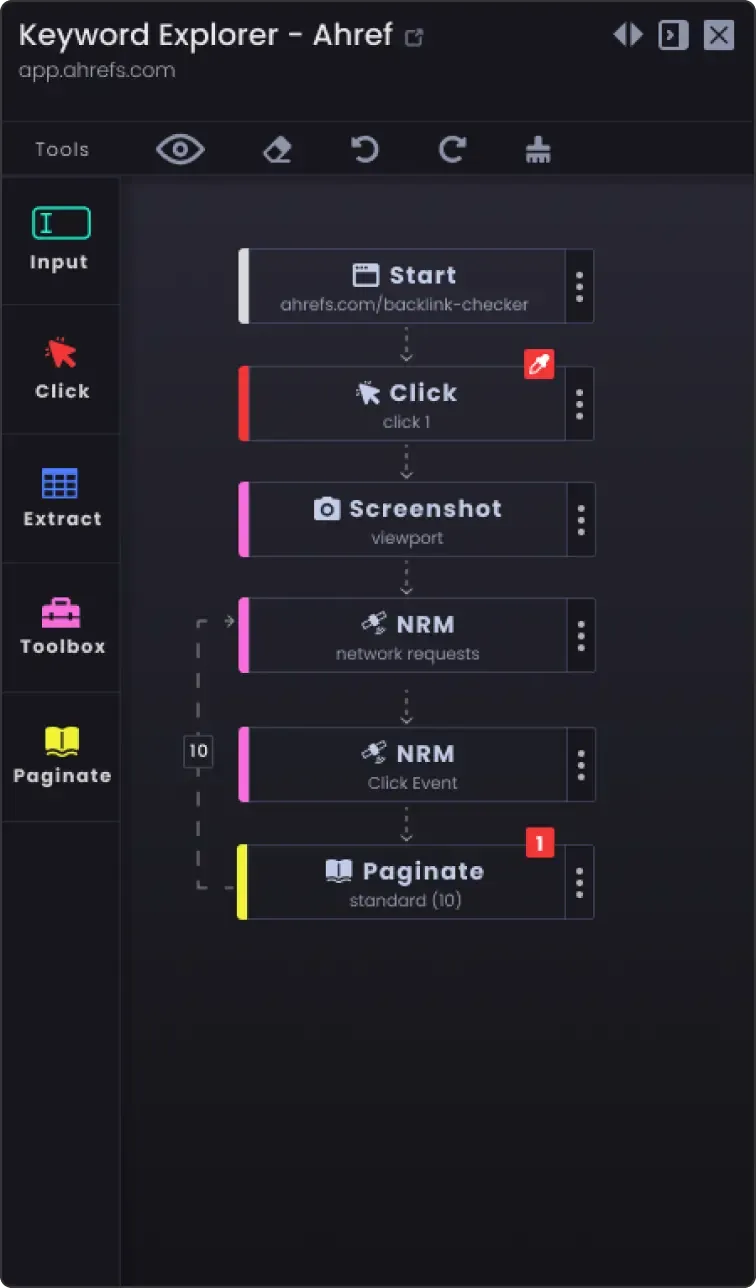

3. 두 페이지 이상을 스크랩하는 페이지 매김 옵션

웹사이트는 종종 정보를 여러 페이지로 분할합니다. 모든 페이지를 스크랩하려면

- 페이지 매김메커니즘 확인: 웹사이트가 페이지 매김을 처리하는 방식(예: 다음 페이지 버튼, 페이지 번호)을 확인합니다.

- 스크립트를 업데이트합니다: 스크립트에 페이지 탐색을 위한 로직을 추가하세요. 여기에는 일반적으로 URL에서 페이지 번호를 늘리거나 '다음' 버튼을 클릭하는 것이 포함됩니다.

예(Python 의사 코드):

page_number = 1 while True: url = f"https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) not data: break # 더 이상 스크랩할 데이터 없음 save_data(data) page_number += 1

4. 사용자 정의 옵션

- 오류 처리: 네트워크 문제나 웹페이지 구조의 예기치 않은 변경과 같은 문제가 발생하더라도 스크래퍼가 계속 실행되도록 오류 처리 기능을 추가하세요.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f"Error: {e}") continue

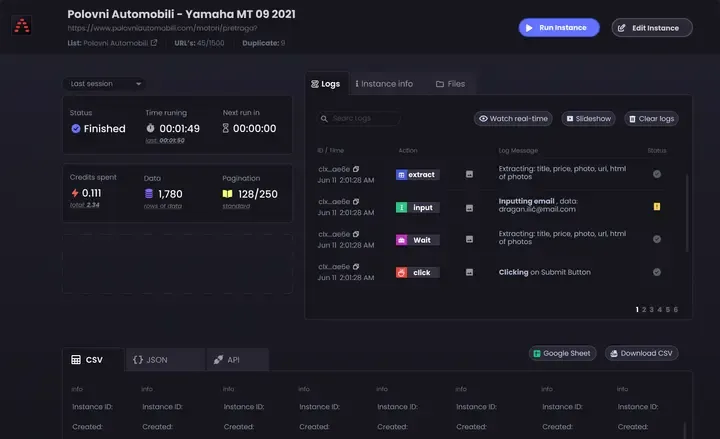

데이터 저장 옵션: 스크랩된 데이터를 어디에 어떻게 저장할지 결정합니다. 옵션은 다음과 같습니다:

CSV 파일: Python의 csv 모듈을 사용하여 쉽게 읽고 쓸 수 있습니다.

데이터베이스: 더 복잡한 쿼리와 더 나은 데이터 무결성을 위해 SQLite, MySQL 또는 MongoDB와 같은 데이터베이스에 데이터를 저장하세요.

클라우드 스토리지: AWS S3 또는 Google 클라우드 스토리지와 같은 클라우드 스토리지 서비스에 데이터를 저장합니다.

데이터 정리 및 유효성 검사: 스크랩한 데이터를 정리하고 유효성을 검사하는 단계를 추가하여 정확하고 사용 가능한 데이터인지 확인합니다.

company_name이 아닌 경우: 계속 # 회사 이름이 누락된 경우 건너뛰기

- 로깅: 로깅을 구현하여 스크래핑 진행 상황과 발생한 모든 문제를 추적하세요. 파이썬의

로깅 모듈을 사용합니다.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'스크래핑 페이지 {페이지_번호}')

이 팁에 따라 특정 요구사항을 충족하고 포괄적인 최신 정보를 수집할 수 있도록 YCombinator 스크래퍼 템플릿을 사용자 정의할 수 있습니다.