Tips untuk Menyesuaikan Template Scraper YCombinator

1. Menambahkan Lebih Banyak Tindakan untuk Mengekstrak Informasi Tambahan

Untuk mengumpulkan lebih banyak data dari situs web YCombinator, Anda dapat memperbarui skrip scraper untuk menyertakan tindakan tambahan. Informasi umum yang mungkin ingin Anda ekstrak antara lain:

- Deskripsi perusahaan: Cari tag atau kelas HTML yang berisi deskripsi setiap perusahaan.

- Informasi pendiri: Identifikasi tag atau kelas di mana detail pendiri disebutkan.

- Rincian pendanaan: Catat bagian atau atribut yang menampilkan informasi pendanaan.

Untuk menambahkan tindakan ini:

- Periksa halaman web: Buka halaman web di peramban dan gunakan alat bantu seperti Chrome DevTools untuk memeriksa elemen yang berisi informasi yang diinginkan.

- Perbarui skrip pengikis: Modifikasi skrip untuk menyertakan aturan ekstraksi untuk elemen-elemen baru ini, biasanya dengan menambahkan baris kode baru yang mengidentifikasi dan mengumpulkan elemen-elemen ini.

Contoh (dengan asumsi skrip Python):

deskripsi_perusahaan = company.find('p', class_='deskripsi-perusahaan').text informasi_pendiri = company.find('span', class_='informasi-pendiri').text informasi_pendanaan = company.find('span', class_='informasi-pendanaan').text

2. Menyiapkan Pengikisan Berkala

Untuk menjaga data Anda tetap mutakhir, aturlah jadwal agar scraper Anda berjalan secara otomatis. Hal ini dapat dilakukan dengan menggunakan berbagai alat:

- Pekerjaan Cron (Linux): Jadwalkan skrip untuk berjalan pada interval tertentu. Contoh: Untuk menjalankan scraper setiap hari pada tengah malam:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Penjadwal Tugas (Windows): Mirip dengan pekerjaan cron, jadwalkan scraper Anda untuk berjalan pada waktu tertentu.

- Layanan cloud: Gunakan layanan penjadwalan berbasis cloud seperti AWS CloudWatch Events, Google Cloud Scheduler, atau Heroku Scheduler untuk menjalankan scraper Anda secara berkala.

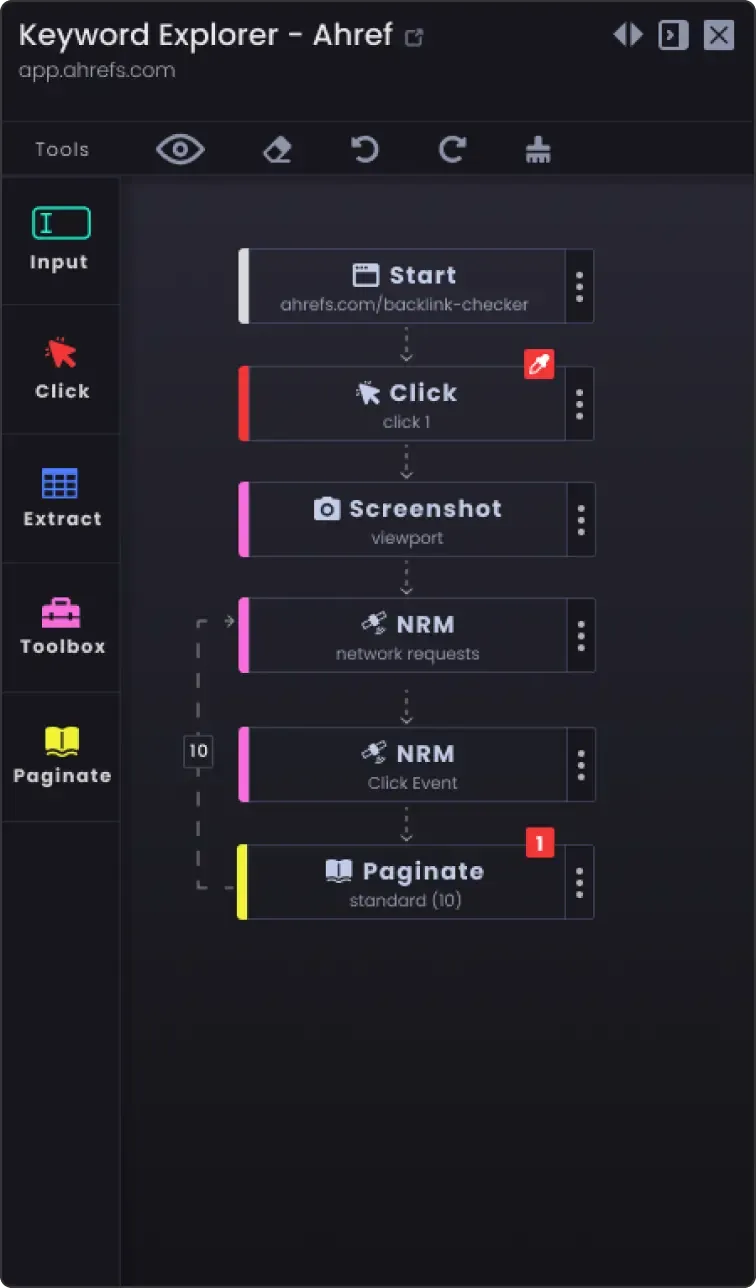

3. Opsi Penomoran Halaman untuk Mengikis Lebih dari Satu Halaman

Situs web sering kali membagi informasi menjadi beberapa halaman. Untuk mengikis semua halaman:

- Identifikasi mekanisme pagination: Periksa situs web untuk melihat bagaimana situs web tersebut menangani pagination (mis., tombol halaman berikutnya, nomor halaman).

- Perbarui skrip: Tambahkan logika ke skrip Anda untuk menavigasi halaman. Hal ini biasanya melibatkan penambahan nomor halaman dalam URL atau mengklik tombol "next".

Contoh (kode semu Python):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Tidak ada lagi data yang harus diambil save_data(data) page_number += 1

4. Opsi Kustomisasi

- Penanganan kesalahan: Tambahkan penanganan kesalahan untuk memastikan scraper terus berjalan meskipun mengalami masalah seperti masalah jaringan atau perubahan tak terduga dalam struktur halaman web.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

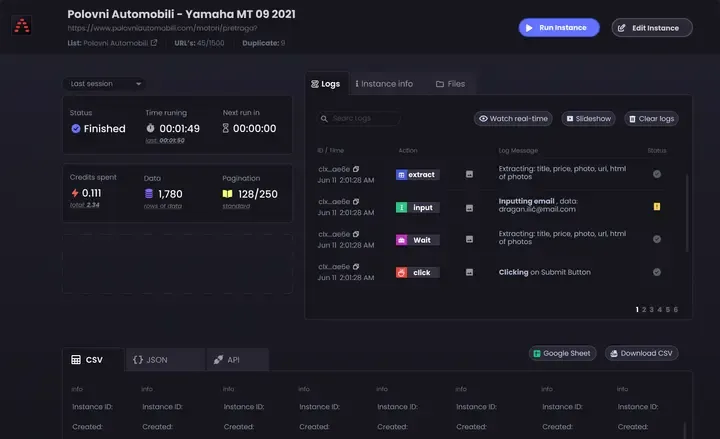

Opsi penyimpanan data: Tentukan di mana dan bagaimana menyimpan data yang dihapus. Pilihannya meliputi:

File CSV: Mudah dibaca dan ditulis menggunakan modul csv Python.

Basis data: Menyimpan data dalam database seperti SQLite, MySQL, atau MongoDB untuk kueri yang lebih kompleks dan integritas data yang lebih baik.

Penyimpanan awan: Menyimpan data ke layanan penyimpanan awan seperti AWS S3 atau Google Cloud Storage.

Pembersihan dan validasi data: Tambahkan langkah-langkah untuk membersihkan dan memvalidasi data yang telah dihapus untuk memastikan data tersebut akurat dan dapat digunakan.

jika bukan nama_perusahaan: lanjutkan # Lewati jika nama perusahaan tidak ada

- Pencatatan: Terapkan pencatatan untuk melacak kemajuan penggalian dan masalah apa pun yang ditemui. Gunakan modul

pencatatan Python.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping halaman {page_number}')

Dengan mengikuti tips ini, Anda dapat menyesuaikan Templat Scraper YCombinator untuk memenuhi kebutuhan spesifik Anda dan memastikan Anda mengumpulkan informasi yang komprehensif dan terkini.