Tipy pro přizpůsobení šablony YCombinator Scraper

1. Přidání dalších akcí pro získání dalších informací

Chcete-li shromáždit více údajů z webových stránek YCombinator, můžete aktualizovat skript scraperu a zahrnout do něj další akce. Mezi běžné informace, které můžete chtít extrahovat, patří:

- Popisy společností: Vyhledejte značku nebo třídu HTML, která obsahuje popis každé společnosti.

- Informace o zakladateli: Najděte značku nebo třídu, kde jsou uvedeny údaje o zakladateli.

- Podrobnosti o financování: Všimněte si oddílu nebo atributů, které zobrazují informace o financování.

Přidání těchto akcí: Proveďte následující akce:

- Prohlédněte si webovou stránku: Otevřete webovou stránku v prohlížeči a pomocí nástrojů jako Chrome DevTools zkontrolujte prvky obsahující požadované informace.

- Aktualizujte skript scraperu: Upravte skript tak, aby obsahoval pravidla pro extrakci těchto nových prvků, obvykle přidáním nových řádků kódu, které tyto prvky identifikují a shromažďují.

Příklad (předpokládáme skript v jazyce Python):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Nastavení pravidelného scrapování

Chcete-li udržovat data aktuální, nastavte plán automatického spouštění scraperu. To lze provést pomocí různých nástrojů:

- Cron jobs (Linux): Naplánujte spuštění skriptu v určitých intervalech. Příklad: Naplánujte spuštění skriptu v určitých intervalech: Pro spuštění scraperu denně o půlnoci:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Plánovač úloh (Windows): Podobně jako u úloh cron můžete naplánovat spuštění scraperu v určitý čas.

- Cloudové služby: Pro pravidelné spouštění scraperu použijte cloudové plánovací služby, jako jsou AWS CloudWatch Events, Google Cloud Scheduler nebo Heroku Scheduler.

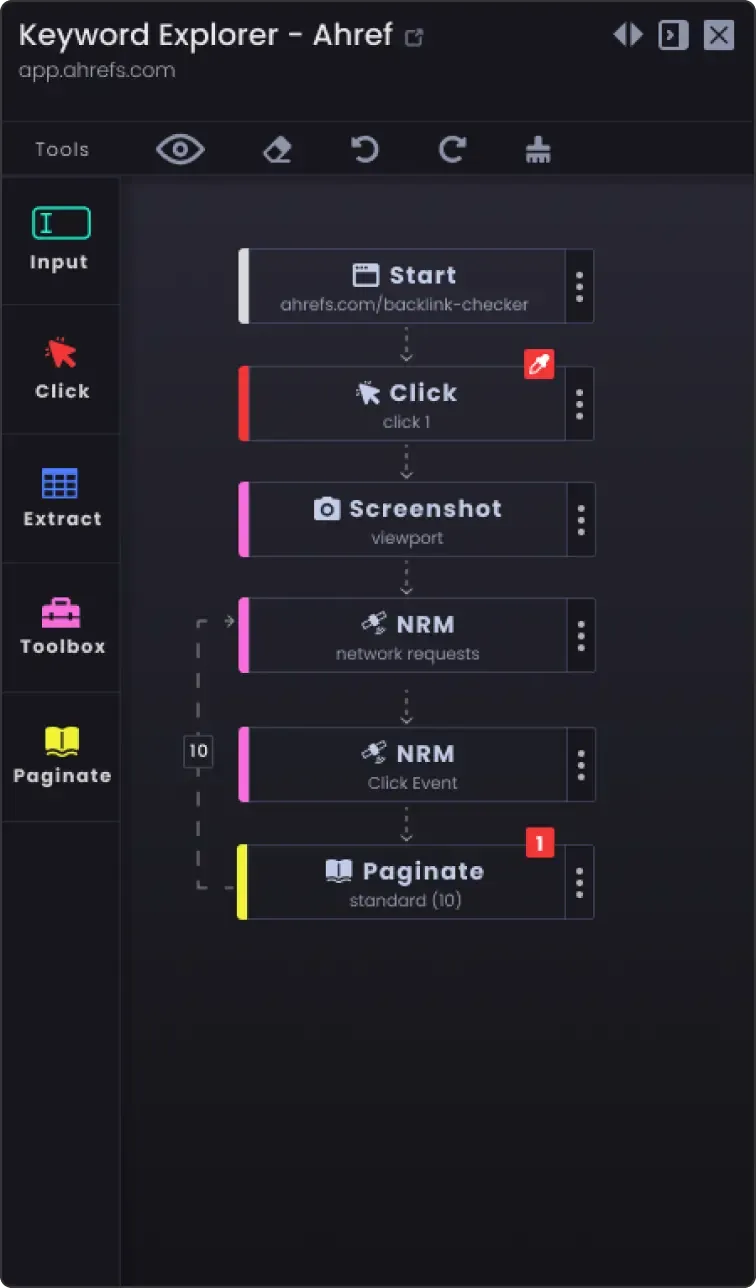

3. Možnost stránkování pro skrapování více než jedné stránky

Webové stránky často rozdělují informace na více stránek. Chcete-li seškrábat všechny stránky:

- Určete mechanismus stránkování: Prozkoumejte webovou stránku a zjistěte, jakým způsobem zpracovává stránkování (např. tlačítko další stránky, čísla stránek).

- Aktualizujte skript: Přidejte do skriptu logiku procházení stránek. To obvykle zahrnuje inkrementaci čísla stránky v adrese URL nebo kliknutí na tlačítko "další".

Příklad (pseudokód jazyka Python):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Žádná další data k seškrábání save_data(data) page_number += 1

4. Možnosti přizpůsobení

- Zpracování chyb: Přidejte ošetření chyb, abyste zajistili, že scraper bude pokračovat v práci, i když narazí na problémy, jako jsou problémy se sítí nebo neočekávané změny ve struktuře webové stránky.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Chyba: {e}") continue

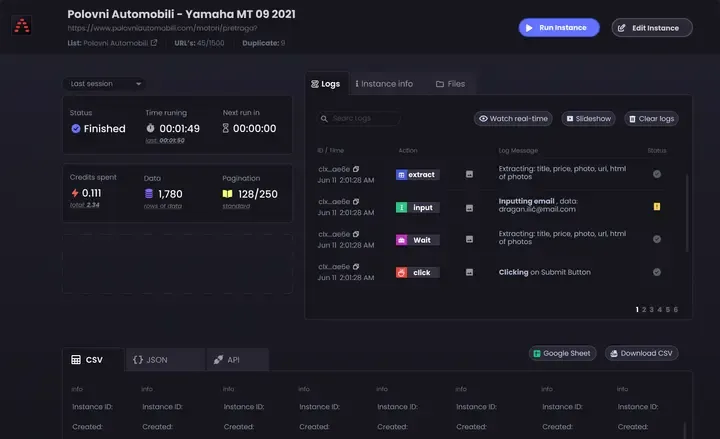

Možnosti ukládání dat: Rozhodněte, kam a jak uložit vyřazená data. Mezi možnosti patří:

CSV soubory: Snadné čtení a zápis pomocí modulu csv jazyka Python.

Databáze: Pro složitější dotazy a lepší integritu dat můžete data ukládat do databází, jako je SQLite, MySQL nebo MongoDB.

Cloudové úložiště: Ukládejte data do cloudových úložišť, jako je AWS S3 nebo Google Cloud Storage.

Čištění a ověřování dat: Přidejte kroky k čištění a validaci nashromážděných dat, abyste zajistili jejich přesnost a použitelnost.

if not company_name: continue # Přeskočit, pokud chybí název společnosti

- Protokolování: Implementujte protokolování, abyste mohli sledovat průběh scrapování a případné problémy. Použijte modul

logování Pythonu.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Dodržováním těchto tipů můžete šablonu YCombinator Scraper přizpůsobit svým specifickým potřebám a zajistit sběr komplexních a aktuálních informací.