Tips for å tilpasse YCombinator Scraper Template

1. Legge til flere handlinger for å hente ut mer informasjon

Hvis du vil samle inn flere data fra YCombinator-nettstedet, kan du oppdatere skrapeskriptet slik at det inkluderer flere handlinger. Vanlig informasjon du kanskje vil hente ut, er blant annet

- Beskrivelser av selskapet: Finn HTML-taggen eller -klassen som inneholder beskrivelsen av hvert selskap.

- Informasjon om grunnleggeren: Identifiser taggen eller klassen der grunnleggeropplysningene er nevnt.

- Finansieringsdetaljer: Legg merke til delen eller attributtene som viser finansieringsinformasjon.

Slik legger du til disse handlingene:

- Inspiser nettsiden: Åpne nettsiden i en nettleser og bruk verktøy som Chrome DevTools for å inspisere elementene som inneholder den ønskede informasjonen.

- Oppdater skrapeskriptet: Endre skriptet slik at det inkluderer uttrekksregler for disse nye elementene, vanligvis ved å legge til nye kodelinjer som identifiserer og samler inn disse elementene.

Eksempel (forutsatt et Python-skript):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Sette opp periodisk skraping

For å holde dataene dine oppdaterte, kan du sette opp en tidsplan for at skraperen skal kjøre automatisk. Dette kan gjøres ved hjelp av ulike verktøy:

- Cron-jobber (Linux): Planlegg skriptet til å kjøre med bestemte intervaller. Eksempel: For å kjøre skraperen daglig ved midnatt:

0 0 * * * * /usr/bin/python3 /path/to/din_scraper.py

- Oppgaveplanlegger (Windows): I likhet med cron-jobber kan du planlegge at skraperen skal kjøre på bestemte tidspunkter.

- Skytjenester: Bruk skybaserte planleggingstjenester som AWS CloudWatch Events, Google Cloud Scheduler eller Heroku Scheduler til å kjøre skraperen din med jevne mellomrom.

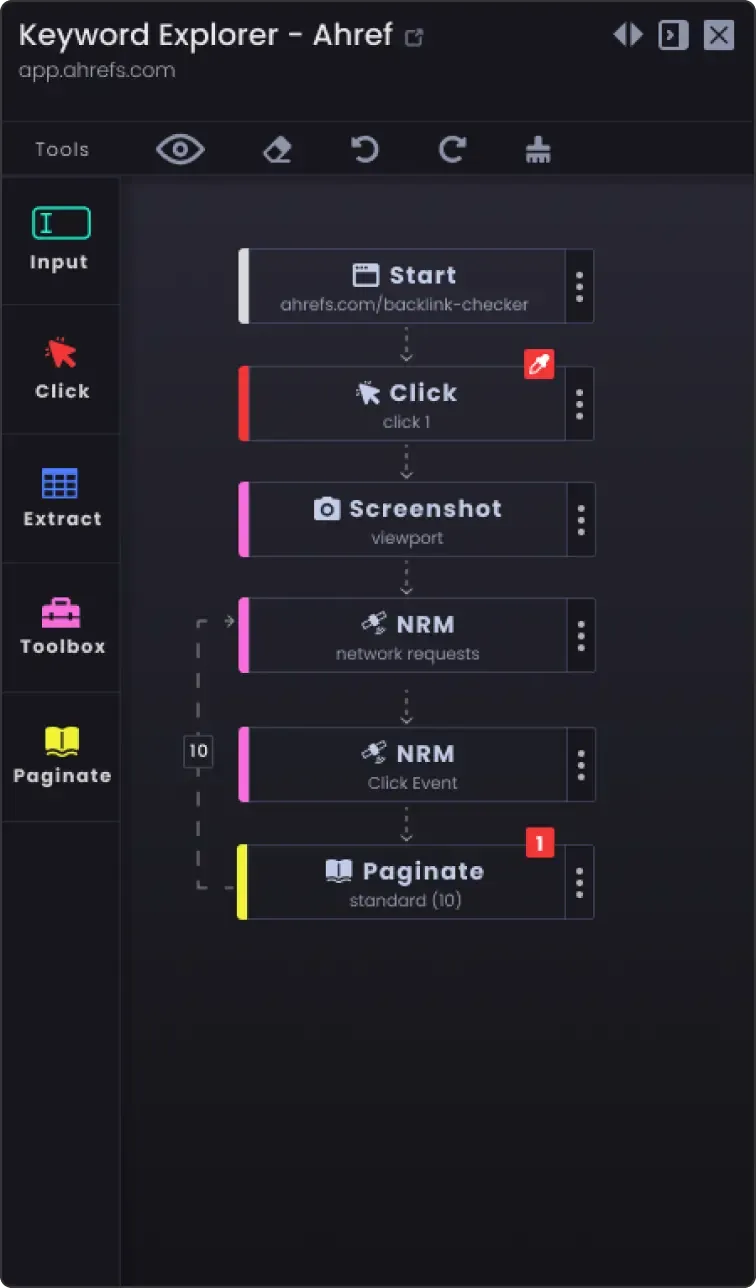

3. Pagineringsalternativ for å skrape mer enn én side

Nettsteder deler ofte opp informasjon på flere sider. For å skrape alle sidene:

- Identifiser pagineringsmekanismen: Inspiser nettstedet for å se hvordan det håndterer paginering (f.eks. neste side-knapp, sidetall).

- Oppdater skriptet: Legg til logikk i skriptet for å navigere gjennom sidene. Dette innebærer vanligvis å øke et sidetall i URL-en eller klikke på "neste"-knappen.

Eksempel (pseudokode i Python):

page_number = 1 while True: url = f"https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Ingen flere data å skrape save_data(data) page_number += 1

4. Tilpasningsalternativer

- Feilhåndtering: Legg til feilhåndtering for å sikre at skraperen fortsetter å kjøre selv om den støter på problemer, for eksempel nettverksproblemer eller uventede endringer i nettsidestrukturen.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f"Error: {e}") continue

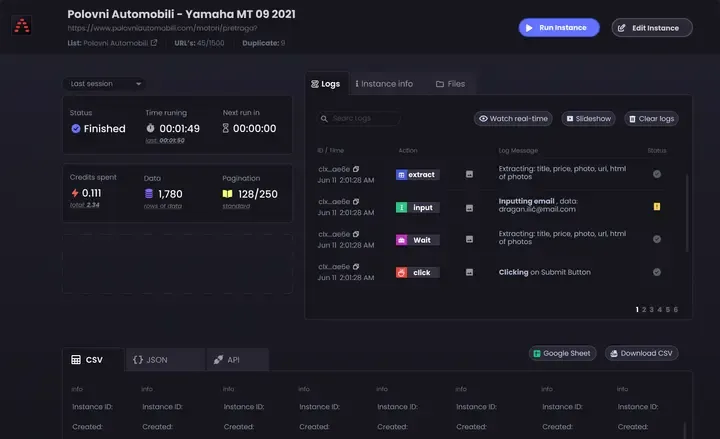

Alternativer for datalagring: Bestem hvor og hvordan de skrapede dataene skal lagres. Alternativene inkluderer:

CSV-filer: Lett å lese og skrive ved hjelp av Pythons csv-modul.

Databaser: Lagre data i databaser som SQLite, MySQL eller MongoDB for mer komplekse spørringer og bedre dataintegritet.

Skylagring: Lagre data i skylagringstjenester som AWS S3 eller Google Cloud Storage.

Datarensing og -validering: Legg til trinn for å rense og validere de skrapede dataene for å sikre at de er nøyaktige og brukbare.

if not company_name: continue # Hopp over hvis firmanavnet mangler

- Logging: Implementer logging for å holde oversikt over fremdriften i skrapingen og eventuelle problemer som oppstår. Bruk Pythons

loggmodul.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Skraper side {page_number}')

Ved å følge disse tipsene kan du tilpasse YCombinator Scraper Template slik at den oppfyller dine spesifikke behov og sikrer at du samler inn omfattende og oppdatert informasjon.