Näpunäiteid YCombinator Scraper malli kohandamiseks

1. Täiendavate toimingute lisamine lisateabe väljavõtmiseks

Et koguda YCombinatori veebisaidilt rohkem andmeid, saate skrepi skripti uuendada, et lisada täiendavaid toiminguid. Tavalised teabeosad, mida võite soovida ekstraheerida, on järgmised:

- Ettevõtte kirjeldused: Leidke HTML-silt või klass, mis sisaldab iga ettevõtte kirjeldust.

- Asutaja teave: Leidke silt või klass, kus on mainitud asutaja andmed.

- Rahastamise üksikasjad: Märkige jaotis või atribuut, kus kuvatakse rahastamise teavet.

Nende tegevuste lisamiseks:

- Vaadake veebilehte: Avage veebileht brauseris ja kasutage vahendeid nagu Chrome DevTools, et kontrollida soovitud teavet sisaldavaid elemente.

- Värskendage skripti: Muutke skripti, et lisada nende uute elementide ekstraheerimisreeglid, tavaliselt lisades uusi koodiridu, mis tuvastavad ja koguvad need elemendid.

Näide (eeldusel, et tegemist on Pythoni skriptiga):

ettevõtte_kirjeldus = company.find('p', class_='company-description').text asutaja_info = company.find('span', class_='founder-details').text rahastamine_details = company.find('span', class_='funding-info').text.

2. Perioodilise kraapimise seadistamine

Et hoida oma andmeid ajakohasena, seadistage oma skrepperi automaatseks käivitamiseks ajakava. Seda saab teha erinevate tööriistade abil:

- Cron jobs (Linux): Ajastage skripti käivitamine kindlate ajavahemike järel. Näide: Käivitada skraper iga päev keskööl:

0 0 * * * * /usr/bin/python3 /path/to/your_scraper.py: 0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Task Scheduler (Windows): Sarnaselt cron-ülesannetega, planeerige oma skraperi käivitamine kindlatel kellaaegadel.

- Pilveteenused: Kasutage pilvepõhiseid ajaplaneerimisteenuseid, nagu AWS CloudWatch Events, Google Cloud Scheduler või Heroku Scheduler, et oma skraperit perioodiliselt käivitada.

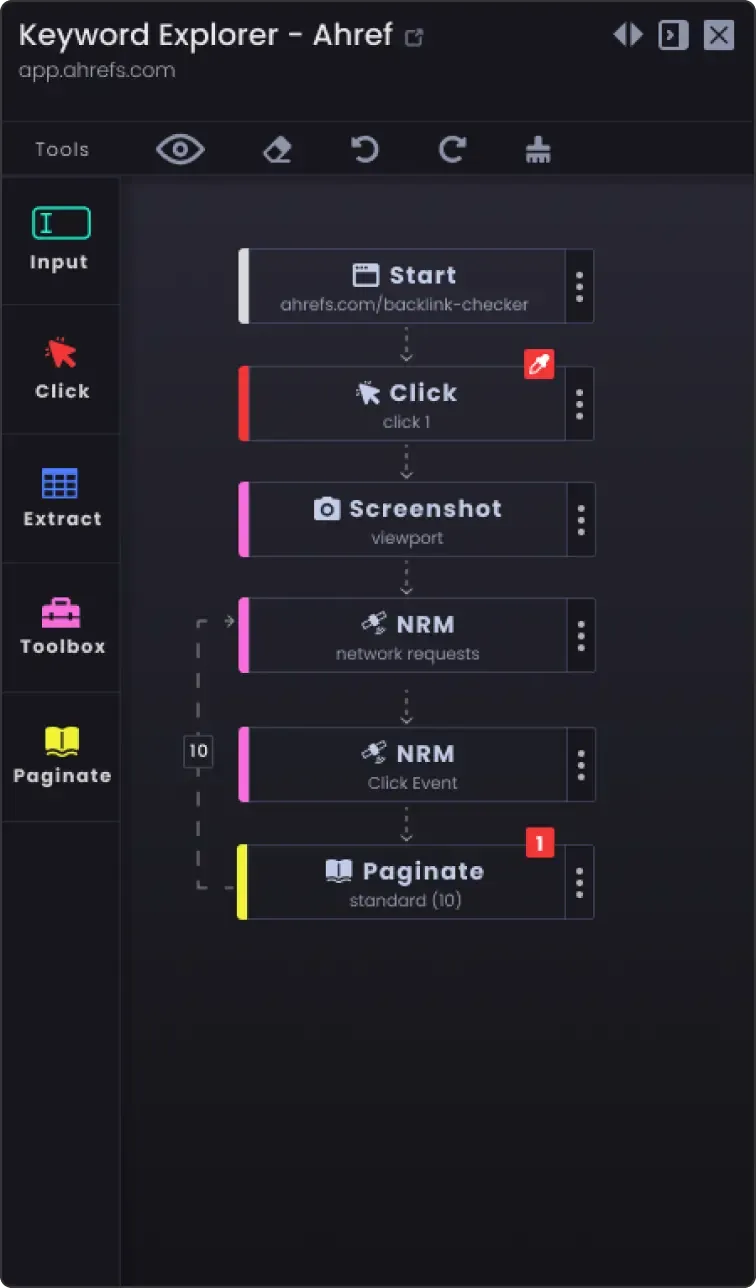

3. Paginatsioonivõimalus, et kraapida rohkem kui üks lehekülg

Veebilehed jagavad teavet sageli mitmele leheküljele. Kõigi lehekülgede kraapimiseks:

- Tehke kindlaks lehekülgede liigitusmehhanism: Vaadake veebisaiti, et näha, kuidas see käsitleb lehekülgede liigitust (nt järgmise lehekülje nupp, leheküljenumbrid).

- Uuendage skripti: Lisage skriptile loogika lehekülgedel navigeerimiseks. See hõlmab tavaliselt leheküljenumbri suurendamist URL-is või nupule "järgmine" klõpsamist.

Näide (Pythoni pseudokood):

page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # Rohkem andmeid ei saa skreipida save_data(data) page_number += 1

4. Kohandamisvõimalused

- Veakäitlus: Lisage veakäitlus, et tagada skrepperi jätkuv töö isegi siis, kui tekib probleeme, näiteks võrguprobleemid või ootamatud muutused veebilehe struktuuris.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

Andmete salvestamise võimalused: Otsustage, kus ja kuidas varutud andmeid salvestada. Võimalused on järgmised:

CSV-failid: Lihtne lugeda ja kirjutada, kasutades Pythoni csv-moodulit.

Andmebaasid: Andmete salvestamine andmebaasides nagu SQLite, MySQL või MongoDB, et teha keerulisemaid päringuid ja tagada andmete terviklikkus.

Pilvemälu: Salvestage andmed pilvesalvestusteenustesse nagu AWS S3 või Google Cloud Storage.

Andmete puhastamine ja valideerimine: Lisage sammud skreipitud andmete puhastamiseks ja valideerimiseks, et tagada nende täpsus ja kasutatavus.

if not company_name: continue # Jäta vahele, kui ettevõtte nimi puudub.

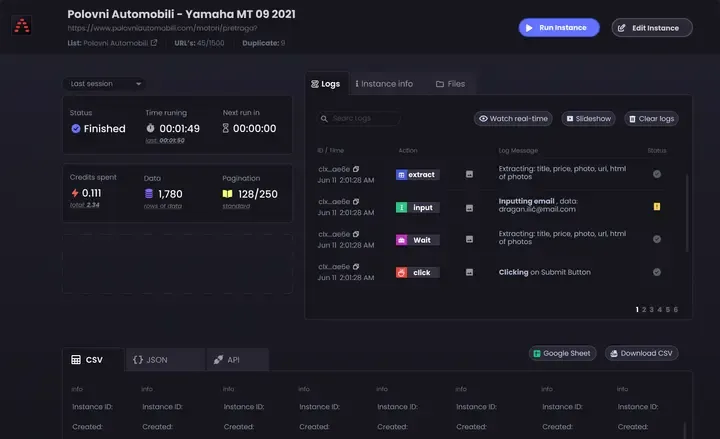

- Logimine: Rakendage logimine, et jälgida skreppimise edenemist ja tekkinud probleeme. Kasutage Pythoni

logimoodulit.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Neid näpunäiteid järgides saate kohandada YCombinator Scraper Template'i vastavalt oma konkreetsetele vajadustele ja tagada, et kogute põhjalikku ja ajakohast teavet.