Padomi, kā pielāgot YCombinator skrāpētāja veidni

1. Papildu darbību pievienošana, lai iegūtu papildu informāciju

Lai savāktu vairāk datu no YCombinator vietnes, varat atjaunināt skrāpētāja skriptu, iekļaujot tajā papildu darbības. Biežāk izmantotā informācija, ko varētu būt nepieciešams iegūt, ir šāda:

- Uzņēmumu apraksti: Atrodiet HTML tagu vai klasi, kas satur katra uzņēmuma aprakstu.

- Informācija par uzņēmuma dibinātāju: Atrodiet tagu vai klasi, kurā ir minēta informācija par uzņēmuma dibinātāju.

- Informācija par finansējumu: Atzīmējiet sadaļu vai atribūtus, kuros parādīta informācija par finansējumu.

Lai pievienotu šīs darbības:

- Pārbaudiet tīmekļa vietni: Atveriet tīmekļa lapu pārlūkprogrammā un, izmantojot tādus rīkus kā Chrome DevTools, pārbaudiet elementus, kuros ir vajadzīgā informācija.

- Atjauniniet skrāpētāja skriptu: Mainiet skriptu, lai iekļautu šo jauno elementu ieguves noteikumus, parasti pievienojot jaunas koda rindas, kas identificē un apkopo šos elementus.

Piemērs (pieņemot Python skriptu):

Uzņēmuma_apraksts = company.find('p', class_='company-description').text dibinātājs_info = company.find('span', class_='founder-details').text finansējums_details = company.find('span', class_='funding-info').text

2. Periodiskas skrāpēšanas iestatīšana

Lai dati būtu pastāvīgi atjaunināti, iestatiet grafiku, pēc kura skrāpētājs tiks palaists automātiski. To var izdarīt, izmantojot dažādus rīkus:

- Cron jobs (Linux): Plānojiet skripta darbību noteiktos intervālos. Piemērs: Lai darbinātu skrāperi katru dienu pusnaktī:

* * * * /usr/bin/python3 /path/to/your_scraper.py.

- Uzdevumu plānotājs (Windows): Līdzīgi kā cron uzdevumiem, ieplānojiet skrāpētāja palaišanu noteiktā laikā.

- Mākoņpakalpojumi: Periodiskai skrāpētāja palaišanai izmantojiet mākoņpakalpojumus, piemēram, AWS CloudWatch Events, Google Cloud Scheduler vai Heroku Scheduler.

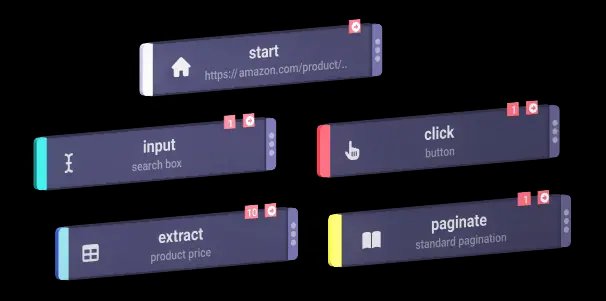

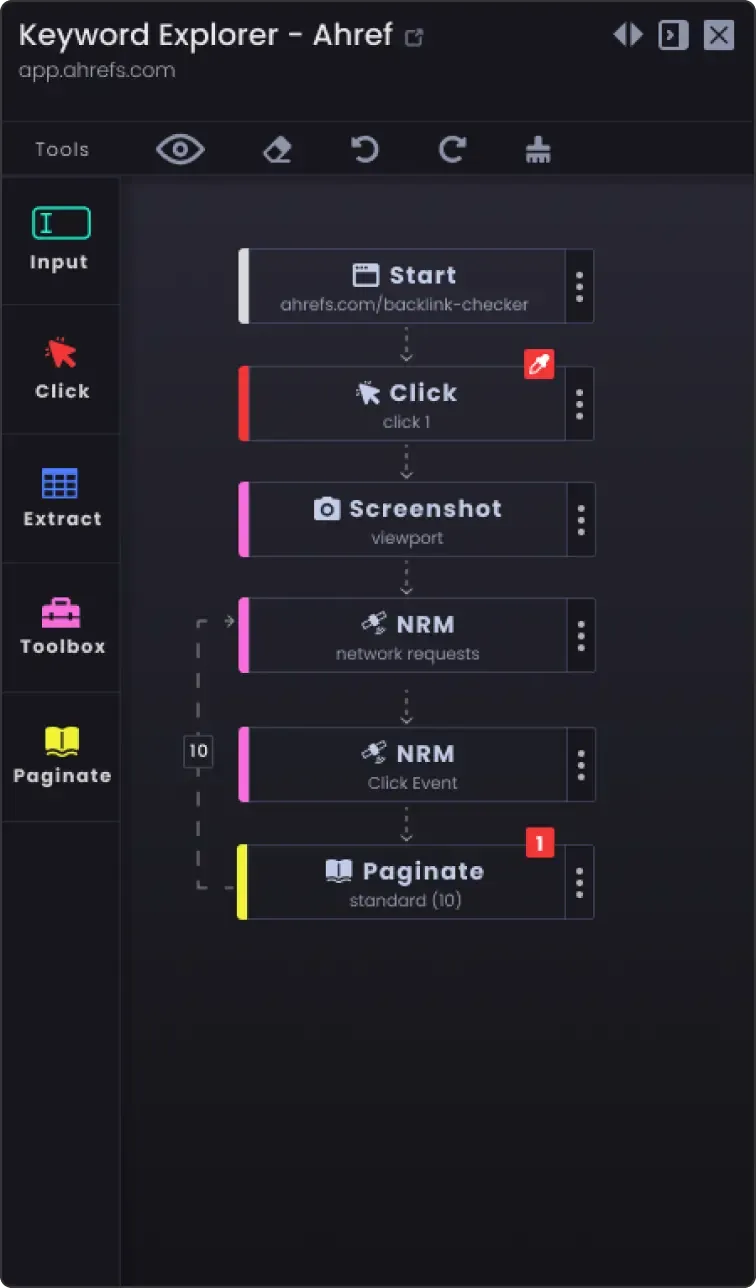

3. Pagination opcija, lai noskrāpētu vairāk nekā vienu lapu

Tīmekļa vietnēs informācija bieži tiek sadalīta vairākās lapās. Lai noskrāpētu visas lapas:

- Pārbaudiet tīmekļa vietni, lai redzētu, kā tajā tiek veiktalappušu numerācija (piemēram, nākamās lapas poga, lapu numuri).

- Atjauniniet skriptu: Pievienojiet skripta loģiku, lai pārvietotos pa lapām. Tas parasti ietver lapas numura palielināšanu URL adresē vai pogas "nākamā" klikšķināšanu.

Piemērs (Python pseidokods):

Page_number = 1 while True: url = f "https://example.com/companies?page={page_number}" response = requests.get(url) data = extract_data(response.text) if not data: break # vairs nav datu, kas jānokasē save_data(data) page_number += 1

4. Pielāgošanas opcijas

- Kļūdu apstrāde: Pievienojiet kļūdu apstrādi, lai nodrošinātu, ka skrāpis turpina darboties pat tad, ja tas saskaras ar tādām problēmām kā tīkla problēmas vai negaidītas izmaiņas tīmekļa vietnes struktūrā.

mēģiniet: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Error: {e}") continue

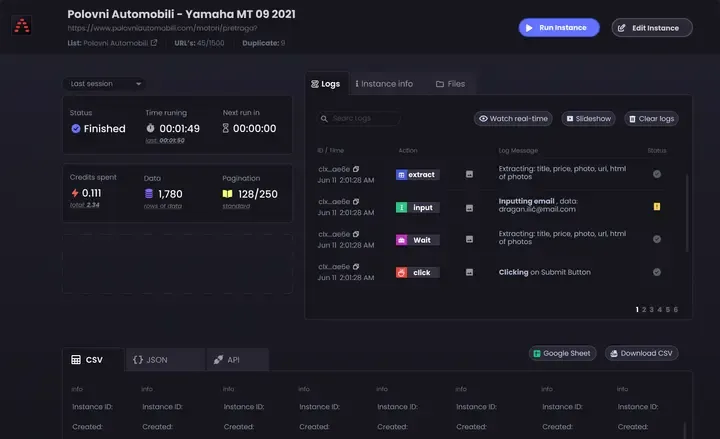

Datu glabāšanas iespējas: Izlemiet, kur un kā glabāt iegūtos datus. Iespējas ir šādas:

CSV faili: Viegli lasīt un rakstīt, izmantojot Python csv moduli.

Datu bāzes: Uzglabāt datus datubāzēs, piemēram, SQLite, MySQL vai MongoDB, lai veiktu sarežģītākus pieprasījumus un nodrošinātu labāku datu integritāti.

Mākoņglabāšana: Saglabājiet datus mākoņglabāšanas pakalpojumos, piemēram, AWS S3 vai Google mākoņglabāšanas pakalpojumos.

Datu tīrīšana un validēšana: Pievienojiet darbības, lai attīrītu un validētu iegūtos datus, lai nodrošinātu, ka tie ir precīzi un izmantojami.

if not company_name: continue # Izlaist, ja nav uzņēmuma nosaukuma

- Reģistrēšana: Ievietojiet reģistrēšanu, lai sekotu līdzi skrāpēšanas gaitai un visām problēmām, ar kurām nākas saskarties. Izmantojiet Python

logēšanas moduli.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Ievērojot šos padomus, varat pielāgot YCombinator skrāpētāja veidni savām vajadzībām un nodrošināt visaptverošas un aktuālas informācijas apkopošanu.