YCombinator Kazıyıcı Şablonunu Özelleştirmek için İpuçları

1. Ek Bilgi Almak için Daha Fazla Eylem Ekleme

YCombinator web sitesinden daha fazla veri toplamak için, kazıyıcının komut dosyasını ek eylemler içerecek şekilde güncelleyebilirsiniz. Çıkarmak isteyebileceğiniz yaygın bilgi parçaları şunları içerir:

- Şirket açıklamaları: Her şirketin açıklamasını içeren HTML etiketini veya sınıfını bulun.

- Kurucu bilgileri: Kurucu ayrıntılarının belirtildiği etiketi veya sınıfı belirleyin.

- Finansman ayrıntıları: Finansman bilgilerini gösteren bölüm veya nitelikleri not edin.

Bu eylemleri eklemek için:

- Web sayfasını inceleyin: Web sayfasını bir tarayıcıda açın ve istenen bilgileri içeren öğeleri incelemek için Chrome DevTools gibi araçları kullanın.

- Kazıyıcı komut dosyasını güncelleyin: Genellikle bu öğeleri tanımlayan ve toplayan yeni kod satırları ekleyerek, bu yeni öğeler için çıkarma kuralları içerecek şekilde komut dosyasını değiştirin.

Örnek (bir Python betiği varsayarak):

company_description = company.find('p', class_='company-description').text founder_info = company.find('span', class_='founder-details').text funding_details = company.find('span', class_='funding-info').text

2. Periyodik Kazıma Kurulumu

Verilerinizi güncel tutmak için, kazıyıcınızın otomatik olarak çalışması için bir zamanlama ayarlayın. Bu çeşitli araçlar kullanılarak yapılabilir:

- Cron işleri (Linux): Komut dosyasını belirli aralıklarla çalışacak şekilde zamanlayın. Örnek: Kazıyıcıyı her gün gece yarısı çalıştırmak için:

0 0 * * * /usr/bin/python3 /path/to/your_scraper.py

- Görev Zamanlayıcı (Windows): Cron işlerine benzer şekilde, kazıyıcınızı belirli zamanlarda çalışacak şekilde zamanlayın.

- Bulut hizmetleri: Kazıyıcınızı periyodik olarak çalıştırmak için AWS CloudWatch Events, Google Cloud Scheduler veya Heroku Scheduler gibi bulut tabanlı zamanlama hizmetlerini kullanın.

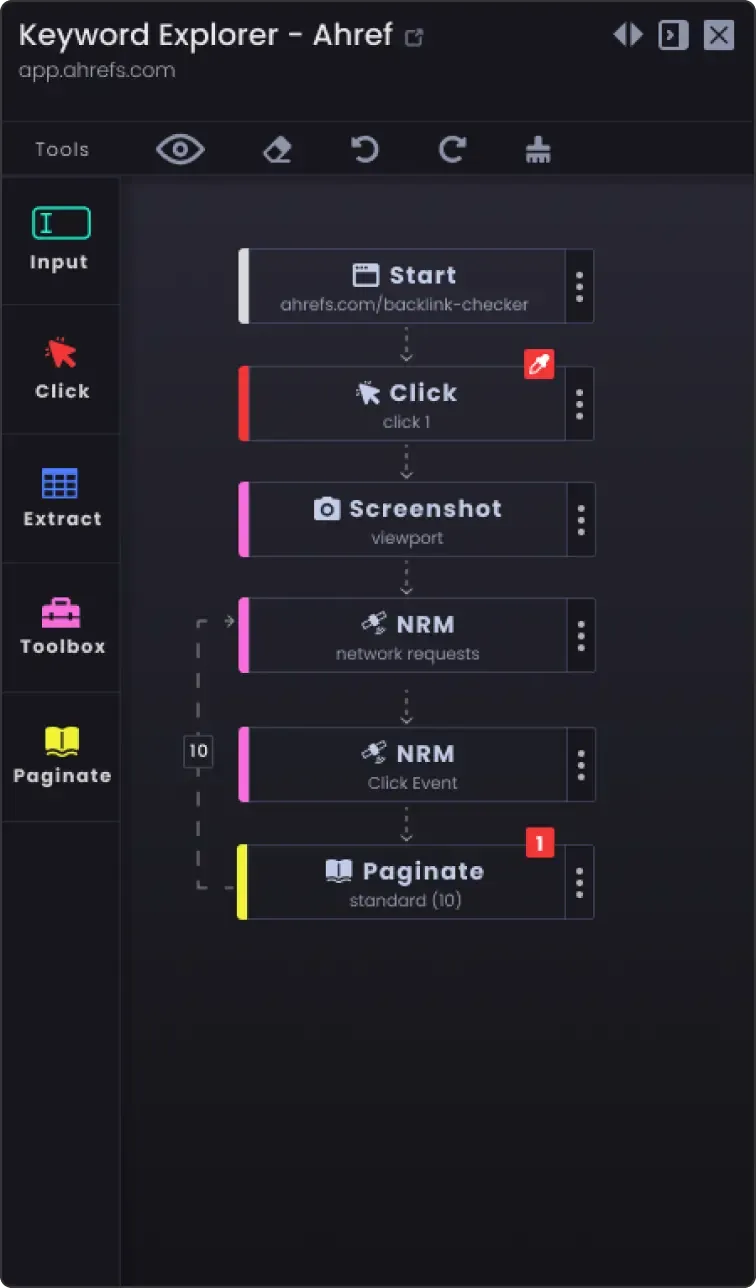

3. Birden Fazla Sayfayı Kazımak için Sayfalandırma Seçeneği

Web siteleri genellikle bilgileri birden fazla sayfaya böler. Tüm sayfaları kazımak için:

- Sayfalandırmamekanizmasını belirleyin: Sayfalandırmayı nasıl işlediğini görmek için web sitesini inceleyin (örneğin, sonraki sayfa düğmesi, sayfa numaraları).

- Komutdosyasını güncelleyin: Sayfalar arasında gezinmek için kodunuza mantık ekleyin. Bu genellikle URL'deki bir sayfa numarasının artırılmasını veya "sonraki" düğmesine tıklanmasını içerir.

Örnek (Python sözde kodu):

sayfa_sayısı = 1 while True: url = f "https://example.com/companies?page={sayfa_sayısı}" response = requests.get(url) data = extract_data(response.text) if not data: break # Kazınacak veri kalmadı save_data(data) sayfa_sayısı += 1

4. Özelleştirme Seçenekleri

- Hata işleme: Ağ sorunları veya web sayfası yapısında beklenmedik değişiklikler gibi sorunlarla karşılaşsa bile kazıyıcının çalışmaya devam etmesini sağlamak için hata işleme ekleyin.

try: response = requests.get(url) response.raise_for_status() except requests.exceptions.RequestException as e: print(f "Hata: {e}") continue

Veri depolama seçenekleri: Hurdaya çıkarılan verilerin nerede ve nasıl saklanacağına karar verin. Seçenekler şunları içerir:

CSV dosyaları: Python'un csv modülünü kullanarak okumak ve yazmak kolaydır.

Veritabanları: Daha karmaşık sorgular ve daha iyi veri bütünlüğü için verileri SQLite, MySQL veya MongoDB gibi veritabanlarında depolayın.

Bulut depolama: Verileri AWS S3 veya Google Cloud Storage gibi bulut depolama hizmetlerine kaydedin.

Veri temizleme ve doğrulama: Doğru ve kullanılabilir olduğundan emin olmak için kazınan verileri temizlemek ve doğrulamak için adımlar ekleyin.

if not company_name: continue # Şirket adı eksikse atla

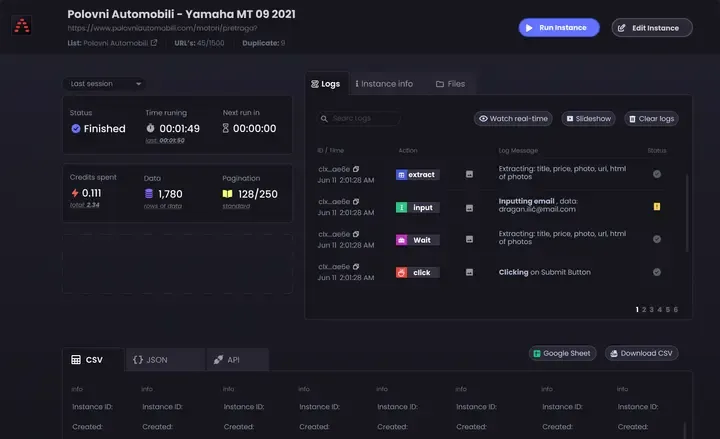

- Günlük kaydı: Kazıma ilerlemesini ve karşılaşılan sorunları takip etmek için günlük kaydı uygulayın. Python'un

günlük modülünü kullanın.

import logging logging.basicConfig(level=logging.INFO) logging.info(f'Scraping page {page_number}')

Bu ipuçlarını takip ederek, YCombinator Kazıyıcı Şablonunu özel ihtiyaçlarınızı karşılayacak şekilde özelleştirebilir ve kapsamlı ve güncel bilgiler topladığınızdan emin olabilirsiniz.